7 Minuten

AMD berichtet von erheblichem Interesse mehrerer Kunden, die Geschäfte in ähnlicher Größenordnung wie die viel beachtete Partnerschaft mit OpenAI anstreben. Im Mittelpunkt dieser Dynamik steht die nächste Generation der Instinct-AI-Familie — einschließlich des bereits angekündigten MI355 und des erwarteten MI450 — und AMD positioniert sich aktiv für eine breitere, rack‑skalierbare Bereitstellung von KI-Beschleunigern in Rechenzentren.

Why multiple OpenAI-scale customers matter

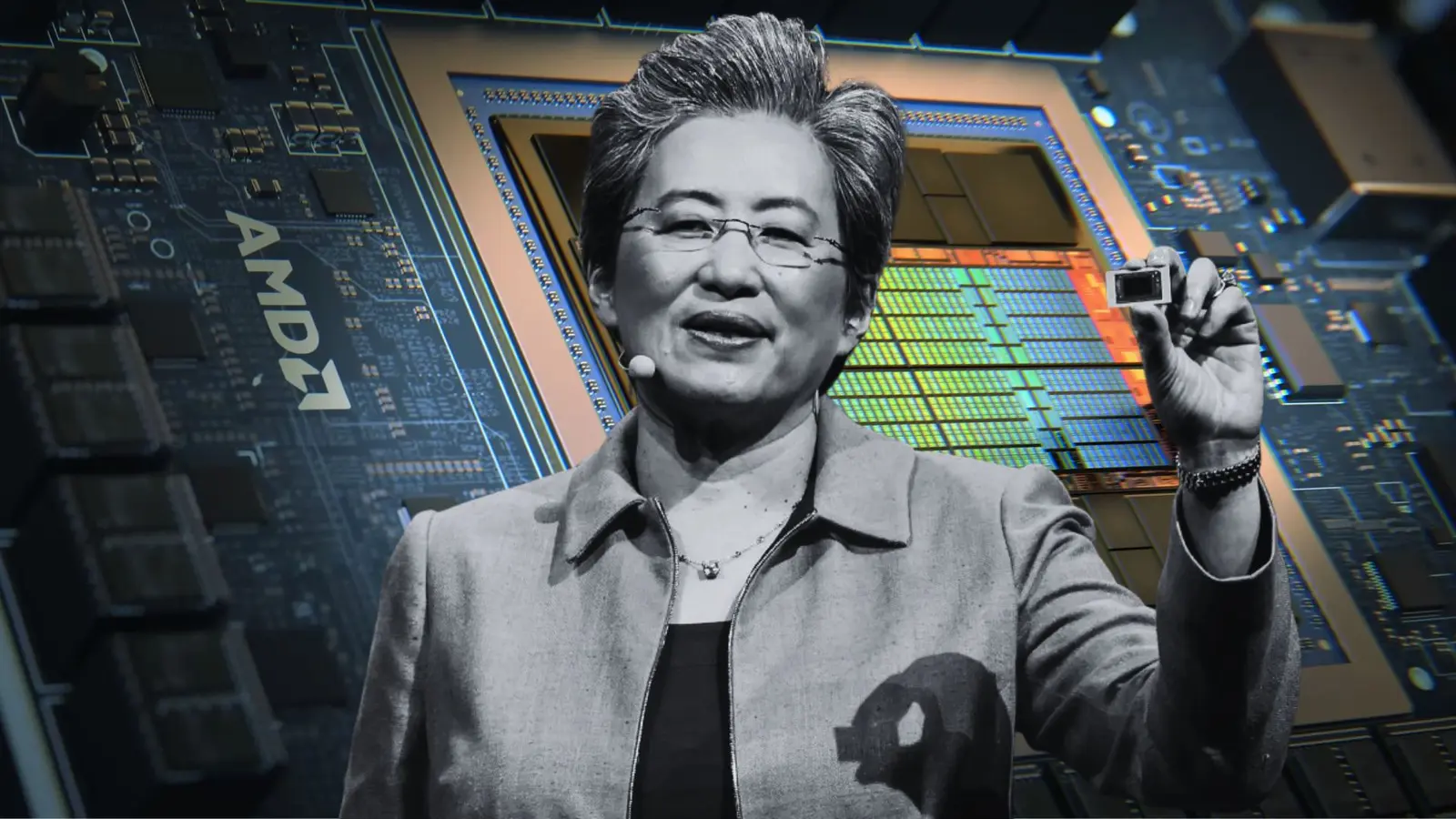

Stellen Sie sich vor, ein einzelner Cloud‑KI‑Vertrag entwickelt sich zu Dutzenden: Dieses Szenario hat AMD‑CEO Lisa Su während der jüngsten Quartalskonferenz angedeutet. Die Zusammenarbeit mit OpenAI hat die Aufmerksamkeit innerhalb des gesamten KI‑Ökosystems gesteigert und bietet AMD die Möglichkeit, weitere Kunden vergleichbarer Größenordnung zu gewinnen, um Einnahmen zu diversifizieren und Konzentrationsrisiken zu reduzieren. Für ein Halbleiterunternehmen ist eine solche Streuung wichtig, weil sie stabilere Umsätze und verbesserte Verhandlungspositionen gegenüber Zulieferern und Partnerschaften ermöglicht.

Das ist insofern relevant, als der Markt für hyperskalige KI‑Infrastruktur längst kein Nischenmarkt mehr ist. Große Sprachmodelle (Large Language Models, LLMs) und generative KI-Anwendungen treiben den Bedarf an dichten, energieeffizienten Beschleunigern, die sich in bestehende Serverracks integrieren lassen, ohne überproportionale Anforderungen an Stromversorgung und Kühlung zu erzeugen. AMDs Instinct‑Roadmap wird explizit darauf ausgerichtet, diese Anforderungen zu erfüllen: höhere Rechenleistung pro Watt, kompaktere Formfaktoren und verbesserte Integrationsmöglichkeiten auf Rack‑Ebene sind zentrale Verkaufsargumente für Cloud‑Anbieter, Hyperscaler und größere Unternehmensrechenzentren.

What to expect from the Instinct lineup

Führende AMD‑Manager erklären, dass die Produktion der Instinct-MI355‑Serie jetzt hochfährt und das Unternehmen für 2026 eine starke Marktbewegung erwartet. Die MI450‑Familie soll im zweiten Halbjahr des kommenden Jahres in den Markt kommen und wird als ein großer Schritt nach vorne bei der Leistung pro Watt sowie bei der Rack‑Skalierbarkeit angepriesen. Diese technische Entwicklung zielt darauf ab, sowohl den Durchsatz für Trainings‑Workloads großer Modelle als auch die Effizienz für Inferenz‑Aufgaben zu verbessern.

- MI355: Beginnende Hochlaufphase, konzipiert für breit angelegte Deployments und kurzfristige Skalierung in Cloud‑ und Enterprise‑Umgebungen; konzentriert auf Kosteneffizienz und Kompatibilität mit gängigen AI‑Software‑Stacks.

- MI450: Geplanter Launch in H2 nächstes Jahr, mit architektonischen Verbesserungen, optimierter Energieeffizienz und ausgeprägteren Merkmalen für die Integration in dichte Rack‑Konfigurationen; soll Latenz reduzieren und die Performance‑per‑Watt deutlich steigern.

- Fokusbereiche: Performance‑per‑Watt, Rack‑Scale‑Konfigurationen, umfassende Ökosystem‑Partnerschaften (Software, Orchestrierung, Kühlsysteme) und Support für Open‑Source‑ und proprietäre KI‑Frameworks.

How this changes the competitive landscape

Der erneute Vorstoß von AMD in den Markt für KI‑Beschleuniger dürfte den Wettbewerb mit den etablierten Anbietern deutlich verschärfen. Marktteilnehmer erwarten, dass die MI450 wichtige Lücken gegenüber Wettbewerbern schließt und mögliche Vorwände für Kunden beseitigt, die Migration von älterer Hardware hinauszuzögern. Wenn AMD dabei signifikante Verbesserungen bei Energieeffizienz und Rack‑Integration liefert, können Cloud‑Provider und Hyperscaler schneller ROI‑berechnungen anstellen, die Investitionszyklen beschleunigen und größere Bestellungen in Erwägung ziehen.

Zugleich weisen Branchenbeobachter darauf hin, dass steigende Nachfrage und mehrere groß angelegte Abkommen Preis‑ und Angebotsdynamiken entlang der Lieferkette beeinflussen können. Das betrifft nicht nur die Stückzahlen der GPUs selbst, sondern auch Komponenten wie HBM‑Speicher, Netzteile, Backplanes und die Kühlinfrastruktur; Engpässe oder Volumenrabatte könnten die Strategie der Anbieter und deren Margen beeinflussen. AMDs Fähigkeit, die Lieferkette zu managen und Skaleneffekte zu realisieren, wird daher entscheidend sein, um in diesem wettbewerbsintensiven Umfeld Marktanteile zu gewinnen.

Für Anwender bedeutet ein stärkerer Wettbewerb außerdem potenziell günstigere Preise, schnellere Innovationszyklen bei Architektur und Software‑Optimierung sowie mehr Auswahl bei Lieferanten. Aus Sicht von Hyperscalern steht zusätzlich die Frage im Raum, wie gut sich Plattformen in ihre bestehenden Management‑Stacks (z. B. Kubernetes, spezialisierte Scheduler für KI‑Workloads) integrieren lassen — und hier versucht AMD, mit Referenzdesigns, Treibern und Softwarepartnerschaften aufzuholen.

What industry watchers should watch next

Wichtige Signale, die Anleger, Kunden und Branchenanalysten in den kommenden Quartalen beobachten sollten, sind:

- Produktions‑ und Auslieferungsvolumina der MI355‑Serie: Steigende Stückzahlen und eine zuverlässige Lieferkette sind Indikatoren für Marktakzeptanz und Fähigkeit, Nachfrage zu bedienen.

- Kommerzielle Verfügbarkeit und Benchmark‑Ergebnisse der MI450: Unabhängige Leistungsbenchmarks, insbesondere in Bezug auf Durchsatz, Latenz und Energieverbrauch bei Trainings‑ und Inferenz‑Workloads, geben Aufschluss über die Wettbewerbsfähigkeit gegenüber Alternativen.

- Bekanntgabe weiterer Hyperscale‑Partnerschaften neben OpenAI: Mehrere OpenAI‑Skalengeschäfte würden die Strategie von AMD validieren und den Wettbewerb um Großkunden intensivieren.

- Software‑Ecosystem und Optimierungen: Unterstützung durch Compiler, Bibliotheken (z. B. für Training, Quantisierung) und Integration in bestehende MLOps‑Pipelines ist genauso wichtig wie die reine Hardware‑Performance.

- Ökonomische Effekte: Preisgestaltung, Total Cost of Ownership (TCO) und langfristige Verträge mit Wartung und Support sind für Cloud‑Provider und Großunternehmen ausschlaggebend.

Wenn AMD es schafft, mehrere OpenAI‑skalige Abschlüsse zu sichern, wäre das eine gewichtige Bestätigung der eigenen KI‑Strategie und könnte Beschaffungspläne bei Cloud‑Anbietern sowie großen Unternehmen nachhaltig verändern. Solche Deals signalisieren auch den Software‑ und Systemintegratoren, welche Plattformen sich lohnen, zu priorisieren und zu optimieren.

Unterm Strich setzt AMD darauf, dass architektonische Verbesserungen, bessere Energieeffizienz und eine robuste Rack‑Skalierbarkeit das vorhandene Interesse in konkrete Mehrkundenbeziehungen verwandeln. Gelingt dies, könnte die Instinct‑Familie zu einem zentralen Baustein der mainstream‑tauglichen KI‑Infrastruktur werden — nicht nur für Training großer Modelle, sondern auch für latenzkritische Inferenz‑Workloads in Cloud‑ und Edge‑Szenarien.

Technisch betrachtet spielen dabei mehrere Faktoren zusammen: Die Balance zwischen Roh‑Rechenleistung (FLOPS), Speicherdurchsatz (z. B. Bandbreite zu HBM‑Speicher), Netzwerkanbindung (RDMA, Infiniband, Ethernet mit hoher Bandbreite) sowie thermische Limits bestimmen, wie leicht sich ein Beschleuniger in dichte Rack‑Topologien integrieren lässt. AMD positioniert MI355 und MI450 so, dass diese Parameter optimiert werden — etwa durch bessere Kühlkonzepte, modulare Board‑Designs und enge Zusammenarbeit mit Anbietern von Rack‑Level‑Lösungen.

Auf der Softwareseite sind Performance‑Optimierungen in gängigen Frameworks (PyTorch, TensorFlow) sowie Unterstützung für Beschleunigungsbibliotheken, Quantisierungsverfahren und Mixed‑Precision‑Rechenmodi kritisch. AMD investiert in Compiler‑ und Laufzeitoptimierungen sowie in Partnerschaften mit ISVs (Independent Software Vendors), um sicherzustellen, dass Kunden die Hardware effizient nutzen können. Ein robustes Ökosystem aus Systemintegratoren, Kühllösungsanbietern und Softwarepartnern erhöht die Wahrscheinlichkeit, dass Rack‑skalable Lösungen tatsächlich in großem Maßstab eingesetzt werden.

Auch die ökologischen und ökonomischen Aspekte sind nicht zu vernachlässigen: Energieeffizienz wirkt sich direkt auf die Betriebskosten (OPEX) von Rechenzentren aus, und bessere Performance‑per‑Watt kann die CO2‑Bilanz einer KI‑Workload verbessern. In Zeiten steigender Energiepreise und wachsender regulatorischer Anforderungen ist dies ein zusätzliches Verkaufsargument gegenüber traditionellen, weniger effizienten Systemen.

Schließlich sollten Interessenten auf mögliche Auswirkungen auf Lieferketten und Teilemärkte achten: Ein starker Nachfrageschub nach Instinct‑Produkten kann zu Engpässen bei HBM‑Modulen, PCIe‑Switches, Netzteilen oder Kühlkomponenten führen. AMDs Fähigkeit, hier frühzeitig Kapazitäten zu sichern und mit Partnern vereinbarte Liefermengen zu erfüllen, wird einen großen Einfluss auf die Skalierbarkeit der Angebote haben.

Beobachter sollten außerdem prüfen, wie Wettbewerber reagieren — ob durch Preisanpassungen, eigene Architekturverbesserungen oder verstärkte Kooperationen mit Cloud‑Anbietern. Die Kombination aus Hardware‑Innovation und Ökosystemaufbau entscheidet letztlich darüber, welche Plattformen sich als Standards für Rack‑Scale KI‑Infrastruktur etablieren.

Quelle: wccftech

Kommentar hinterlassen