6 Minuten

iOS 26 könnte mit dem Model Context Protocol ein großes KI-Upgrade erhalten

Apple scheint native Unterstützung für das Model Context Protocol (MCP) vorzubereiten. Dies geht aus Code hervor, der in der ersten iOS 26.1 Developer Beta entdeckt wurde. Würde MCP implementiert, könnte das Protokoll Drittanbieter-KI-Tools ermöglichen, tiefer mit Apps auf iPhone, iPad und Mac zu interagieren. Das würde neue In-App-Funktionen für Assistenten und Modelle außerhalb des Apple-Ökosystems eröffnen und die Interoperabilität zwischen System, Apps und externen KI-Diensten erheblich verbessern.

Was ist MCP und warum es wichtig ist

Das Model Context Protocol (MCP) ist ein universelles Protokoll, das KI-Systemen erlaubt, die kontextuellen Daten anzufragen und zu nutzen, die sie für eine zuverlässige Analyse und Interaktion benötigen. Statt für jede Datenquelle individuelle Integrationen zu entwickeln, standardisiert MCP den Zugriff auf Kontextinformationen wie sichtbare Bildschirminhalte, Benutzerdaten (sofern freigegeben), App-Zustände oder Metadaten. MCP wurde ursprünglich von Anthropic vorgeschlagen und fand bereits Unterstützung bei großen KI-Anbietern wie OpenAI und Google. Der fundierte Anspruch des Protokolls besteht darin, Entwicklern und Modellen eine konsistente, sichere Schnittstelle zu bieten, um Kontextdaten in strukturierter Form auszutauschen — ein wichtiger Schritt für skalierbare KI-Funktionen auf mobilen Geräten.

Die Entdeckung entsprechender Hinweise in der iOS 26.1 Beta deutet darauf hin, dass Apple daran arbeitet, MCP in sein Betriebssystem zu integrieren. Eine solche Integration wäre aus mehreren Gründen bedeutsam: Erstens würde sie die Entwicklung von KI-gestützten Funktionen für Drittanbieter beschleunigen. Zweitens könnte sie die Innovationsgeschwindigkeit für neue Assistenzfunktionen erhöhen, da Modelle standardisiert auf relevanten Kontext zugreifen könnten. Drittens ließe sich durch präzise Zugriffskontrollen und Policies ein hoher Datenschutzstandard beibehalten, wenn Apple diese Mechanismen systemseitig umsetzt.

App Intents, Siri und MCP

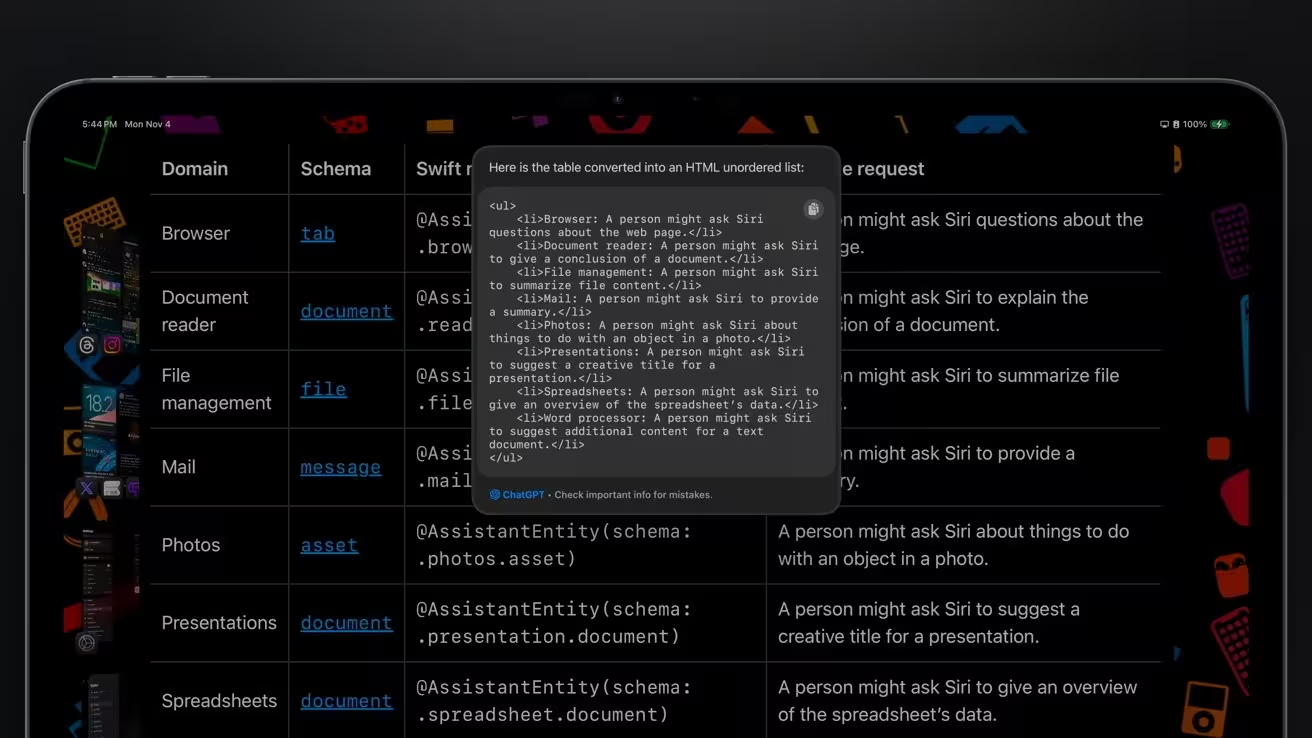

Das App Intents-Framework von Apple ermöglicht bereits heute, dass Siri und die Kurzbefehle-App Aktionen innerhalb von Anwendungen auslösen. Entwickler können über App Intents bestimmte Funktionen ihrer Apps für Systemdienste und Automatisierungen verfügbar machen; jüngste Verbesserungen stehen zudem in Verbindung mit Apple Intelligence. Durch diese Erweiterungen ist es Entwicklern möglich, sichtbare Inhalte auf dem Bildschirm für die Analyse durch Siri aufzubereiten. In der Praxis bedeutet das: Alles, was aktuell auf dem Display sichtbar ist, kann zur weiteren Verarbeitung an eine KI geschickt werden — vorausgesetzt, der Nutzer hat seine Zustimmung erteilt.

Wenn Apple MCP unterstützt, könnten Drittanbieter-KI-Dienste denselben Kommunikationsweg nutzen, um mit Anwendungen zu interagieren. Das eröffnet Szenarien, in denen Siri detaillierte Fragen zu einer gezeigten Webseite beantwortet, Fotos auf Anweisung bearbeitet und teilt, Social-Media-Posts annotiert oder Artikel in einen Online-Einkaufswagen legt — und das alles ohne manuelle Bedienung durch den Nutzer. Gleiches gilt für externe Modelle wie OpenAI’s ChatGPT: Nutzer könnten diese Modelle anweisen, innerhalb installierter Apps Aktionen auszuführen und den App-Zustand zu berücksichtigen.

MCP würde darüber hinaus Assistenten ermöglichen, umfassendere Informationen aus dem Web zu sammeln und kontextuell zu verarbeiten. Berichten zufolge plant Apple, seine eigenen Foundation Models für datenschutzkritische Aufgaben lokal auf dem Gerät zu nutzen, während externe Modelle für Webabruf und -zusammenfassungen hinzugezogen werden können. MCP würde in einem solchen Hybridansatz genau regeln, wie Kontextdaten an externe Modelle übermittelt werden, sodass sowohl Funktionalität als auch Sicherheit besser gewährleistet sind.

Apples Pläne für einen überarbeiteten Siri

Gerüchte aus September 2025 deuten darauf hin, dass Apple eine neue Web-Suche einführen möchte, die von Apple Foundation Models (AFM) angetrieben wird. Optional könnte diese Funktion Google Gemini oder andere externe Modelle hinzuziehen, um webbasierte Zusammenfassungen zu verbessern. Die umgestaltete Siri soll drei Kernkomponenten umfassen: einen Planner, einen Search Operator und einen Summarizer. Apples eigener Modellanteil würde vornehmlich als Planner und Search Operator fungieren, um personalisierte, gerätebezogene Daten sicher zu bearbeiten. Externe Modelle könnten unterstützend für die Websuche und die Extraktion sowie Verdichtung von externen Inhalten eingesetzt werden.

Wird MCP Teil von iOS, könnten externe Modelle wie Google Gemini mehr als nur Suchergebnisse zurückliefern — sie könnten potenziell In-App-Operationen über verschiedene Drittanbieter-Apps hinweg ausführen. Das würde die von Apple angekündigten erweiterten in-App-Fähigkeiten für Siri ergänzen oder sogar zeitweise ersetzen, falls diese Funktionen verzögert eingeführt werden. Für Nutzer wäre das ein Vorteil, weil sie zwischen mehreren KI-Anbietern wählen könnten, ohne auf die Grundfunktionen von Siri verzichten zu müssen.

Zugleich könnte MCP Siri erlauben, eigenständig Webinformationen abzurufen und zu nutzen, ohne ausschließlich auf externe Anbieter angewiesen zu sein. Weil MCP den Zugriff auf kontextuelle Daten über Quellen hinweg standardisiert, könnten sowohl Apples eigene Modelle als auch Drittanbieter-Assistenzsysteme relevante Informationen leichter finden, zusammenführen und darauf basierend handeln. Das schafft ein flexibleres Ökosystem, in dem Sicherheit, Datenschutz und Funktionalität balanciert werden müssen.

Derzeit kann Siri bereits datenschutzorientierte Websuchen durchführen, und komplexere Aufgaben werden mit Zustimmung des Nutzers an Dienste wie ChatGPT delegiert. Apples Strategie scheint daraufhinzuzielen, mit KI-Firmen zusammenzuarbeiten, anstatt eine einzige, vollständig geschlossene Lösung aufzubauen. Dieses kooperative Modell könnte die Entwicklungszyklen verkürzen, Innovationen fördern und den Nutzern mehrere KI-Optionen bieten, ohne die Kontrolle über sensible Daten zu verlieren.

Insider erwarten, dass die überarbeitete Siri Anfang 2026 verfügbar sein könnte, wahrscheinlich im Rahmen eines iOS 26.x-Updates. In der Zwischenzeit werden Entwickler und Anbieter von KI-Services vermutlich damit beginnen, ihre Systeme MCP-kompatibel zu machen, um zum Startumfang entsprechender Apple-Funktionen bereit zu sein.

Quelle: appleinsider

Kommentar hinterlassen