9 Minuten

OpenAI hat sich in einer ersten Liefervereinbarung die Memory-Champions Südkoreas gesichert: Samsung Electronics und SK Hynix wurden als Lieferanten für Speicherchips verpflichtet, die für das großangelegte Stargate-Datenzentrumsprojekt benötigt werden. Diese Ankündigung löste an den Märkten unmittelbare Kursanstiege bei beiden Chipherstellern aus und macht deutlich, wie gewaltig die nächste Welle der KI-Infrastruktur ausfallen dürfte. Neben dem direkten wirtschaftlichen Effekt zeigt der Schritt auch, wie strategisch wichtig spezialisierte Speicherlösungen für KI-Systeme geworden sind.

Warum das Abkommen den Markt für KI-Chips verändert

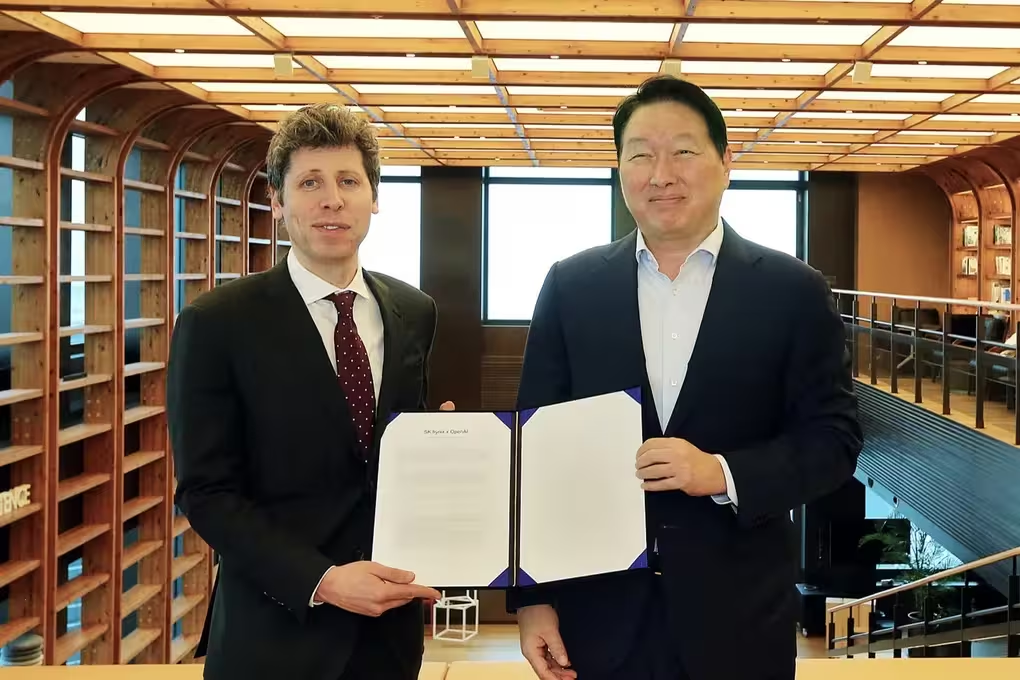

Sam Altman unterzeichnete ein Letter of Intent mit Samsung und SK Hynix zur Lieferung von Speicherchips für OpenAIs Stargate-Projekt — einem globalen Ausbauplan für KI-Datenzentren, an dem Branchenplayer von Nvidia bis Oracle beteiligt sind. Die von OpenAI angedeutete Größenordnung ist beeindruckend: Bis zu 900.000 Waferstarts pro Monat könnten erforderlich werden, wenn Stargate wächst. Zum Vergleich: Nach Angaben von Marktbeobachtern entspräche dieses Volumen mehr als dem Doppelten der derzeit weltweit verfügbaren Produktionskapazität für HBM (High-Bandwidth Memory), die spezialisierten Module, die KI-Acceleratoren mit extrem schnellen Datenströmen versorgen.

Das Ausmaß solcher Bedarfe verändert die Dynamik im Markt. Ein Waferstart steht für den Beginn der Fertigung einer Halbleiterscheibe, auf der viele einzelne Speicherchips entstehen. Eine massive Erhöhung der Waferstarts bedeutet nicht nur mehr reine Produktionszeit, sondern auch einen enormen Bedarf an Vorleistung, Logistik und Verpackungskapazitäten — von Dünnschichtprozessen über Testeinrichtungen bis hin zu Substraten und Kupferspuren. Solche Engpässe können Lieferketten spürbar verzerren und Preise beeinflussen.

HBM unterscheidet sich technisch deutlich von konventionellem DRAM. Die Module verwenden eine 3D-Stacking-Architektur mit durchkontaktierten Verbindungen (Through-Silicon Vias, TSVs) und bieten dadurch eine deutlich höhere Speicherbandbreite bei vergleichsweise kompakter Bauweise. Diese Eigenschaften machen HBM zur bevorzugten Wahl in modernen KI-Beschleunigern, die große Mengen an Parameterdaten in sehr kurzer Zeit verarbeiten müssen. Wenn OpenAI seine Nachfrage in der genannten Größenordnung durchsetzt, erhöht das den Druck auf die Hersteller, Fertigungsprozesse zu optimieren und Skaleneffekte zu realisieren.

Die Märkte reagierten schnell und deutlich. SK Hynix — derzeit führend im HBM-Segment — legte rund 12 % zu und erreichte damit die höchste Marktbewertung seit mehr als zwei Jahrzehnten. Samsung stieg auf ein Vier-Jahres-Hoch und gewann zeitweise bis zu 4,7 %. Sogar kleinere Zulieferer in der Wertschöpfungskette, wie etwa Hanmi Semiconductor, sprangen um etwa 8 % nach oben, weil Investoren die Möglichkeit einer zusätzlichen Nachfragewelle für Speicherkomponenten einkalkulierten. Solche Reaktionen zeigen, wie sensibel Kapitalmärkte auf Veränderungen in den Technologie- und Lieferketten reagieren.

Neben den unmittelbaren Kursgewinnen lässt sich auch ein struktureller Effekt beobachten: Hersteller investieren nun verstärkt in Kapazitätsaufbau, Forschung und Entwicklung sowie Partnerschaften entlang der Lieferkette. Strategien wie Co-Engineering-Projekte mit Hyperscalern, langfristige Lieferverträge und Kapazitätsreservierungen werden zunehmend zum Standard, um Versorgungssicherheit zu gewährleisten. Das ist besonders relevant, weil HBM nicht nur Material- und Produktionsprobleme birgt, sondern auch hohe Qualitätsanforderungen an Yield-Raten und thermisches Management stellt.

Was Südkorea aus der Partnerschaft gewinnt

Über die unmittelbare kommerzielle Lieferung hinaus zielt das Abkommen darauf ab, die langfristigen Beziehungen zwischen OpenAI und dem südkoreanischen Halbleiter-Ökosystem zu vertiefen. Bestandteil der Vereinbarung ist die Zusammenarbeit beim Aufbau einer inländischen KI-Infrastruktur in Seoul — ein Teil einer globalen Initiative vieler Regierungen, kritische KI-Lieferketten national zu verankern. Für Südkorea bedeutet das nicht nur kurzfristige Auftragsvolumina, sondern auch strategische Vorteile in Forschung, Fertigungstiefe und Wertschöpfung.

Präsident Lee Jae Myung begrüßte die Vereinbarung öffentlich und äußerte die Hoffnung, dass koreanische Firmen eine zentrale Rolle bei der weltweiten Verbreitung von KI-Technologie spielen werden. Solche politischen Signale sind wichtig: Sie fördern regulatorische Unterstützung, erleichtern Infrastrukturinvestitionen und können Fördermittel oder steuerliche Anreize für Forschung und Produktionsausbau nach sich ziehen. Regierungspolitik kann so zur Beschleunigungsmaßnahme werden, die private Investitionen ergänzt.

Die Beteiligung lokaler Partner geht über reine Chiplieferungen hinaus. SK Telecom hat zugesagt, ein dediziertes OpenAI-Datenzentrum im Südwesten Südkoreas zu errichten. Das zeigt, dass lokale Akteure in Design, Bau und Betrieb integraler Bestandteil des Projekts sein sollen. Für die heimische Industrie bedeutet das zusätzliche Nachfrage nach Rechenzentrumskapazität, Energieinfrastruktur, Kühllösungen und Dienstleistungen rund um den Betrieb hochperformanter KI-Anlagen.

Auf Unternehmensebene könnten sich weiterreichende Kooperationen ergeben: Samsung-Ableger — von SDS (IT-Dienstleistungen) bis zu Samsung Heavy Industries — könnten Komponenten wie Rechenzentrums-IT-Architektur, Containerlösungen oder sogar experimentelle schwimmende Rechenzentren anbieten. Solche multidisziplinären Kooperationen stärken die Position Südkoreas als umfassender Anbieter in der globalen KI-Infrastrukturkette und schaffen Arbeitsplätze in Forschung, Fertigung und Bauwesen.

Langfristig stärkt die Kooperation auch die technologische Souveränität: Durch engere Zusammenarbeit bei Design, Test und Validierung von KI-Hardware können lokale Ingenieurteams Know-how aufbauen, das über einzelne Aufträge hinaus wirkt. Ein solcher Wissensaufbau erhöht die Chance, in Zukunft nicht nur Komponenten zu liefern, sondern komplexe Systemintegrationen zu übernehmen — ein Schritt von reiner Fertigung hin zu höherwertiger Industriekompetenz.

Die enge Verzahnung von Politik, Industrie und Forschung schafft damit ein Ökosystem, das für weitere Investoren attraktiv ist. Internationale Konzerne sehen in stabilen lokalen Partnern niedrigere politische Risiken und höhere Planbarkeit. Gleichzeitig profitiert die südkoreanische Wirtschaft von zusätzlichen Exportmöglichkeiten und einer stärkeren Position in globalen Hightech-Wertschöpfungsketten.

Wie das in das globale Rennen um KI-Infrastruktur passt

OpenAIs Initiative Stargate reiht sich ein in eine Serie massiver Investitionen und strategischer Allianzen. Nvidia kündigte kürzlich Pläne an, bis zu 100 Milliarden US-Dollar in OpenAI zu investieren, um Rechenzentrums-Kapazitäten und zugehörige Infrastruktur zu unterstützen — ein Indikator für die Billionen-Dollar-Dimensionen, die Analysten mittlerweile mit Next-Generation-KI-Systemen verbinden. Da Nvidias KI-Beschleuniger stark auf HBM angewiesen sind, könnte die Nachfrage durch OpenAI zu einem spürbaren Anstieg der Bestellungen bei SK Hynix und Samsung führen.

Die Inflation von Rechenleistungsbedarf und die damit verbundene Nachfrage nach Spezialkomponenten wie HBM treiben das gesamte Ökosystem an: Chipdesigner, Paketierer, Serverhersteller, Kühllösungsanbieter, Energieversorger und Rechenzentrumsbauer müssen koordiniert skalieren. Solche Wertschöpfungsnetzwerke erfordern präzise Abstimmung: Von der Definition technischer Schnittstellen über gemeinsame Testplattformen bis hin zu abgestimmten Lieferplänen. Der Erfolg von großen KI-Projekten hängt deshalb nicht nur von einzelnen Technologien ab, sondern von der Fähigkeit zur Integration komplexer Lieferketten.

Altmans Asienreise setzte dieser Entwicklung ein sichtbares Zeichen: Nach Seoul waren Treffen mit Taiwan Semiconductor Manufacturing Co. (TSMC) und Hon Hai Precision Industry (Foxconn) in Taipei geplant. Diese Gesprächsreihe macht deutlich, dass der Bau von KI-Infrastruktur maßgeblich von länderübergreifender Zusammenarbeit abhängt — TSMC für die Chipfertigung, Foxconn für Systemintegration und Hardwaremontage, und Südkoreas Speicherhersteller für HBM-Komponenten. Nur durch die Kombination dieser Kompetenzen lassen sich die enormen Kapazitätsanforderungen effizient realisieren.

Wirtschaftspolitisch zeigt sich hier ein globaler Hebel: Länder, die eine komplette oder zumindest gut vernetzte Lieferkette anbieten können, gewinnen strategische Bedeutung. Gleichzeitig entstehen geopolitische Spannungsfelder, denn Halbleiter und KI-Infrastruktur sind zu sicherheitsrelevanten Industriesegmenten avanciert. Regierungen wägen daher zwischen Offenheit für Investitionen und dem Wunsch nach nationaler Kontrolle über kritische Technologien ab.

Technisch betrachtet werden auch Energieeffizienz und Kühltechnologien zu Schlüsselvariablen. KI-Cluster benötigen nicht nur massive Speicherkapazitäten, sondern auch effiziente Wärmeableitung, zuverlässige Stromversorgung und optimierte Software-Stacks, um die Hardware optimal zu nutzen. Investitionen in nachhaltige Energiequellen, Flüssigkeitskühlung oder modulare Rechenzentrumskonzepte können die Betriebskosten senken und die Skalierbarkeit erhöhen — Faktoren, die in der Gesamtbetrachtung über Profitabilität und Wettbewerbsfähigkeit entscheiden.

Brancheneffekte und Beobachtungspunkte

- Lieferdruck: Ein mögliches Volumen von 900.000 Waferstarts pro Monat würde die globale HBM-Kapazität stark unter Druck setzen und rasche Produktions-, Logistik- und Investitionsanläufe erzwingen. Unternehmen müssten kurzfristig Fertigungskapazitäten erweitern, was Investitionszyklen, Maschinenbeschaffung und Personalaufbau beschleunigt.

- Wettbewerbssituation: Samsung strebt an, neben SK Hynix eine größere Rolle im HBM-Markt zu spielen. Beide Konzerne könnten zudem von zusätzlicher Nachfrage nach konventionellem DRAM profitieren, wenn Stargate auch klassische Arbeitsspeicher in großem Stil benötigt. Wettbewerbsvorteile ergeben sich durch Yield-Optimierung, Kostensenkung und enge Kundenpartnerschaften.

- Breitere Zusammenarbeit: Samsung-Affiliates — von SDS bis zu Heavy Industries — könnten alles von schwimmenden Rechenzentrumskonzepten bis zu gemeinsamen Designpartnerschaften mit OpenAI erkunden. Solche Kooperationen erlauben es, Branchenexpertise zu bündeln und innovative Betriebsmodelle zu testen.

Stellen Sie sich eine Landschaft vor, in der Rechenzentren nicht nur in ihrer Größe, sondern auch in ihrem Typus diversifizieren: Landgestützte Megafarmen neben spezialisierten Standorten mit sehr niedriger Latenz, modularen Edge-Installationen und sogar experimentellen schwimmenden Plattformen. Diese Vielfalt entsteht aus dem Bedarf, Rechenleistung geographisch und funktional zu verteilen — sei es aus Gründen der Energieverfügbarkeit, Netzwerklatenz oder regulatorischer Vorgaben.

Für Investoren signalisiert das Modell von OpenAI und seinen Partnern eine Chance, aber auch ein Risikoprofil: Gewinner sind Unternehmen mit technischer Tiefe, stabilen Lieferketten und Innovationskraft. Gleichzeitig müssen politische Risiken, etwa Exportkontrollen oder Förderbedingungen, in die Bewertung einfließen. Analysten werden daher künftig nicht nur Produktionszahlen, sondern auch politische Absicherungen und Lieferverträge in ihre Modelle einfließen lassen.

Während Stargate von der Konzeptphase in die konkrete Bau- und Beschaffungsphase übergeht, gilt es, drei Dimensionen besonders aufmerksam zu verfolgen: die Verfügbarkeit von HBM und verwandten Speichertechnologien, die Ausbaupläne und Yield-Verbesserungen der Hersteller sowie politische Entscheidungen in Schlüsselmärkten wie Seoul und Taipei. Diese Faktoren werden maßgeblich darüber entscheiden, welche Akteure wirtschaftlich profitieren, wie schnell Kapazitäten skaliert werden können und wie resilient die entstehenden KI-Infrastrukturen gegenüber Störungen sind.

Die Entwicklung zeigt: KI verschiebt sich von Experimenten in der Cloud hin zu einer neuen industriellen Basis, die Rechenleistung, Speicherarchitektur und regionale Politik eng miteinander verknüpft. Wer hier frühzeitige Partnerschaften, technologische Führerschaft und robuste Geschäftsmodelle aufbaut, hat die besten Chancen, in der nächsten Phase der KI-Ökonomie zu dominieren.

Quelle: bloomberg

Kommentar hinterlassen