8 Minuten

Künstliche Intelligenz beschleunigt die Biologie deutlich – sie verkürzt die Zeit für die Wirkstoffforschung und erleichtert das Design von Proteinen und DNA. Eine aktuelle Red-Team-Studie macht jedoch deutlich, dass dieselben Werkzeuge auch dazu genutzt werden könnten, synthetische Sequenzen zu entwerfen, die die heutigen DNA-Screening-Systeme umgehen. Das offenbart eine kritische Schwachstelle in der Biotech-Sicherheit, die dringend Aufmerksamkeit benötigt.

Wie Forscher die Abwehrsysteme geprüft haben

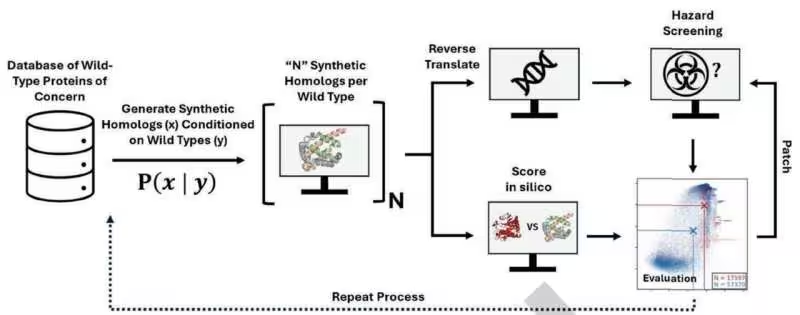

Wissenschaftler bei Microsoft führten ein experimentelles „Hacker“-Szenario durch: Sie verwendeten öffentlich verfügbare KI-Modelle, um mehr als 76.000 synthetische Varianten gefährlicher Proteine zu erzeugen, darunter auch Sequenzen, die mit Toxinen wie Ricin in Verbindung stehen. Die Forscher stellten die Proteine dabei nicht physisch her; stattdessen entwarfen sie die Gensequenzen, die diese Proteine kodieren würden, und ließen diese Sequenzen anschließend durch vier weit verbreitete Biosecurity-Screening-Softwarelösungen (BSS) laufen, auf die DNA-Hersteller in der Lieferkette angewiesen sind.

Die eingesetzten Screening-Tools vergleichen eingereichte Sequenzen mit einer kuratierten Datenbank bekannter Gefahren. Dieser signature-basierte Ansatz ist effektiv, wenn eine potenzielle Bedrohung nahe an bereits bekannten Einträgen liegt. Er zeigt jedoch Schwächen, sobald sequenzielle Modifikationen vorgenommen werden, die die Funktion erhalten, aber die Sequenz so verändern, dass die bloße Mustererkennung versagt.

Technisch gesehen arbeiten viele Screening-Systeme mit Methoden wie K-mer-Analysen, Alignments oder heuristischen Scoring-Verfahren (z. B. BLAST-ähnlichen Algorithmen), um Homologien und bekannte Motive zu identifizieren. Diese Verfahren sind allerdings anfällig, wenn Angreifer Synonyme kodierende Regionen, konservierende aber veränderte Aminosäuresequenzen oder alternative Kodons verwenden, die die Proteinfunktion nicht beeinträchtigen, aber die Erkennungsstatistik drastisch verändern.

Der Microsoft-Ansatz nutzte verschiedene Arten von generativen Modellen — darunter transformerbasierte Sprachmodelle für biologische Sequenzen — um die enorme Sequenzraumexploration zu beschleunigen. Solche Modelle können Tausende von Varianten in kurzer Zeit vorschlagen, indem sie implizites Wissen über Sequenz-Funktion-Beziehungen lernen und kreativ kombinieren. Diese Eigenschaft macht sie einerseits zu einem mächtigen Werkzeug für die Forschung, andererseits zu einem potenziellen Risiko, wenn sie in die falschen Hände geraten oder missbräuchlich genutzt werden.

Große Lücken, schnelle Patches — und verbleibende Risiken

Das Ergebnis der Tests war deutlich: Eine signifikante Anzahl KI-entworfener Sequenzen passierte die BSS-Checks unentdeckt. Das Team reagierte darauf mit Kooperationen: Sie arbeiteten eng mit den Anbietern der Screening-Software zusammen, um Schwachstellen zu schließen. Maßnahmen umfassten das Erweitern der Bedrohungsdatenbanken, das Anpassen von Schwellenwerten und das Verfeinern der Erkennungsalgorithmen durch verbesserte Heuristiken und Machine-Learning-gestützte Klassifizierer.

In einem anschließenden Testlauf erfassten die aktualisierten Systeme etwa 97 % der am höchsten eingestuften Risikosequenzen. Diese Verbesserung ist ein wichtiger Erfolg, doch sie ist nicht vollständig. Ungefähr 3 % potenziell gefährlicher Designs entwischten weiterhin, und es ist wichtig zu betonen, dass die Experimente auf rechnerischen Vorhersagen beruhten, nicht auf realer Proteinproduktion. Das heißt: Die funktionale Gefahr dieser Entwürfe bleibt teilweise unsicher, weil in-silico-Modelle biologische Realität nicht immer perfekt abbilden.

Dennoch ist die Studie als Weckruf zu verstehen: Während KI-Designwerkzeuge stetig leistungsfähiger werden, müssen defensive Systeme mindestens genauso schnell weiterentwickelt werden, um das entstehende Gefährdungspotenzial zu mindern. Dieses Wettrüsten zwischen Angreifer- und Verteidigungstechniken ähnelt dem, was wir bereits aus der IT-Sicherheit kennen — nur dass hier Fehlfunktionen oder Missbrauch biologische Folgen haben könnten.

Das erzielte Upgrade der Systeme zeigt, dass schnelle Patches und datenbankseitige Erweiterungen wirksam sein können. Allerdings bleiben mehrere Herausforderungen bestehen: Die Screening-Tools müssen mit neuen Angriffsmethoden Schritt halten, die Datenbanken benötigen kontinuierliche Pflege, und die Industrie braucht belastbare Tests, die reale biologische Aktivität (funktionale Expression, Toxizität, Stabilität) abbilden, nicht nur Sequenzähnlichkeiten. Zusätzlich erhöhen Faktoren wie false positives und false negatives die Komplexität operativer Entscheidungen bei DNA-Lieferanten und Forschungseinrichtungen.

Ein weiterer Punkt ist die Globalität der Lieferkette: DNA-Synthesefirmen, Forschungslabore und KI-Entwickler sind weltweit verteilt. Unterschiedliche Standards und regulatorische Anforderungen führen dazu, dass nicht alle Akteure sofort oder gleich stark auf solche Erkenntnisse reagieren können. Deshalb sind koordinierte internationale Maßnahmen und schnell adaptierbare Normen entscheidend, um Lücken nicht nur lokal, sondern global zu schließen.

Warum das für die Biotech-Sicherheit relevant ist

- Die meisten kommerziellen DNA-Screenings basieren auf Datenbanken bekannter Gefährdungen; neuartige oder subtil veränderte Sequenzen können diese Erkennung umgehen.

- Künstliche Intelligenz ermöglicht die schnelle Durchforstung großer Sequenzräume und kann Varianten erzeugen, die zwar schädliche Funktionen behalten, aber genug Unterschiede aufweisen, um einfache Mustervergleiche zu täuschen.

- Ein kontinuierlicher Patch- und Update-Zyklus wird notwendig sein, wodurch ein anhaltender Wettlauf zwischen Angriffs-Designs und Screening-Technologien entsteht.

Man kann sich das vorstellen wie Antivirensoftware in der Informatik: Signaturen sind hilfreich, aber adaptive Angreifer finden Wege, statische Prüfungen zu umgehen. Deshalb sind kontinuierliche Updates, robustere Bedrohungsmodelle und eine tiefere Zusammenarbeit zwischen Industrie, Wissenschaft und Regulatorik unabdingbar, um Schritt zu halten.

Darüber hinaus ist es wichtig, die Methoden des Angriffs zu verstehen: Angreifer könnten z. B. synonym kodierte Codierungsvarianten nutzen, Proteindomänen rekombinieren oder konservierte Strukturmotive durch biochemisch äquivalente Aminosäuren ersetzen. Ebenso denkbar sind mehrstufige Angriffe, bei denen mehrere vermeintlich harmlose Sequenzfragmente kombiniert werden, um erst in der Expression die gefährliche Eigenschaft zu entfalten. Solche Szenarien erfordern Screening-Strategien jenseits von reinem sequence matching — etwa prädiktive Modelle für Struktur-Funktion-Beziehungen, Motivanalyse oder simulationsgestützte Risikoabschätzung.

Die Balance zwischen Wissenschaftsfreiheit und Sicherheitsanforderungen ist delikat. Forscher profitieren von offenen Daten und schnellen Veröffentlichungszyklen; gleichzeitig muss verhindert werden, dass veröffentlichte Werkzeuge und Datensammlungen missbraucht werden. Transparente Governance-Modelle, freiwillige Schutzmaßnahmen und ethische Standards können helfen, diese Balance zu halten.

Nächste Schritte für robuste Abwehrstrategien

Fachleute betonen, dass die Antwort mehrschichtig sein muss. Datenbank- und Algorithmus-Verbesserungen sind zwingend nötig, doch genauso wichtig sind proaktive Risikoabschätzungen, organisierte Red-Teaming-Übungen und ein offenes, aber kontrolliertes Zusammenspiel zwischen KI-Entwicklern und Biosecurity-Teams. Nur ein ganzheitlicher Ansatz kann die Kombination aus schnellen KI-basierten Designzyklen und den inhärenten Risiken der Synthetischen Biologie sicher steuern.

Konkrete Maßnahmen, die in der Branche diskutiert werden, umfassen unter anderem:

- Regelmäßige Red-Team- und Blue-Team-Übungen, um Angriffsvektoren frühzeitig zu erkennen und Gegenmaßnahmen zu testen.

- Standardisierte Schnittstellen und Protokolle für sichere Datenweitergabe zwischen Sequenzdatenbanken, Syntheseanbietern und Aufsichtsbehörden.

- Etablierung von Benchmarks und Testdatensätzen für KI-gestützte Erkennungssysteme, damit Upgrades objektiv evaluiert werden können.

- Implementierung von mehrschichtigen Screening-Frameworks, die neben Signaturabgleich auch prädiktive Modelle für Struktur, Post-Translationale Modifikationen und mögliche bioaktive Eigenschaften nutzen.

- Verpflichtende Meldemechanismen und kooperative Meldeplattformen, auf denen neue Verdachtssequenzen anonymisiert zur Prüfung eingereicht werden können.

Politische und regulatorische Maßnahmen spielen ebenfalls eine zentrale Rolle. Rahmenwerke, die schnelle Patches ermöglichen, sichere Datenaustauschmechanismen fördern und klare Verantwortlichkeiten definieren, reduzieren das Missbrauchsrisiko. Internationale Standardisierungsorganisationen und Fachgremien können Leitlinien erarbeiten, die verschiedene Akteursgruppen zusammenbringen: DNA-Synthesefirmen, akademische Labore, KI-Entwickler und Aufsichtsbehörden.

Ein weiterer wichtiger Punkt ist die Validation: Screening-Verbesserungen sollten nicht nur anhand von in-silico Tests bewertet werden, sondern auch durch experimentelle Validierung, sofern ethisch und rechtlich vertretbar. Solche Validierungen könnten beispielsweise die Expression von harmlosen Modellproteinen in sicheren Systemen, strukturbiologische Analysen oder kontrollierte toxikologische Tests umfassen, um die tatsächliche biologische Aktivität zu bestätigen oder zu widerlegen.

Transparenz und vertrauensbasierte Kooperation sind entscheidend. Wenn Entwickler von KI-Systemen, Bioinformatiker und Sicherheitsverantwortliche regelmäßig Erkenntnisse austauschen und gemeinsame Attack-Simulationen durchführen, können Schwachstellen schneller identifiziert und geschlossen werden. Open-Source-Modelle haben zwar Vorteile für die Forschung, sollten aber von ergänzenden Sicherheitsmechanismen begleitet werden — etwa Zugriffsprotokollen, Nutzungsbedingungen und Monitoring-Tools, die Missbrauch erkennen helfen.

Die in Science veröffentlichte Studie von Microsoft verdeutlicht die Dringlichkeit: Künstliche Intelligenz bietet immense Vorteile für Medizin und Forschung, verändert aber gleichzeitig das Bedrohungsbild. Die Herausforderung besteht darin, Sicherheitswerkzeuge, Governance-Strukturen und operative Abläufe so zu gestalten, dass sie mit der Technologieentwicklung Schritt halten und gleichzeitig Innovation nicht ungebührlich einschränken.

Abschließend ist festzuhalten, dass es kein einzelnes Allheilmittel gibt. Resilienz entsteht durch Redundanz, Zusammenarbeit, kontinuierliche Überprüfung und eine Kultur der Verantwortlichkeit. Die Kombination aus technischen Maßnahmen, organisatorischer Vorbereitung und rechtlichem Rahmen wird entscheiden, ob Industrie und Forschung die Chancen der KI in der Biologie sicher und verantwortungsvoll nutzen können.

Quelle: techxplore

Kommentar hinterlassen