8 Minuten

AMDs wegweisende Vereinbarung mit OpenAI hat die Märkte aufgerüttelt und die Debatte darüber neu entfacht, wer im Wettlauf um KI-Beschleuniger die Nase vorn hat. Aktienkurse schwankten deutlich, als Investoren die Nachricht einer milliardenschweren Bereitstellung von AMD-GPUs in einem der einflussreichsten KI-Labore der Branche verarbeiteten.

Aktien reagieren: OpenAI setzt auf AMDs Instinct‑Chips

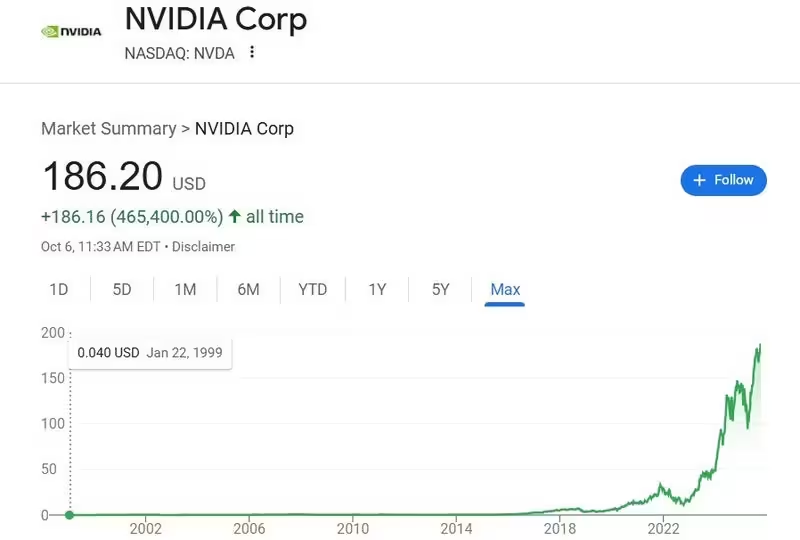

Kurz nach der Ankündigung, dass OpenAI rund 6 Gigawatt an Instinct‑GPUs von AMD einsetzen will, stieg der Aktienkurs von AMD in den frühen Handelsstunden um mehr als 27 %. Nvidia fiel zunächst zurück, erholte sich aber im weiteren Verlauf der Sitzung wieder leicht. Solche starken Kursbewegungen zeigen, wie schnell sich die Marktstimmung ändern kann, wenn ein großer KI‑Player offen eine Diversifizierung seiner Hardwarelieferanten signalisiert.

Die Schlagzeilen verstärkten sich durch die finanziellen Details des Deals: OpenAI erhält eine Options‑ bzw. Wandeloption, mit der bis zu 160 Millionen AMD‑Aktien zu einem nominalen Preis gekauft werden können. Dieses Instrument könnte OpenAI bei minimalen Vorabkosten einen Anteil von ungefähr 10 % an AMD verschaffen. Zum Vergleich: AMDs Marktkapitalisierung liegt im hohen zweistelligen bis hunder Milliarden‑Bereich, während Nvidia weiterhin zu den wertvollsten US‑Technologieunternehmen zählt.

Warum GPUs für KI weiter entscheidend sind — und warum der Wettbewerb anzieht

GPUs sind für bestimmte KI‑Aufgaben nach wie vor die beste Wahl, weil sie massiv parallel rechnen können. Moderne Large Language Models und andere neuronale Netze benötigen riesige Mengen an Matrix‑Multiplikationen und Vektoroperationen, die tausende Kern‑Threads gleichzeitig verarbeiten. CPUs hingegen erledigen viele Aufgaben sequenziell und sind für diese Art von Workload weniger effizient.

Doch die Landschaft der KI‑Recheninfrastruktur verändert sich: OpenAIs Deal mit AMD, ergänzt durch laufende Vereinbarungen mit Nvidia und Broadcom, dokumentiert eine klare Strategie zur Hardwarediversifizierung. Das Ziel ist nicht nur, Kostenvorteile zu sichern, sondern auch Versorgungssicherheit und Verhandlungsspielraum gegenüber einzelnen Anbietern zu erhöhen.

Parallel dazu entwickeln Hyperscaler und Cloud‑Provider eigene Beschleuniger: Google mit TPUs, Amazon mit Trainium und Inferentia, andere mit maßgeschneiderten ASICs. Diese maßgeschneiderten Lösungen steigern den Druck auf traditionelle GPU‑Anbieter, liefern aber nicht automatisch eine sofortige Ablösung—denn Ökosysteme, Softwarekompatibilität und eingesetzte Basis an Hardware sind mächtige Hürden.

Technik, die den Unterschied macht

Worauf es technisch ankommt, ist mehr als rohe Rechenleistung. Wichtige Faktoren sind Speichergeschwindigkeit und -bandbreite (HBM), effiziente Interconnects zwischen Chips (z. B. proprietäre Links wie NVLink oder Infinity Fabric), die Latenz der Verbindung zwischen Servern, sowie Energieverbrauch pro Rechenoperation. Auch Software: Toolchains, Bibliotheken und Optimierungen für Training und Inferenz entscheiden oft über die tatsächliche Praxisleistung.

AMD bringt mit den Instinct‑Reihen eine Kombination aus eigener Chiparchitektur und der Open‑Source‑Software ROCm, während Nvidia sein breites Ökosystem um CUDA, cuDNN und TensorRT pflegt. Beide Ansätze haben Vor‑ und Nachteile: Offene Stacks fördern Portabilität, proprietäre Stacks liefern häufig optimierte Leistung und eine große Entwicklerbasis.

Analysten sehen starkes KI‑Investitionspotenzial — Nvidia bleibt ein Dominant

Trotz kurzfristiger Volatilität bleiben die meisten Analysten auf Wall Street gegenüber Nvidia positiv eingestellt. Die anhaltende Nachfrage nach KI‑Infrastruktur wird als Treiber für nachhaltiges Wachstum gesehen. Einige Marktbeobachter prognostizieren, dass sich der adressierbare Gesamtmarkt für KI‑Compute und zugehörige Netzwerkinfrastrukturen bis 2030 erheblich ausweiten könnte — mit Werten, die in die Billionen reichen könnten. Das erklärt, warum das Rennen um Marktanteile so hart ist.

Gleichzeitig ist Nvidias Vorteil nicht nur technischer Natur: Das Unternehmen verfügt über ein großes, etabliertes Ökosystem aus Hardware, optimierter Software und einer installierten Basis in Rechenzentren weltweit. Selbst wenn Mitbewerber wie AMD oder spezialisierte Chipentwickler vergleichbare Rohleistung oder bessere Energieeffizienz liefern, ist die Verdrängung eines Platzhirschen auf großem Maßstab weder schnell noch sicher.

Neue Marktteilnehmer haben dennoch Chancen: Sie können gezielt Nischen besetzen, Kosten‑ oder Energieeffizienzvorteile bieten oder spezialisierte Funktionen für bestimmte ML‑Workloads liefern. Besonders bei Inferenz‑Workloads, Edge‑Deployment oder spezifischen Modellarchitekturen können alternative Beschleuniger attraktive wirtschaftliche Vorteile bringen.

Finanzielle Implikationen für Investoren

Für Anleger bedeutet der Deal eine Mischung aus Opportunity und Risiko. Auf der einen Seite ist die Möglichkeit, dass OpenAIs Beteiligung AMDs finanzielle Stabilität und zukünftige Aufträge stärkt, attraktiv. Auf der anderen Seite können Unsicherheiten bestehen bleiben: Wird OpenAI die Option ausüben? Wie verteilt sich der Einsatz zwischen AMD‑ und Nvidia‑Hardware? Und wie reagieren andere Großkunden und Hyperscaler? Solche Fragen beeinflussen die Bewertung und die Volatilität auf kurze Sicht.

Worauf es jetzt ankommt: Beobachtungspunkte für Marktteilnehmer

- Konkrete Zeitpläne für OpenAIs Rollout und welche Workloads auf AMD‑ versus Nvidia‑Hardware laufen werden.

- Weitere kommerzielle Details: Übt OpenAI die Aktienoption aus und welche Folgen hat das für Aktionärsstruktur und Marktvertrauen?

- Ankündigungen von Hyperscalern zu eigenen Beschleunigerprojekten oder erweiterten Partnerschaften, die Beschaffungsstrategien ändern könnten.

- Benchmark‑Tests, die Leistungsdaten, Energieeffizienz und Gesamtkostenbetrachtungen (Total Cost of Ownership) zwischen AMD Instinct, Nvidia GPUs und kundenspezifischen Chips vergleichen.

- Fertigungskapazitäten und Lieferkettenfaktoren: Halbleiterkapazitäten, Packaging‑Engpässe und HBM‑Produktion sind zentrale Engpässe in der Branche.

Stellen Sie sich KI‑Rechenzentren vor, in denen mehrere Architekturen parallel arbeiten und je nach Aufgabe die effizienteste Hardware gewählt wird. Dieses Multi‑Vendor‑Szenario wirkt heute realistischer denn je. Es bietet Flexibilität, verringert Ausfallrisiken durch einzelne Lieferanten und erlaubt gezielte Kostenoptimierung – zugleich erhöht es aber die Komplexität beim Management, der Software‑Integration und bei der Orchestrierung von Workloads.

Operationalisierung in Rechenzentren

Die praktische Umsetzung einer Multi‑Vendor‑Strategie erfordert ausgereifte Tools: Orchestrierer, die Workloads abhängig von Latenz, Durchsatz und Kosten intelligent verteilen; Monitoring‑Systeme, die Energie‑ und Leistungsdaten in Echtzeit liefern; und Software‑Layer, die Modelle mit unterschiedlichen Backends kompatibel machen. Viele Unternehmen investieren deshalb nicht nur in Hardware, sondern gleichermaßen in Softwareengineering und Infrastrukturautomatisierung.

Zudem spielen Skaleneffekte eine Rolle: Große Rechenzentrumsbetreiber können durch Volumenrabatte und langfristige Verträge bessere Konditionen erzielen. Kleinere Anbieter oder Forschungslabore müssen ihre Auswahl eher am besten Preis‑Leistungs‑Verhältnis und der Verfügbarkeit orientieren.

Technologie und Ökosystem: Mehr als nur Chips

Wer die KI‑Infrastruktur von morgen gewinnen will, braucht mehr als schnelle Siliziumchips. Softwarebibliotheken, Entwickler‑Tools, Partnerschaften mit Cloud‑Providern, Ökosystemsupport für beliebte Frameworks (z. B. PyTorch, TensorFlow) und ein Netzwerk aus Systemintegratoren zählen ebenso. Nvidia hat hier mit CUDA ein Jahrzehnt Vorsprung aufgebaut; AMD versucht, mit ROCm und Kooperationen aufzuholen.

Auch die Kompatibilität mit bestehenden Modellen ist entscheidend. Viele Forschungsteams und Produktionssysteme sind auf Toolchains und Optimierungen angewiesen, die sich über Jahre etabliert haben. Ein neuer Beschleuniger muss also nicht nur eine starke Rohleistung bieten, sondern auch den Migrationsaufwand möglichst gering halten.

Ökonomische Grenzen: Energie, Kühlung, TCO

Für Betreiber großer KI‑Cluster ist die Energieeffizienz ein Schlüsselkriterium. Energie‑ und Kühlkosten können über die Lebenszeit einer Anlage einen großen Teil der Gesamtkosten ausmachen. Deshalb wird die Leistungsaufnahme pro Modellinferenz oder pro Trainingsiteration häufig als zentrales Wirtschaftlichkeitsmaß herangezogen. Auch diese Metrik entscheidet darüber, ob ein Anbieter auf lange Sicht konkurrenzfähig ist.

Ein weiterer Punkt sind Investitionszyklen: Rechenzentren planen Hardwarekäufe oft Jahre im Voraus. Das führt zu Trägheit im Marktwechsel — selbst wenn neue Architekturen Vorteile versprechen, dauert die großflächige Adoption oft länger als die Schlagzeilen suggerieren.

Was bedeutet das für Entwickler und Ingenieure?

Für technische Teams heißt die Entwicklung höhere Komplexität, aber auch neue Chancen. Die Arbeit an Hardware‑agnostischen Frameworks, Performance‑Profiling und Energiesparstrategien wird wichtiger. Entwickler, die Erfahrung mit mehreren Stacks sammeln — etwa mit CUDA, ROCm, ONNX Runtime und anderen Optimierern —, sind gefragt.

Forschungsteams profitieren von der Auswahl: Verschiedene Beschleuniger können für unterschiedliche Experimenttypen geeignet sein — etwa schnelleres Prototyping auf einer Plattform, effizientere Produktion auf einer anderen. Dieser pragmatische Ansatz kann Entwicklungszyklen beschleunigen und Kosten senken.

Regulatorische und geopolitische Überlegungen

Nicht zuletzt spielen Handelsregeln, Exportkontrollen und geopolitische Spannungen eine Rolle. Länderpolitische Entscheidungen können Lieferketten beeinflussen und damit die Verfügbarkeit von High‑End‑Chips in bestimmten Regionen einschränken. Unternehmen müssen diese Risiken in ihre Beschaffungsstrategien einpreisen.

Insgesamt bleibt der Markt in Bewegung. Die AMD‑OpenAI‑Partnerschaft ist ein markantes Signal dafür, dass große KI‑Player Strategien zur Risikoverteilung und Kostenoptimierung fahren. Für Investoren, Ingenieure und Betreiber ist das sowohl eine Chance als auch eine Aufforderung, technisches Wissen, Vertragsdetails und Markttrends genau zu beobachten.

Die nächsten Monate dürften neue Benchmarks, detailliertere Kommerztermine und weitere Partnerschaften bringen. Für alle Beteiligten gilt: Augen offen halten, technische Metriken hinterfragen und nicht nur auf Headlines reagieren. Das Rennen um die KI‑Infrastruktur hat gerade erst eine neue Runde begonnen — und es ist alles andere als ausgemacht, wer am Ende die Ziellinie als Erster überquert.

Quelle: phonearena

Kommentar hinterlassen