7 Minuten

OpenAI hat GPT-5-Codex-Mini eingeführt, eine kompakte und budgetfreundliche Variante seines GPT-5-basierten Codex-Codierungsmodells. Das Modell ist darauf ausgelegt, Entwickler:innen kostengünstigen Zugang zu fortgeschrittener Codegenerierung und Unterstützung bei Softwareentwicklungsaufgaben zu bieten.

Was das neue Mini-Modell bietet

GPT-5-Codex-Mini ist ein kleineres, kostenoptimiertes Geschwistermodell von GPT-5-Codex. Es zielt darauf ab, die meisten Kernfunktionen für Entwickler bereitzustellen — wie das Generieren neuer Projekte, das Hinzufügen von Features und Tests sowie groß angelegte Refaktorisierungen — und gleichzeitig die Rechenkosten zu senken, sodass Teams mit demselben Budget deutlich mehr Aufgaben ausführen können. Laut OpenAI ermöglicht das Mini-Modell in der Praxis etwa die vierfache Nutzung im Vergleich zum vollen GPT-5-Codex, wobei nur ein moderater Rückgang bei Genauigkeit und Inferenzleistung in Kauf genommen wird.

Das Mini-Modell ist vor allem für Teams interessant, die große Mengen routinemäßiger Codeaufgaben automatisieren möchten, ohne die höheren Betriebskosten des großen Modells zu tragen. Durch gezielte Kompromisse bei Modellgröße und Rechenintensität lassen sich typische Entwickler-Workloads wie Boilerplate-Generierung, Test-Suites und einfache Refactorings deutlich günstiger skalieren.

Wesentliche Vorteile auf einen Blick

- Geringere Kosten pro Anfrage: ermöglicht höhere Durchsätze pro Budget.

- Effiziente Integration: bereits verfügbar in CLI und als IDE-Plugin.

- Gute Kernfähigkeiten: erhält viele Stärken des größeren GPT-5-Codex für Standardaufgaben.

- Skalierbar: geeignet für CI-Pipelines, lokale Workflows und Editor-gestützte Sessions.

Wie es abschneidet: Reale Benchmark-Zahlen

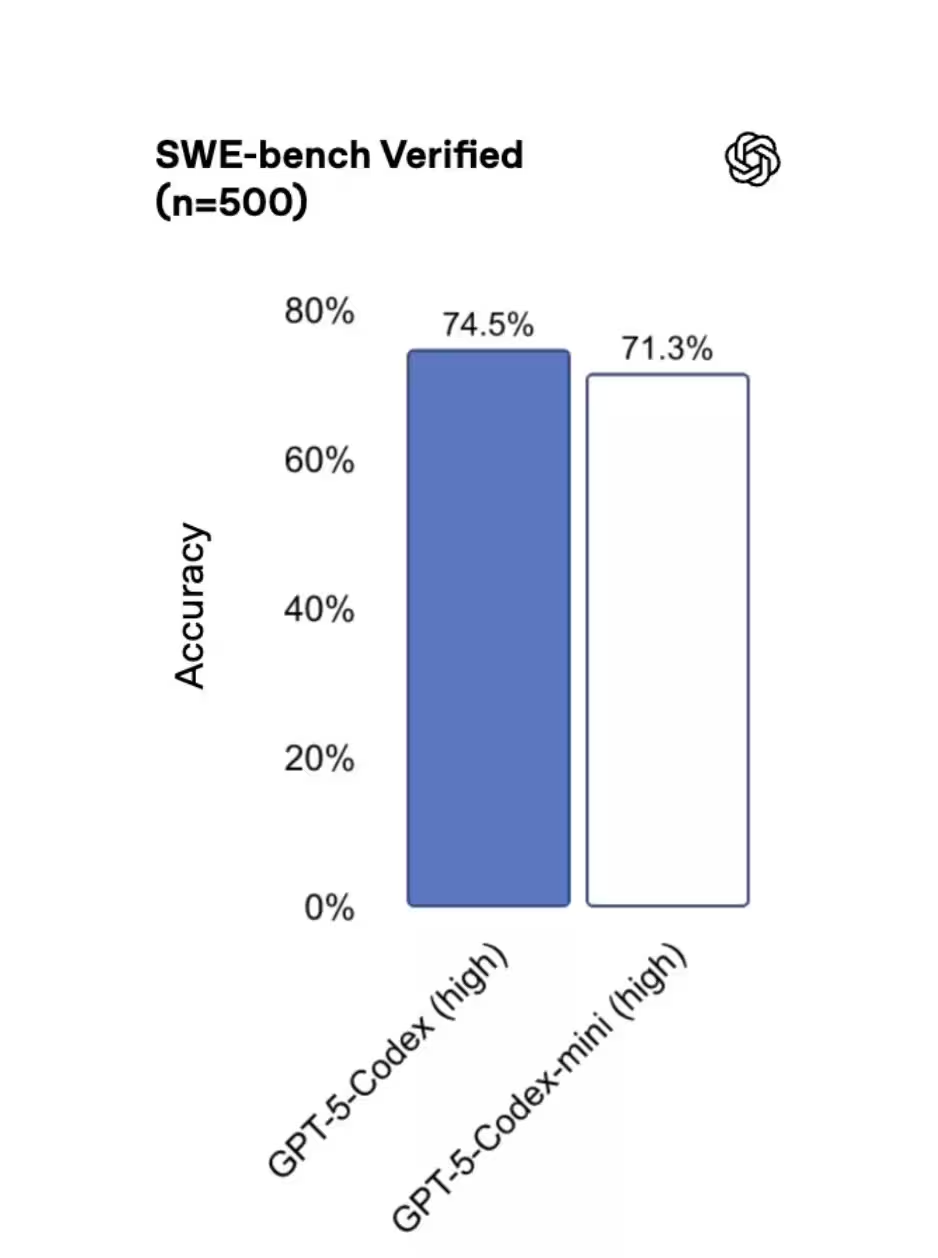

Benchmark-Ergebnisse auf SWE-bench Verified zeigen, dass sich die drei Modelle relativ nahe beieinander positionieren: GPT-5 High erzielte 72,8 %, GPT-5-Codex 74,5 % und GPT-5-Codex-Mini 71,3 %. Diese Zahlen deuten darauf hin, dass das Mini-Modell viele Stärken des Originalmodells bewahrt, während es spürbare Kosteneinsparungen ermöglicht — ein attraktives Verhältnis für viele produktive Workflows.

Bei der Bewertung solcher Benchmarks ist es wichtig, die Metriken im Kontext zu betrachten. Ein Unterschied von wenigen Prozentpunkten in einer Benchmark-Score kann in kritischen Einsatzszenarien relevant sein (z. B. bei sicherheitskritischer Software oder hochkomplexen Algorithmen), während derselbe Unterschied für Routineaufgaben oder Massenverarbeitung oft akzeptabel ist. Entwicklerteams sollten deshalb Tests unmittelbar auf ihren eigenen Codebasen und Metriken durchführen, um das ideale Gleichgewicht zwischen Kosten und Genauigkeit zu finden.

Benchmarks richtig interpretieren

Einige Hinweise, um Benchmarks sinnvoll zu nutzen:

- Vergleichen Sie Benchmarks auf ähnlichen Datensätzen und mit identischen Evaluationseinstellungen (Token-Limits, Timeout, Eingangsformat).

- Führen Sie Probeläufe mit realen Repositories durch, um die praktische Wirkung auf Build-Zeiten, Testdurchlaufdauer und Fehlerraten zu messen.

- Beachten Sie Latenz und Durchsatz: Ein günstigeres Modell kann höhere Parallelität ermöglichen, was die Gesamtkosten pro erledigter Aufgabe reduziert.

Wann Entwickler das Mini wählen sollten

Wann ist das Mini die richtige Wahl? OpenAI empfiehlt GPT-5-Codex-Mini für leichtere Engineering-Aufgaben oder als Fallback, wenn man sich den Nutzungslimits des primären Modells nähert. Die Codex-Tooling-Empfehlungen raten sogar dazu, auf das Mini umzuschalten, sobald etwa 90 % des Kontingents erreicht sind. Man kann sich das wie ein Drosselungsmodell vorstellen: Lassen Sie risikoreiche oder qualitativ anspruchsvolle Aufgaben auf dem vollständigen GPT-5-Codex laufen und delegieren Sie Routine- oder volumenstarke Arbeiten an das Mini, um Budget und Durchsatz zu strecken.

Typische Einsatzszenarien für das Mini

- Automatische Erstellung von Boilerplate-Code und Projekt-Scaffolding.

- Generierung und Aktualisierung von Unit- und Integrationstests in großem Umfang.

- Großflächige, aber einfache Refaktorisierungen (z. B. Umbenennungen, API-Adaptionen).

- Batch-Prozesse in CI/CD-Pipelines, bei denen Latenz wichtiger ist als perfektes reasoning.

Für komplexe Architekturentscheidungen, sicherheitskritische Reviews oder Aufgaben mit hohen Anforderungen an formale Korrektheit sollten Teams weiterhin das vollständige GPT-5-Codex einsetzen oder eine menschliche Überprüfung einplanen. Ein hybrider Ansatz — kritische Jobs auf dem großen Modell, Bulk-Operationen auf dem Mini — bietet oft das beste Kosten-/Nutzenverhältnis.

Wo man es heute einsetzen kann

Das Mini ist bereits in der Command Line Interface (CLI) und als IDE-Plugin verfügbar, die API-Unterstützung folgt zeitnah. Das bedeutet, Entwickler:innen können es sofort in lokale Workflows, Continuous-Integration-Pipelines und editorbasierte Coding-Sessions integrieren — noch bevor die breitere API-Rollout abgeschlossen ist.

Integration in Entwicklungsprozesse

Einige praktische Integrationsbeispiele:

- CLI-Skripte: Automatisierte Refactorings oder Test-Generierung als Teil von Pre-Commit-Hooks.

- IDE-Plugins: Kontextbezogene Code-Vervollständigung, Vorschläge für Verbesserungen und On-Demand-Refactorings direkt im Editor.

- CI/CD-Pipelines: Batch-Verarbeitung großer Codebasen, Erzeugung zusätzlicher Tests oder automatisierte Code-Checks.

Die Verfügbarkeit als Plugin und CLI erleichtert es Teams, die neuen Möglichkeiten schnell zu evaluieren. Sobald die API allgemein verfügbar ist, eröffnen sich zusätzliche Integrationspfade — etwa serverseitige Automatisierungen, Platform-as-a-Service-Workflows und engere Verknüpfung mit Issue-Tracking-Systemen.

Hinter den Kulissen: Leistungs- und Zuverlässigkeitsverbesserungen

OpenAI hat außerdem Infrastrukturverbesserungen angekündigt, um die Nutzung von Codex vorhersehbarer zu machen. Maßnahmen zur GPU-Effizienz und Routing-Optimierungen haben es OpenAI erlaubt, die Rate-Limits für ChatGPT Plus, Business und Education Abonnenten um 50 % zu erhöhen. Pro- und Enterprise-Kunden erhalten priorisierte Verarbeitung, um Spitzenperformance und Reaktionsfähigkeit zu erhalten.

Frühere Probleme, die durch Caching-Fehler die verfügbare Kapazität verringerten, wurden ebenfalls adressiert, sodass Entwickler im Tagesverlauf eine konstantere und verlässlichere Erfahrung sehen sollten. Solche Infrastrukturverbesserungen sind wichtig, um Produktionsnutzungen vorhersehbar und skalierbar zu machen.

Technische Aspekte der Optimierungen

Zu den konkreten Optimierungen zählen:

- GPU-Auslastungsverbesserungen: Besseres Packing von Batch-Anfragen, reduzierte Leerlaufzeiten und optimierte Mixed-Precision-Strategien.

- Routing-Optimierungen: Intelligente Lastverteilung zwischen Rechenzentren und Priorisierungsklassen.

- Caching-Fixes: Stabilere Cache-Invaliderung und verbesserte Kapazitätsabschätzung.

Diese Änderungen wirken sich nicht nur auf Verfügbarkeit, sondern auch auf Latenz und Kosten aus. Für Teams bedeutet das: geringere Wahrscheinlichkeit für unerwartete Limit-Engpässe und eine zuverlässigere Planung von Automatisierungs-Jobs.

Praktische Empfehlungen für den Einsatz

Um das Beste aus GPT-5-Codex-Mini herauszuholen, empfehlen sich folgende Vorgehensweisen:

- Hybridstrategie implementieren: Kritische, risikoreiche Tasks auf dem Full-Modell belassen; Bulk-Operationen und wiederkehrende Aufgaben an das Mini übergeben.

- Quota- und Kosten-Monitoring: Alarme bei 80–90 % Budgetauslastung konfigurieren und die vorgeschlagene Umschaltung zum Mini automatisieren.

- Regressionstests: Automatisierte Tests verwenden, um die Auswirkungen des Modells auf Funktionalität und Codequalität regelmäßig zu prüfen.

- Entwicklerrichtlinien: Regeln definieren, welche Arten von Änderungen automatisch durch das Modell übernommen werden dürfen und welche menschliche Review erfordern.

Außerdem sollten Teams Metriken wie Fehlerquote, Zeit bis zur Fertigstellung, durchschnittliche Latenz und Kosten pro automatisierter Aufgabe erfassen, um den ROI der Automatisierung laufend zu bewerten.

Sicherheits- und Qualitätskontrollen

KI-gestützte Codegenerierung kann neue Risiken einführen, etwa ungewollte Lizenzverletzungen, Schwachstellen oder stilistische Inkonsistenzen. Praktische Gegenmaßnahmen sind:

- Automatisierte Sicherheits-Scans (SAST/DAST) nach KI-generierten Änderungen.

- Peer-Reviews und Pull-Request-Policies für Änderungen, die Produktionsreife erreichen sollen.

- Schrittweise Einführung (Canary Releases) für KI-generierte Features.

Mit diesen Kontrollen lässt sich die Qualität sichern, ohne die Effizienzgewinne aufzugeben.

Warum das Mini für viele Teams sinnvoll ist

GPT-5-Codex-Mini bietet Teams eine praktikable Möglichkeit, die Automatisierung von Programmieraufgaben zu skalieren, ohne die Kosten proportional steigen zu lassen. Für viele Entwickler wird es die bessere Wahl für volumenstarke oder risikoärmere Aufgaben sein — besonders während OpenAI die API-Zugänge weiter ausbaut und Performancegarantien verschärft.

Die Kombination aus integriertem CLI/IDE-Support, verbesserten Infrastrukturressourcen und klaren Betriebsstrategien macht das Modell zu einer praktikablen Option für Organisationen, die ihren Entwicklungsprozess beschleunigen und gleichzeitig die Kosten kontrollieren wollen.

Wichtige Takeaways

- Das Mini eignet sich hervorragend für massenhafte, wiederkehrende Aufgaben und für Teams mit begrenztem Budget.

- Benchmarks zeigen geringfügig niedrigere Scores, aber der reale Nutzen hängt vom konkreten Anwendungsfall ab.

- Eine hybride Nutzung in Kombination mit Monitoring und Prüfprozessen ist die empfohlene Best-Practice.

Insgesamt steht GPT-5-Codex-Mini für einen praktischen Kompromiss zwischen Kosten, Geschwindigkeit und Qualität — ein Modell, das viele Entwicklungsorganisationen dabei unterstützen kann, KI-gestützte Programmierautomatisierung kosteneffektiv in Produktion zu bringen.

Quelle: smarti

Kommentar hinterlassen