6 Minuten

NVIDIA hat bestätigt, dass die GTC 2026 am 15. März in San Jose zurückkehren wird, und CEO Jensen Huang wird am 16. März eine zentrale Keynote halten. Die Entwicklerkonferenz richtet sich vorrangig an technische Entscheider, Entwickler und Infrastrukturteams und entwickelt sich zu einer tiefgehenden Auseinandersetzung mit KI-Infrastruktur — von Vera Rubin GPU-Clustern bis hin zu praxisorientierten Workshops zu CUDA und Robotik.

What to expect at GTC 2026

Die Agenda der GTC in diesem Jahr ist stark auf Enterprise-KI und Fortschritte im Rechenzentrumsbereich ausgerichtet. Der offizielle Zeitplan von NVIDIA hebt praktische Sessions zu CUDA-Bibliotheken, Entwickler-Tooling für Robotik sowie technische Briefings hervor, die Partnern und Entwicklern helfen sollen, Infrastruktur-Upgrades sinnvoll zu planen und erfolgreiche Migrationspfade für KI-Workloads zu definieren. Erwarten Sie detaillierte Präsentationen zu Software-Stacks (CUDA, cuDNN, Triton), Containerisierung (Docker, Kubernetes) und Best Practices für das Training großer Modelle samt Ressourcenplanung, Monitoring und Kostenoptimierung.

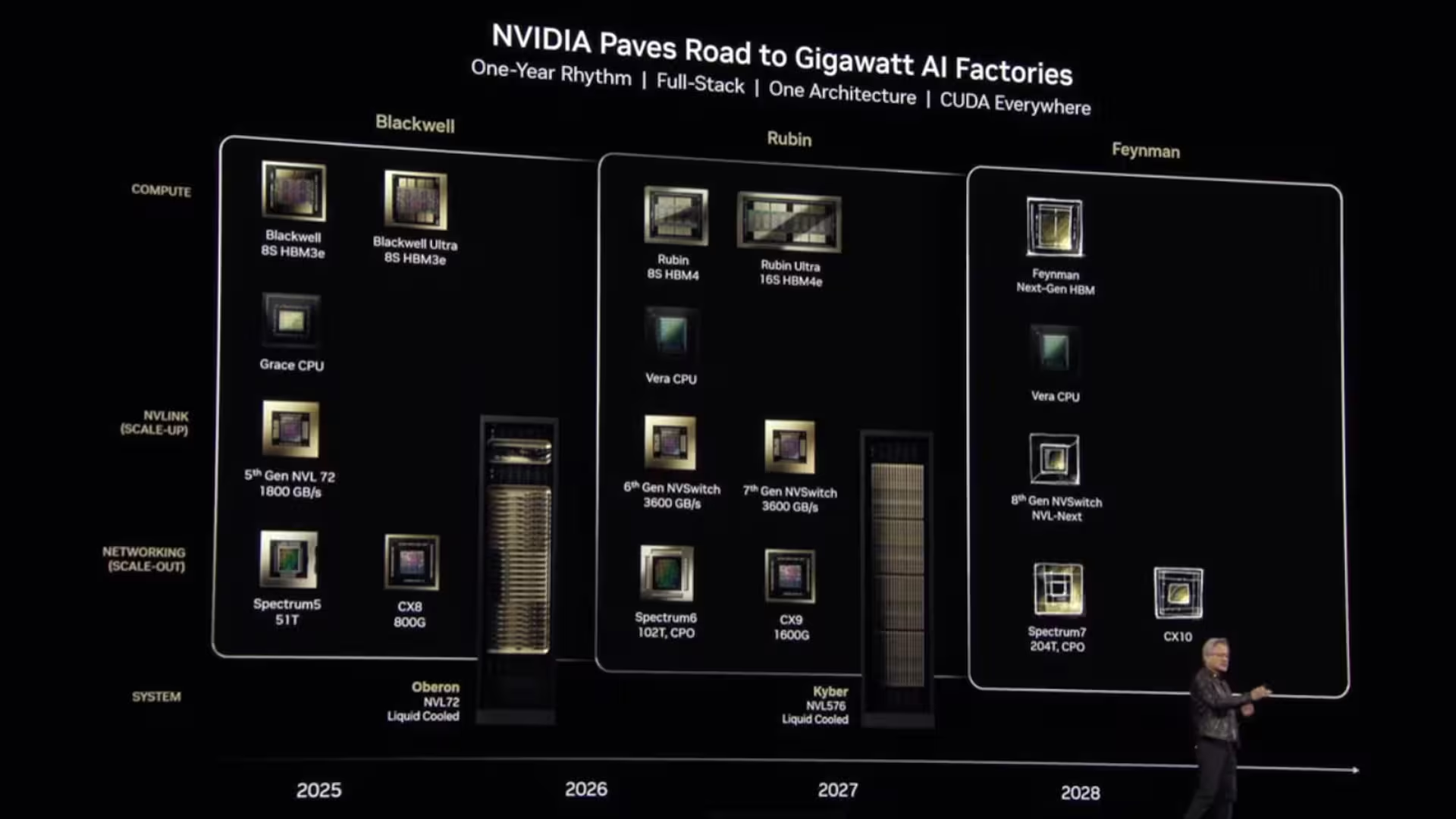

Wesentliche Ankündigungen werden voraussichtlich Vera Rubin betreffen — NVIDIAs nächste Architekturgeneration, bei der Analysten HBM4-Speicher, Verbesserungen durch TSMCs 3-nm-Fertigungsprozess und erhebliche Netzwerk-Upgrades erwarten. Technisch gesehen zielen diese Optimierungen darauf ab, gegenüber der Blackwell-Familie signifikante Leistungssteigerungen bei Durchsatz, Speicherkapazität und Energieeffizienz zu ermöglichen. Für Betreiber großer KI-Cluster sind besonders die erweiterte Speicherbandbreite (HBM4), dichter integrierte Chip-Layouts durch 3nm-Prozesse und schnellere Interconnects (z. B. NVLink/NVSwitch-Verbesserungen und Hochgeschwindigkeits-Ethernet bzw. InfiniBand) relevant, da sie Trainingszeiten verkürzen und Skalierungskosten pro trainiertem Modell senken können. Analysten sehen diese Kombination als Schlüssel, um die Serienfertigung von AI-Cluster-Hardware Mitte bis Ende 2026 zu unterstützen, was wiederum die Marktdurchdringung bei Hyperscalern und großen Unternehmen beschleunigen dürfte.

- Event dates: Die GTC beginnt am 15. März 2026; Jensens Huang Keynote ist für den 16. März geplant.

- Focus areas: KI-Infrastruktur, CUDA-Entwicklerworkshops, Robotik-Sessions, sowie Rechenzentrums- und Netzwerkarchitektur für beschleunigte Workloads.

- Major hardware: Vera Rubin-Updates (HBM4, TSMC 3nm), plus ein früher Ausblick auf künftige Feynman-GPUs und ergänzende Systemangebote wie DGX- oder DGX-ähnliche Appliances.

Bei der GTC 2025 hatte NVIDIA bereits Blackwell Ultra und das DGX Spark vorgestellt — beides Technologien, die prototypisch hohe Rechenleistungen für Training und Inferenz demonstrierten. Die GTC 2026 dürfte die Diskussionen deutlich in Richtung Produktion und Skalierung verschieben: weniger Whitepaper- oder Referenzdesign-Ankündigungen, mehr Validierungskriterien, Lieferketten-Planungen und Integrationspfade für Hyperscaler, Cloud-Anbieter und große Enterprise-Kunden. Viele Teilnehmer erwarten, dass Vera Rubin nicht nur als Chip- oder Architekturankündigung präsentiert wird, sondern als Grundlage für groß angelegte KI-Cluster, die in Rechenzentren der Hyperscaler, bei Cloud-Providern und in unternehmensinternen High-Performance-Computing-Umgebungen eingesetzt werden sollen.

Während die GTC den Schwerpunkt klar auf Server, Netzwerk und Entwickler-Tooling legt, scheint NVIDIA konsumentenorientierte GPU-Nachrichten bis zur CES 2026 zurückzustellen. Für Besucher bedeutet das: technische Deep-Dives, Roadmaps zur Infrastruktur, Benchmarks und Migrationsempfehlungen anstelle von GeForce-Produktvorstellungen für den Endverbraucher. Für Systemarchitekten und IT-Leiter sind die Sessions zu Validierung, thermischen Anforderungen, Energieversorgung und Kühlung (einschließlich Flüssigkeitskühlung bei dicht gepackten Servern) besonders wichtig, weil sie praktische Hinweise für Rechenzentrumsmodernisierungen liefern.

Zusätzlich neigt Jensen Huang dazu, langfristige Produktfahrpläne anzudeuten. Bei GTC 2026 ist daher ein Vorgeschmack auf die nächste Feynman-Generation der GPUs wahrscheinlich — genug, um Erwartungen zu setzen, ohne dass eine komplette Consumer-Rollout-Strategie vorgestellt wird. Für Ingenieure, Cloud-Architekten und KI-Verantwortliche ist die GTC 2026 das Ereignis, um Signale zu erhalten, wie NVIDIA die nächsten Ebenen des KI-Stacks sieht: Hardware-Architektur, Interconnect-Technologie, Software-Ökosystem und Partnerlösungen. Entscheidungen zu Beschaffung, Proof-of-Concepts und Migrationsprojekten für 2026/2027 werden stark von den dort kommunizierten technischen Details und Metriken abhängen.

Technisch betrachtet ist es nützlich, einige Kernkomponenten und ihre Bedeutung zu erläutern. HBM4 (High Bandwidth Memory 4) verspricht eine deutlich höhere Bandbreite pro Speicherkanal und oft auch eine verbesserte Energieeffizienz verglichen mit HBM3. In Kombination mit TSMCs 3-nm-Prozess kann dies die Flächen- und Energieeffizienz pro Recheneinheit verbessern, sodass mehr SMs (Streaming Multiprocessors) oder Tensor Cores auf einem vergleichbaren Die untergebracht werden können. Netzwerkseitig werden verbesserte Telemetrie, schnellere RDMA-fähige Verbindungen und höhere Throughputs für verteiltes Training erwartet — alles Faktoren, die die effektive Skalierung großer Modelle beeinflussen. Rechenzentrumsbetreiber werden besonders auf Metriken wie Interconnect-Latenz, Aggregate-Bandbreite pro Server und Energieverbrauch pro Trainingsstunde achten.

Für Softwareentwickler sind die angekündigten CUDA-Workshops zentral: CUDA bleibt die primäre Programmierschnittstelle für viele Optimierungen auf NVIDIA-Hardware. Erwartet werden hands-on Sessions zu CUDA-Bibliotheken (cuBLAS, cuDNN, cuFFT), Performance-Tuning, Mixed-Precision-Training, sowie Integrationen mit Frameworks wie PyTorch, TensorFlow und ONNX. Ebenfalls relevant sind Sessions zu Triton Inference Server für skalierbare Bereitstellung, Profiling-Tools (Nsight, cuProfiler), und Best Practices für containerisierte Bereitstellungen mit Kubernetes und GPU-Scheduling.

Im Bereich Robotik dürften Vorträge und Workshops Tools wie NVIDIA Isaac Sim, Isaac ROS und Plattformintegrationen zeigen, die Robotik-Workflows von der Simulation bis zur Produktion beschleunigen. Solche Sessions sprechen Entwickler an, die autonome Systeme, industrielle Automatisierung oder Forschung in eingebetteten KI-Systemen vorantreiben. Robotik-Toolchains profitieren oft von gleichermaßen optimierter Hardware und Software, da latenzarme Inferenz und deterministische Steuerungsloops in realen Anwendungen entscheidend sind.

Ökonomisch betrachtet sind die Auswirkungen einer erfolgreichen Vera Rubin-Einführung weitreichend: niedrigere Kosten pro trainiertem Modell, kürzere Time-to-Market für KI-Produkte und ein verschobenes Gleichgewicht zwischen lokalem Rechenzentrumsbetrieb und Cloud-Outsourcing. Hyperscaler, die erste Produktionsläufe einführen, könnten einen Wettbewerbsvorteil in Form geringerer Trainingkosten und höherer Modellgröße erzielen. Gleichzeitig werden Drittanbieter-Lösungen wie managed services, spezialisierte KI-Appliances und Systemintegratoren wichtig, um heterogene Infrastruktur in bestehende IT-Landschaften zu integrieren.

Weitere Punkte, die Besucher beachten sollten: Roadmap-Transparenz (z. B. konkrete Verfügbarkeitsfenster und Produktionskapazitäten), Partnerschaften mit Foundries und Board-Partnern, sowie Support- und Software-Lifecycle-Strategien für neue Hardwaregenerationen. Fragen zu Kompatibilität (z. B. Abwärtskompatibilität von CUDA-Code), Treiber-Updates und long-term support (LTS) für kritische Produktionsumgebungen sind für viele Entscheider essenziell und werden vermutlich in den Tech-Briefings adressiert.

Schließlich ist GTC 2026 eine Gelegenheit für die Community, sich über Benchmarks, Validierungsergebnisse und reale Anwendungsfälle auszutauschen. Erwartet werden praxisnahe Case Studies von Unternehmen, die große Sprachmodelle, Recommendation Engines oder multimodale KI-Lösungen betreiben, sowie Diskussionen zu Energieeffizienz, Nachhaltigkeit und Kühlkonzepten in Rechenzentren. Für jene, die Investitions- und Migrationsentscheidungen treffen, sind diese Erfahrungsberichte oft hilfreicher als reine Architektur-Papiere.

Quelle: wccftech

Kommentar hinterlassen