8 Minuten

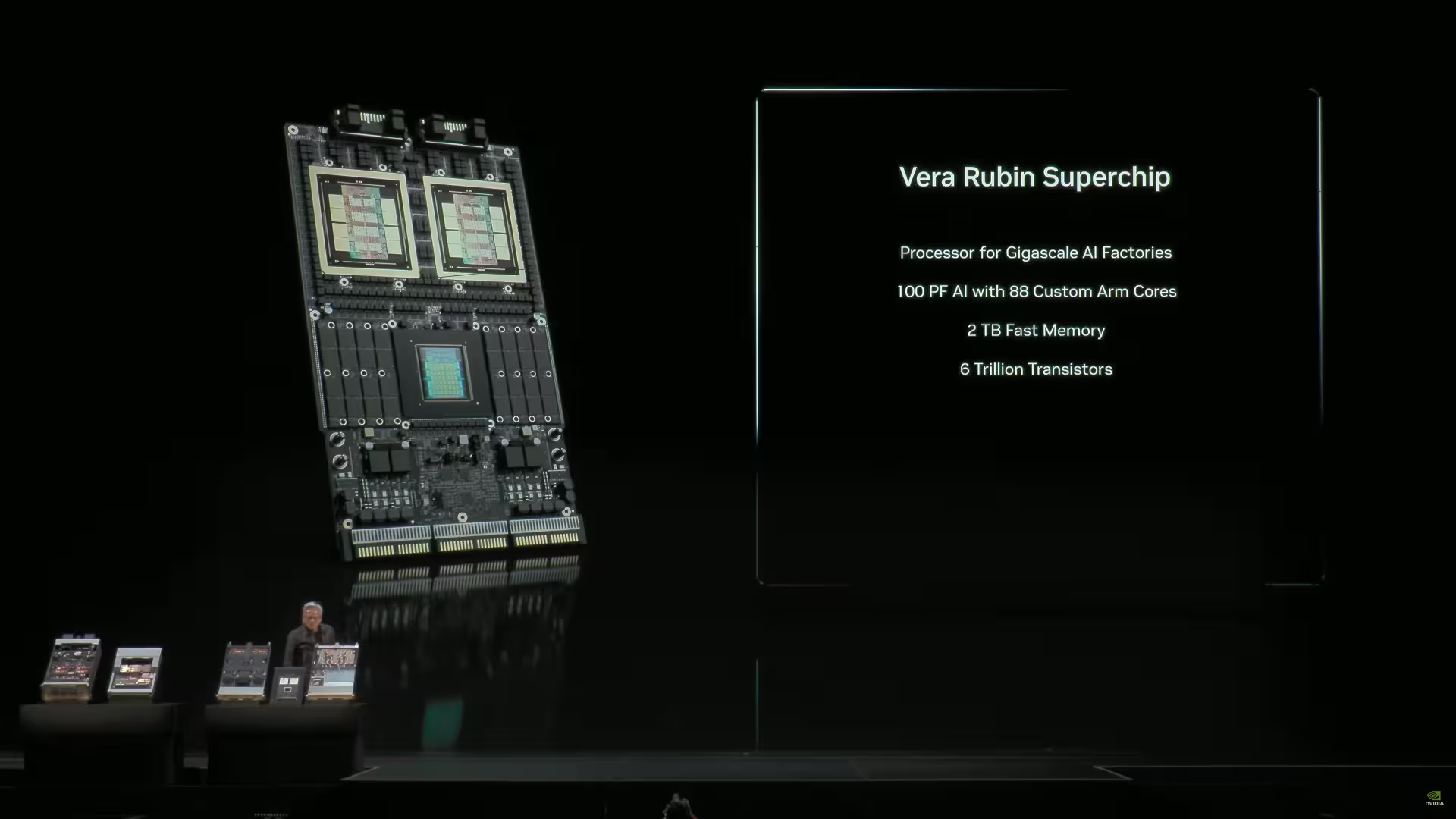

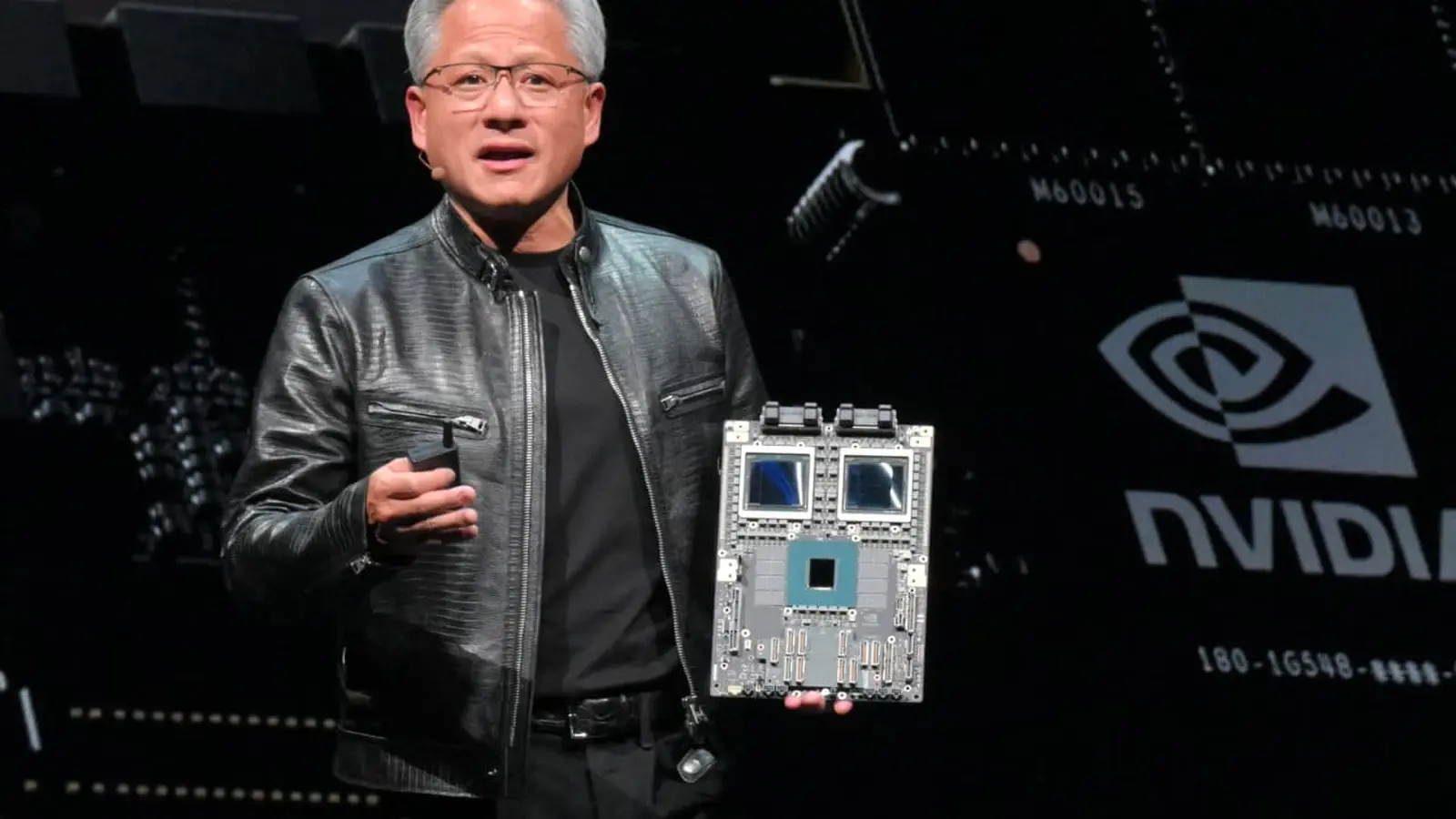

Auf der GTC 2025 gab NVIDIA erstmals einen öffentlichen Einblick in den Vera Rubin Superchip — zwei gewaltige GPUs, vertikal gestapelt, ergänzt durch eine Vera-CPU und umfangreiche LPDDR-Speicherflächen an den Rändern. Seither berichten Quellen, dass Rubin den Sprung von Laborvorführungen auf Produktionslinien vollzogen hat, und NVIDIA angeblich HBM4-Samples von allen großen DRAM-Herstellern gesichert hat. Diese Entwicklung ist nicht nur eine technische Demonstration, sondern ein möglicher Wendepunkt für die Skalierung von KI-Beschleunigern in Hyperscale-Rechenzentren: Der Rubin-Superchip kombiniert Chip-Stacking, fortgeschrittene Verpackungstechniken und schnellen Speicherzugriff, um die steigenden Anforderungen großer KI-Modelle besser zu bedienen. In diesem Artikel analysieren wir die gemeldeten Produktionsschritte, die Veränderungen in der Lieferkette, den erwarteten Zeitplan bis zur Serienfertigung und die Bedeutung dieser Schritte für die KI-Infrastruktur, Cloud-Anbieter und Chip-Ökosysteme.

Vom Demo-Board zur Fertigungsstraße: Was hat sich geändert

Berichten zufolge bestätigte NVIDIA-CEO Jensen Huang bei einem Besuch bei TSMC, dass Rubin-GPUs bereits auf der Produktionsebene gesichtet wurden. Zuvor hatte NVIDIA die Ankunft von Laborproben gemeldet — ein ungewöhnlich schneller Übergang von Prototypen zu sichtbarer Produktion. Wenn sich diese Informationen bestätigen, beschleunigt das den Fahrplan für Rubin als nächsten großen AI-Accelerator, der speziell auf Hyperscale-Rechenzentren und groß angelegte Trainings- und Inferenz-Workloads ausgerichtet ist. Solche Sichtungen auf der Fertigungsstraße deuten in der Regel darauf hin, dass Package- und Thermal-Designs validiert werden, die Yield-Raten beobachtet werden und erste Prozessvarianten getestet werden, um stabile Volumenerträge zu erreichen. Außerdem sind solche Übergänge oft begleitet von erweiterten Test- und Qualifikationsläufen bei ODMs und OEMs sowie von Integrationsläufen mit Infrastrukturanbietern, die die neuen Karten in Validierungsumgebungen prüfen.

Technisch gesehen stellt Rubin eine komplexe Kombination aus mehreren Design-Disziplinen dar: Heterogene Integration von zwei großen GPUs, ein integrierter Vera-CPU-Kern für Systemaufgaben und umfangreiche LPDDR am Rand für bestimmte I/O- und Steuerungsfunktionen. Die Herausforderung liegt nicht nur in der Fertigung der individuellen Chips auf einem fortschrittlichen 3-nm-Prozess, sondern vor allem in der Zuverlässigkeit des Stacking, der Wärmeableitung und der hochbandbreiten Speicheranbindung. Die Beobachtung von Rubin-Artefakten auf einer Produktionslinie würde bedeuten, dass TSMC, Packaging-Partner und NVIDIA einen Reifegrad erreicht haben, der über einzelne Engineering-Samples hinausgeht und in Richtung validierter Fertigungsabläufe geht. Dieser Schritt ist für die Marktreife entscheidend — insbesondere wenn große Cloud-Anbieter und KI-Labore bereits mit Evaluationseinheiten planen.

Lieferketten bewegt: TSMC zieht an, HBM4 trifft ein

Die Nachfrage nach NVIDIAs Blackwell-Familie bleibt intensiv, und TSMC arbeitet offenbar daran, Schritt zu halten. Laut Berichten hat die Foundry ihre 3-nm-Kapazität um ungefähr 50 % erhöht, um NVIDIAs Aufträge zu unterstützen. TSMC-Präsident C. C. Wei bestätigte, dass NVIDIA signifikant mehr Wafer anfragt, nannte aber genaue Zahlen "geheim". Solche Kapazitätserweiterungen sind ein klares Signal für die Priorisierung großer Kunden und für die Notwendigkeit, Lieferengpässe bei hochmodernen Nodes zu vermeiden. Für NVIDIA bedeutet das nicht nur mehr Produktionskapazität, sondern auch eine stärkere Abhängigkeit von TSMC als strategischem Fertigungspartner.

Auf der Speicherseite hat NVIDIA Berichten zufolge HBM4-Samples von sämtlichen großen DRAM-Herstellern erhalten. HBM4 verspricht die hohe Bandbreite und niedrige Latenz, die Rubin für das Training und die Inferenz großer KI-Modelle benötigt: Mehrere Terabytes pro Sekunde an Speicherbandbreite pro Package werden kombiniert mit enger Integration, um Datenbewegungen innerhalb von Trainingspipelines zu minimieren. Die Beschaffung von HBM4 von mehreren Lieferanten — zu denen typischerweise Unternehmen wie SK Hynix, Samsung und Micron zählen — ist eine strategische Absicherung gegen Lieferengpässe und hilft dabei, die Risiken bei Stückzahlen und Preisvolatilität zu reduzieren. Darüber hinaus erlaubt Mehrquellenbeschaffung NVIDIA, Preise zu verhandeln, Kapazitäten über mehrere Fertiger zu verteilen und Ausfallrisiken zu minimieren.

Die Bedeutung von HBM4 für Rubin lässt sich nicht überbetonen: Während LPDDR an den Rändern des Packages für Steuerungs- und Managementaufgaben wichtig ist, ist HBM4 die Schlüsselressource für die massiv parallelen Rechenkerne der GPUs. HBM4 bringt nicht nur höhere Bandbreiten pro Stack, sondern verbessert auch die Energieeffizienz pro Transfer, was bei großen Modellen und langen Trainingsläufen einen direkten Einfluss auf Betriebskosten (TCO) und Leistungsdichte hat. Hersteller von KI-Beschleunigern betrachten deshalb die Verfügbarkeit von HBM4 als einen kritischen Pfadfaktor für die rechtzeitige Lieferung von vollständigen Systemen an Rechenzentren und Cloud-Provider.

Timing, Serienfertigung und was zu erwarten ist

NVIDIA hat angegeben, dass Rubin etwa im dritten Quartal 2026 in die Serienfertigung gehen könnte — möglicherweise sogar früher. Es ist jedoch wichtig zu unterscheiden zwischen frühen Risiko-Produktionsläufen (Pilot- oder Validierungsserien) und der eigentlichen Massenfertigung: Erstere dienen der Validierung von Silizium, Testprogrammen und Packaging- oder Kühlungsstrategien; letztere markieren den Beginn volumetrischer Auslieferungen an Cloud-Anbieter, Systemintegratoren und OEMs. In der Praxis folgt auf Sichtungen in der Fertigung oft eine Phase intensiver Qualitätskontrolle, Yield-Optimierung und Software-Anpassung, damit die Hardware zuverlässig in produktiven Umgebungen eingesetzt werden kann.

Für Hyperscaler und Betreiber von Rechenzentren sind diese Unterschiede kritisch. Risiko-Produktionen erlauben frühe Evaluierungen, Benchmarking und Integration in bestehende Pipeline-Software, doch erst die Massenfertigung ermöglicht planbare, großvolumige Auslieferungen und langfristige Infrastrukturentscheidungen. NVIDIA und seine Partner müssen dabei viele Faktoren synchronisieren: Fertigungsdurchsatz und Yield, HBM4-Lieferketten, Paket- und Board-Level-Designs, Kühlkonzepte für hohe Leistungsdichten sowie die Software- und Systemintegration für diverse KI-Workloads. Nur wenn all diese Elemente zusammenpassen, können Anbieter robuste Dienstleistungsangebote und Betreiber langfristige Kaufpläne entwickeln.

Rubin ist bereits an großen kommerziellen Wetten beteiligt. NVIDIAs Roadmap und eine berichtete Partnerschaft im Milliardenbereich mit OpenAI unterstreichen, wie die neuen Beschleuniger die nächste Welle großangelegter KI-Deployments antreiben könnten. Solche Partnerschaften sind mehr als reine Kaufverträge: Sie umfassen oft gemeinsame Architektur-Optimierungen, frühe Softwareintegration, maßgeschneiderte Board- oder Systemdesigns sowie langfristige Liefer- und Supportvereinbarungen. Sollte Rubin also planmäßig in Serie gehen, könnte das die Infrastrukturstrategie großer KI-Anbieter und Cloud-Provider nachhaltig verändern.

Warum das für KI-Infrastruktur wichtig ist

Stellen Sie sich Rechenzentren vor, die mit Rubin-Klasse-Acceleratoren und HBM4-Speicher hochskaliert werden: höhere Durchsatzraten, kürzere Trainingszeiten und dichtere Inferenz-Cluster. Für Cloud-Anbieter, Chiphersteller und Forschungslabore reduziert der Schritt von Rubin in die Produktion — kombiniert mit TSMCs Kapazitätserhöhung und HBM4-Versorgung durch mehrere Lieferanten — das Risiko von Engpässen, während Modellgrößen und Trainingsanforderungen weiter explodieren. Höhere Bandbreite und bessere Energieeffizienz pro Rechenoperation können zudem die Gesamtkosten für KI-Training (TCO) senken und somit wirtschaftlichere Produktionsläufe für große Modelle ermöglichen.

Die Marktwirkung hängt davon ab, wie schnell Rubin tatsächlich in die Volumenproduktion gelangt und wie breit die Akzeptanz ist. Ein beschleunigter Markteintritt kann den Wettbewerb zwischen GPUs, CPUs und spezialisierten Acceleratoren verschärfen: Cloud-Anbieter könnten bevorzugt auf Rubin-gestützte Systeme setzen, wenn sie effizientere Trainingszeiten und bessere Leistungsdichten versprechen. Gleichzeitig könnten Wettbewerber mit alternativen Architekturen (zum Beispiel spezialisierte ASICs oder neue Memory-Architekturen) Druck erzeugen, was die Produktinnovationen beschleunigt. Für NVIDIA bedeutet dies sowohl eine Chance als auch eine Herausforderung — die Chance, die Marktführerschaft bei Rechenleistung für KI weiter auszubauen, und die Herausforderung, Produktion, Lieferketten und Partnerschaften skalierbar zu halten.

Zusammengefasst ist die aktuelle Nachricht ein Indikator für starke Nachfrage, aggressives Foundry-Support und eine koordinierte Reaktion der Speicherlieferanten, um die nächste Generation von KI-Hardware zu beliefern. Ob Rubin den Markt mit einem beschleunigten Zeitplan erreicht oder konservativer eingeführt wird, bleibt abzuwarten. Klar ist jedoch: Die Kombination aus fortschrittlichem Packaging, HBM4-Integration und erhöhter Fertigungskapazität könnte die Grundlage für deutlich leistungsfähigere KI-Infrastrukturen legen und die Art und Weise verändern, wie große Modelle trainiert und bereitgestellt werden.

Quelle: wccftech

Kommentar hinterlassen