10 Minuten

Google rollt eine vereinfachte Möglichkeit aus, NotebookLM innerhalb von Gemini-Chats zu nutzen. Nutzerinnen und Nutzer können Notizbücher an Konversationen anhängen, damit Gemini auf reichhaltigere Kontextinformationen zugreifen kann, ohne die App verlassen zu müssen.

NotebookLM trifft Gemini — was sich gerade geändert hat

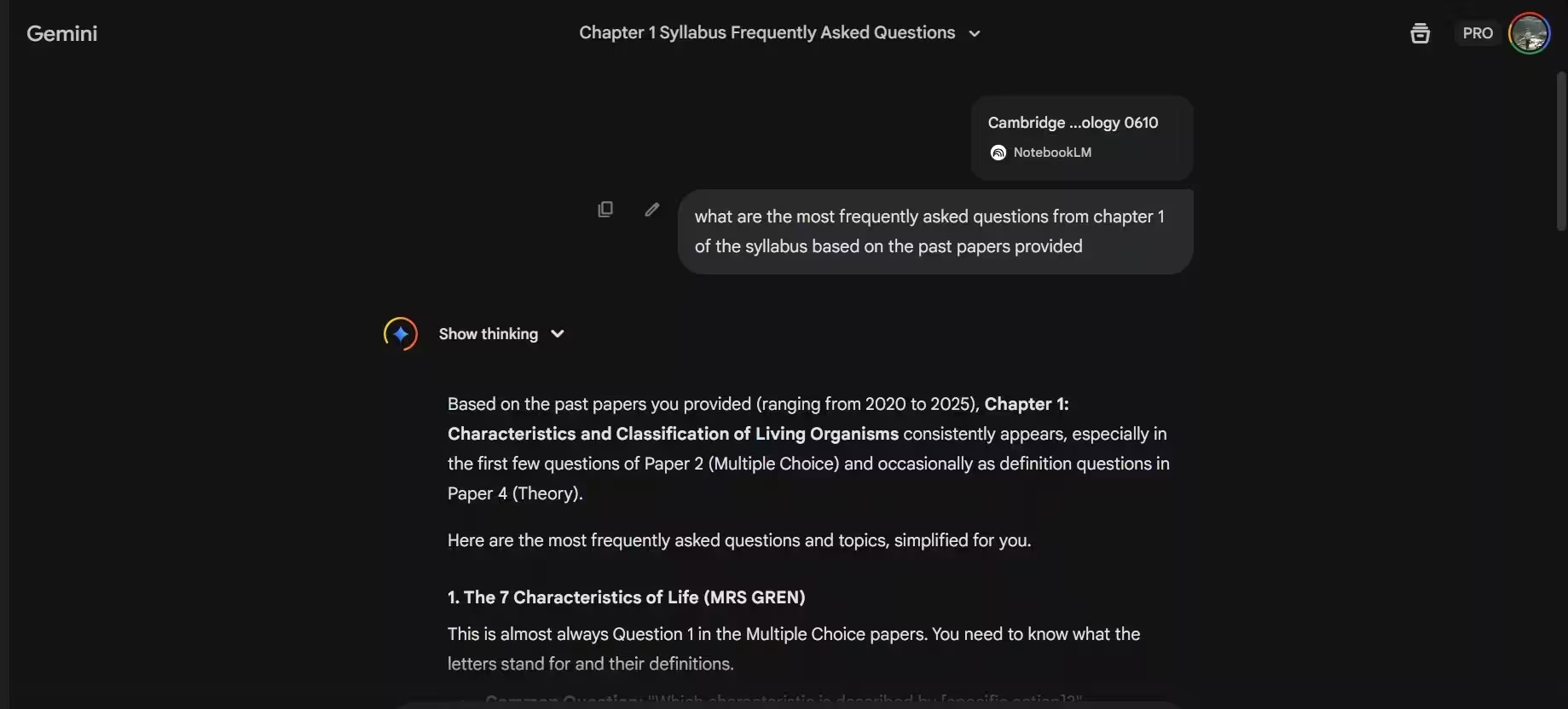

Laut Berichten des TestingCatalog-Forschers Alexey Shabanov erscheint in einigen Gemini-Konten eine neue Option, mit der Nutzer NotebookLM-Notizbücher direkt in Chatverläufe einbinden können. Diese Integration erlaubt es den Reasoning-Modellen von Gemini, auf die in NotebookLM gespeicherten Dokumente und Notizen zuzugreifen und dadurch präzisere, kontextbewusste Antworten zu liefern — ganz ohne App-Wechsel.

Die Änderung ist Teil von Googles fortlaufendem Bestreben, KI-Funktionen stärker zu vernetzen und Arbeitsabläufe zu straffen. Indem NotebookLM als Anhang verfügbar wird, kann Gemini strukturierte Notizen, Literaturverzeichnisse, Zusammenfassungen und markierte Quellen direkt einbeziehen und so relevantere Ergebnisse erzeugen. Diese Verknüpfung ist sowohl für Einzelpersonen als auch für Teams interessant, die häufig zwischen Notizen, Recherchematerial und interaktiven KI-Antworten wechseln.

Technisch gesehen handelt es sich um eine Nutzerschnittstelle, die bestehenden Notebook-Inhalt als zugreifbare Ressource im Chat anbietet. Die Integration beruht auf Zugriffsberechtigungen und einer UI, die das ausgewählte Notizbuch als Context-Layer für die KI-Modelle sichtbar macht. Google nutzt dafür offenbar interne APIs, die NotebookLM-Daten sicher an das Gemini-Frontend übermitteln, ohne Nutzerinteraktionen zu fragmentieren.

Wie es in der Praxis funktioniert

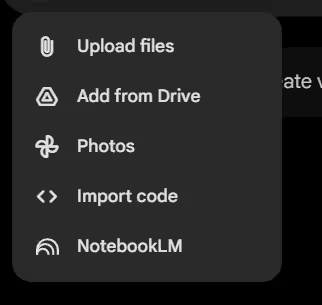

Sobald das Feature für Ihr Konto freigeschaltet ist, sehen Sie NotebookLM als eine der Optionen im Anhangsmenü des Chats. Sie wählen das Notizbuch aus, das Sie teilen möchten, und Gemini kann dieses Material bei Fragen oder Aufgaben direkt referenzieren. Zusätzlich gibt es eine Quellen-Schaltfläche (Sources), die eine NotebookLM-Oberfläche öffnet, sodass Sie schnell zu den Originalnotizen zurückspringen können.

In der Praxis bedeutet das: Sie müssen nicht mehr manuell Passagen kopieren, den Kontext zusammenfassen oder externe Links einzufügen, damit die KI den nötigen Hintergrund kennt. Stattdessen kann Gemini direkte Zitate, strukturierte Erkenntnisse oder konsolidierte Punkte aus dem Notebook nutzen, um Antworten zu formulieren oder Folgefragen vorzuschlagen. Das reduziert Reibungspunkte in Workflows für Forschung, redaktionelles Arbeiten oder datengetriebene Analysen.

Aus Nutzerperspektive läuft der Ablauf typischerweise so ab: Öffnen Sie den Gemini-Chat, klicken Sie auf die Anhangs- oder Plus-Schaltfläche, wählen Sie „NotebookLM“ aus der Liste, suchen oder wählen Sie ein Notizbuch aus und bestätigen Sie die Freigabe. Das System zeigt dann an, dass ein bestimmtes Notizbuch als Kontext aktiviert wurde. Bei Bedarf können Sie jederzeit die Quellenansicht öffnen, um Abschnitte zu prüfen oder zu bearbeiten.

Wichtig sind hierbei auch die Berechtigungen: NotebookLM-Notizbücher können persönliche oder geteilte Inhalte enthalten. Die Integration sollte deshalb mit granularen Freigabeoptionen arbeiten, sodass nur autorisierte Personen und Modelle Zugriff erhalten. In Organisationskontexten (z. B. Google Workspace) dürften Admin-Richtlinien und Data-Governance-Regeln regeln, welche Notizbücher zugänglich sind.

Technische Einschränkungen sind erwartbar: Nicht alle Inhalte eignen sich gleichermaßen als Kontext, etwa sehr große Datensätze, proprietäre Formate oder geschützte Anhänge. Google wird vermutlich Mechanismen implementieren, die zu große oder nicht unterstützte Dateien ausfiltern oder nur Metadaten übergeben, um Latenz und Speicherbedarf zu optimieren. Darüber hinaus spielt die Modellkontextlänge eine Rolle: Gemini muss relevante Ausschnitte aus einem Notizbuch priorisieren, damit die Antwortqualität erhalten bleibt.

Warum das wichtig ist

Stellen Sie sich vor, Sie arbeiten gemeinsam an einer Studie oder verfassen einen längeren Artikel. Anstatt Notizen manuell in den Chat zu kopieren oder sie erst zusammenzufassen, kann Gemini direkt auf den Inhalt des Notizbuchs zurückgreifen, um:

- Präzisere Antworten und Follow-up-Prompts zu liefern

- Inhalte zu erzeugen, die Kontext und Daten aus Ihren Notizen respektieren

- Workflows zu beschleunigen, indem alles innerhalb von Gemini bleibt

Für Knowledge Worker, Content-Ersteller und Analysten kann diese nahtlose Übergabe zwischen NotebookLM und Gemini Minuten — oder in komplexen Fällen sogar Stunden — an Routineaufwand einsparen. Die Zeitersparnis entfaltet sich besonders dann, wenn Notizbücher gut strukturiert sind: mit Tags, Inhaltsverzeichnissen, Zusammenfassungen und markierten Quellen.

Im Detail lässt sich das wie folgt aufgliedern: Wenn Gemini auf ein Notizbuch zugreift, kann das System erst eine Relevanzbewertung vornehmen, um die relevanten Kapitel oder Abschnitte zu isolieren. Anschließend erfolgt eine semantische Suche innerhalb dieser Abschnitte, sodass Antworten nicht nur oberflächlich, sondern fundiert und mit Bezug auf spezifische Passagen entstehen. Solche Antworten können auch Zitationshinweise enthalten — sofern NotebookLM Metadaten oder Quellenangaben gespeichert hat.

Ein weiterer praktischer Effekt ist die Konsistenz von Texten: Wer wiederkehrende Projekte oder Serienbeiträge erstellt, profitiert davon, dass Gemini beim Erzeugen von Gliederungen, Einleitungen oder Zusammenfassungen dieselben Informationen verwendet, die bereits in NotebookLM dokumentiert sind. Das reduziert Inkonsistenzen und spart Zeit bei der redaktionellen Abstimmung.

Darüber hinaus verbessert die Integration die Nachvollziehbarkeit: Wenn eine KI-Antwort auf bestimmten Notizen basiert, können Nutzer durch die Quellen-Schaltfläche schnell zur Originalstelle im Notebook gelangen, statt auf Basis unklarer, generischer Antworten weiterzurecherchieren. Diese Transparenz ist besonders wichtig für wissenschaftliche, juristische oder datengetriebene Anwendungsfälle.

Limitierte Einführung und was zu erwarten ist

Shabanovs APK-Analyse deutet darauf hin, dass Google mit einer beschränkten Einführung begonnen hat, doch der Zugang bleibt inkonsistent: In seinen Tests war das Feature nur in einem von fünf Konten verfügbar. Andere Tester berichteten ebenfalls, dass die Notebook-Anhangs-Schaltfläche (+) für viele Pro-Konten noch nicht sichtbar ist.

Limitierte Rollouts sind bei großen Plattformen üblich: Sie erlauben es Unternehmen, das Nutzerverhalten zu beobachten, Performancedaten zu sammeln und Probleme in kleinen Kohorten zu beheben, bevor ein globaler Start erfolgt. Google nutzt dabei oft gestaffelte Phasen — Beta-Tests, interne Pilotprojekte und regionale Ausweitungen — um Stabilität und Sicherheit zu gewährleisten.

Für Unternehmenskunden sind zusätzliche Aspekte relevant: Admins in Google Workspace werden wahrscheinlich Optionen erhalten, die Funktion zentral zu aktivieren oder zu blockieren, Compliance-Richtlinien zu hinterlegen und Audit-Logs zu überprüfen. Diese Kontrollen sind essenziell, um Datenschutz- und Governance-Anforderungen zu erfüllen, insbesondere wenn Notizbücher sensible Informationen enthalten.

Auch technisch gibt es Hürden, die einen langsamen Rollout erklären: Authentifizierungs- und Autorisierungs-Workflows müssen robust sein, Synchronisation zwischen NotebookLM und Gemini darf keine Inkonsistenzen erzeugen, und die Infrastruktur muss Lastspitzen abfangen können, wenn viele Nutzer gleichzeitig große Notizbücher referenzieren. Solche Herausforderungen sprechen dafür, dass Google die Verfügbarkeit schrittweise erhöht.

Was Sie als Nutzer jetzt tun können: Prüfen Sie regelmäßig die Einstellungen in Ihrer Gemini-App und in NotebookLM, verfolgen Sie offizielle Release-Notes von Google und achten Sie auf Ankündigungen in Workspace-Adminzentralen. Wenn Sie in einer Organisation arbeiten, sprechen Sie mit Ihrem IT- oder Security-Team über mögliche Pilotprojekte, um frühzeitig Erfahrungen mit der Integration zu sammeln.

Anwendungsfälle und schnelle Tipps

Hier sind praktische Wege, wie diese Integration heute genutzt werden kann:

- Forschung unterwegs: Hängen Sie ein Notizbuch mit Literaturhinweisen an und bitten Sie Gemini, zentrale Erkenntnisse zusammenzufassen.

- Erstellung und Überarbeitung von Texten: Lassen Sie Gemini auf Ihre Entwurfsnotizen zugreifen, um konsistente Gliederungen oder alternative Formulierungen zu erzeugen.

- Datenorientiertes Q&A: Versorgen Sie Notizbücher mit Datenfragmenten, sodass Gemini Antworten mit korrektem Kontext und Zitationen liefert.

Zusätzlich zu diesen Basisfällen lassen sich fortgeschrittene Workflows aufbauen:

- Projekt-Dashboards: Nutzen Sie Notizbücher als dynamische Wissensbasis, auf die Gemini Zugriff hat, um Status-Updates oder To‑Do-Listen automatisch zu generieren.

- Interne Wissensdatenbanken: Bündeln Sie SOPs, Handbücher und Meeting-Notizen in NotebookLM und nutzen Sie Gemini als interaktiven Assistenten, der Fragen direkt aus der internen Dokumentation beantwortet.

- Lehr- und Lernunterstützung: Lehrende können Kursmaterialien in Notizbüchern strukturieren; Studierende verwenden Gemini, um präzise Zusammenfassungen oder Übungsfragen zu erhalten.

Schnelle Tipps zur Nutzung:

- Strukturieren Sie Notizbücher mit klaren Titeln und Tags, damit Gemini relevante Abschnitte leichter findet.

- Fügen Sie prägnante Zusammenfassungen an Kapitelanfang, um die Qualität der generierten Antworten zu erhöhen.

- Prüfen Sie die Quellenansicht, bevor Sie Ergebnisse in offiziellen Dokumenten verwenden, um Verifizierbarkeit sicherzustellen.

Da der Rollout noch begrenzt ist, schauen Sie in Ihrer Gemini-App nach dem Anhangsmenü. Wenn NotebookLM noch nicht angezeigt wird, ist das kein Grund zur Sorge — Google erweitert die Verfügbarkeit in der Regel schrittweise.

Was das über Googles KI-Strategie aussagt

Die direkte Integration von NotebookLM in Gemini-Chats ist ein deutliches Signal für Googles Strategie, KI-Tools innerhalb des Ökosystems enger zu verknüpfen. Anstatt isolierte Funktionalitäten anzubieten, setzt Google auf ein zusammenhängendes Nutzererlebnis, in dem strukturierte Notizen und reasoningfähige Sprachmodelle Hand in Hand arbeiten.

Diese Strategie hat mehrere Dimensionen: Produktivität (Workflows vereinfachen), Vertrauen (Nachvollziehbarkeit durch Quellen), sowie Plattformbindung (Nutzer innerhalb des Google-Ökosystems halten). NotebookLM liefert strukturierte, oft kuratierte Informationen; Gemini nutzt diese als Kontextquelle, um Antworten präziser und nützlicher zu machen. Die Kombination erhöht den praktischen Wert der KI im Alltag deutlich.

Verglichen mit Wettbewerbern zielt Google darauf ab, unterschiedliche Bausteine (Suche, Workspace, NotebookLM, Gemini) zu einem integrierten Experience-Stack zu verbinden. Solche Integrationen können die Adoptionshürden für KI senken, weil Anwender weniger technische Konfigurationen vornehmen müssen und stattdessen bekannte Werkzeuge im Verbund nutzen können. Gleichzeitig schafft Google damit neue Möglichkeiten für Geschäftsmodelle und Enterprise-Angebote, etwa durch Premium-Features, erweiterte Sicherheitsfunktionen oder kontextsensitive APIs.

Aus technischer Sicht ist die Verbindung von strukturierter Wissensbasis und generativem Modell ein wichtiger Schritt zur Verbesserung der Output-Qualität. Wenn Modelle nicht nur auf das eingegebene Prompt, sondern auf reichhaltigen, persistenten Kontext zugreifen können, steigt die Relevanz der Antworten. Das unterstützt nicht nur Routineaufgaben, sondern auch komplexere Szenarien wie Forschungszusammenfassungen, juristische Vorabprüfungen oder datengetriebene Analysen.

Datenschutz und Compliance bleiben zentrale Herausforderungen. Google muss sicherstellen, dass NotebookLM-Inhalte bei Bedarf verschlüsselt, Zugriffe geloggt und sensible Informationen geschützt sind. Für Unternehmen ist entscheidend, dass Richtlinien zur Datenklassifizierung und Zugriffskontrolle vorhanden sind, bevor sie Notizbuch-Integration breit einsetzen.

Schließlich ist diese Entwicklung auch ein Hinweis auf mögliche zukünftige Features: tiefere Integration mit Google Search, bessere Zitiermechanismen, API-Zugänge für Entwickler und fortschrittlichere Kontextverwaltung (z. B. kontextsensitive Lesezeichen, automatische Relevanz-Extraktion). Wenn Google diese Grundlagen konsequent ausbaut, könnten produktive, KI-unterstützte Workflows in Forschung, Lehre und Unternehmenseinsatz deutlich an Reichweite gewinnen.

Behalten Sie Ihre Gemini-App und die offiziellen Google-Kanäle im Blick, um die formelle Ankündigung und eine breitere Verfügbarkeit nicht zu verpassen. Vorläufig ist dies ein vielversprechender Schritt hin zu stärker integrierter, kontextbewusster KI-Zusammenarbeit.

Quelle: smarti

Kommentar hinterlassen