8 Minuten

Google hat stillschweigend die kostenlosen Zugriffsgrenzen für zwei seiner jüngsten KI-Angebote verschärft, während die Nachfrage stark ansteigt. Kostenlose Nutzer von Gemini 3 Pro und dem Bildwerkzeug Nano Banana Pro sehen sich nun mit reduzierten täglichen Kontingenten konfrontiert — ein Schritt, den Google als vorübergehend bezeichnet, bis die Kapazitäten erweitert werden.

Was sich geändert hat — die neuen Limits erklärt

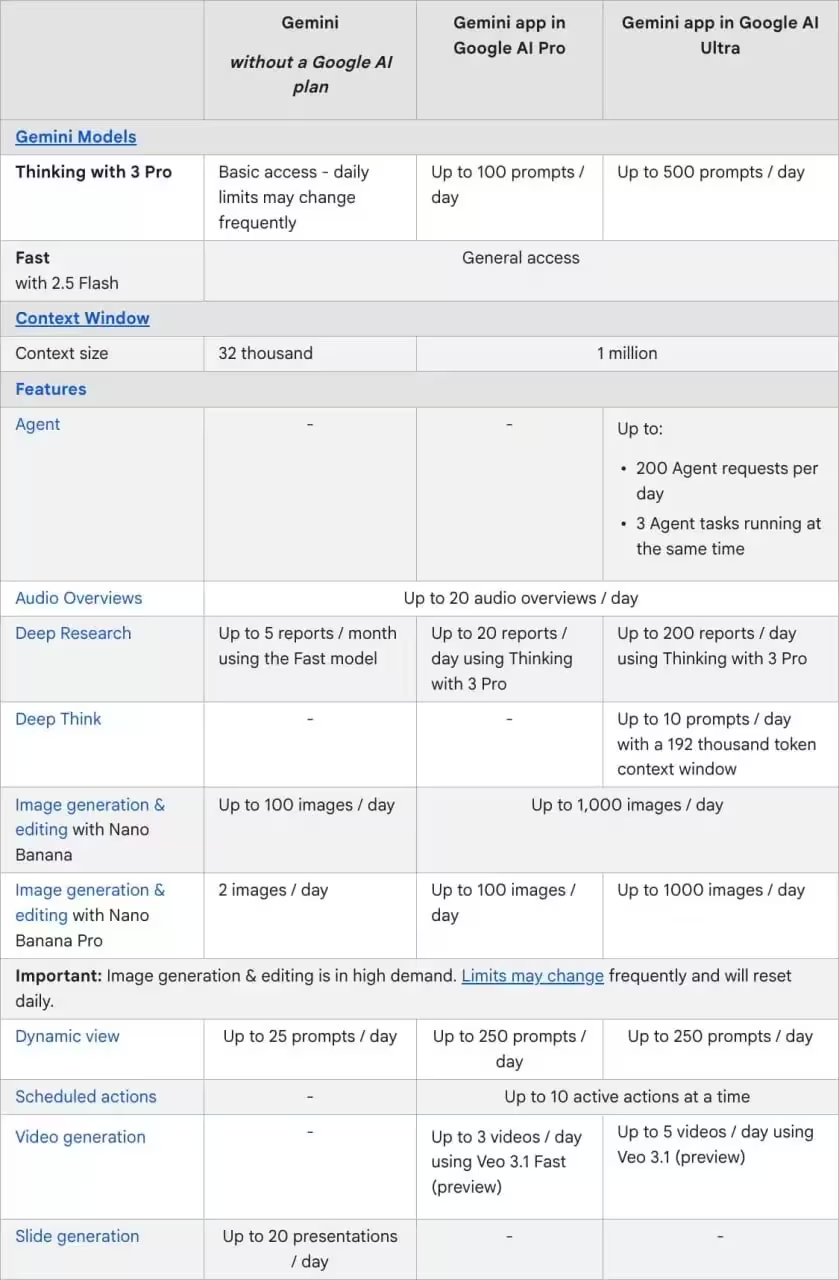

Zum Start konnten kostenfreie Nutzer Gemini 3 Pro mit bis zu fünf Eingaben (Prompts) pro Tag testen, und Nano Banana Pro erlaubte das Erstellen von drei Bildern täglich. Diese festen Zuweisungen wurden durch eine weniger vorhersehbare "Basic Access"-Stufe ersetzt, die variable Beschränkungen vorsieht.

- Gemini 3 Pro: Kostenlose Nutzer sind jetzt im Basic Access — Google weist darauf hin, dass sich die täglichen Limits häufiger ändern können anstatt des bisherigen festen Kontingents von fünf Prompts.

- Nano Banana Pro: Das Bilderstellungs-Kontingent für kostenlose Nutzer wurde auf zwei Bilder pro Tag reduziert; Google merkt an, dass die hohe Nachfrage weitere Anpassungen erforderlich machen kann.

Die Einführung einer dynamischen Basisstufe bedeutet, dass die Verfügbarkeit und die genauen Quoten nicht mehr dauerhaft garantiert sind. Dieses Modell dient dazu, Lastspitzen abzufedern und die Plattform stabiler zu halten, bietet aber weniger Planbarkeit für Anwender, die sich an fixe Tageslimits gewöhnt hatten.

Aus technischer Sicht ist das Vorgehen nachvollziehbar: Machine‑Learning-Modelle wie Gemini 3 Pro benötigen Rechenleistung und Speicherressourcen, insbesondere bei multimodalen Aufgaben (Text plus Bild). Wenn Nutzeraufkommen und Generierungsanfragen parallel stark ansteigen, kann das System nur durch temporäre Begrenzungen oder durch Priorisierung von zahlenden Kunden zuverlässig betrieben werden.

Für Nutzer ist wichtig zu verstehen, dass "Basic Access" nicht nur niedrigere Zahlen bedeutet, sondern auch eine höhere Schwankungsbreite: Ein Tag kann mehr Ressourcen erlauben, der nächste weniger. Wer Workflows automatisiert hat, sollte daher Kontingenzpläne einbauen — zum Beispiel Batch-Verarbeitung, Warteschlangen oder Fallback-Strategien zu alternativen Modellen.

NotebookLM-Funktionen ebenfalls betroffen

Die Änderungen betreffen nicht nur die eigenständigen Modelle. Google gibt an, dass neue NotebookLM‑Funktionen, die auf Nano Banana Pro basieren — etwa Infografiken und Slide‑Decks — für kostenlose Nutzer vorübergehend nicht verfügbar sind. Teilweise gelten zusätzliche Einschränkungen sogar für bestimmte Pro‑Funktionen innerhalb von NotebookLM.

NotebookLM kombiniert Recherche‑ und Präsentationsfunktionen mit generativen Bild‑ und Textmodulen, sodass Einschränkungen in einem Untermodul wie Nano Banana Pro direkte Auswirkungen auf die gesamte Notebook‑Funktionalität haben können. Praktisch bedeutet das: Features, die automatisiert aus Inhalten Grafiken oder Folien erstellen, sind anfälliger für Kapazitätsbeschränkungen, weil sie sowohl GPU‑Last als auch Datenvorverarbeitung erfordern.

Für Lehrende, Content‑Creator und Produktteams, die NotebookLM für schnelle Prototypen oder Präsentationen nutzen, führt das zu unmittelbaren Einschränkungen im Arbeitsablauf. Wenn eine Demo auf mehreren automatisch generierten Grafiken basiert, kann das reduzierte Kontingent die Demo‑Vorbereitung verlängern oder erfordern, dass man Teile der Arbeit manuell erstellt.

Offizielle Stellungnahme von Google

In einer kurzen Stellungnahme erkannte Google Kapazitätsgrenzen an, die durch extrem hohe Nachfrage verursacht werden, und erklärte, man plane, den breiteren Zugang wiederherzustellen, während die Infrastruktur skaliert wird. Das Unternehmen stellte zudem klar, dass bezahlte Google AI Pro‑ und Ultra‑Abonnements für Gemini vorerst unverändert bleiben.

Google kommuniziert hier zwei Kernpunkte: Erstens, die Einschränkungen sind eine Reaktion auf aktuelle Belastungen und damit temporär gedacht; zweitens, zahlende Kunden sollen weiterhin priorisierten Zugang behalten. Diese Dualität ist in der Cloud‑Industrie üblich und spiegelt die Balance zwischen Nutzerwachstum, Service‑Qualität und Monetarisierung wider.

Aus Sicht der Betriebssicherheit ist die Vorgehensweise nachvollziehbar: Anbieter legen bevorzugten Zugriff für zahlende Kunden fest, um SLA‑Verpflichtungen einhalten zu können. Gleichzeitig versuchen sie, die Basisnutzung so weit wie möglich offen zu halten, ohne die gesamte Plattform zu destabilisieren. Für Nutzer ist entscheidend, offizielle Statusseiten, Support‑Kanäle und Ankündigungen aktiv zu verfolgen, um die Wiederherstellungszeiträume besser einschätzen zu können.

Warum das für Kreative und Entwickler wichtig ist

Stellen Sie sich Workflows vor, die auf vorhersehbaren täglichen Abfragen oder Bildausgaben beruhen — plötzliche Änderungen der Kontingente unterbrechen Tests, Redaktionspläne und Demos. Kleine Teams und Hobbyisten, die häufig auf kostenlose Stufen zum Prototyping angewiesen sind, sind am stärksten betroffen.

Für Entwickler bedeutet das: CI/CD‑Pipelines und automatisierte Tests, die generative APIs ansprechen, sollten flexibler gestaltet werden. Statt fixe, tägliche Durchläufe zu erwarten, empfiehlt sich ein adaptives Design mit Retry‑Logik, exponenziellen Backoffs und Queuing. Auch serverseitiges Caching von Antworten oder die Aggregation von Requests können helfen, das Verbrauchsvolumen zu reduzieren.

Kreative Teams, die Bildmaterial für Social‑Media‑Posts, Marketing‑Kampagnen oder Produktseiten automatisiert erzeugen, müssen mit möglichen Verzögerungen rechnen. Strategien wie die Nutzung lokaler Bildbibliotheken, die Vorplanung von Content oder das Batchen von Generierungsaufgaben an Tagen mit geringer Auslastung können die Auswirkungen minimieren.

Unternehmen mit klaren Produktionsanforderungen sollten bezahlte Pläne in Betracht ziehen, um stabile, höhere Kontingente zu sichern und vertraglich besser planbar zu bleiben. Für Startups und Forschungsteams können Förderungen, Credits oder spezielle Bildungsangebote von Cloud‑Anbietern temporär Abhilfe schaffen.

Schließlich signalisiert diese Entwicklung ein größeres, strukturelles Thema: Die KI‑Infrastruktur steht unter Druck, weil die Adaption rasant wächst. Modelle werden komplexer, die Nachfrage steigt sowohl bei privaten Anwendern als auch bei Unternehmen, und der Bedarf an Rechenressourcen — insbesondere an spezialisierten Beschleunigern wie GPUs und TPUs — nimmt zu. Das hat Folgen für Kosten, Verfügbarkeit und die technische Architektur von KI‑gestützten Produkten.

Praktische Schritte, die Nutzer ergreifen können

- Überwachen Sie Ihre Nutzung genau und priorisieren Sie kritische Prompts oder Bildgenerierungen.

- Ziehen Sie einen kurzfristigen kostenpflichtigen Plan in Betracht, wenn Sie stabile, höhere Kontingente für Produktion oder wichtige Demos benötigen.

- Prüfen Sie Googles offizielle Updates und Statusseiten für Kapazitätsänderungen und Wiederherstellungszeiträume.

- Entwickeln Sie Ausweich‑Workflows, die offline oder mit alternativen Anbietern funktionieren, falls Kontingente erneut verschärft werden.

Diese Empfehlungen sind praktisch und sofort umsetzbar. Ergänzend dazu lassen sich weitere technische Maßnahmen einsetzen, um Robustheit und Planbarkeit zu erhöhen:

- Monitoring & Alerting: Implementieren Sie Metriken für Verbrauchsvolumen, Fehlerraten und Latenz, die frühzeitig auf Limitüberschreitungen hinweisen. Durch automatisierte Alerts lässt sich rechtzeitig reagieren.

- Priorisierung & Throttling: Bauen Sie Prioritätsstufen in Ihrem Produkt ein, sodass geschäftskritische Anfragen Vorrang erhalten. Throttling und Rate‑Limiting verhindern plötzliche Lastspitzen.

- Batch-Verarbeitung und Scheduling: Sammeln Sie nicht‑echtzeitkritische Generierungsaufträge und verarbeiten Sie sie gebündelt zu weniger ausgelasteten Zeiten.

- Caching & Reuse: Speichern Sie erzeugte Inhalte, wo sinnvoll, um wiederholte Generierungskosten zu vermeiden. Kleine Anpassungen lassen sich häufig per Nachbearbeitung statt kompletter Neu‑Generierung lösen.

- Hybride Architektur: Kombinieren Sie cloudbasierte Dienste mit lokal gehosteten oder offenen Modellen (z. B. LLMs, die auf eigenen Servern laufen), um Abhängigkeit von einer einzigen Anbieterinfrastruktur zu verringern.

- Multi‑Provider‑Strategie: Halten Sie alternative APIs und Anbieter bereit, um bei temporären Einschränkungen umlenken zu können. Das erfordert zwar zusätzlichen Integrationsaufwand, erhöht aber die Ausfallsicherheit.

- Vertragsverhandlungen: Bei hohem Bedarf lohnt es sich, frühzeitig mit Cloud‑Anbietern über maßgeschneiderte Enterprise‑SLAs oder Kontingente zu verhandeln, um planbare Kapazitäten zu sichern.

Zusammengefasst unterstreicht Googles Schritt, wie schnell die Nachfrage nach generativer KI die verfügbare Infrastruktur übersteigen kann. Für den Moment sollten kostenlose Nutzer mit schwankendem Zugang zu Gemini 3 Pro und Nano Banana Pro rechnen, während kostenpflichtige Tarife die verlässlichere Wahl für konstante Leistung bleiben.

Langfristig dürfte die Entwicklung zwei Effekte verstärken: Erstens investieren Anbieter stärker in skalierbare Infrastruktur und Optimierungen (etwa effizientere Modelldesigns, bessere Quantisierung und Sparverfahren). Zweitens werden Nutzer und Unternehmen ihre Architektur anpassen, um resilienter gegenüber solchen Limitierungen zu werden — durch Hybridlösungen, intelligente Priorisierung und redundante Anbieterstrategien.

Wenn Sie regelmäßig auf generative KI‑Funktionen angewiesen sind, planen Sie jetzt technische und organisatorische Maßnahmen ein, um Unterbrechungen zu minimieren. Das erhöht nicht nur die Zuverlässigkeit Ihrer Produkt‑ und Arbeitsprozesse, sondern schafft auch Kostentransparenz in einer sich rasch entwickelnden KI‑Landschaft.

Quelle: smarti

Kommentar hinterlassen