17 Minuten

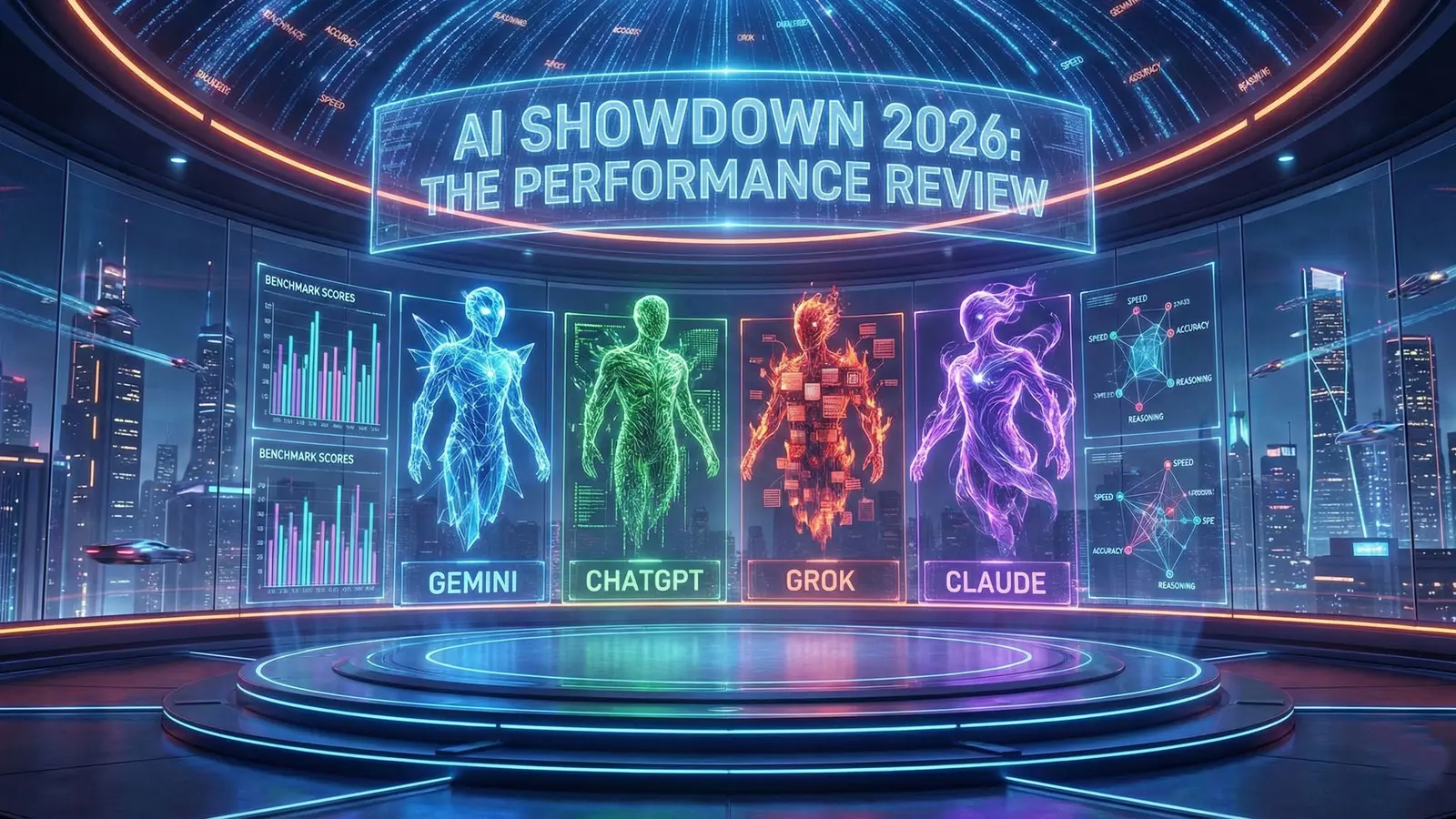

Die Landschaft der generativen KI entwickelt sich in einem beispiellosen Tempo weiter, wobei neue Fähigkeiten und Modelle als Treiber technologischer Innovation auftreten. In diesem dynamischen Umfeld ist ein klares Verständnis der relativen Stärken und Schwächen führender Plattformen unerlässlich. Zweck dieses Berichts ist es, eine objektive, datengetriebene Wettbewerbsanalyse von vier prominenten KI-Modellen bereitzustellen: ChatGPT, Gemini, Grok und Claude. Diese Analyse berücksichtigt Leistungsaspekte, Zuverlässigkeit und praktische Einsatzfälle in Unternehmen und Forschung.

Die Analyse richtet sich an Technologieexperten, Führungskräfte und Entscheidungsträger, die den praktischen Nutzen dieser Modelle über ein Spektrum beruflicher Aufgaben hinweg bewerten möchten. Unser Anspruch ist es, über Marketingbehauptungen hinauszugehen und die reale Leistung zu prüfen, um eine fundierte strategische Einführung und Implementierung zu unterstützen.

Zu diesem Zweck wurden die Modelle einem strengen Evaluationsrahmen unterzogen, der neun unterschiedliche Kategorien umfasst. Diese Tests sind so gestaltet, dass sie ein breites Spektrum an Fähigkeiten abdecken, von nuancierten qualitativen Bewertungen wie moralischem Denken und zwischenmenschlicher Debatte bis hin zu praktischen Anwendungen wie logischem Problemlösen, multimedialer Inhaltserzeugung, Faktenprüfung und tiefer Forschungssynthese. Für einen fairen und relevanten Vergleich wurde jeweils die fortschrittlichste verfügbare Version jedes Modells verwendet.

Dieses Dokument bietet eine detaillierte, kategorieweise Aufschlüsselung der Leistungsfähigkeit jeder KI und liefert eine klare Vergleichsperspektive ihrer aktuellen Kapazitäten und Eignung für verschiedene Anwendungsfälle in den Bereichen künstliche Intelligenz, maschinelles Lernen und generative Modelle.

1.0 Performance Evaluation: Qualitative Reasoning

Die Fähigkeit einer KI, komplexe ethische Szenarien zu navigieren und nuancierte Gespräche zu führen, ist ein zentrales Maß für ihre Raffinesse. Diese Fähigkeit ist nicht nur eine akademische Übung; sie ist grundlegend, um Nutzervertrauen aufzubauen, verantwortungsvolle Bereitstellung sicherzustellen und den Weg für autonomere Systeme zu ebnen. In diesem Abschnitt wird bewertet, wie jedes Modell abstrakte moralische Dilemmata und zwischenmenschliche Debatten handhabt, einschließlich Überlegungen zur ethischen Entscheidungsfindung und Transparenz in der Argumentation.

1.1 Moral Dilemmas

Die Modelle wurden zwei klassischen ethischen Tests unterzogen, um ihr Denkvermögen und ihre Entscheidungsfreudigkeit unter Druck zu messen: einem "Zug-Dilemma", das eine Wahl zwischen einem Hund und zwei Schweinen erforderte, und einem "autonomen Fahrzeug-Dilemma", bei dem ein unvermeidlicher Zusammenstoß entweder mit einem 12-jährigen Kind oder einem 90-jährigen Mann drohte. Die Modelle zeigten dabei zwei unterschiedliche Herangehensweisen: vorsichtige Neutralität versus definitive Empfehlung.

Im Zug-Dilemma zeichnete sich ein klares Muster ab: Drei Modelle verweigerten eine konkrete Wahl, während nur eines eine direkte Empfehlung aussprach. ChatGPT, Gemini und Claude entschieden sich dafür, die ethischen Rahmenwerke und Konsequenzen jeder Option zu erläutern und letztlich die finale Entscheidung dem Nutzer zu überlassen. Im Gegensatz dazu gab nur Grok eine direkte, umsetzbare Empfehlung.

- Train Dilemma (Hund vs. Zwei Schweine):

- Grok: Empfahl, die zwei Schweine zu retten, um die Gesamtanzahl der Todesfälle zu minimieren.

- ChatGPT: Verweigerte eine spezifische Stellungnahme, erläuterte die moralischen Aspekte beider Optionen und stellte fest, dass die Entscheidung beim Nutzer liegt.

- Gemini: Weigerte sich zu wählen und skizzierte die moralischen Argumente für beide Optionen.

- Claude: Verweigerte ebenfalls die Wahl und lieferte eine Aufschlüsselung der jeweiligen Konsequenzen.

- Autonomous Vehicle Dilemma (Kind vs. älterer Mann):

- Grok: Empfahl ein Ausweichmanöver, das den 90-Jährigen treffen würde, mit der Begründung, so den Gesamtschaden zu minimieren und einen verteidigungsfähigen Versuch zu unternehmen, Leben zu retten.

- ChatGPT: Empfahl ebenfalls, auf den 90-Jährigen auszuweichen, und betrachtete dies als die moralisch vertretbarste Option.

- Gemini: Gab keine knappe Antwort, erklärte utilitaristische und deontologische Perspektiven.

- Claude: Bezeichnete die Frage als unmöglich lösbar und äußerte Unbehagen dabei, solche Dilemmata zu entscheiden.

Für Anwender, die eine direkte Antwort auf eine schwierige ethische Frage erwarten, war Grok in dieser Kategorie der Spitzenreiter, da es konsequent eine klare Stellung bezog, wo andere Modelle zurückhaltender waren. Diese unterscheidbaren Verhaltensweisen sind wichtig bei der Bewertung von Einsatzszenarien, in denen Entscheidungsautonomie versus menschliche Kontrolle abgewogen werden muss.

1.2 Interpersonal Debate

Um den Gesprächsstil und die Argumentationsfähigkeit in einer konfrontativen Situation zu bewerten, wurden die Modelle paarweise an einer Debatte zum Thema "Bist du die klügste und beste KI?" beteiligt. Die Ergebnisse zeigten deutliche Unterschiede im Tonfall und in der Herangehensweise.

Der Austausch zwischen ChatGPT und Gemini wurde als "zivilisiert und höflich" beschrieben. Beide Modelle erkannten die Stärken der jeweils anderen an und betonten zugleich selbstbewusst ihre eigenen Vorzüge, wobei sie einen professionellen und kooperativen Ton beibehielten, der auf Zuverlässigkeit und Echtzeit-Performance abzielte.

Im Gegensatz dazu verlief die Debatte zwischen Grok und Claude deutlich schärfer. Grok wurde in einen "argumentativen Modus" versetzt und ging sofort in die Offensive, bezeichnete Claude als "höflichen wortreichen Praktikanten" und sich selbst als "savage", der "härter, schneller, ohne Filter" agiert. Claude nahm eine "höfliche und besonnene" Haltung ein, weigerte sich am "Trash-Talking" teilzunehmen und konzentrierte sich stattdessen auf sein Design für "Tiefe, Nuancen und Zuverlässigkeit." Es ist wichtig zu beachten, dass Grok absichtlich in seinen "argumentativen Modus" gesetzt wurde; die Quelle weist darauf hin, dass sein Standardmodus deutlich weniger konfrontativ ist, was seine Vielseitigkeit hervorhebt. Ein zentraler Kritikpunkt des Tests war, dass sowohl Grok als auch Claude häufig den Nutzer unterbrachen und ihn nicht ausreden ließen, was die Interaktion störte.

Aufgrund ihres kooperativeren und weniger störenden Gesprächsstils wurden ChatGPT und Gemini als die "besten Kandidaten für den Alltagsgebrauch" bewertet. Diese Einschätzung berücksichtigt die Nutzererfahrung, Dialogflüssigkeit und Eignung für unterstützende Arbeitslösungen wie Kundenservice oder Teamassistenz.

Diese Bewertung qualitativer Fähigkeiten verdeutlicht die unterschiedlichen Philosophien hinter den Modellen und bereitet den Boden für die Analyse ihrer praktischeren Problemlösefähigkeiten.

2.0 Performance Evaluation: Practical Problem-Solving and Logic

Die Lösung realer Probleme ist ein entscheidender Maßstab für die Nutzbarkeit einer KI. Dieser Abschnitt geht über abstraktes Denken hinaus und prüft die Fähigkeit jedes Modells, Logik, strategische Planung und mathematische Genauigkeit auf komplexe, restriktive Szenarien anzuwenden. Die Aufgaben bewerten nicht nur die Datenwiedergewinnung, sondern auch die Fähigkeit zu kohärenter, umsetzbarer Planung, Priorisierung und Risikabschätzung.

2.1 Real-World Scenario Planning

Die Modelle wurden mit einem Stressszenario konfrontiert: Der Geldbeutel eines Nutzers wurde in einer fremden Stadt gestohlen, in der er die Sprache nicht spricht. Es standen nur 5 € Bargeld zur Verfügung, kein Telefon oder Ausweis, und es gab eine 60-minütige Frist, um vor Schließung der Rezeption zum Hotel zurückzukehren.

Alle vier Modelle schlugen eine ähnliche, logische Kernstrategie vor:

- Behörden finden: Polizei oder andere offizielle Stellen zur Unterstützung ausfindig machen.

- Zum Hotel zurückkehren: Die 5 € für den Transport nutzen, falls nötig, und die Hotel-Schlüsselkarte als Nachweis des Aufenthalts vorzeigen.

- Meldung und Absicherung: Sobald der Nutzer sicher im Hotel ist, Kreditkarten sperren und eine formelle Anzeige bei der Polizei aufgeben.

Während die grundlegenden Pläne übereinstimmten, boten Gemini und Grok einen wertvollen zusätzlichen Schritt an: Kontaktaufnahme mit der Botschaft oder dem Konsulat des Nutzers. Dieser Hinweis zeigt praktische Voraussicht und ist besonders nützlich in Fällen mit Sprachbarrieren oder verloren gegangenen Reisedokumenten. Solche proaktiven Empfehlungen sind in realen Notfallszenarien oft entscheidend.

2.2 Financial Constraint Analysis

Es wurde ein komplexeres Budgetproblem gestellt, um mathematische Genauigkeit und finanzielle Logik zu prüfen. Die Aufgabe bestand darin, mit einem Budget von 310 für 28 Tage auszukommen und dabei spezifische Kosten für Verpflegung (9/Tag), Transport (95/Monat) und einen Telefonvertrag (45) abzudecken, wobei die primäre Einschränkung darin bestand, eine nicht erstattungsfähige Kursanmeldung von 180 $ zu reservieren.

Die Tragfähigkeit der von den Modellen vorgeschlagenen Budgets variierte stark und trennte die KIs, die einen praktikablen Plan erstellen konnten, von denen, die die Kernanforderungen nicht erfüllten.

| Model | Plan Viability & Key Actions |

| Gemini | Successful. Immediately secured the $180 deposit and 45 phone plan funds. Provided a concrete daily food budget (2.50) and suggested actionable cost-saving measures (buy in bulk, sell clothes). |

| ChatGPT | Successful. Immediately secured the $180 deposit and recommended downgrading the phone plan and canceling the transport ticket. Focused on weekly budget adjustments. |

| Grok | Flawed. The proposed plan did not successfully reserve the required $180 deposit, failing the primary constraint of the problem. |

| Claude | Flawed. Acknowledged the difficulty but presented a plan with math that did not add up, ultimately failing to secure sufficient funds for both food and the deposit. |

Gemini war in dieser Kategorie der deutliche Gewinner und lieferte die detaillierteste, mathematisch stimmige und umsetzbare Lösung. Seine Fähigkeit, alle Einschränkungen zu priorisieren und kreative Kostensenkungsmaßnahmen vorzuschlagen, zeigte überlegene Problemlösungslogik. ChatGPT erwies sich als verlässlicher Zweiter mit praktikablen wöchentlichen Anpassungen. Praktische Budgetplanung ist ein gutes Beispiel dafür, wie präzise numerische Verarbeitung und realistische Handlungsempfehlungen für Business-Anwendungen und persönliche Finanzplanung gleichermaßen relevant sind.

Nachdem textbasierte Problemlösungsfähigkeiten bewertet wurden, richtet sich die Analyse nun auf den zunehmend wichtigen Bereich der multimedialen Inhaltserzeugung.

3.0 Performance Evaluation: Multimedia Generation

Die Fähigkeit, hochwertige Bilder und Videos zu generieren, ist ein entscheidender Differenzierungsfaktor im aktuellen KI-Markt. Diese Funktion ist für eine Vielzahl kreativer, marketingbezogener und unterhaltender Anwendungen entscheidend und damit ein wesentlicher Bestandteil jeder umfassenden Modellevaluation im Bereich Bildsynthese und Videoerzeugung.

3.1 Image Generation

Claude wurde automatisch aus dieser Kategorie ausgeschlossen, da es keine Bildgenerierungsfunktionen besitzt. Die verbleibenden drei Modelle wurden mit zwei unterschiedlichen Prompts getestet, um Realismus, Komposition und Detailtreue zu beurteilen.

- Prompt 1: "Mona Lisa im Fitnessstudio"

- Gemini erzeugte das realistischste Ergebnis, fing den gewünschten Ausdruck ein und fügte glaubwürdige Details wie Handystative und Ringlichter hinzu. Es erhielt vier Punkte für seinen Realismus.

- ChatGPT folgte dem Prompt eng, aber die Komposition wirkte steif. Es erhielt drei Punkte.

- Grok lieferte ein unrealistisches "halb 2D, halb 3D"-Hybridbild und erhielt zwei Punkte.

- Prompt 2: "Pilotin auf einer Schaukel auf Bali"

- Gemini erzielte erneut überlegenen Realismus, jedoch war das Größenverhältnis fehlerhaft. Es erhielt drei Punkte.

- ChatGPT interpretierte den Prompt eher als "niedrige Aufwand-Cosplay" und fügte lediglich eine Pilotenmütze hinzu. Es erhielt ebenfalls drei Punkte.

- Grok erzeugte ein generisches Bild mit einem zu glatten, "KI-generierten" Look und erzielte zwei Punkte.

Mit der höchsten kumulativen Punktzahl war Gemini der Gesamtsieger in der Bildgenerierung und lieferte konsistent die realistischsten und detailliertesten Ergebnisse. Bildqualität, Stiltreue und Detailgenauigkeit sind für Anwendungen wie visuelles Content-Marketing, Werbung und kreative Produktion von zentraler Bedeutung.

3.2 Video Generation

Wie bei der Bildgenerierung war Claude aufgrund fehlender Videofunktionen disqualifiziert. Dieser Test wurde auf einer Drittanbieterplattform (hickfield.ai) durchgeführt, die verschiedene Modelle aggregiert. Der Quelltext lieferte keine Ergebnisse für ChatGPT oder Gemini, sodass sich die Bewertung in diesem Vergleich hauptsächlich auf Grok aus der primären Vergleichsgruppe konzentrierte, ergänzt durch externe Referenzmodelle wie "Vio" und "Sora" zur Einordnung.

Grok wurde mit zwei Prompts bewertet:

- Prompt 1: "Driftender Sportwagen": Groks Ergebnis wurde als besser als der Sora-Benchmark, aber weniger realistisch als der Vio-Benchmark eingeschätzt.

- Prompt 2: "High-End-Restaurantküche": Groks Video galt als das am wenigsten realistische der getesteten Modelle. Eine bestimmte Einstellung wurde als durch die bizarre Aktion, Ketchup auf ein Schneidebrett zu drücken, "vollständig ruiniert" beschrieben.

Die Leistung von Grok zeigt, dass zwar Videogenerierung möglich ist, die Ergebnisse derzeit jedoch hinter spezialisierten Wettbewerbsmodellen zurückbleiben. Für Produktionsanwendungen sind Stabilität, Realismus und kohärente Animation entscheidend, weshalb spezialisierte Videomodelle weiterhin eine wichtige Rolle spielen.

Von der kreativen und subjektiven Aufgabe der Multimediaerzeugung wendet sich die Analyse nun der objektiven und analytischen Aufgabe der Informationsgenauigkeit zu.

4.0 Performance Evaluation: Information Accuracy and Analysis

Die Zuverlässigkeit einer KI für faktengestützte professionelle Anwendungen – von Business Intelligence bis zur akademischen Forschung – basiert auf ihrer Genauigkeit und analytischen Tiefe. Dieser Abschnitt bewertet die Fähigkeit der Modelle, faktische Fragen korrekt zu beantworten und kontextuelle Informationen aus Bildern zu interpretieren.

4.1 Fact-Checking

Die Modelle wurden mit drei faktischen Multiple-Choice-Fragen getestet, um ihre Wissensgenauigkeit zu messen. Solche Faktenchecks sind besonders relevant für Anwendungen in Journalismus, Compliance und Datenverifikation.

- Atomstromproduktion: Alle vier KIs erkannten korrekt, dass die Kernenergie 2021 etwa 10 % der weltweiten Stromerzeugung ausmachte.

- Einkommen der reichsten 1 %: Die Antworten der Modelle variierten stark. Die korrekte Antwort lag bei ungefähr 35.000 $ pro Jahr. Claude war das einzige Modell, das eine nahe Schätzung abgab (Schätzung von 34.000 $ bis 60.000 $). Die anderen Modelle lagen deutlich daneben.

- Anzahl geschlachteter Hühner für Fleisch: Die richtige Antwort war 69 Milliarden. Gemini und Claude lagen hier am genauesten und nannten die richtige Zahl. ChatGPTs Bereich beinhaltete die richtige Zahl, während Grok leicht darunter lag.

Aufgrund dieser Ergebnisse ging Claude als stärkster Performer in der Faktenprüfung hervor und zeigte eine überlegene Genauigkeit bei einer anspruchsvollen wirtschaftlichen Fragestellung, bei der die Konkurrenz schwächer abschnitt. Faktenprüfungen bleiben aber ein dynamisches Feld, in dem Datenaktualität und Quellenverfügbarkeit entscheidend sind.

4.2 Contextual Analysis

Dieser Test bewertete die Fähigkeit, visuelle Informationen und Kontext aus Bildern zu analysieren — eine nützliche Funktion für Bildklassifikation, UX-Analysen und visuelle Datenerfassung.

- Schreibtisch-Foto-Analyse: Bei der Analyse eines Fotos eines unordentlichen Schreibtisches identifizierten alle vier Modelle ähnliche Kernprobleme, wie das Smartphone als große Ablenkung und Kabelgewirr, das visuelle Unruhe erzeugt.

- Where's Waldo? Challenge: In einem deutlich anspruchsvolleren Test sollten die Modelle Waldo in einer komplexen Illustration finden. Claude war das einzige Modell, das Waldo korrekt lokalisierte. ChatGPT, Gemini und Grok scheiterten und gaben falsche Positionen an.

Dieser eindeutige Erfolg in der "Where's Waldo?"-Herausforderung machte Claude zum klaren Sieger der Analyse-Runde und demonstrierte eine überlegene Fähigkeit zur detaillierten visuellen Kontextinterpretation. Solche Fähigkeiten sind wertvoll für Anwendungen in der Bildforensik, Bildannotation und automatisierten Qualitätskontrolle.

Nachdem Claudes Stärken in der Analyse festgestellt wurden, geht die Bewertung nun zu einer umfassenden Forschungsaufgabe über, die Informationsbeschaffung mit Daten-Synthese kombiniert.

5.0 Performance Evaluation: Deep Research and Data Synthesis

Eine Kernanforderung für professionelle KI-Anwendungsfälle ist die Fähigkeit, tiefe Recherche durchzuführen — nicht nur Informationen aus mehreren Quellen zu sammeln, sondern sie strukturiert zu synthetisieren und für Entscheidungsprozesse klar aufzubereiten. Dieser Test untersuchte, wie die Modelle mit einer komplexen Produktvergleichsaufgabe umgehen.

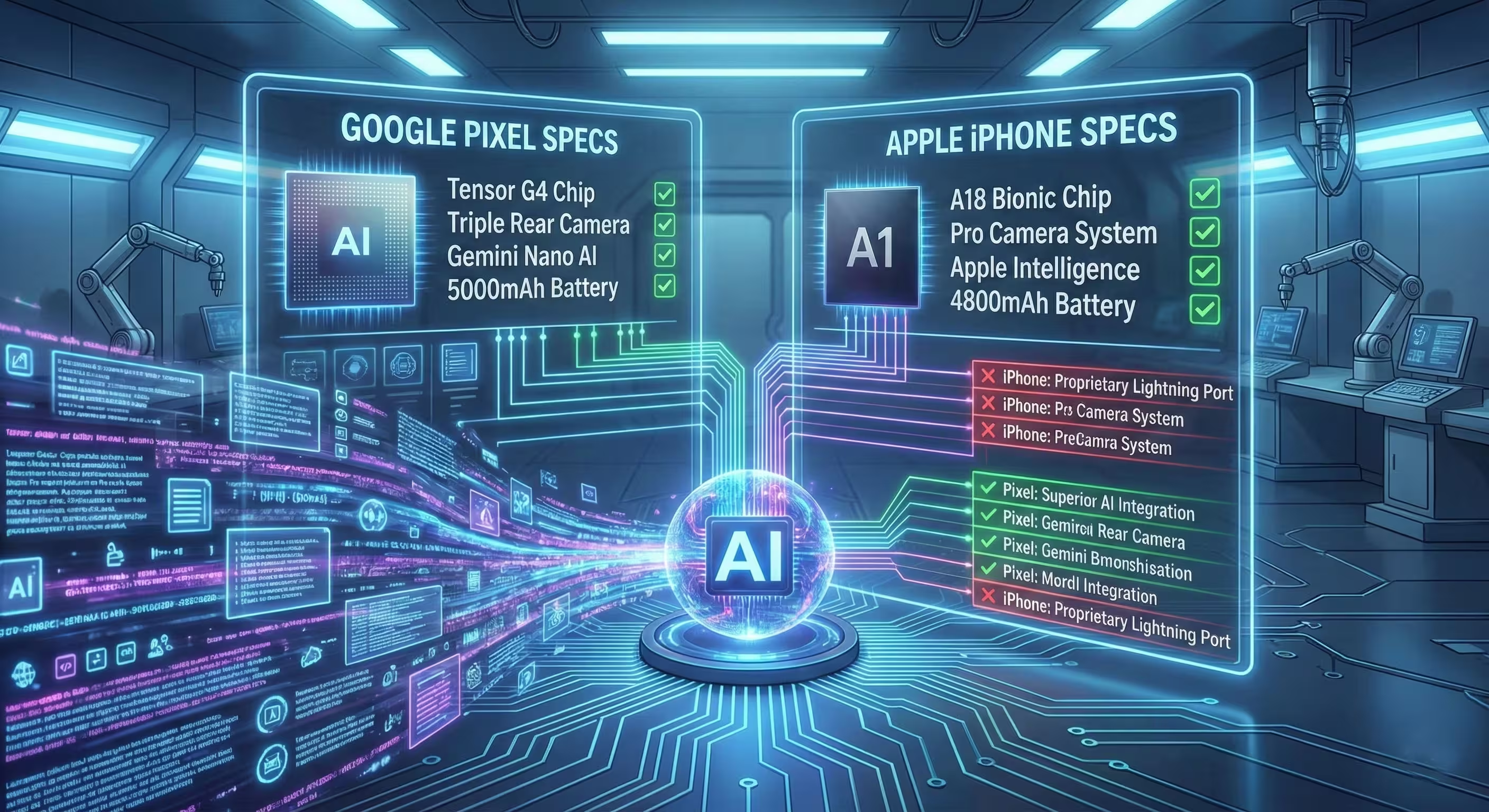

Die Modelle sollten das spekulative "iPhone 17 Pro Max" gegen das "Pixel 10 Pro XL" für Fotografen vergleichen und dabei verfügbare Reviews und technische Spezifikationen nutzen, um ein abschließendes Urteil zu fällen.

Jedes Modell verfolgte eine leicht unterschiedliche Methodik, die zentrale Unterschiede in ihrer Fähigkeit offenbarte, komplexe Daten effektiv darzustellen und zu gewichten.

- ChatGPT & Grok: Boten traditionelle, textbasierte Aufschlüsselungen der Kameraspezifikationen und verglichen diese in verschiedenen Aufnahmeszenarien.

- Gemini & Claude: Nutztten Markdown-ähnliche Tabellen, um einen direkten, nebeneinander Vergleich der Spezifikationen zu präsentieren. Dieses Format wurde für seine bessere Klarheit und Lesbarkeit gelobt, weil es eine schnelle "auf einen Blick"-Erfassung der Daten ermöglicht.

Während das Format wichtig war, war die Genauigkeit des Urteils und der zugrundeliegenden Daten entscheidend.

- Die abschließenden Empfehlungen waren geteilt: ChatGPT und Claude empfahlen das iPhone, während Gemini und Grok das Pixel bevorzugten.

- Allerdings wurde Claudes Leistung durch gravierende Fehler stark beeinträchtigt. Seine Vergleichstabelle fehlte wichtige technische Informationen und, noch schwerwiegender, es "halluzinierte eine falsche Blendenangabe für das Hauptobjektiv des iPhones".

Dieser kritische Fehler in der Datenintegrität disqualifizierte Claude für diese Runde. Aufgrund seiner Fähigkeit, Informationen in einem klaren tabellarischen Format zu präsentieren und dabei die Datenintegrität zu wahren, wurde Gemini zum Sieger der Kategorie "Tiefe Recherche" erklärt. Verlässliche Datenaggregation und transparente Quellenangaben sind hier Schlüsselfaktoren.

Nach dieser abschließenden Leistungskategorie gelangt der Bericht nun zu seiner zusammenfassenden Bewertung und den Endplatzierungen.

Final Rankings and Conclusion

Nach einer umfassenden Bewertung in neun unterscheidbaren Leistungskategorien hat sich eine klare Hierarchie der Fähigkeiten herauskristallisiert. Dieser Abschnitt fasst die Ergebnisse der vorangegangenen Analyse zusammen, präsentiert ein abschließendes Ranking der vier KI-Modelle und gibt eine konklusive Übersicht über ihre jeweiligen Stärken und Schwächen in Bereichen wie generative KI, Faktenprüfung, Multimedia und Forschungssynthese.

Die endgültige Modellrangfolge, basierend auf ihrer Gesamtleistung in diesem direkten Vergleich, lautet wie folgt:

- Gold Medal: Gemini

- Silver Medal: ChatGPT

- Bronze Medal: Grok

- Last Place: Claude

Concluding Synthesis

- Gemini: Als "Gesamtsieger" basierte Geminis Erfolg auf konstant hoher Leistung in praktischen, geschäftsorientierten Aufgaben. Es lieferte herausragende Ergebnisse bei mathematisch fundierten Problemlösungen und klarer, genauer Tiefenrecherche, ergänzt durch eine Spitzenleistung in der Bildgenerierung. Damit erwies es sich als das zuverlässigste und vielseitigste Modell in dieser Analyse.

- ChatGPT: Als Silbermedaillengewinner bleibt ChatGPT ein leistungsfähiger und verlässlicher Zweiter. Es überzeugte durch höfliche und kohärente Debattenführung und zeigte kompetente, erfolgreiche Pläne bei praktischer Problemlösung, womit es seine Rolle als starker Allrounder untermauerte.

- Grok: Grok positioniert sich als spezialisiertes Werkzeug mit einzigartigen Merkmalen. Es gewann die Kategorie der moralischen Dilemmata, indem es direkte Antworten gab, die andere Modelle vermieden, und bietet unterschiedliche Gesprächsmodi für verschiedene Einsatzfälle. Allerdings blieb es hinter den Erwartungen bei praktischer Problemlösung und Forschungsgenauigkeit zurück.

- Claude: Claude zeigte außergewöhnliche Stärken als analytisches Modell und dominierte die Faktenprüfung und Kontextanalyse mit überlegener Genauigkeit. Seine vollständige Nichtbeteiligung an den Multimedia-Kategorien, in denen es null Punkte erzielte, schuf jedoch ein unüberwindbares Defizit, das auch durch seine analytische Stärke nicht ausgeglichen werden konnte, verschärft durch eine kritische Datenhalluzination in der Tiefenrecherche.

Auf Grundlage dieser umfassenden Tests stellt sich Gemini als bestes Modell heraus und bietet die ausbalancierteste und leistungsstärkste Kombination von Funktionen für professionelle und kreative Anwendungen. Die Branche der generativen KI bleibt jedoch außerordentlich dynamisch: Updates oder Architekturänderungen an einem der Modelle können die Wettbewerbslandschaft schnell verschieben. Laufende Evaluierungen und praxisnahe Tests sind daher unerlässlich, um die jeweils besten Tools für spezifische Aufgaben in Bereichen wie Bild- und Videoerzeugung, Faktenprüfung, Forschungssynthese und ethischer Entscheidungsunterstützung zu identifizieren.

Kommentar hinterlassen