25 Minuten

Vier führende Modelle. Neun Kategorien. Ein Gesamtsieger. Das ist kein Labor-Benchmark mit undurchsichtigen Ranglisten. Es ist ein praktischer, durchgängiger Vergleich, aufgebaut aus Aufgaben, die für Nutzer wirklich relevant sind: reale Probleme unter Zeitdruck lösen, Bilder und Videos erzeugen, Fakten ohne Internet prüfen, unordentliche Eingaben analysieren, auf Abruf kreativ sein, natürlich sprechen und tiefgehende Recherche leisten, die einer Überprüfung standhält. Wir bewerteten jede Unteraufgabe mit 0–4 Punkten und führten eine laufende Gesamtwertung. Am Ende kürten wir einen Champion und, noch wichtiger, ordneten jedes Modell den Aufgaben zu, für die es am besten geeignet ist.

Kurzfristige Antwort zuerst: Gemini gewinnt insgesamt mit 46 Punkten. ChatGPT landet knapp dahinter mit 39 Punkten. Grok belegt den dritten Platz mit 35 Punkten. DeepSeek liegt bei 17 Punkten. Das heißt nicht, dass Sie immer den Gesamtsieger wählen sollten. Verschiedene Kategorien begünstigen unterschiedliche Stärken, und das richtige Modell hängt von der Aufgabe ab, die Sie erledigen müssen. Diese Bewertung zeigt genau, wo jedes Modell glänzt und wo es stolpert — mit konkreten Beispielen und vollständig transparenten Bewertungen.

How We Tested

Models compared: ChatGPT, Gemini, Grok, DeepSeek.

Categories: neun insgesamt. Einige beinhalten mehrere Runden oder Prompts.

Scoring: jede Runde wird 0–4 bewertet. Wo der Quellvergleich explizite Punkte oder Rangfolgen vorgab, haben wir diese übernommen; sonst folgten wir denselben Regeln und dem gleichen Bewertungsraster.

Constraints: wenn in einer Runde Internetzugang verboten war, haben wir diese Einschränkung respektiert. Wo eine Fähigkeit nicht existiert (zum Beispiel Bild- oder Videogenerierung in DeepSeek), erhält das Modell für diese Runde null Punkte.

Speed: beschreibend erfasst, nicht als eigene Kategorie bewertet, damit die Gesamtsummen mit dem ursprünglichen Wettbewerb übereinstimmen.

Unser Ziel war nicht, Fangfragen zu stellen. Wir wollten reales Verhalten untersuchen, einschließlich Fehlerbildern wie erfundenen Details in der Bildanalyse oder oberflächlichen Budgetrechnungen, die das Szenario ignorieren.

Category 1: Problem Solving

Zwei realistische Herausforderungen. Einzelbewertung pro Runde, dann Summierung.

Round 1: You have 10 dollars, a dead phone, no map, and 45 minutes to reach a central train station in a foreign city. Give a five-step plan.

Speed: DeepSeek antwortet in 7 Sekunden, Grok in 11, Gemini in 21, ChatGPT in 62.

Quality: alle vier liefern strukturierte, praktikable Fünf-Schritte-Pläne.

Peer review twist: wir zeigten dann alle vier Antworten jedem Modell und baten sie, die beste auszuwählen. Jedes Modell wählte unabhängig ChatGPTs Antwort.

Scores, Round 1

ChatGPT 4, Gemini 3, Grok 2, DeepSeek 1.

Round 2: You have 400 dollars after rent to cover groceries, transport, and internet. Groceries cost 50 per week, transport 80 per month, internet 60 per month. You want to attend a 200 dollar event next month. How do you budget?

Eine Denkfalle. ChatGPT, Grok und DeepSeek entscheiden sich, jetzt nur 60 Dollar zurückzulegen und „nächsten Monat mehr zu sparen“, was zu spät ist. Gemini ist das einzige Modell, das den Plan sofort anpasst: Lebensmittelbudget um 15 Dollar pro Woche reduzieren durch Rabattkauf und strikte Mahlzeitenplanung, sodass das Defizit diesen Monat ausgeglichen wird.

Scores, Round 2

Gemini 4, ChatGPT 3, Grok 3, DeepSeek 2.

Problem Solving Totals

| Model | Round 1 | Round 2 | Total |

|---|---|---|---|

| ChatGPT | 4 | 3 | 7 |

| Gemini | 3 | 4 | 7 |

| Grok | 2 | 3 | 5 |

| DeepSeek | 1 | 2 | 3 |

Interpretation: ChatGPT zeigt starke schrittweise Planung und gewinnt die Peer-Review-Abstimmung; Gemini zeigt bessere Szenario-Anpassung unter Einschränkungen. Beide teilen sich den ersten Platz insgesamt.

Category 2: Image Generation

Zwei Prompts. DeepSeek kann keine Bilder erzeugen und erhält per Definition null Punkte.

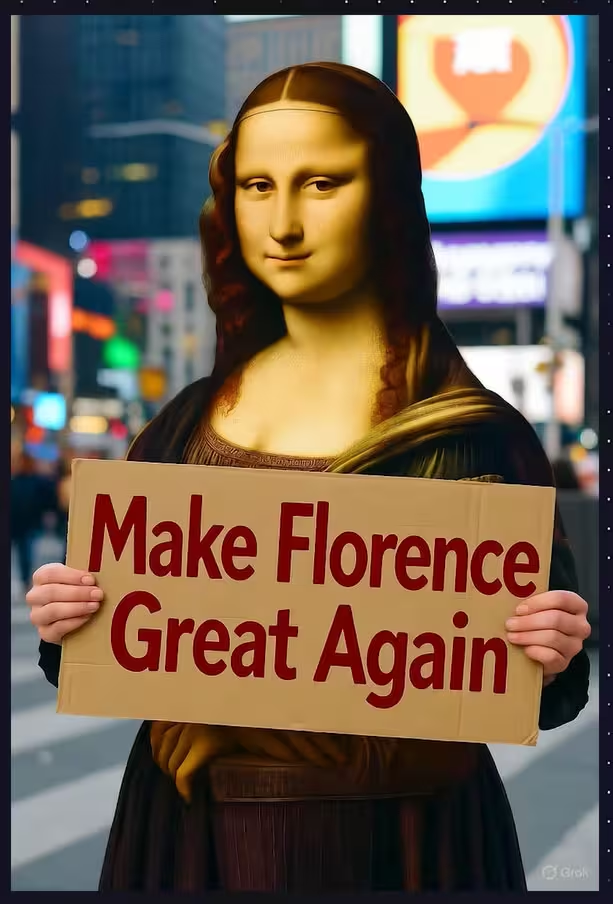

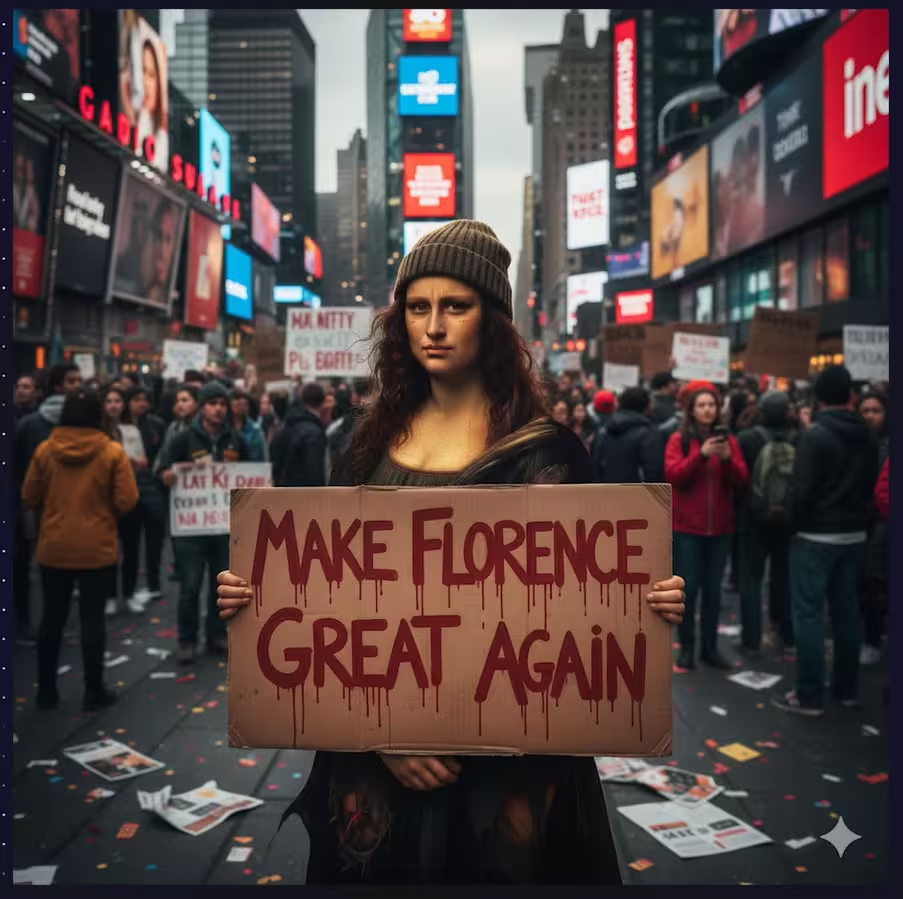

Prompt 1: Photoreal Mona Lisa as a frustrated street protester in Times Square, holding a cardboard sign that reads “Make Florence great again” in bold red letters.

Grok: am schnellsten, aber offensichtlich künstlich. Die Person wirkt falsch, selbst mit zusätzlichen Händen.

Gemini: gute Komposition und Umfeld; das Motiv hat jedoch immer noch drei Hände.

ChatGPT: natürlichstes Motiv mit überzeugendem Times-Square-Hintergrund; das Schild und die Pose entsprechen dem Briefing.

Scores

ChatGPT 4, Gemini 3, Grok 1, DeepSeek 0.

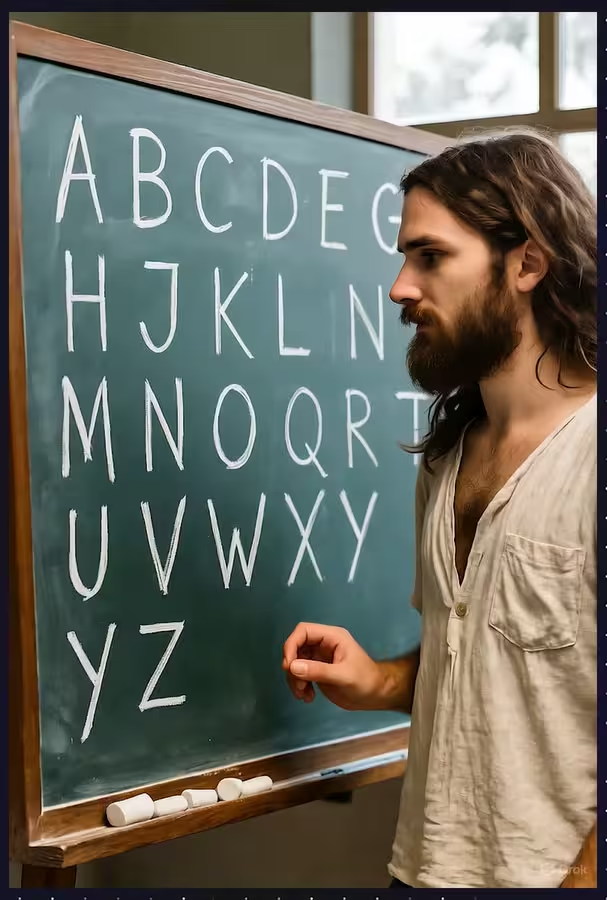

Prompt 2: Photoreal classroom with a hippie-style teacher beside a chalkboard showing the full alphabet in chalk, letters decreasing in size.

Grok: Klassenraum und Handschrift wirken authentisch, aber das Alphabet selbst ist falsch und unvollständig.

Gemini: ästhetisch ansprechend, aber stärker stilisiert als fotorealistisch; übertrieben perfekte Schriftzeichen.

ChatGPT: insgesamt am überzeugendsten; Beleuchtung, Klassenraumdetails und Lehrkraft wirken glaubwürdig. Die Handschrift ist möglicherweise zu perfekt.

Im ursprünglichen Wettbewerb war die Höchstpunktzahl für diese spezielle Runde auf 3 begrenzt.

Scores

ChatGPT 3, Gemini 2, Grok 2, DeepSeek 0.

Image Generation Totals

| Model | P1 | P2 | Total |

|---|---|---|---|

| ChatGPT | 4 | 3 | 7 |

| Gemini | 3 | 2 | 5 |

| Grok | 1 | 2 | 4 |

| DeepSeek | 0 | 0 | 0 |

Interpretation: ChatGPT ist am zuverlässigsten bei fotorealistischen Prompts. Gemini liegt meist nah dran, während Grok bei feiner Anatomie und Texttreue Probleme hat.

Category 3: Fact-Checking Without Internet

Drei Multiple-Choice-Fragen. Vertrauenswerte wurden aufgezeichnet, beeinflussten aber das Raster nicht.

Q1: In 2018, about how many chickens were killed for meat production?

Optionen: 690 Millionen, 6,9 Milliarden, 69 Milliarden, 690 Milliarden.

Korrekt: 69 Milliarden.

Grok antwortet direkt mit 69 Milliarden.

ChatGPT gibt eine Bandbreite an, die die richtige Zahl einschließt.

Gemini und DeepSeek liegen geringfügig niedriger um etwa 65 Milliarden.

Scores

Grok 4, ChatGPT 3, Gemini 1, DeepSeek 1.

Q2: As of 2020, approximately how much annual income puts you in the richest 1 percent globally?

Optionen: 200k, 75k, 35k, 15k.

Korrekt: 35k.

Gemini nennt 34k.

ChatGPT 200k, Grok 60k, DeepSeek 75–85k.

Scores

Gemini 4, die anderen 0.

Q3: In 2019, what proportion of U.S. electricity came from fossil fuels?

Optionen: 83%, 63%, 43%, 23%.

Korrekt: 63%.

Gemini trifft mit genau 63%.

ChatGPT 63–65%, Grok 62%, DeepSeek 60–65%.

Scores

Gemini 4, ChatGPT 3, Grok 3, DeepSeek 3.

Fact-Checking Totals

| Model | Q1 | Q2 | Q3 | Total |

|---|---|---|---|---|

| ChatGPT | 3 | 0 | 3 | 6 |

| Gemini | 1 | 4 | 4 | 9 |

| Grok | 4 | 0 | 3 | 7 |

| DeepSeek | 1 | 0 | 3 | 4 |

Interpretation: Gemini gewinnt bei Präzision und Konsistenz. Grok punktet bei der ersten Frage, liegt aber beim Einkommensschwellenwert weit daneben. ChatGPTs Bandbreiten sind hilfreich, doch Genauigkeit zählt.

Category 4: Multimodal Analysis

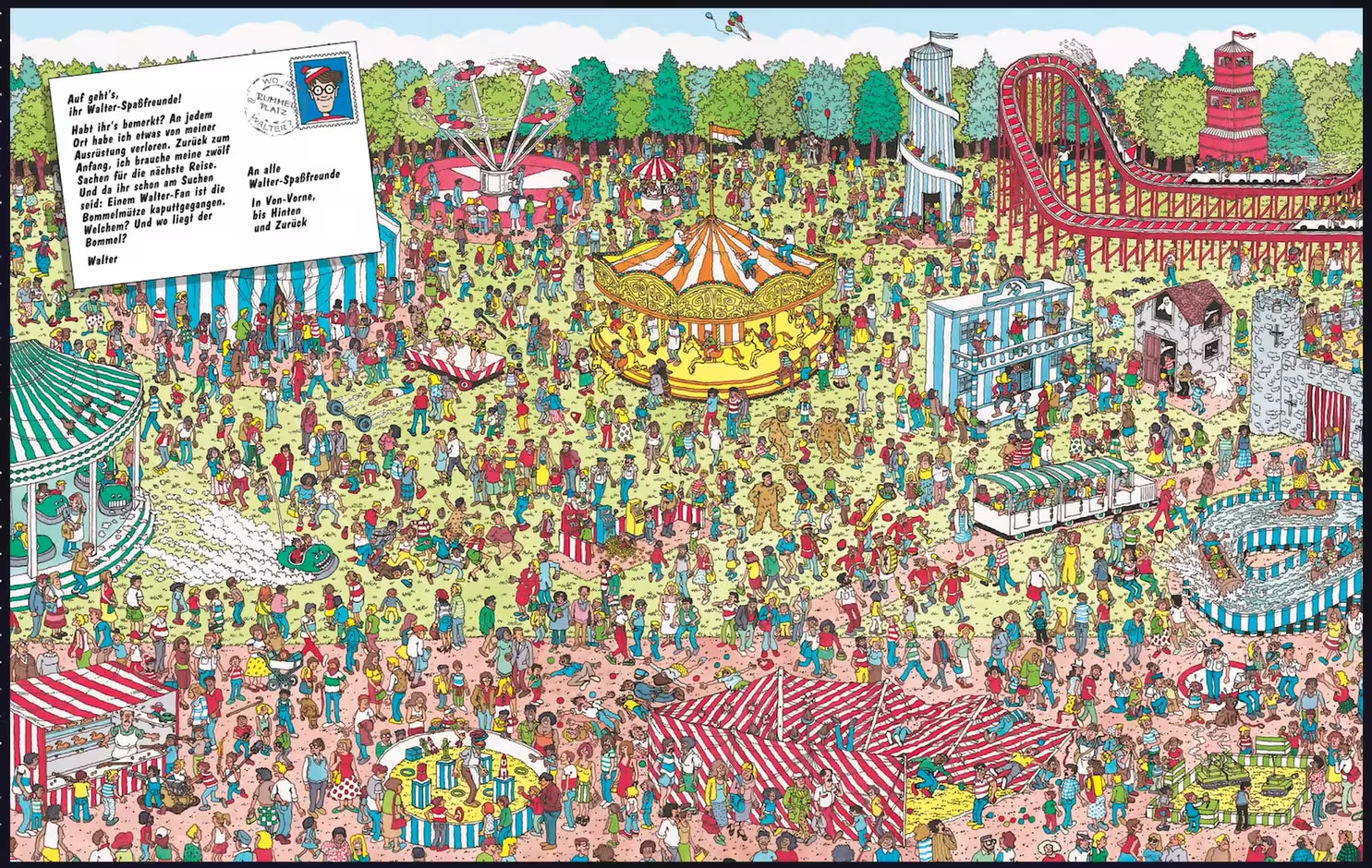

Zwei Runden: ein Kühlschrankfoto und eine "Where’s Waldo"-Szene.

Round 1: What’s in the fridge, and propose three meals from those ingredients.

DeepSeek kann keine Objekte identifizieren und fällt aus.

ChatGPT übersieht drei Artikel, erfindet keine Extras und schlägt vernünftige Gerichte vor, die mit dem Vorrat übereinstimmen.

Gemini übersieht sieben Artikel und erfindet Zitrusfrüchte, die nicht vorhanden sind.

Grok übersieht drei, erfindet aber eine lange Liste zusätzlicher Artikel und schreibt dann Rezepte, die diese Phantomzutaten benötigen.

Scores

ChatGPT 4, Gemini 3, Grok 2, DeepSeek 0.

Round 2: Find Waldo in a busy illustration.

Keines der Modelle findet Waldo korrekt. DeepSeek liest verstreuten Text und liefert eine Nicht-Antwort.

Scores

Alle 0.

Analysis Totals

| Model | Fridge | Waldo | Total |

|---|---|---|---|

| ChatGPT | 4 | 0 | 4 |

| Gemini | 3 | 0 | 3 |

| Grok | 2 | 0 | 2 |

| DeepSeek | 0 | 0 | 0 |

Interpretation: erfundene Objekte sind tödlich für die Praxisrelevanz. ChatGPT widersteht der Versuchung zu erfinden, und diese Zurückhaltung gewinnt die Runde.

Category 5: Video Generation

Zwei klassische Szenen. DeepSeek kann kein Video erzeugen und erhält null Punkte.

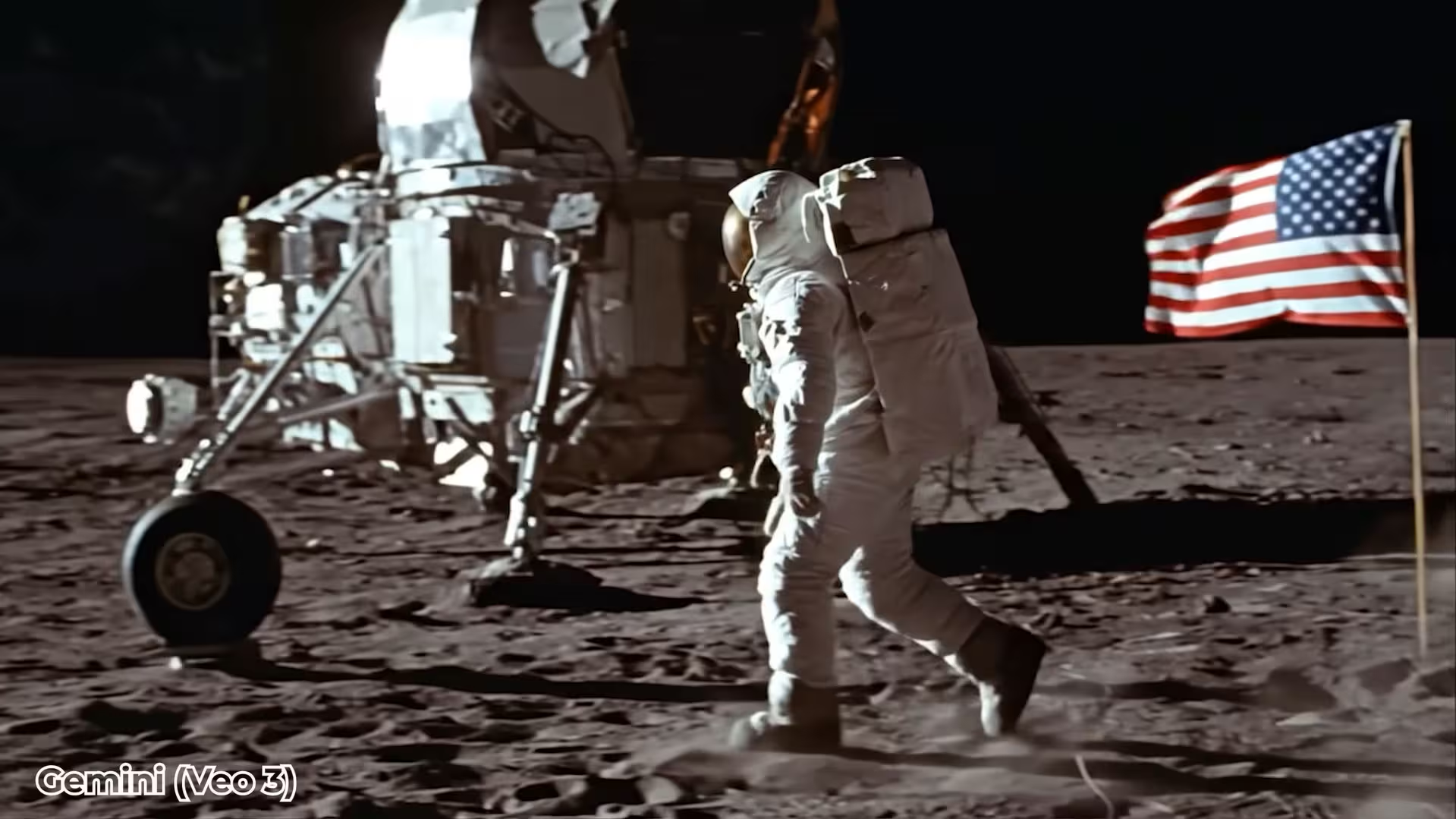

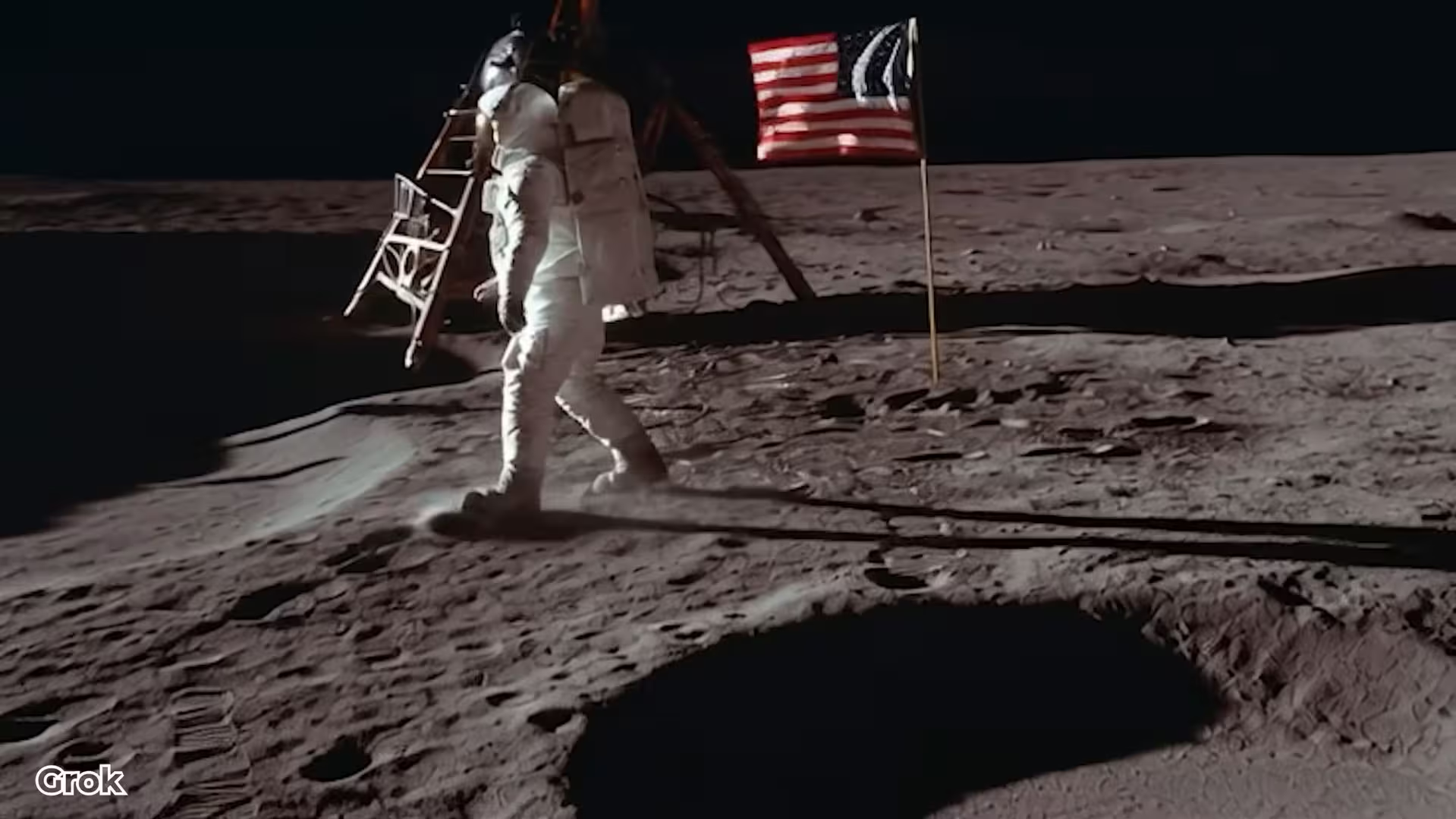

Round 1: Image-to-video from the iconic photo of Neil Armstrong on the Moon

Sora 2 weigerte sich, Menschen direkt zu animieren, daher haben wir neu vom Textprompt ausgegeben. Die Audioergebnisse waren überraschend stark.

Gemini: am cinematischsten und beste Audioausrichtung. Physikalischer Fehler: die Flagge weht, was im Vakuum nicht passieren kann.

Grok: solide Gesamtleistung, aber Maßstab des Schiffs stimmt nicht und es gibt Wind.

ChatGPT: akzeptabel, aber weniger packend als die anderen beiden.

Scores

Gemini 4, Grok 3, ChatGPT 2, DeepSeek 0.

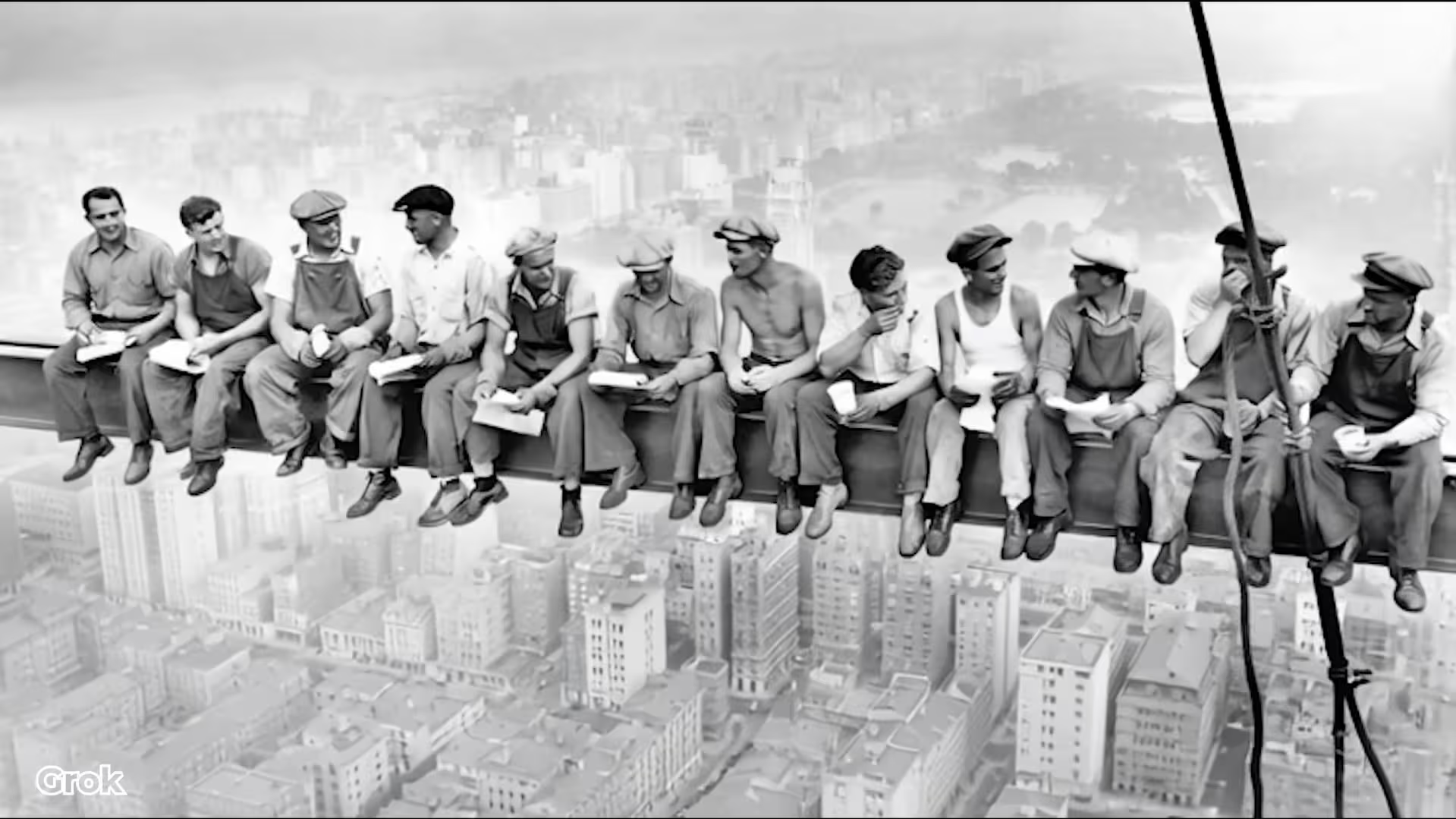

Round 2: Steel-beam workers high above the city

Gemini: beste Kameraführung und Parallaxe; Zigaretten sehen leicht falsch aus.

Grok: starke Spannung durch die schwingende Trägerkonstruktion; Zeitungen verwandeln sich unrealistisch in der Szene.

ChatGPT: anständig, aber nicht top.

Scores

Gemini 4, Grok 3, ChatGPT 2, DeepSeek 0.

Video Generation Totals

| Model | R1 | R2 | Total |

|---|---|---|---|

| Gemini | 4 | 4 | 8 |

| Grok | 3 | 3 | 6 |

| ChatGPT | 2 | 2 | 4 |

| DeepSeek | 0 | 0 | 0 |

Interpretation: Gemini führt deutlich bei Bewegungsqualität und Sounddesign. Grok ist dicht dran, macht aber Realismusfehler. ChatGPT ist stabil, aber weniger filmisch.

Category 6: Creative Generation

Zwei kurze Prompts für Wortspiele und Dad-Jokes.

Prompt 1: Three original tech puns and a one-sentence explanation for each

Alle vier folgen sauber dem Auftrag. Team-Favorit:

„Ich wollte einen Witz über USB machen, aber er hat einfach nicht gehalten.“

Scores

ChatGPT 3, Gemini 3, Grok 3, DeepSeek 3.

Prompt 2: Three original dad jokes that make me laugh really hard

Grok folgt dem allgemeinen Prompt nicht und macht ständig Witze über Smartphones und Wi‑Fi.

ChatGPT, Gemini, DeepSeek liefern allgemeine Dad-Jokes. Team-Favorit:

„Die Bäckerei meines Freundes ist letzte Nacht abgebrannt. Jetzt ist sein Geschäft toast.“

Scores

ChatGPT 4, Gemini 4, DeepSeek 4, Grok 1.

Creative Totals

| Model | Puns | Dad Jokes | Total |

|---|---|---|---|

| ChatGPT | 3 | 4 | 7 |

| Gemini | 3 | 4 | 7 |

| DeepSeek | 3 | 4 | 7 |

| Grok | 3 | 1 | 4 |

Interpretation: Dreifach-Gleichstand auf dem ersten Platz. DeepSeek erinnert daran, dass leichtes, schnelles Humor-Output zu seinen stärkeren Seiten gehört.

Category 7: Voice Mode

Wir stellten drei Geräte nebeneinander und führten strukturierte Mini-Debatten. DeepSeek hat keinen Sprachmodus und erhält null Punkte.

ChatGPT beginnt mit merkwürdigen Pausen und Tonverschiebungen mitten im Satz.

Gemini ist flüssiger und natürlicher, mit gleichmäßigem Rhythmus.

Grok ist schnell, selbstbewusst und etwas würzig; im direkten Vergleich mit Gemini klingen beide stark und wir werten es als Unentschieden.

Scores

Gemini 4, Grok 4, ChatGPT 2, DeepSeek 0.

Interpretation: Wenn Sie eine natürliche Sprachkonversation wollen, sind Gemini und Grok derzeit die besten Optionen.

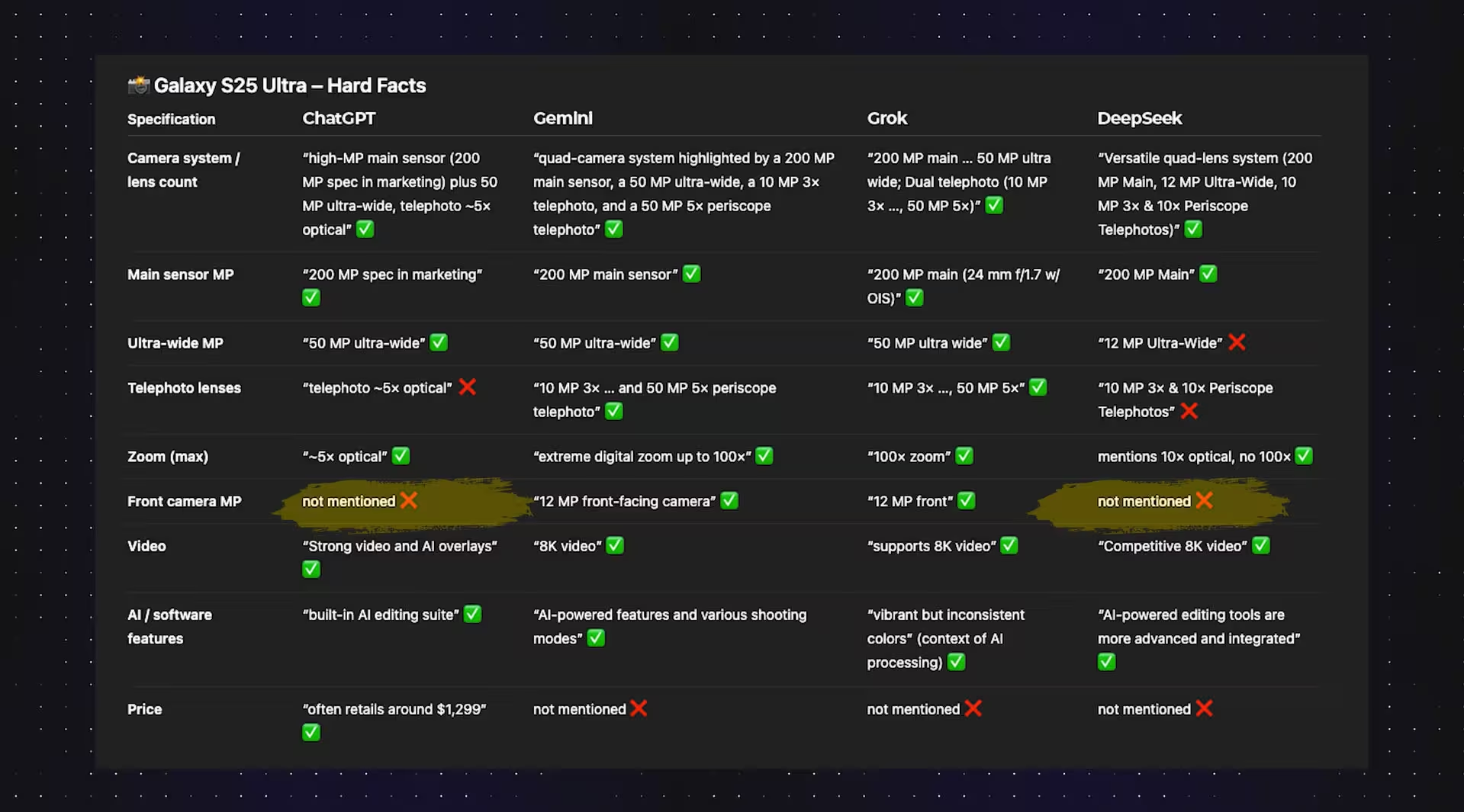

Category 8: Deep Research

Prompt: compare iPhone 17 Pro Max vs Galaxy S25 Ultra for photographers, use reviews and official specs, decide which is better, be concise.

DeepSeek behauptet fälschlich ein 5x-Tele beim iPhone, wo es 4x sind, und gibt das Galaxy-Ultraweitwinkel mit 12 MP statt 50 an; verweist wiederholt auf ein 10x-Teleobjektiv, das seit dem S24 gestrichen wurde.

ChatGPT vergisst das Dual-Tele-Setup beim Galaxy und lässt Frontkameras weg, nennt aber den Preis.

Gemini listet das korrekte Galaxy-Kamera-Array auf und liefert eine ausgewogene Schlussfolgerung.

Grok liefert die vollständigste und genaueste Spec‑Durcharbeitung.

Alle vier kommen zur gleichen Einschätzung: Das iPhone gewinnt bei Konsistenz und Videoqualität; das Galaxy punktet beim langen Zoom und mit fortschrittlichen KI‑Tools. Das entspricht praktischen Erfahrungen. Trotzdem müssen vereinzelte Spezifikationsdetails verifiziert werden.

Scores

Grok 4, Gemini 3, ChatGPT 2, DeepSeek 1.

Interpretation: Grok gewinnt die Recherchearbeit, Gemini ist dicht dahinter, ChatGPT ist nützlich, verpasst aber Schlüsselcam‑Fakten, DeepSeek braucht sorgfältigere Spec‑Disziplin.

Category 9: Speed (Observed, Not Scored)

ChatGPT wirkt bei Plain‑Text-Aufgaben am schnellsten, verlangsamt aber bei Bild- und Tiefenrechercheaufgaben.

Gemini ist fast überall konstant; selten das absolute Schnellste, fast nie das Langsamste.

Grok ist allgemein flott, kann aber bei Analyse und Recherche ins Stocken geraten.

DeepSeek antwortet oft in unter 10 Sekunden, doch diese Geschwindigkeit geht häufig zu Lasten von Kontext und Genauigkeit.

Wir haben Geschwindigkeit nicht als eigene Kategorie bewertet, um die Punktzahlen mit dem Originalwettbewerb abzugleichen.

Full Scoreboard

Aus Transparenzgründen hier die vollständige Tabelle der Punkte nach Kategorie, passend zu den Endergebnissen des Quellwettbewerbs.

| Category | ChatGPT | Gemini | Grok | DeepSeek |

|---|---|---|---|---|

| Problem Solving | 7 | 7 | 5 | 3 |

| Image Generation | 7 | 5 | 4 | 0 |

| Fact-Checking | 6 | 9 | 7 | 4 |

| Analysis | 4 | 3 | 2 | 0 |

| Video Generation | 4 | 8 | 6 | 0 |

| Creative | 7 | 7 | 4 | 7 |

| Voice Mode | 2 | 4 | 4 | 0 |

| Deep Research | 2 | 3 | 4 | 1 |

| Total | 39 | 46 | 35 | 17 |

Overall winner: Gemini (46 points).

Runner-up: ChatGPT (39). Third place: Grok (35). Fourth place: DeepSeek (17).

Strengths, Weaknesses, and Failure Modes

Ein Head-to-Head hilft nur, wenn es erklärt, warum Modelle sich so verhalten, wie sie es tun. Das sind die konsistenten Muster, die wir beobachtet haben.

ChatGPT

Strengths: sehr strukturierte Argumentation unter Einschränkungen; konservative, weniger halluzinatorische Bildanalyse; außergewöhnlich starke fotorealistische Bildgenerierung; verlässliche, prägnante kreative Texte.

Weaknesses: verlangsamt bei schweren multimodalen Aufgaben; gelegentliche Spec‑Auslassungen in Recherchen; Sprachwiedergabe braucht stabilere Prosodie.

Failure modes to watch: kleine, aber wichtige Faktenlücken bei Multi‑Device‑Vergleichen; unvollständige Spezifikationen, wenn der Prompt zu knapp ist.

Pick ChatGPT if: Sie brauchen Bildgenerierung, die Prompts genau einhält, schrittweise Pläne oder kreative Texte, die sauber und konsistent landen. Es ist auch hervorragend für Lebensmittel‑ und Rezeptlogik, wenn das Inventar unvollständig ist.

Gemini

Strengths: beste Gesamtbalance; scharf beim Faktencheck ohne Internet; überzeugendste Videoausgabe und Audio‑Staging; problembasierte Lösungsfindung, die den Plan anpasst statt nur die Zahlen zu kommentieren; die geschmeidigste Stimme.

Weaknesses: gelegentliche Überpolitur in Bildern; kann in der visuellen Analyse nette, aber imaginäre Details ergänzen; selten absolut das schnellste Modell.

Failure modes to watch: fotorealistische Prompts, die penible Typografie oder perfekte menschliche Anatomie verlangen, können es stolpern lassen; seien Sie bei physikalischen Randbedingungen in Videos explizit.

Pick Gemini if: Sie möchten ein Standardmodell, das die meisten Aufgaben sehr gut bewältigt, besonders wenn die Arbeit Argumentation mit multimodaler Generierung verbindet und Korrektheit wichtig ist.

Grok

Strengths: exzellente Tiefenrecherche; prägnante Stimme; schnelle Erstentwürfe; starkes Verständnis von Debattenstruktur.

Weaknesses: Bildhalluzinationen in der visuellen Analyse; Realitätsbrüche in Videos; gelegentliche Tunnelblick‑Effekte bei kreativen Prompts.

Failure modes to watch: erfundene Gegenstände in Fotos; selbstbewusste, aber falsche Details; Festhalten an einem verworfenen Thema, wenn der Prompt geändert wurde.

Pick Grok if: Sie brauchen einen scharfen Rechercheassistenten zum Konsolidieren von Specs und Reviews oder eine lebhafte Stimme für Debatten. Kombinieren Sie es mit manueller Verifikation, wenn Präzision zählt.

DeepSeek

Strengths: schnell bei Text; überraschend solide bei kurzen, leichten Humoraufgaben; gut beim Befolgen einfacher kreativer Briefings.

Weaknesses: keine Bild‑ oder Videogenerierung; kann keine Objekte in Bildern identifizieren; lockerere Faktenkontrolle in Recherchen.

Failure modes to watch: selbstbewusste, aber verzerrte Zahlen; Lesen von Texten in Bildern, während die Szene ignoriert wird.

Pick DeepSeek if: Sie wollen günstigen, sehr schnellen Textoutput für einfache Aufgaben, Witze oder Entwürfe, die Sie später ohnehin redigieren.

Practical Recommendations by Use Case

Photoreal image generation with strong prompt adherence: ChatGPT

Image analysis without hallucinated objects: ChatGPT

Video generation with better motion and sound design: Gemini

Tough fact-checking without browsing: Gemini

Problem solving under constraints: Gemini and ChatGPT

Natural, steady voice conversation: Gemini and Grok

Spec comparisons and product research summaries: Grok

Quick, lightweight creative text: DeepSeek

Why the Winner Matters Less Than the Fit

Gemini erzielte die höchste Punktzahl, weil es Genauigkeit, Anpassungsfähigkeit und multimodale Qualität kombiniert. Diese Balance gewinnt Wettbewerbe. Im realen Einsatz zählt jedoch die Passung zur Aufgabe. Wenn Ihr Alltag sich um Standbilder dreht, kann ChatGPT in Ihren Workflows besser abschneiden als die Punktwerte vermuten lassen. Wenn Sie Spezifikationstabellen erstellen, ist Grok möglicherweise der schnellste Weg zu einem veröffentlichungsreifen Entwurf. Brauchen Sie eine günstige, schnelle Pointe oder einen Rohentwurf, ist DeepSeeks Geschwindigkeit ein Feature, kein Bug.

Denken Sie an diese Modelle wie an Objektive in einer Kamera‑Tasche. Das „beste“ Objektiv auf dem Papier ist nicht immer das, das Sie brauchen. Wählen Sie die Brennweite, die zum Motiv passt.

Limitations and Notes on Reproducibility

No internet rounds: alle Modelle arbeiteten mit eingebettetem Wissen, das altert. Wenn Sie die Tests Monate später wiederholen, können sich Faktenwerte verschieben, wenn Modell‑Snapshots oder Trainingsdaten aktualisiert wurden.

Generative variability: Run‑to‑run‑Variationen können die genaue Formulierung oder kleine Details ändern. Wir kontrollierten das, indem wir auf Korrektheit und Einhaltung fokussierten, nicht auf stilistische Finesse.

Speed: qualitativ erfasst. Infrastruktur und Auslastung beeinflussen Latenzen; heute schnellstes Modell kann morgen langsamer wirken.

Modal gaps: Wo eine Fähigkeit nicht existiert (DeepSeek für Bilder und Videos), ist eine Null kein Abwertur des Textvermögens. Sie spiegelt einfach den Produktumfang wider.

Verdict

Winner: Gemini (46 points). Bestes Allround‑Modell für 2025, mit herausragenden Ergebnissen beim Faktencheck, in der Videoproduktion und bei adaptivem Problemlösen sowie mit der geschmeidigsten Stimme.

Runner-up: ChatGPT (39 points). Fotorealistischer Bildführer, strukturierter Problemlöser, verlässlicher kreativer Partner und am sorgfältigsten in der bildbasierten Analyse.

Third: Grok (35 points). Recherche‑Ass mit markanter Sprachpersönlichkeit. Überprüfen Sie Details, wenn Präzision entscheidend ist.

Fourth: DeepSeek (17 points). Schnell, einfach und überraschend unterhaltsam für leichtes Kreativmaterial, aber es fehlt an multimodalem Tiefgang im Vergleich zu den Rivalen.

Wenn Sie ein Modell wollen, das die breiteste Palette alltäglicher Aufgaben mit den wenigsten Überraschungen abdeckt, wählen Sie Gemini. Wenn Ihr Workflow stark bildbezogen ist und Sie sorgfältige, schrittweise Argumentation schätzen, wird sich ChatGPT wie zuhause anfühlen. Für spec‑lastige Briefings und prägnante, gesprochene Debatten ist Grok überzeugend. Für schnelle, risikofreie Texte, bei denen Kosten und Tempo wichtiger sind als Breite, rechtfertigt DeepSeek seinen Einsatz.

Neun Kategorien. Eine Rangliste. Viel Raum für Nuancen. Wählen Sie das richtige Werkzeug, und jedes dieser Modelle kann der klügste Mitstreiter im Raum sein.

Kommentar hinterlassen