7 Minuten

Einleitung

Samsung steht diesen Monat vor einem möglichen Wendepunkt. Still und leise, beinahe unterm Feuerwerk des Lunar New Year, könnte das Unternehmen mit der Massenproduktion von HBM4 beginnen — der bisher bedeutendsten Speicher-Generation von Samsung.

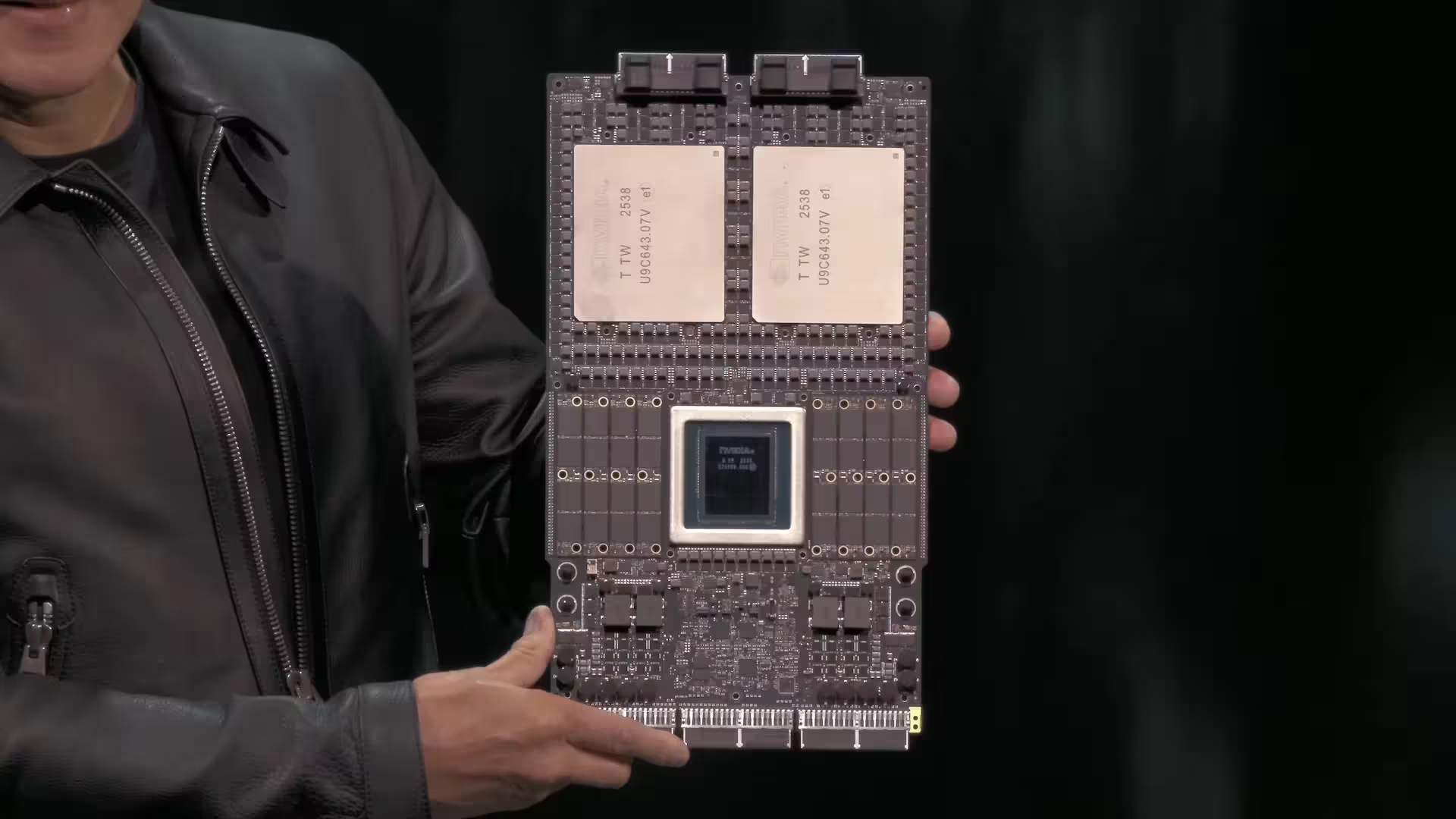

Diese High-Bandwidth-Memory-Chips sind kein kleines Update. Sie bilden das Rückgrat für die nächste Generation von KI-Beschleunigern. Nvidias Vera-Rubin-Architektur, entworfen für generative KI in Hyperscaler-Skala, soll vermutlich auf HBM4 setzen, um Latenzen zu senken und die Speicherbandbreite deutlich zu erhöhen. Berichte deuten darauf hin, dass Auslieferungen an Nvidia bereits schon nächste Woche beginnen könnten.

Warum HBM4 wichtig ist

Warum spielt das eine so große Rolle? Weil der Speicher häufig der Engpass für KI-Leistung ist. Schnelle Rechenkerne ohne ebenso schnellen Speicher gleichen einem Rennwagen, der im ersten Gang stecken bleibt. Wenn Samsung HBM4 in die Produktion bringt, könnte das Nvidia — und den Käufern dieser Beschleuniger — einen spürbaren Durchsatzvorteil verschaffen.

Marktposition und Wettbewerb

Bislang dominierten SK Hynix und Micron den HBM3E-Markt. Samsung hinkte bei HBM3 und HBM3E hinterher. Das scheint sich zu ändern. Mehrere Quellen melden, dass Samsung Nvidias finale Verifikationstests bestanden und frühe Bestellungen erhalten hat, wobei die Produktionscadenz exakt an Nvidias Zeitplan angepasst wurde. Investitionen wurden getätigt, Kapazitäten wurden erweitert. Das Ergebnis: Samsung könnte als Erster HBM4 in großem Maßstab ausliefern.

Beginnt Samsung noch in diesem Monat mit HBM4-Lieferungen, könnte das die Landkarte der HBM-Lieferanten für KI-Infrastruktur neu zeichnen.

Auswirkungen auf Hyperscaler und Cloud-Anbieter

Über Nvidia hinaus haben die Auswirkungen weitreichende Konsequenzen für Amazon und Google. Beide Unternehmen entwerfen eigene Beschleuniger für ihre Cloud-Dienste, und der Zugang zu einer HBM4-Versorgung kann Hardware-Roadmaps und Beschaffungsstrategien im gesamten Cloud-Ökosystem beeinflussen.

Risiken und Unsicherheiten

Natürlich gibt es Risiken — Yield-Probleme, Störungen in der Lieferkette oder parallel laufende Hochfahrpläne bei SK Hynix oder Micron könnten das Bild schnell verändern. Dennoch signalisiert dieser Schritt einen größeren Trend: Speicherinnovatoren sprinten, um den unersättlichen Bedarf der generativen KI zu decken. Erwartet werden engere Zeitpläne, tiefere Lieferantenkooperationen und schnellere Iterationen, wenn eine neue Speichergeneration in die Rechenzentren einzieht.

Beobachten Sie die nächsten Wochen. Hardware, deren Integration früher Quartale dauerte, könnte nun das Kräfteverhältnis in kurzer Zeit verschieben.

Technische Details: Was HBM4 anders macht

HBM4 bringt mehrere technische Verbesserungen gegenüber HBM3E und früheren Generationen:

- Höhere Datenrate pro Pin: HBM4 zielt auf deutlich höhere Datenraten pro I/O-Pin ab, was die effektive Speicherbandbreite pro Stack erhöht.

- Erhöhte Stack-Höhe und Kapazität: Durch verbesserte Die-Stapeltechnik lassen sich größere Kapazitäten pro Package realisieren, was für große KI-Modelle wichtig ist.

- Verbesserte Energieeffizienz: Effizientere I/O-Standards und interne Architekturoptimierungen senken Watt pro Gigabyte/Sekunde, was die Leistung pro Watt in Beschleunigern verbessert.

- Feinere Integration mit Interposer-Designs: Optimierte Co-Packaging-Strategien mit Chiplets, 2.5D/3D-Integration und silikonbasierten Interposern senken Latenzen zwischen Compute-Die und HBM4-Stapeln.

Diese Merkmale ermöglichen es KI-Beschleunigern, größere Modelle schneller und mit geringerer Latenz zu verarbeiten. Insbesondere bei großen Inferenz- und Trainings-Workloads reduziert mehr Bandbreite die Notwendigkeit häufiger Datenbewegungen über langsamere Pfade, wodurch sich End-to-End-Latenzen und Kosten pro Inferenz verbessern.

Test, Verifikation und Qualitätskontrolle

Die Freigabe großer Speicherlieferungen setzt umfangreiche Verifikationsläufe voraus. Typische Prüfungen umfassen:

- Signal-Integritäts-Tests (SI) und Power-Integritäts-Analysen (PI)

- Langzeit-Temperatur- und Zuverlässigkeitstests (Burn-In, HTOL)

- Systemlevel-Integrationsprüfungen mit Zielbeschleunigern (z. B. Vera Rubin)

- Yield-Optimierung und Defektklassifizierung

Quellen, die über Samsungs Fortschritt berichten, erwähnen, dass das Unternehmen Nvidias finale Verifikationssuite durchlaufen hat — ein entscheidender Meilenstein, bevor frühe Bestellungen in Serienfertigung umgesetzt werden. Solche Tests sind nicht nur technisch anspruchsvoll, sondern auch logistischer Prüfstein: Sie erfordern enge Abstimmung zwischen Speicherlieferant, Beschleuniger-Designteam und Platinen-/Systemintegration.

Yield-Management und Produktionsskala

Der Sprung von Pilotfertigung zur Massenproduktion verlangt zuverlässige Yield-Raten. Samsung hat angeblich Kapazitäten erweitert und Investitionen in Ausbau und Feinabstimmung getätigt. Dennoch bleibt Yield riskant: Neue Fertigungsprozesse, komplexere Stacking- und TSV-Verfahren (Through-Silicon Vias) sowie erhöhte Komplexität bei Testalgorithmen können zu anfänglichen Ausschussraten führen, die den kurzfristigen Lieferrhythmus beeinflussen.

Wirtschaftliche und strategische Folgen

Ein früher Markteintritt mit HBM4 kann Samsung mehrere Vorteile bringen:

- Marktanteile: Erster in Serie gelieferter HBM4-Produkte verschafft Wettbewerbsvorteile gegenüber SK Hynix und Micron.

- Preissetzungsmacht: Frühzeitige Belieferung von Hyperscalern kann Preis- und Volumenverhandlungen zugunsten Samsungs beeinflussen.

- Technologie-Führerschaft: Erfolge bei HBM4 stärken Samsungs Reputation als Innovationsführer im High-Bandwidth-Memory-Bereich.

Für Nvidia bedeutet eine frühe HBM4-Zulieferung potenziell höhere Performance ihrer Vera-Rubin-Module, was wiederum die Attraktivität für Cloud-Anbieter, Forschungszentren und KI-Farmen steigert. Dies kann Beschleuniger-Auslieferungen und Plattformadoption beschleunigen und so ein ganzes Ökosystem beeinflussen.

Auswirkungen auf Beschaffungsstrategien großer Cloud-Anbieter

Cloud-Anbieter wie Amazon Web Services und Google Cloud Platform verfolgen differenzierte Beschaffungsstrategien:

- Amazon und Google bauen eigene Beschleuniger-Designs (z. B. AWS Trainium/Inferentia-Serien, Google TPU-Folgen) und haben spezifische Anforderungen an Speicherbandbreite und Latenz.

- Verfügbarkeit von HBM4 könnte Roadmaps beschleunigen oder die Priorisierung von Plattform-Updates beeinflussen.

- Strategische Partnerschaften, Rahmenverträge und Vorratslagerung (buffer stock) werden als Absicherung gegen kurzfristige Lieferengpässe wahrscheinlicher.

Dies bedeutet: Selbst wenn Nvidia die erste Charge erhält, wird die HBM4-Verfügbarkeit die gesamte Supply-Chain neu ausrichten — von Herstellerverträgen über Logistik bis zu langfristigen Investitionsplänen in Rechenzentren.

Technologische Wechselwirkungen: Compute, Netzwerk und Speicher

Die Leistungssteigerung durch HBM4 ist nicht isoliert. Sie wirkt in Kombination mit folgenden Komponenten:

- Compute-Architektur: Moderne Beschleuniger mit hoher Kernanzahl benötigen proportional skalierte Speicherbandbreite, sonst bleibt die Rechenleistung ungenutzt.

- Interconnects und Fabric: PCIe-Generationen, CXL-Standards und Intra-Node-Verkabelung müssen mit erhöhten Durchsatzanforderungen Schritt halten.

- Speichermanagement-Software: Neue Treiber, Memory-Allocation-Strategien und Scheduler sind nötig, um HBM4 effizient auszunutzen und Hotspot-Bildung zu vermeiden.

Optimale Performance ergibt sich erst, wenn Hardware und Software synchronisiert sind: Acceleratoren müssen Bandwidth-Optimierungen kennen, Plattformen erfordern intelligente Data-Placement-Strategien, und Entwickler müssen Modelle entsprechend partitionieren.

Wirtschaftliche Szenarien: Was zu erwarten ist

Man kann mehrere plausible Szenarien skizzieren:

- Schneller Ramp-Up: Samsung erreicht stabile Yields, liefert laut Zeitplan an Nvidia, SK Hynix und Micron folgen mit leichtem Verzug. Preise stabilisieren, HBM4 wird schnell zum Standard in neuen Acceleratoren.

- Verzögerter Rollout: Yield- oder Logistikprobleme führen zu limitierten Mengen. Hyperscaler stoßen auf Engpässe, verhandeln exklusive Lieferfenster, und die Marktentwicklung stagniert kurzfristig.

- Wettbewerbsgetriebener Preiskampf: Wenn mehrere Anbieter gleichzeitig HBM4 hochfahren, kann das den Preis senken, die Margen der Speicherhersteller belasten, aber die Adoptionsrate in Rechenzentren erhöhen.

Welche Variante eintritt, hängt von Fertigungsreife, strategischen Allianzen und der Reaktion der Wettbewerber ab.

Praktische Hinweise für Betreiber von Rechenzentren

Für Betreiber lohnt sich folgende Checkliste:

- Planung: Überprüfen Sie Hardware-Roadmaps und definieren Sie Upgrade-Pfade für Server- und Rack-Designs.

- Beschaffung: Evaluieren Sie Rahmenverträge mit Speicherlieferanten und verhandeln Sie Lieferkonditionen inklusive Priorisierungsoptionen.

- Software-Stack: Aktualisieren Sie Treiber, Scheduler und Telemetrie-Tools, um neue Bandbreiten-Profile zu unterstützen.

- Thermal-Design: Höhere Bandbreite kann Änderungen im Kühldesign erfordern. Planen Sie für erhöhte thermische Anforderungen auf Board- und Rack-Level.

Langfristige Folgen für KI-Ökosysteme

Langfristig könnte ein erfolgreiches Hochfahren von HBM4 mehrere Effekte haben:

- Schnellere Modellentwicklung: Größere Modelle können effizienter trainiert werden, was Innovationen bei generativer KI beschleunigt.

- Neue Geschäftsmodelle: Anbieter könnten spezialisierte HBM4-basierte Instanzen anbieten, um latenzkritische Anwendungen zu bedienen.

- Ökologischer Fußabdruck: Effizientere Speicher führt zu besserer Energieeffizienz pro Rechenleistung, beeinflusst aber auch Gesamtenergiebedarf durch Vermehrung rechenintensiver Anwendungen.

Fazit

Samsungs Vorstoß in die HBM4-Massenfertigung ist ein bedeutender Schritt für die KI-Infrastruktur. Wenn die Auslieferungen planmäßig starten, kann das die Performance-Landschaft für KI-Beschleuniger und Rechenzentren nachhaltig verändern. Dennoch bleiben technische Risiken und Marktreaktionen entscheidend. In den nächsten Wochen könnten sich die Kräfteverhältnisse in der Speicherindustrie und bei Beschleuniger-Ökosystemen spürbar verschieben — schneller, als viele erwarten.

Beobachten Sie genau, wie sich Verkäufe, Yield-Raten und Wettbewerbsreaktionen entwickeln. Die nächste Speichergeneration wird nicht nur technische Werte verbessern, sondern auch strategische Entscheidungen in Rechenzentren, bei Cloud-Anbietern und in der gesamten KI-Lieferkette beeinflussen.

Quelle: sammobile

Kommentar hinterlassen