8 Minuten

Einleitung

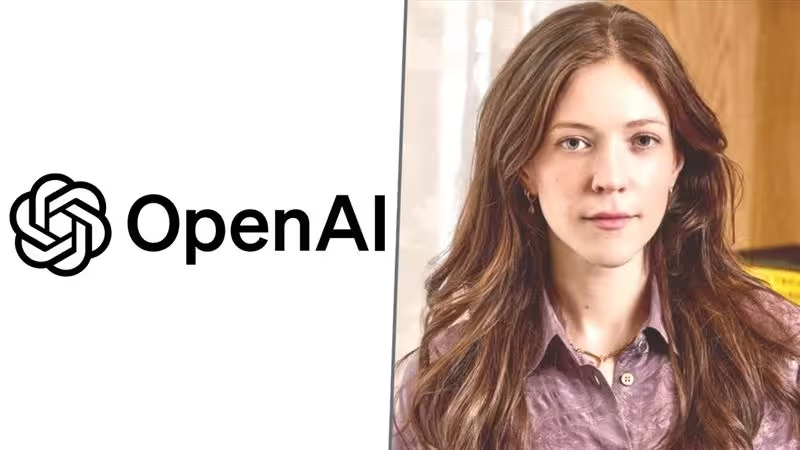

Wer zieht den Stecker, wenn interne Richtlinien mit Produktambitionen kollidieren? Bei OpenAI wurde diese Frage in diesem Winter laut diskutiert, nachdem Ryan Beiermeister, der Vice President of Product Policy des Unternehmens, abrupt ausgeschieden ist. Der Fall wirft zentrale Fragen zur Balance von Produktinnovation, Sicherheit und Unternehmensführung auf.

Nach Angaben des Wall Street Journal wurde Beiermeister im Januar entlassen, nachdem ein männlicher Kollege ihn der geschlechtsspezifischen Diskriminierung beschuldigt hatte. Beiermeister wies die Anschuldigung zurück. „Der Vorwurf, ich hätte jemanden diskriminiert, ist schlicht falsch“, sagte er dem Journal in einer kurzen Stellungnahme.

Die Entlassung erhielt zusätzliche Aufmerksamkeit, weil sie zeitlich mit internen Debatten über eine geplante ChatGPT-Funktion zusammenfiel, die intern als „Erwachsenenmodus“ ("adult mode") bezeichnet wurde. Fidji Simo, Leiterin der Consumer-Apps bei OpenAI, hatte bereits gegenüber Medien erklärt, die Funktion sei für eine Veröffentlichung im ersten Quartal vorgesehen. Dieser Zeitplan löste sowohl innerhalb als auch außerhalb des Unternehmens Verwunderung und Besorgnis aus.

Berichten zufolge haben Beiermeister und weitere Mitarbeitende Vorbehalte geäußert. Die zentrale Sorge: Wie würde ein expliziterer oder nachsichtigerer Modus vulnerable Nutzerinnen und Nutzer beeinflussen und welche Auswirkungen hätte er auf die bestehenden Sicherheitsmechanismen? Auf der einen Seite stehen Nutzerwünsche nach mehr Kontrolle und weniger Einschränkungen, auf der anderen Seite die Risiken, die mit einem gelockerten Inhaltsfilter verbunden sind. Das ist ein typisches Produkt‑gegen‑Richtlinie-Dilemma – doch in diesem Fall geht es um Werkzeuge, die das öffentliche Informationsumfeld für Millionen beeinflussen.

Hintergrund des Vorfalls

OpenAI hat den Weggang von Beiermeister offiziell als nicht in Zusammenhang mit den geäußerten Politikfragen stehend dargestellt. Das Unternehmen teilte mit, Beiermeister sei in den Monaten vor seinem Austritt beurlaubt gewesen und habe während seiner Amtszeit wertvolle Beiträge geleistet. Gleichwohl nährte die Nähe zwischen interner Kontroverse und Personalentscheidung Spekulationen: Wenn es intern starken Widerstand gegen ein Produktfeature gibt und kurz darauf leitende Personen das Unternehmen verlassen, fragen Beobachter natürlich, ob die Personalentscheidung nicht doch eine Reaktion auf die Meinungsverschiedenheiten gewesen sein könnte.

Der Fall ist deshalb relevant, weil er typische Spannungsfelder moderner KI‑Unternehmen sichtbar macht: technische Machbarkeit, kommerzieller Druck und ethische Verantwortung. Entscheidungen über Inhalte, Moderation und Freischaltung neuer Funktionen haben direkte gesellschaftliche Auswirkungen — etwa auf Minderjährige, gefährdete Gruppen oder Personen, die durch schädliche Inhalte retraumatisiert werden könnten.

Der Streit um den "Erwachsenenmodus"

Was war geplant?

Der vorgeschlagene „Erwachsenenmodus“ sollte nach Berichten eine weniger restriktive ChatGPT-Einstellung sein, die es erwachsenen Nutzerinnen und Nutzern ermöglichen würde, offener über Themen zu sprechen, die in den Standard‑Einstellungen stärker moderiert sind. Befürworter argumentieren, dass eine alters- und kontextgerechte Freischaltung spezifischer Inhalte die Nutzerzufriedenheit steigert und Profi‑Anwendungsfälle erleichtert, etwa in therapeutischen, kreativen oder forschungsbezogenen Kontexten.

Sicherheits- und Ethikbedenken

Kritiker warnten hingegen vor den möglichen Nebenwirkungen: Ein permissiverer Modus könnte Missbrauch erleichtern, etwa durch die Bereitstellung detaillierterer Anleitungen zu schädlichem Verhalten, die Verbreitung von Desinformation oder die sexualisierte Exploitation vulnerabler Personen. Technische Teams und Policy‑Verantwortliche betonen, dass Inhaltsmoderation nicht nur eine Frage der Nutzerpräferenzen, sondern auch der rechtlichen Verantwortung und der Reputation von Unternehmen ist.

Zu den konkreten Risiken gehören:

- Verletzung von Minderjährigenschutz: Selbst bei Altersverifikation sind Fälle möglich, in denen junge Menschen Zugang zu ungeeigneten Inhalten erhalten.

- Missbrauch durch koordinierte Akteure: Offenere Modelle können für automatisierte Angriffe, Social‑Engineering oder gesundheitsschädliche Ratschläge missbraucht werden.

- Schwächerer Vertrauensschutz: Nutzerinnen und Nutzer erwarten, dass Plattformen für sichere Interaktionen sorgen; ein zu großzügiger Modus könnte dieses Vertrauen untergraben.

Beteiligte Rollen und interne Dynamiken

Die Debatte zeigte, wie unterschiedliche Teams in Technologieunternehmen aufeinandertreffen: Produktmanager, die Nutzerwünsche und Wachstumstreiber berücksichtigen; Technik- und Sicherheits‑Teams, die Risiken quantifizieren und technischen Safeguards entwerfen; sowie Policy‑Experten, die langfristige Reputations- und Compliance‑Fragen adressieren. Führungskräfte müssen diese Perspektiven abwägen.

Beiermeisters beruflicher Hintergrund macht seine Rolle in der Debatte plausibel: Seine LinkedIn‑Angaben weisen etwa vier Jahre Tätigkeit im Produktbereich bei Meta und mehr als sieben Jahre bei Palantir aus — eine Kombination aus Produktentwicklung und Erfahrung mit operationalen sowie ethischen Herausforderungen. Dieser Erfahrungsschatz dürfte seine Skepsis gegenüber einem unfiltrierten Chatmodus beeinflusst haben.

Interne Entscheidungsprozesse

In großen Technologieunternehmen laufen Entscheidungen zu sensiblen Funktionen oft in mehreren Schichten ab: initiale Produktideen, technische Machbarkeitsstudien, Risikobewertungen, rechtliche Prüfung, Nutzerforschung und schließlich Management‑Reviews. Meinungsverschiedenheiten sind normal; kritisch wird es, wenn ein Produktjahrplan und Bedenken zur Nutzersicherheit in Konflikt geraten und die institutionellen Mechanismen zur Konfliktlösung unklar oder unzureichend sind.

Regulatorischer Druck und externe Erwartungen

Parallel zu internen Diskussionen wächst der regulatorische Druck: Gesetzgeber in Europa, den USA und anderen Regionen verlangen zunehmend nach überprüfbaren Prozessen zur Risikobewertung von KI‑Systemen, Transparenz über Moderationspraktiken und Schutzmechanismen gegen Missbrauch. Solche Vorschriften können Produktzeitpläne beeinflussen und Unternehmen zwingen, zusätzliche Sicherheitsprüfungen und Compliance‑Layer einzubauen.

Hinzu kommt Erwartungsdruck von Nutzerseite: Einige Nutzer fordern mehr Kontrolle, Anpassbarkeit und weniger Zensur, während andere stärkere Schutzmaßnahmen und verlässliche Moderation verlangen. Unternehmen, die global operieren, müssen zudem regionale Unterschiede in Gesetzgebung und Kultur berücksichtigen, was die Komplexität der Produktfreigabe erhöht.

Technische Ansätze zur Risikominderung

Techniker und Forscher entwickeln eine Palette technischer Maßnahmen, um moderatere Freigaben zu ermöglichen und gleichzeitig Risiken zu reduzieren. Zu den bewährten Ansätzen gehören:

- Mehrstufige Altersverifikation und Kontextprüfung, um sicherzustellen, dass sensible Inhalte nur für erwachsene Nutzer freigeschaltet werden.

- Feinjustierte Moderationsmodelle, die differenzierter zwischen legitimen, potenziell sensiblen und schädlichen Anfragen unterscheiden.

- Human‑in‑the‑loop‑Systeme, bei denen KI‑Entscheidungen durch menschliche Prüfer ergänzt werden, insbesondere bei kritischen oder zweifelhaften Fällen.

- Transparenz‑ und Rückmeldemechanismen, die es Nutzerinnen und Nutzern erlauben, problematische Antworten zu melden und so Modelle iterativ zu verbessern.

Solche Maßnahmen sind jedoch ressourcenintensiv und können den Rollout neuer Funktionen verzögern. Sie zeigen aber auch Wege auf, wie Produktfreiheit und Sicherheit technisch miteinander verbunden werden können.

Auswirkungen auf Vertrauen und Unternehmenskultur

Wenn interne Konflikte öffentlich sichtbar werden, kann das Vertrauen bei Mitarbeitenden, Kundinnen und der Öffentlichkeit leiden. Plötzliche Personalwechsel, gerade in Schlüsselpositionen für Produktpolitik oder Sicherheit, lassen Fragen offen: Wurden fundierte Bedenken ignoriert? Wie werden zukünftige interne Meinungsverschiedenheiten gehandhabt? Transparente Kommunikation und nachvollziehbare Entscheidungsprozesse sind hier entscheidend, um Glaubwürdigkeit zu erhalten.

Unternehmenskultur spielt eine zentrale Rolle: Organisationen, die offene Diskussionen, dokumentierte Entscheidungswege und Schutz für Mitarbeitende, die Risiken benennen, fördern, sind besser gerüstet, um Konflikte konstruktiv zu lösen. Fehlen diese Mechanismen, drohen stille Kompromisse oder eskalierende öffentliche Kontroversen.

Branchenweite Implikationen

Der Fall OpenAI steht nicht isoliert. Andere Technologieunternehmen sehen sich ähnlichen Spannungen gegenüber, wenn Produktteams, rechtliche Abteilungen und Policy‑Verantwortliche unterschiedliche Prioritäten haben. Wie OpenAI diese Situation adressiert, kann branchenweite Signalwirkung haben: einerseits für Praktiken zur Inhaltsmoderation und Produktfreigabe, andererseits für Standards bezüglich Mitarbeiterbeteiligung, Governance und Transparenz.

Ein verantwortlicher Umgang mit solchen Konflikten stärkt die Position eines Unternehmens als vertrauenswürdiger Anbieter. Zugleich kann ein zu straffes oder zu lax reguliertes Vorgehen entweder Innovationskraft hemmen oder Risiken verstärken — beides hat Auswirkungen auf Marktakzeptanz und regulatorische Reaktionen.

Praktische Empfehlungen für Unternehmen

Aus dem Geschehen lassen sich einige generelle Empfehlungen ableiten, die auch andere Organisationen nutzen können:

- Klare Governance‑Prozesse etablieren: dokumentierte Pfade für die Abwägung zwischen Produktanforderungen und Policy‑Bedenken.

- Interdisziplinäre Review‑Boards einsetzen, die technische, rechtliche, ethische und nutzerorientierte Perspektiven integrieren.

- Transparenz nach außen: Erklärungen zu Entscheidungen sollten nachvollziehbar und datenbasiert sein, ohne private Personalangelegenheiten zu verletzen.

- Investitionen in Sicherheitsmechanismen und Nutzerforschung vorantreiben, um Risiken empirisch zu bewerten und Gegenmaßnahmen zu testen.

- Schutz für Mitarbeitende, die Risiken benennen (whistleblowing‑freundliche Prozesse), damit interne Debatten nicht aus Angst vor Repression erstickt werden.

Fazit

Die Auseinandersetzung um Ryan Beiermeisters Abgang und den vorgeschlagenen „Erwachsenenmodus“ bei ChatGPT illustriert die schwierige Balance, die KI‑Unternehmen heute meistern müssen: zwischen Nutzerwünschen, kommerziellem Druck, technischer Machbarkeit und ethischer Verantwortung. Wie OpenAI und andere Firmen solche Konflikte lösen, wird nicht nur einzelne Produkte prägen, sondern auch Standards und Erwartungen der Branche formen.

Solange die genauen Details der Diskriminierungsvorwürfe nicht öffentlich zugänglich sind, bleiben einige Fragen offen. Die breitere Debatte über Inhaltsmoderation, Nutzerkontrolle und operative Transparenz ist jedoch klar: Unternehmen müssen robuste Prozesse etablieren, die technische Innovation ermöglichen, ohne die Sicherheit und das Vertrauen der Nutzer zu gefährden.

Wie OpenAI diese Fragen beantwortet, wird Auswirkungen über das Unternehmen hinaus haben — auf Regulatoren, Nutzergruppen und die Entwicklung ethischer KI‑Standards weltweit.

Quelle: smarti

Kommentar hinterlassen