8 Minuten

Google erweitert Circle to Search mit einem neuen KI‑Modus, der kontextbewusste Antworten direkt auf dem Bildschirm liefert, ohne dass Sie die aktuelle Ansicht verlassen müssen. Die Erweiterung integriert eine "Frag alles"-Suchleiste in das Circle‑Erlebnis und zeigt eine KI‑Zusammenfassung des ausgewählten Elements an — beides ist darauf ausgelegt, die mobile Suche schneller, natürlicher und zielgerichteter zu machen. Dieser Artikel beschreibt die Funktion, ihre praktische Anwendung, technische Aspekte, Kompatibilität sowie Folgen für Nutzer, Entwickler und die mobile Suche insgesamt.

Was der KI‑Modus für Circle to Search bringt

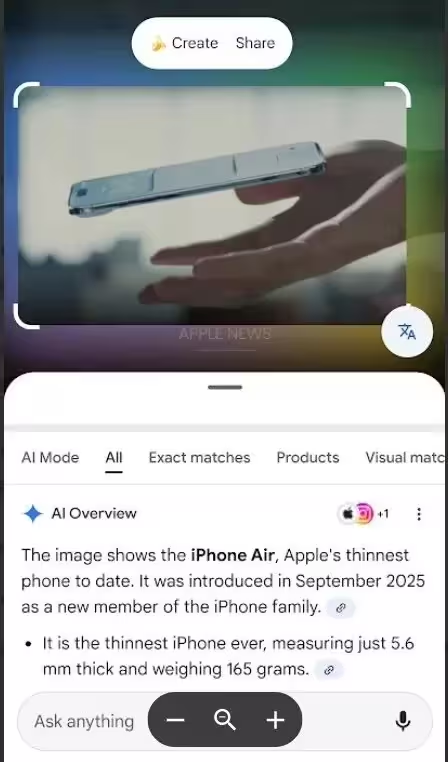

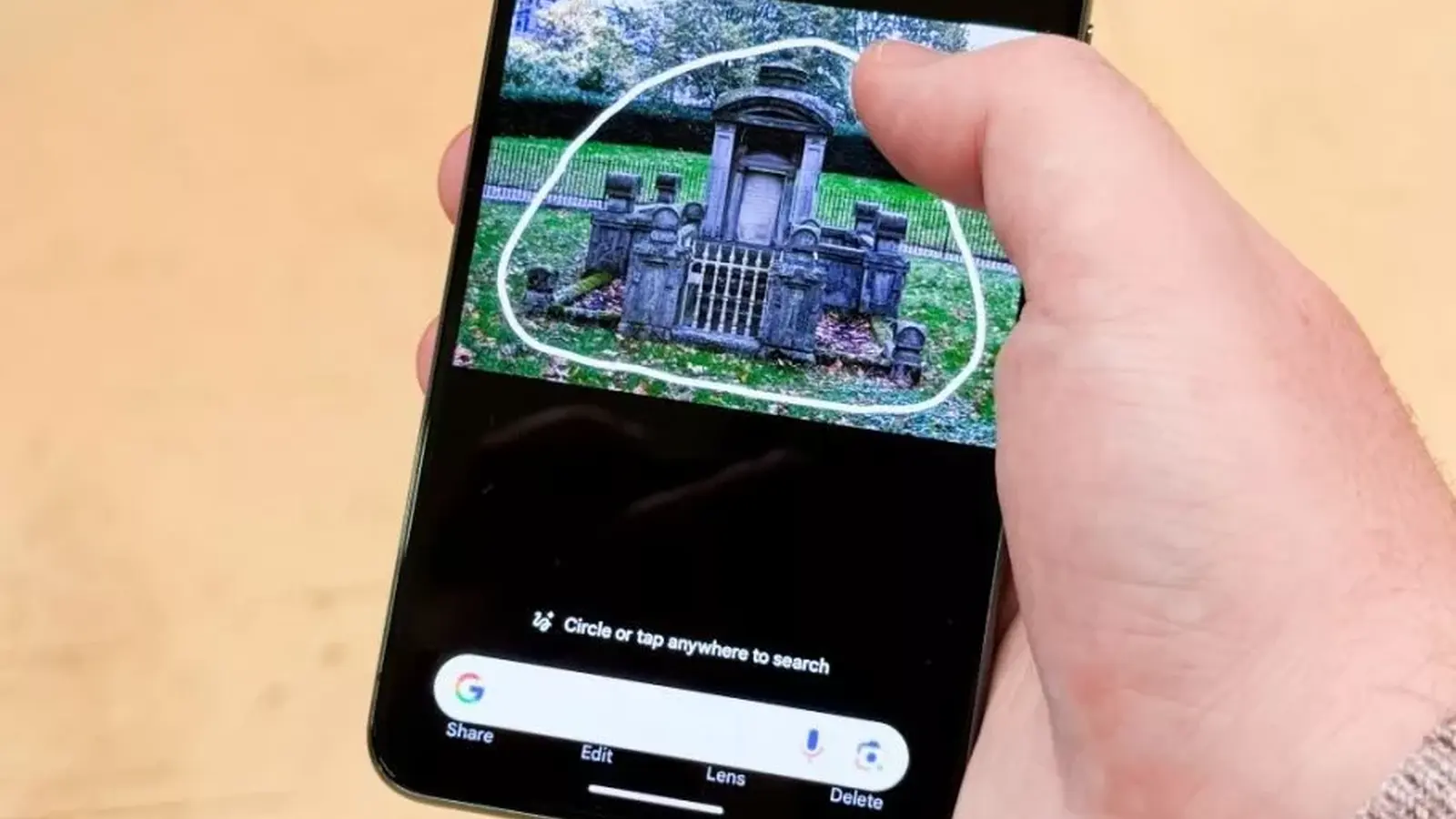

Circle to Search erlaubt es bereits, auf Android einen Kreis um jeden beliebigen Bereich des Bildschirms zu ziehen, um Objekte zu identifizieren oder verwandte Suchergebnisse zu erhalten. Mit dem jüngsten Update, das in der Google App Beta entdeckt wurde, erscheint nach dem Markieren eines Objekts ein KI‑gestütztes Bedienfeld. Dieses Panel enthält eine "KI‑Übersicht", die das ausgewählte Element zusammenfasst, und eine dauerhaft sichtbare "Frag alles"-Leiste am unteren Bildschirmrand für schnelle Folgefragen.

Die KI‑Übersicht fasst relevante Informationen komprimiert zusammen — beispielsweise Produktinformationen, mögliche Identifikation, kurze Pflegehinweise bei Pflanzen oder kontextuelle Hinweise zu gezeigten Texten und Menüs. Die Zusammenfassung basiert auf einer Kombination von visueller Erkennung (Computer Vision) und semantischer Aufarbeitung durch Modellinferenz. Die Auslieferung dieser Informationen erfolgt in Echtzeit oder mit sehr geringer Verzögerung, sodass der Wechsel zwischen Kamera, Suchergebnissen und externen Apps minimiert wird.

Zu den zugrundeliegenden Konzepten gehören Bildanalyse, Entitätszuordnung (Named Entity Recognition), Retrieval‑Techniken für ergänzende Web‑Inhalte und On‑Device vs. Cloud‑Verarbeitung. Google kombiniert in der Regel lokale Vorverarbeitung mit serverseitigen Modellen, um sowohl Latenz als auch Datenschutzanforderungen abzuwägen. Für Nutzer bedeutet das: präzisere, kontextbewusste Antworten direkt im Suchkontext, ohne mehrfaches Kopieren, Wechseln der App oder Ausblenden des Ausgangsbildes.

Zwei praktische Verbesserungen, die Ihnen auffallen werden

- Einhandbedienung: Durch die Verlagerung der Suchleiste an den unteren Bildschirmrand wird das Tippen oder Antippen auf großen Smartphones deutlich komfortabler. Bei vielen modernen Geräten mit großen Displays reduziert diese Platzierung die Notwendigkeit, das Telefon zu verändern oder mit beiden Händen zu arbeiten. Das ist besonders nützlich bei schnellen Suchanfragen unterwegs, beim Shopping oder wenn Sie unterwegs Informationen direkt aus einer App heraus recherchieren möchten.

- Nahtlose Folgefragen: Die neue Oberfläche erlaubt es, Bildresultate einzusehen und unmittelbar weitere KI‑gestützte Fragen zu stellen, ohne die Ansicht zu wechseln. Dadurch bleibt der Kontext erhalten — die zuvor markierte Region bleibt referenziert, sodass die KI Folgefragen verstehen kann, etwa "Wie viel kostet das ähnliches Modell?" oder "Ist das giftig für Haustiere?". Diese Kontextbindung erhöht die Relevanz der Antworten und verringert Frustration durch verlorenen Kontext.

So testen Sie den KI‑Modus heute (Beta)

Die Funktion wurde in der Google App Beta (Version 16.4.7) entdeckt und wird für Nutzer im Android 16 QPR2‑Beta‑Programm ausgerollt. Wenn Sie in diese Betas eingeschrieben sind, können Sie den KI‑Modus wie folgt ausprobieren und bewerten:

- Öffnen Sie die Google App (Beta) auf einem kompatiblen Android‑16‑Gerät.

- Halten Sie die untere Navigationsleiste gedrückt, um Circle to Search zu aktivieren.

- Ziehen Sie einen Kreis um einen Bereich, ein Objekt oder Text auf dem Bildschirm.

- Suchen Sie nach der "KI‑Übersicht" und der "Frag alles"‑Leiste am unteren Rand des Bildschirms.

Wenn die neue Benutzeroberfläche erscheint, können Sie sofort Folgefragen stellen und KI‑generierten Kontext zusammen mit Bildersuchergebnissen sehen. Falls die Oberfläche nicht sichtbar ist, wurde das Update möglicherweise noch nicht an Ihr Gerät verteilt — Google testet und rollt solche Funktionen üblicherweise gestaffelt während der Beta‑Phase aus.

Für ein reproduzierbares Testverfahren empfiehlt es sich, die folgenden Punkte zu beachten: Stellen Sie sicher, dass die Beta‑Version der Google App installiert ist, das Gerät über Android 16 QPR2 verfügt und die Berechtigungen für Bildschirmzugriff bzw. notwendige Zugriffsrechte erteilt sind. In manchen Fällen hängt das Auftauchen der Funktion auch von Gerätemodell, Regionszuweisung oder experimentellen Flags ab, die Google intern steuert. Entwickler und Power‑User können Logdaten und Debug‑Informationen über die Google App‑Beta einsehen, um zu prüfen, ob Calls an KI‑Endpoints gesendet werden und wie die Latenzwerte liegen.

Hinweis zur Stabilität: Beta‑Funktionen können fehlerhaft oder unvollständig integriert sein. Wenn Sie auf Probleme stoßen, dokumentieren Sie das Verhalten, fügen Sie möglichst genaue Schritte zur Reproduktion hinzu und melden Sie dies über das Feedback‑Tool der Google App Beta. Das hilft Google, das Feature vor dem breiten Release zu optimieren.

Warum das für die mobile Suche wichtig ist

Stellen Sie sich vor, Sie fotografieren eine Pflanze, markieren ein Blatt und erhalten sofort sowohl eine Bestimmung als auch Pflegehinweise — ohne zwischen Apps zu wechseln. Das ist das Versprechen des KI‑Modus: schnellere Informationen, weniger Tipp‑ und Navigationsaufwand und konversationelle Folgeinteraktionen, die direkt an Ort und Stelle möglich sind. Für alltägliche Aufgaben — Einkaufen, Hausaufgaben, Reisen oder schnelle Faktenchecks — können solche Verbesserungen Zeit sparen und die Reibung reduzieren.

Aus Nutzersicht ist die größte Veränderung die Verringerung der kognitiven und physischen Hürden beim Abrufen relevanter Informationen. Anstatt einen Screenshot zu erstellen, eine neue Suche zu starten und dann mehrere Tabs zu öffnen, bleibt alles in einer einzigen, kontextgebundenen Oberfläche. Das verbessert die Nutzererfahrung (UX) und erhöht die Wahrscheinlichkeit, dass Anwender häufiger auf visuelle Suchfunktionen zurückgreifen. Für Google bedeutet das auch engere Nutzerbindung und mehr Interaktionssignale, die zur Verbesserung von Ranking‑ und Suggest‑Algorithmen genutzt werden können.

Technisch gesehen ist diese Entwicklung Teil eines größeren Trends: die Verschmelzung von Computer Vision, multimodalen KI‑Modellen und dialogorientierter Suche. Multimodale Modelle können Bild‑ und Textsignale zusammenführen, um präzisere Entitäten zu erkennen und relevante, kondensierte Antworten zu liefern. Für Entwickler öffnet das neue Möglichkeiten: Apps können Circle to Search als Teil von Workflows nutzen, etwa für AR‑Anwendungen, E‑Commerce‑Integrationen oder Bildungswerkzeuge, die visuelle Referenzen benötigen.

Für die Suchmaschinenoptimierung (SEO) und Content‑Strategie bedeutet dies, dass visuell relevante Inhalte und strukturierte Daten noch wichtiger werden. Webseitenbetreiber sollten darauf achten, dass Produktbilder klare Metadaten enthalten, alt‑Texte aussagekräftig sind und strukturierte Daten (Schema.org) zur Verfügung stehen, damit KI‑Modelle und Bildersuche bessere Verknüpfungen herstellen können. Inhalte, die kurze, prägnante Antworten und Kontext bieten — z. B. FAQs, Produktangaben, Pflegehinweise oder sofort nutzbare Anleitungen — gewinnen an Sichtbarkeit in einem Umfeld, in dem Antworten direkt aus der Suchoberfläche heraus präsentiert werden.

Datenschutz und Transparenz bleiben zentrale Themen: Da visuelle Daten sensibel sein können, spielt die Frage eine Rolle, wie Bilder verarbeitet werden (on‑device vs. cloud), wie lange Metadaten gespeichert werden und welche Drittanbieter‑Services beteiligt sind. Google gibt in der Regel Hinweise zur Datenverarbeitung in den Datenschutzhinweisen der App, aber Anwender und Datenschutzbeauftragte sollten genau prüfen, welche Daten an Server gesendet werden und ob diese pseudonymisiert oder aggregiert werden.

Wettbewerbsposition: Google ist mit Circle to Search nicht der einzige Anbieter, der visuelle Suche und KI‑gestützte Kontextfunktionen entwickelt. Andere Plattformen und App‑Entwickler integrieren ähnliche Funktionen, oft mit unterschiedlichen Schwerpunkten — etwa stärker lokale On‑Device‑Modelle, Offlinesupport oder spezielle E‑Commerce‑Integrationen. Der Vorteil von Googles Ansatz liegt im Ökosystem: tiefe Integration in bestehende Dienste (Search, Shopping, Maps) und Zugang zu umfangreichen Wissensquellen, was die Qualität und Abdeckung der Resultate oft erhöht. Trotzdem können spezialisierte Anbieter durch bessere Datenschutzoptionen oder Fokusfeatures punkten.

Langfristig zu erwartende Entwicklungen umfassen: bessere Personalisierung der Antworten basierend auf Nutzervorlieben, erweiterte Unterstützung für komplexe multimodale Abfragen (z. B. "Vergleiche dieses Produkt mit ähnlichen in meiner Nähe"), engere Verzahnung mit AR‑Funktionen und neue Monetarisierungsformen für Händler, die direkt in visuelle Suchergebnisse integriert werden. Für Unternehmen bedeutet das, sich frühzeitig auf visuelle Auffindbarkeit vorzubereiten und ihre Inhalte für multimodale Abfragen zu optimieren.

Insgesamt zeigt die Einführung des KI‑Modus in Circle to Search, wie sich mobile Suche in Richtung schnellerer, kontextbewussterer und dialogorientierter Interaktionen entwickelt. Nutzer profitieren von weniger Reibung und prägnanteren Antworten, während Entwickler und SEO‑Strategen neue Anforderungen und Chancen erkennen müssen — insbesondere in Bezug auf visuelle Inhalte, strukturierte Daten und Datenschutz.

Quelle: smarti

Kommentar hinterlassen