9 Minuten

Einführung

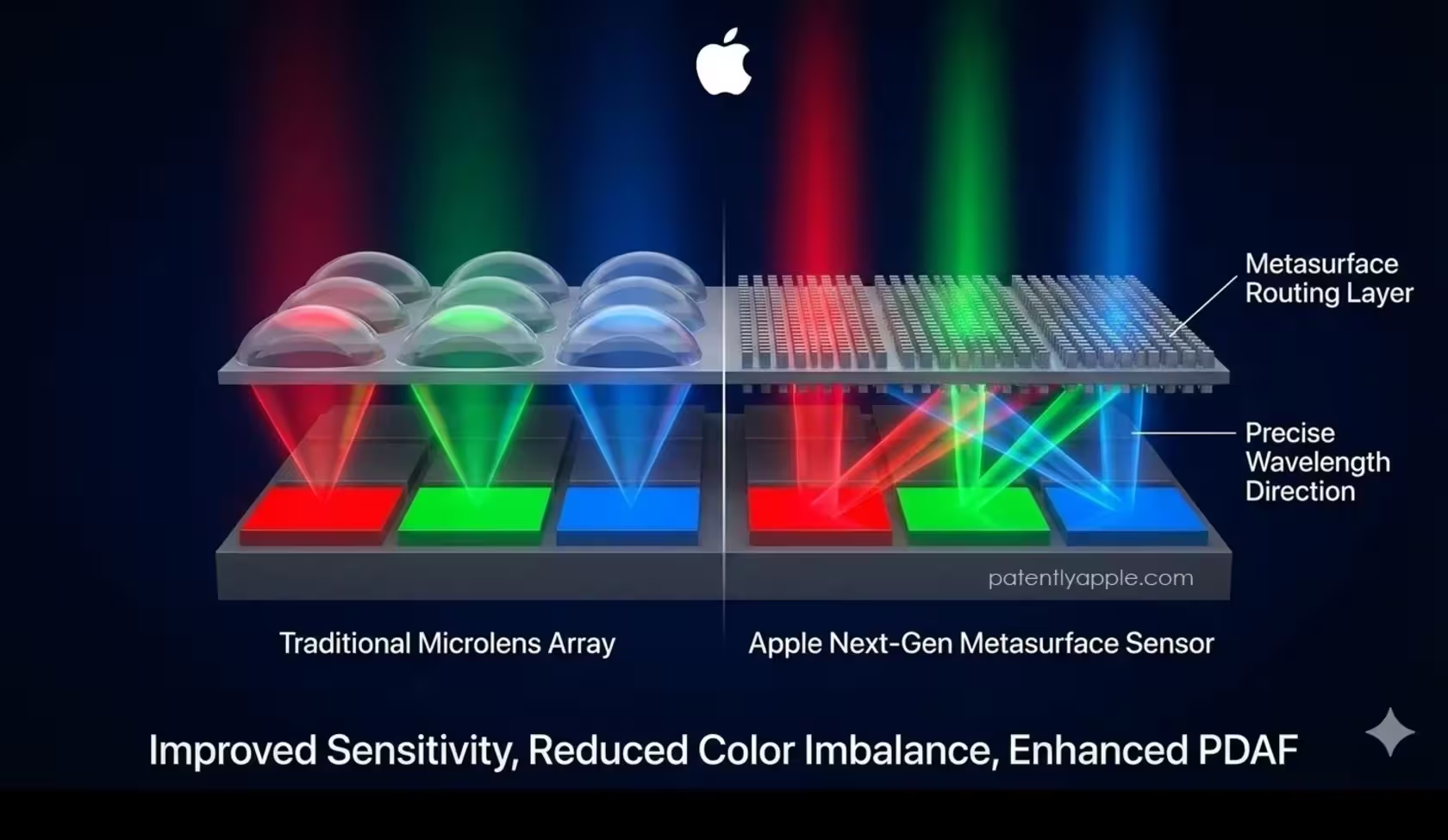

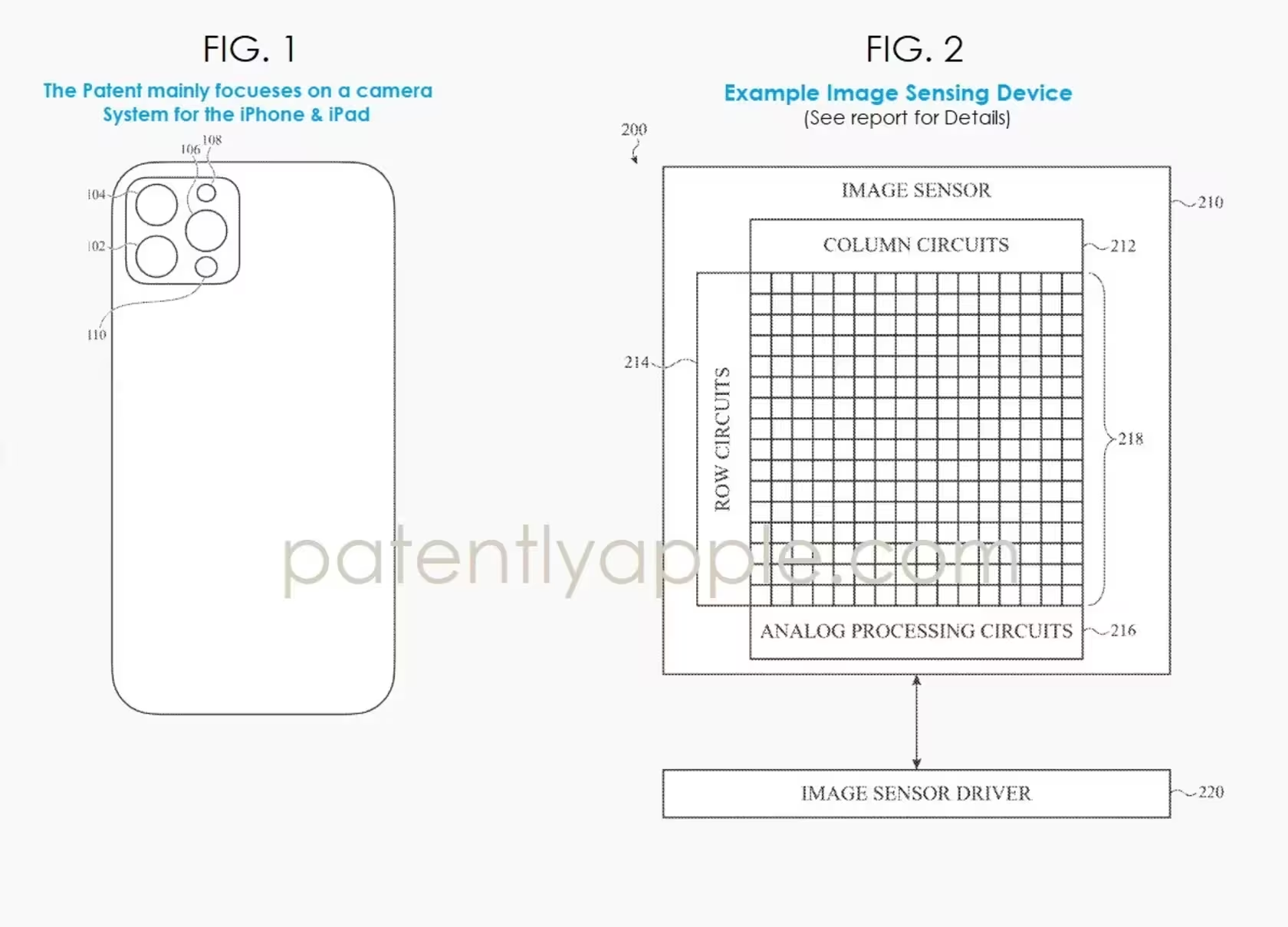

Vielleicht tragen Sie bald eine Kamera bei sich, die Licht lenkt, statt sich auf Türme winziger Glaslinsen zu verlassen. Apple erforscht offenbar stillschweigend einen Neuentwurf von Bildsensoren, bei dem herkömmliche Mikrolinsen durch eine gezielt entwickelte optische Schicht ersetzt werden, die als Metafläche (Metasurface) bezeichnet wird.

Wie eine Metafläche funktioniert

Stellen Sie sich den Sensor als dreistufiges Sandwich vor: ganz unten die Pixelschicht, in der Mitte ein Farbfilter und obenauf eine nur wenige Nanometer bis Mikrometer dünne Metafläche. Diese Metafläche ist keine Linse im klassischen Sinn; sie ist ein Geflecht aus Nanostrukturen, die verschiedene Wellenlängen mit chirurgischer Präzision zu bestimmten Pixeln dirigieren. Das Ergebnis ist eine selektive Weiterleitung von Rot-, Grün- und Blauanteilen, selbst wenn sich die Lichtwege überlappen.

Technisch basiert die Metafläche auf subwellenlängigen Strukturen — also Elementen, deren Abmessungen kleiner sind als die betreffende Lichtwellenlänge. Durch Variation von Form, Größe und Anordnung dieser Nanopfeiler oder -grate lassen sich Phasen, Amplitude und Polarisation des einfallenden Lichts lokal steuern. So lassen sich Beugungs- und Interferenzeffekte nutzen, um Licht gezielt auf die darunterliegenden Fotodioden zu lenken.

Warum das wichtig ist

Warum spielt das eine Rolle? Weil es Apple ermöglicht, die Empfindlichkeit je Farbe gezielt anzupassen. Rot- und Blau-Pixel — die typischerweise weniger Photonen einfangen — können mehr Fläche der Metafläche zugewiesen bekommen, um mehr Licht zu sammeln, während Grün-Pixel kleiner und damit detailreicher bleiben können. Das Design schafft ein ausgewogenes Verhältnis zwischen Sensitivität und Detaildarstellung, das mit traditionellen Mikrolinsen schwer oder gar nicht erreichbar ist.

In konventionellen Bildsensoren sorgen Mikrolinsen dafür, dass Licht möglichst effizient in die Fotodiode eines Pixels gelenkt wird. Diese Mikrolinsen sind jedoch in ihrer Struktur homogen: sie optimieren nicht effizient unterschiedlich für die einzelnen Farbkanäle. Eine Metafläche hingegen arbeitet kanalselektiv und kann so photonische Effizienz, Farbwiedergabe und Schärfe gleichzeitig verbessern.

Hauptvorteile für Bildqualität und Autofokus

Dieser Ansatz verspricht hellere Aufnahmen bei schlechten Lichtverhältnissen, unverfälschtere Farbbalance und einen schnelleren Phasendetektions-Autofokus ohne dickere Kameraerhebungen.

Insbesondere der Phasendetektions-Autofokus (PDAF) kann direkt in die Metafläche integriert werden. Das bedeutet: Fokus wird schneller und verlässlicher, ohne an Pixeldichte einzubüßen oder die Modulhöhe zu erhöhen. Einfacher ausgedrückt: besserer Autofokus, gerade in dunklen Szenen, ohne die üblichen Hardwarekompromisse.

Wenn die Metafläche Per-Pixel- oder Per-Cluster-Phaseninformation liefern kann, lassen sich Fokussensorik und Bildaufnahme enger verzahnen. Das reduziert Latenz und erhöht die Treffsicherheit bei bewegten Motiven oder bei schlechten Lichtverhältnissen. Anders als bei separaten PDAF-Pixeln, die Platz kosten oder die nutzbare Pixelmatrix fragmentieren, könnte die Metafläche phasenrelevante Informationen liefern, ohne dedizierte Pixel zu opfern.

Farbempfindlichkeit und Pixel-Design

Ein weiterer Gewinn liegt in der Möglichkeit, Sensitivität pro Farbkanal zu balancieren. Die typische Bayer-Anordnung (RGGB) im Farbfilter-Array ist ein Kompromiss: Grün hat zwei Pixel, Rot und Blau je eines. Mit einer Metafläche lässt sich diese asymmetrische Photonennutzung optimieren, indem die Lichtlenkung so eingestellt wird, dass Rot- und Blau-Pixel effizienter arbeiten. Das verbessert Signal-Rausch-Verhältnis und dynamischen Bereich, ohne die physische Pixelgröße drastisch zu ändern.

Auswirkungen auf Produktdesign und Multikamera-Systeme

Über die reine Bildqualität hinaus eröffnen Metaflächen neue Möglichkeiten für schlankere Multi-Kamera-Layouts und dünnere Geräte. Diese Vielseitigkeit ist relevant für Apples gesamte Produktpalette — von iPhones und iPads bis hin zu Macs und sogar Wearables — weil das Unternehmen die Bildleistung steigern kann, ohne die Produkte dicker oder weniger tragbar zu machen.

Geringere Modulhöhe bedeutet weniger hervorstehende Kamerabuckel, eine glattere Rückseite und potenziell neue Designoptionen für Gehäuse und Kühlung. Für Multi-Kamera-Systeme lässt sich die Anzahl der optisch nötigen Linsenstufen reduzieren, und die Anordnung der Sensoren kann flexibler gestaltet werden — das eröffnet Chancen für größere Brennweitenabstände, kompaktere Tele-module oder effizientere Weitwinkelkonfigurationen.

Praktische Vorteile: Weniger Software, mehr Optik

Es gibt auch praktische Vorteile. Mit besserer nativer Farbtrennung auf Sensorebene benötigen Bilder weniger harte softwareseitige Korrekturen. Weniger rechnerische Nachbesserung bedeutet treuere Aufnahmen. Das ist ein bedeutsamer Wandel; die „Magie“ verschiebt sich wieder mehr in die Optik und weg von softwareseitigen Flickschustereien.

In vielen modernen Smartphones übernimmt Computational Photography zahlreiche Aufgaben: Rauschunterdrückung, Farbkorrektur, Deblurring, HDR-Combining und Lokalanpassungen. Wenn der Sensor schon eine bessere Rohtrennung von Farben und eine höhere Photonenausbeute liefert, reduziert das die Abhängigkeit von komplexen Algorithmen und kann zu natürlicheren Tonwerten, weniger Artefakten und insgesamt konsistenteren Ergebnissen führen — insbesondere in Szenarien mit wenig Licht oder hohem Dynamikumfang.

Technische Herausforderungen und Herstellbarkeit

Natürlich ist es noch ein weiter Weg von Laborprototypen zu massenproduzierbaren Bauteilen. Die Fertigung von Metaflächen mit extrem hoher Präzision und reproduzierbarer Performance über große Wafer ist technisch anspruchsvoll. Nanopatterning, Lithographie-genauigkeit, Materialstabilität und Toleranzen beim Aufbringen auf empfindliche Sensor-Stacks sind alles kritische Punkte.

Zudem müssen Metaflächen robust gegenüber Umwelteinflüssen, Temperaturschwankungen und mechanischer Beanspruchung sein. Langzeitstabilität, Ausbeute in der Massenfertigung und Kosten pro Einheit sind Faktoren, die entscheiden, ob eine solche Technologie wirtschaftlich in Millionen Geräten eingesetzt werden kann.

Fertigungsverfahren

Hersteller forschen an verschiedenen Herstellverfahren: Elektronenstrahllithographie für Prototypen, Nanoimprint-Lithographie (NIL) für größere Stückzahlen, und Kombinationen aus dünnen dielektrischen Schichten oder hochindex-Elementen. Die Wahl des Materials beeinflusst Transmissionseigenschaften, Absorption und Wärmeverhalten — alles relevant für Sensorleistung und Zuverlässigkeit.

Kompatibilität mit bestehenden Sensoren

Ein weiterer Punkt ist die Kompatibilität mit bestehenden CMOS-Bildsensor-Technologien. Die Metafläche muss präzise ausgerichtet und stabil mit Farbpixeln und Microlens-Alternativen zusammenarbeiten. Für Hersteller wie Apple, die zunehmend eigene Sensor-Designs und enge Integration mit Software betreiben, ist die Kontrolle über Design, Fertigung und Kalibrierung ein Wettbewerbsvorteil — aber auch eine Herausforderung hinsichtlich Lieferkette und Partnerintegration.

Sicherheits- und Patentlage

Apple hat in der Vergangenheit immer wieder Patente zu innovativen Sensorkonzepten angemeldet. Metaflächen sind Gegenstand intensiver Forschung und zahlreicher Patentanmeldungen weltweit. Während Patente alleine nicht garantieren, dass eine Technologie Apples nächste Produkte dominieren, zeigen sie doch die strategische Bedeutung, die das Unternehmen dem Thema beimisst.

Die Patentlandschaft kann außerdem Einfluss auf Partnerwahl und Zuliefererbeziehungen haben: Firmen müssen Lizenzen, Fertigungsrechte und geistiges Eigentum klären, bevor sie eine neue Sensortechnologie in großem Stil einführen können.

Auswirkungen auf die Fotografie und Wettbewerbsposition

Wenn Apple — oder ein anderer Hersteller — die Metaflächenintegration erfolgreich skaliert, könnte das die Spielregeln der Smartphone-Fotografie ändern. Höhere native Bildqualität bedeutet, dass Hersteller weniger aggressive softwareseitige Eingriffe benötigen, um überzeugende Ergebnisse zu erzielen. Das erhöht die Glaubwürdigkeit von Fotos „straight out of camera“ und reduziert Situationen, in denen Computational Photography Artefakte erzeugt.

Wettbewerbstechnisch könnte eine robuste Metaflächen-Implementierung Apple einen Vorsprung verschaffen: bessere Low-Light-Performance, kompaktere Formfaktoren und schnellerer Autofokus sind klare Verkaufsargumente. Gleichzeitig werden andere Hersteller diese Technologie verfolgen oder alternative Lösungen entwickeln — etwa verbesserte Mikrolinsen, neue Pixelarchitekturen oder hybride optisch-elektronische Systeme.

Integration mit Computational Photography

Wichtig ist: Metaflächen ersetzen nicht zwangsläufig Computational Photography, sie ergänzen sie. Ein besserer Rohsensor ermöglicht bessere Ausgangsdaten für Algorithmen — die dann mit weniger „Feuerwehrarbeit" optimieren müssen. Funktionen wie Smart HDR, Deep Fusion oder multi-frame Rauschunterdrückung gewinnen an Präzision, weil die Eingangsdaten sauberer und farbgetreuer sind.

Außerdem könnten Metaflächen neue Arten von Rohdaten liefern — etwa phasenbezogene Informationen oder kanalselektive Lichtverteilungen — die Software-Algorithmen nutzen können, um Tiefeninformation, bessere Rauschmodelle oder gezielte Schärfenachverarbeitung zu ermöglichen.

Zeithorizont und Realismus

Es ist noch früh — viele der heute sichtbaren Patente und Forschungsarbeiten sind Proofs-of-Concept. Die Serienreife hängt von technischen Durchbrüchen in Materialien, Fertigungsprozessen und Qualitätssicherung ab. Wenn Apple diese Hürden meistert, könnten erste Produkte mit Metaflächen innerhalb mehrerer Produktzyklen erscheinen; aber ein sofortiger flächendeckender Ersatz bestehender Sensoren ist unwahrscheinlich.

Bei technologischen Umwälzungen gilt: Prototypen zeigen Machbarkeit, aber Skalierung, Kosten und Integration entscheiden über Marktreife. Apple hat in der Vergangenheit komplexe Technologien (z. B. LiDAR, integrierte Neural Engines) schrittweise eingeführt — eine ähnliche, schrittweise Integration wäre auch hier realistisch.

Fazit

Apple bewegt sich mit dem Konzept der Metaflächen-Bildsensoren in eine Richtung, die physikalische Grenzen heutiger Mobilkameras überwinden könnte. Gelingt die Umsetzung, würde die nächste Generation von Apple-Kameras wie ein neues Regelwerk für Smartphone-Fotografie wirken: bessere Low-Light-Fähigkeiten, treuere Farben, schnellerer Autofokus und schlankere Geräte ohne die herkömmlichen Hardwarekompromisse.

Behalten Sie die Hardware-Entwicklungen im Blick — denn die Art und Weise, wie Licht gelenkt wird, gewinnt noch mehr an Bedeutung. Die Integration von Metaflächen in Bildsensoren wäre kein rein theoretischer Fortschritt, sondern könnte die Balance zwischen Optik, Sensorik und Software nachhaltig neu justieren.

Schlüsselbegriffe und weiterführende Themen

- Metafläche (Metasurface) und Nanostruktur-Optik

- Kamerasensor, CMOS-Bildsensor, Pixel-Architektur

- Mikrolinsen vs. Metaflächen

- Phasendetektions-Autofokus (PDAF) auf Sensorebene

- Bayer-Filter, Farbfilter-Array und Farbrekonstruktion

- Fertigung: Nanoimprint-Lithographie, Elektronenstrahl-Lithographie

- Computational Photography: Synergie zwischen Optik und Software

Weiterführende Hinweise

Für Leser, die tiefer in die Materie einsteigen möchten, lohnen sich Veröffentlichungen zu Metasurfaces in Fachzeitschriften zur Optik und Photonik sowie Patentanmeldungen großer Technologiekonzerne. Dort finden sich Details zu Designprinzipien, Materialwahl und Fertigungsverfahren. Auch Konferenzbeiträge von SPIE, OSA und IEEE behandeln die neuesten Fortschritte im Bereich Nanophotonik und sensorintegrierte Optiken.

Quelle: smarti

Kommentar hinterlassen