8 Minuten

Einführung

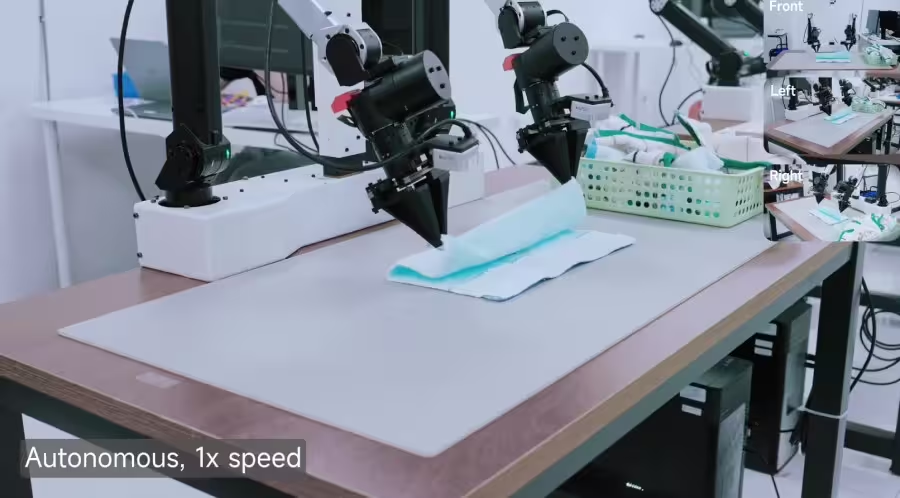

Ein Handtuch, gefaltet, als hätte es ein vorsichtiger Mensch gegriffen. Bausteine, sorgfältig zerlegt, mit ruhigen Händen. Kleine Leistungen vielleicht, aber aufschlussreiche. Xiaomis neues Modell Robotics-0 ist kein glänzendes Konsumgerät; es ist ein Versuch, Maschinen beizubringen, wie man sieht, versteht und sich mit derselben Feinheit bewegt, die wir lange der menschlichen Intuition zugeschrieben haben.

Das zentrale Ziel: Wahrnehmung, Entscheidung, Ausführung

Im Kern versucht Robotics-0, die Schleife zu schließen, die jeden leistungsfähigen Roboter definiert: Wahrnehmung, Entscheidung, Ausführung. Das Unternehmen fasst das unter dem Begriff „physische Intelligenz“ zusammen — eine knappe Formulierung, die einen Stapel schwieriger Probleme verbirgt. Wie hält man ein System gleichzeitig scharf in Sprach- und Bildverstehen und trainiert es daneben auf Millimeter-genaue Bewegungen? Xiaomis Antwort ist eine Architektur, die das Denken vom Bewegen trennt.

Architekturüberblick

Die Lösung teilt sich in zwei Seiten: ein visuelles Sprachmodell und einen Aktions-Experten. Diese Aufgabentrennung ist nicht nur eine technische Spielerei, sondern adressiert ein zentrales Problem in der Roboter-KI: Monolithische Modelle tendieren dazu, Kompromisse einzugehen — werden sie auf Aktion trainiert, verlieren sie mitunter Schärfe im Reasoning, bleiben sie perfekt im Reasoning, fehlt ihnen die Präzision in der Bewegung. Xiaomi verfolgt stattdessen einen Mixture-of-Transformers-Ansatz, bei dem Zuständigkeiten verteilt werden.

Visuelles Sprachmodell (Visual Language Model)

Auf der einen Seite steht das Visual Language Model — denken Sie an es als Dolmetscher des Roboters. Es verarbeitet hochauflösende Kamerabilder und menschliche Anweisungen, auch die vagen: „Bitte falte das Handtuch.“ Es übernimmt Objekterkennung, räumliche Beziehungen, visuelle Frage-Antwort-Aufgaben und die Art von Commonsense-Reasoning, das Pixel in Aufgaben übersetzt. Dieses Modul ist verantwortlich dafür, relevante Objekte zu finden, ihre Positionen und Orientierungen einzuschätzen und Absichten aus ungenauen Befehlen zu extrahieren.

Aktions-Experte (Action Expert)

Auf der anderen Seite steht der Aktions-Experte: ein Diffusion Transformer, der nicht ein einziges Motor-Kommando ausspuckt, sondern eine «Action Chunk» — eine kurze Sequenz koordinierter Bewegungen. Praktisch bedeutet das flüssigere Übergänge und weniger ruckartige Korrekturen. Anstatt einzelne Zielzustände zu proklamieren, erzeugt der Aktions-Experte ganze Bewegungssnippets, die glatt hintereinander ausgeführt werden können.

Warum die Aufteilung wirkt

Die Ingenieursentscheidung hinter dieser Aufteilung wird als Mixture-of-Transformers-Architektur bezeichnet. Zuständigkeiten werden aufgeteilt statt in ein monolithisches Modell gepresst. Das hilft, ein bekanntes Problem zu adressieren: Sobald man ein Vision-Language-Modell darauf trainiert, Aktionen auszuführen, kann es einen Teil seiner Reasoning-Fähigkeiten einbüßen. Um das zu vermeiden, co-trainiert Xiaomi auf multimodalen Daten und Aktions-Trajektorien, sodass das Modell seinen Kopf behält, während es lernt, seine „Hände“ zu bewegen.

Training und Lernphasen

Das Training erfolgt gestuft. Zunächst gibt es einen Action-Proposal-Schritt, in dem das visuelle Modell Verteilungen über plausible Aktionen vorhersagt, während es ein Bild analysiert. Das schafft eine Ausrichtung zwischen internen Repräsentationen von Sehen und Tun. Danach wird der visuelle Teil eingefroren; er dient als stabiler Wahrnehmungs- und Reasoning-Kern.

Im nächsten Schritt trainiert der Diffusion Transformer, um Aktionssequenzen zu entrauschen — er wandelt verrauschte Vermutungen in ausführbare Bewegungen um. Dieser Prozess wird durch Key-Value-Features gesteuert, nicht durch diskrete Sprachtoken. Dadurch bleibt die Aktionsgenerierung dicht an kontinuierlichen sensorischen Merkmalen und ist weniger abhängig von symbolischer Repräsentation.

Technische Details zum Diffusion-Training

Diffusionsmodelle lernen, Rauschen schrittweise zu entfernen und so aus einer verrauschten Initialsequenz eine plausible Trajektorie zu rekonstruieren. Im Kontext von Robotics-0 bedeutet das, dass der Aktions-Transformator mit stochastischen Trajektorien und ihren Korrekturen trainiert wird. Solche Modelle können robuste, glatte Bewegungen erzeugen, die weniger anfällig für einzelne Fehlvorhersagen sind. Gesteuert werden sie durch visuelle Features und kontextuelle Informationen, wodurch Kollisionen und unstimmige Bewegungen reduziert werden.

Latenz und praktische Reibungen

Echte Roboter zeigen zudem praktische Reibungen. Latenz ist eine davon. Wenn das Modell innehält, um zu „denken“, bleibt der Roboter oft stehen oder wankt. Xiaomi begegnet diesem Problem mit asynchroner Inferenz: Berechnung und Hardware laufen halbunabhängig, sodass die Bewegung kontinuierlich bleibt, auch wenn das Modell noch rechnet. Außerdem werden früher vorhergesagte Aktionen zurück in das System gespeist — ein „Clean Action Prefix“ —, das hilft, Zittern zu dämpfen und den Schwung aufrechtzuerhalten.

Eine weitere praktische Maßnahme ist eine Attention-Maske in Form eines Lambda (Λ), die das System dazu drängt, aktuelle visuelle Hinweise gegenüber veralteter Historie zu bevorzugen. Das verbessert die Reaktionsfähigkeit bei plötzlichen Änderungen, weil neue Sensordaten stärker gewichtet werden und alte Kontexte nur begrenzt Einfluss behalten.

Benchmarks und reale Tests

Benchmarks erzählen einen Teil der Geschichte. Xiaomi meldet Spitzenwerte über Simulationen wie LIBERO, CALVIN und SimplerEnv und übertrifft damit etwa 30 Vergleichssysteme. Zahlen sind wichtig, doch reale Tests zählen mindestens genauso viel. Auf einer Doppelarmplattform meisterte Robotics-0 Langzeitaufgaben wie Handtuchfalten und das Zerlegen von Bausteinen. Dabei zeigte es stabile Hand-Auge-Koordination und hantierte sowohl mit starren als auch mit flexiblen Objekten, ohne offensichtliche katastrophale Ausfallmodi.

Leistung in Simulation vs. Realität

Der Sprung von der Simulation in die reale Welt bleibt eine Kernherausforderung: Sim-to-Real-Transfer verlangt robuste Wahrnehmung gegenüber Sensorausfall, Domänenverschiebungen und variabler Beleuchtung. Xiaomis Ansatz versucht, diese Kluft zu verkleinern, indem multimodale reale Daten in das Training einfließen und durch das Co-Training auf Trajektorien die Bewegungssteuerung realitätsnäher gemacht wird. Dennoch braucht es zusätzliche Domain-Randomization, Datenaugmentation und fein abgestimmte Kalibrierung der Steuerungs-Loop, um in heterogenen Umgebungen zuverlässig zu funktionieren.

Open Source und Forschungsökosystem

Ein weiterer praktischer Punkt: Xiaomi veröffentlicht Robotics-0 als Open Source. Das ist wichtig für die Forschungsgeschwindigkeit. Wenn Teams Code inspizieren, Experimente replizieren und aufeinander aufbauen können, beschleunigt sich der Fortschritt. Erwarten Sie Folgeartikel, Forks und wahrscheinlich schnelle Iterationen, die dieselben VLA-Ideen (Vision-Language-Action) auf unterschiedliche Hardware anwenden.

Open Source fördert zudem Transparenz: Forschende können Evaluationsprotokolle, Datensplits und Hyperparameter prüfen und so besser vergleichen. Für die Industrie bedeutet das zudem, dass Prototypen schneller entstehen und Innovationszyklen kürzer werden.

Wirtschaftliche und ethische Überlegungen

Die Freigabe eines solchen Systems wirft aber auch Fragen auf: Wer haftet bei fehlerhaften Manipulationen im Haushalt? Wie werden Sicherheitsmechanismen standardisiert, wenn verschiedene Teams auf denselben Code aufbauen? Xiaomis Open-Source-Ansatz dürfte diese Debatten beschleunigen, weil er die Technologie einem größeren Publikum zugänglich macht. Gleichzeitig wird ein gemeinsamer Kodex für sichere Ausführung, Hardware-Grenzwerte und Nutzungsrichtlinien dringlicher.

Limitierungen und offene Herausforderungen

Robotics-0 löst nicht alle Probleme. Die Manipulation weicher Objekte, die Generalisierung auf stark unterschiedliche Umgebungen und die vollständige Autonomie bleiben offene Herausforderungen. Weiche, deformierbare Gegenstände bringen komplexe, hochdimensionale Zustandsräume mit sich: Tücher, Kleidung oder Lebensmittel verändern kontinuierlich Form und Materialeigenschaften und erfordern oft taktile Rückkopplung und modellbasierte Vorhersagen.

Weitere offene Punkte:

- Robustheit gegenüber unvorhergesehenen Störungen in der Umgebung, z. B. herumliegende Gegenstände oder sich bewegende Personen.

- Skalierbarkeit auf verschiedene Robotertypen und Greiferdesigns, ohne jedes Mal umfassend neu zu trainieren.

- Dateneffizienz beim Erlernen neuer Aufgaben, damit das System nicht für jede neue Tätigkeit extrem große Datensätze benötigt.

Technische Implikationen und Empfehlungen

Robotics-0 deutet auf eine pragmatische Richtung: Wahrnehmung und Aktion eng auszurichten, ohne dass die eine den anderen kannibalisiert. Architekturauswahl kann dabei so viel bewirken wie die schiere Größe eines Modells. Für Entwickler und Forscher bedeutet das:

- Modulare Architekturen evaluieren: Trennung von Wahrnehmungs- und Aktionsmodulen kann Stabilität und Interpretierbarkeit erhöhen.

- Co-Training nutzen: Gemeinsames Training von multimodalen Repräsentationen und Trajektorien hilft, semantisches Verständnis und motorische Präzision zu verbinden.

- Asynchrone Inferenz und Rückkopplungsschleifen implementieren, um Latenzprobleme und ruckartiges Verhalten zu vermeiden.

Wettbewerbspositionierung und Forschungswert

Im Wettbewerb hebt sich Robotics-0 durch seine Kombination aus einem starken visuellen Sprachmodell, einem diffusionsbasierten Aktionsgenerator und pragmatischen Laufzeitlösungen ab. Die Open-Source-Verfügbarkeit dürfte außerdem dazu führen, dass die Methode schnell von der Community geprüft, erweitert und auf neue Hardwareportfolios übertragen wird. Für Forschungsgruppen ist das ein klares Signal: Architekturentscheidungen und Inferenz-Engineering zählen heute genauso stark wie Rohleistungszahlen auf Benchmarks.

Ausblick

Wenn Sie verfolgen, wohin sich die Roboterwelt als Nächstes bewegt, beobachten Sie genau, wie sich dieses Modell außerhalb der Xiaomi-Labore verhält und welche Teile die Community übernimmt und verfeinert. Erwarten Sie Weiterentwicklungen in folgenden Bereichen:

- Besserer Sim-to-Real-Transfer durch datengetriebene Domänenanpassung.

- Integration von Tastsensorik und haptischem Feedback zur Manipulation weicher Objekte.

- Leichtere Adaptionsmechanismen, damit ein trainiertes Modell schneller auf neue Greifer und Umgebungen übertragen werden kann.

Fazit

Robotics-0 ist kein Allheilmittel, aber ein bedeutender Schritt hin zu Robotern mit echter physischer Intelligenz. Die Trennung von Sehen und Tun, kombiniert mit Diffusions-basierten Aktionssequenzen und asynchroner Inferenz, zeigt eine pragmatische Strategie: Wahrnehmung und Aktion eng ausrichten, ohne dass das eine das andere verschlingt. Das könnte genau die Richtung sein, in der praktische, verlässliche Haushalts- und Industrie-Roboter in den kommenden Jahren vorankommen.

Wenn das nächste Mal ein Haushaltsroboter Ihr Handtuch faltet, könnten Sie in jeder glatten Falte die Spur von Robotics-0 erkennen.

Quelle: gizmochina

Kommentar hinterlassen