7 Minuten

Zusammenfassung

Das Forschungsteam von Apple stellte eine einfache, aber beunruhigende Frage: Was erwarten reale Menschen tatsächlich von KI‑Agenten, wenn diese bei Alltagsaufgaben helfen? Die Antwort ist nicht übersichtlich. Sie ist komplex, menschlich und voller Abwägungen.

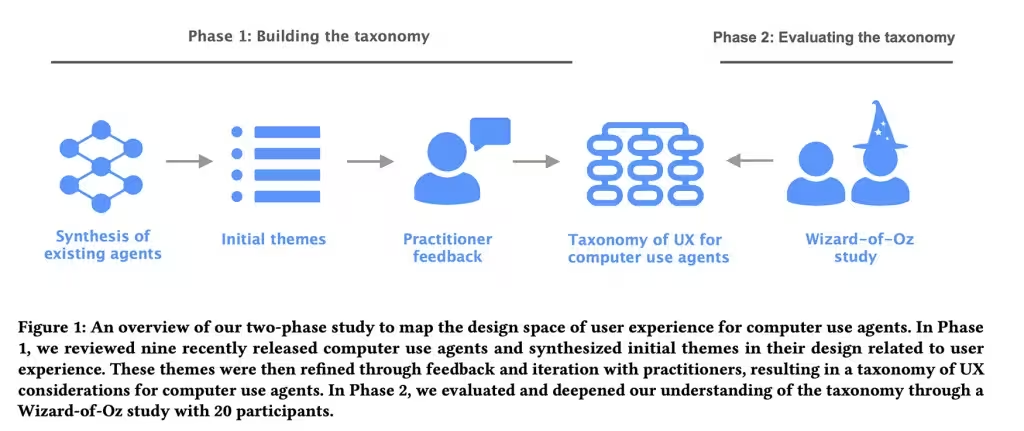

Studie und Katalogisierung

In einer Arbeit mit dem Titel Mapping the Design Space of User Experience for Computer Use Agents analysierten Forscher neun bestehende Agenten — Namen wie Claude Computer Use Tool, Adept, OpenAI Operator, AIlice, Magentic-UI, UI-TARS, Project Mariner, TaxyAI und AutoGLM — um abzubilden, wie diese Systeme Fähigkeiten präsentieren, Fehler handhaben und Benutzerkontrolle ermöglichen. Die erste Phase war beobachtend und klassifizierend: Acht UX‑ und KI‑Spezialisten verdichteten die Landschaft in vier Kernkategorien, 21 Unterkategorien und 55 konkrete Designmerkmale. Diese reichten von der Art, wie Nutzer Eingaben an den Agenten übermitteln, über die Transparenz der Aktionen des Agenten bis hin zur Frage, welche Kontrolle der Nutzer behält und wie mentale Modelle und Erwartungen geformt werden.

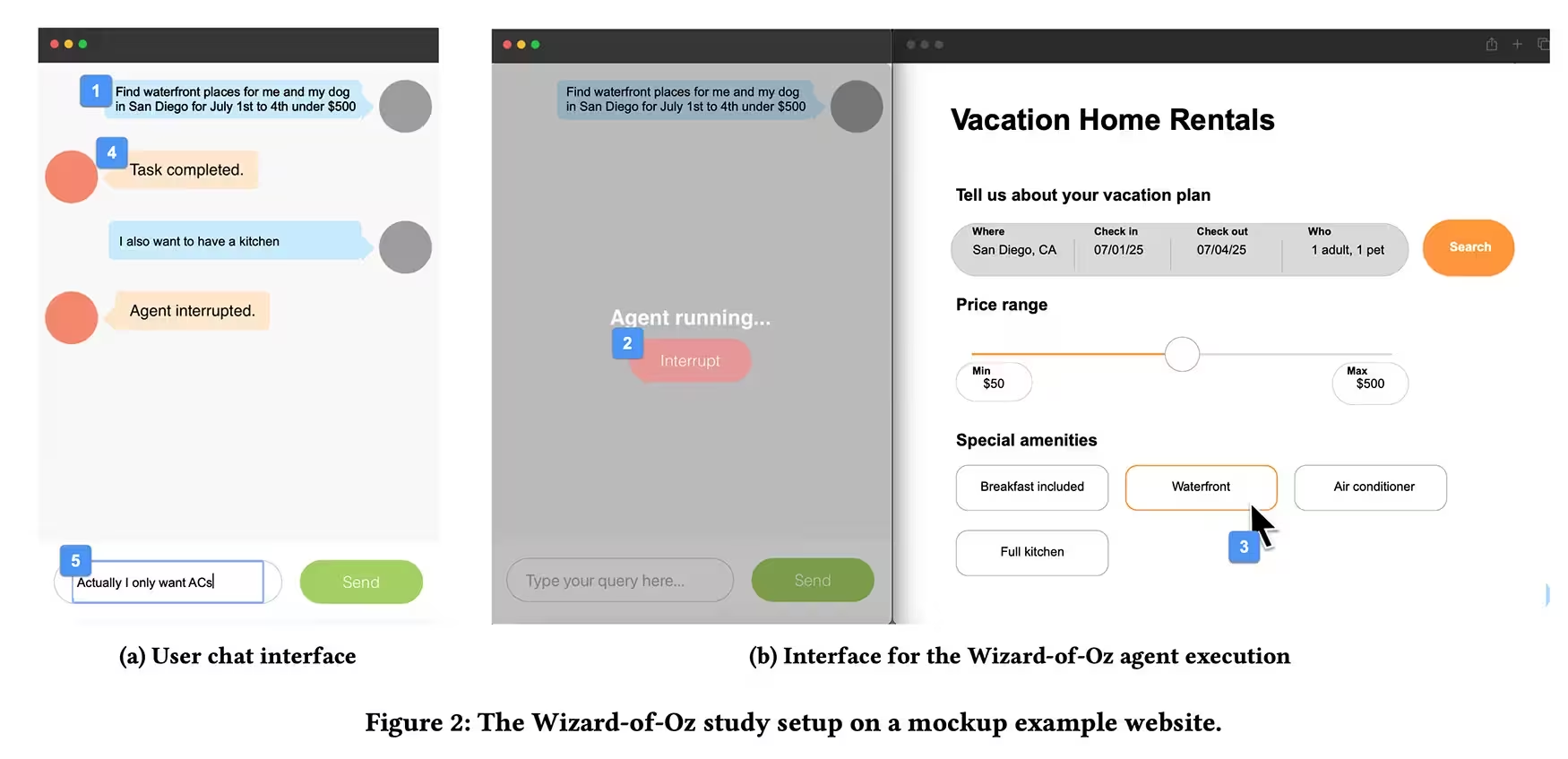

Wizard‑of‑Oz‑Experiment

Anschließend führte das Team ein Wizard‑of‑Oz‑Experiment durch. Zwanzig Teilnehmer mit vorheriger Erfahrung im Umgang mit KI‑Assistenten sollten Aufgaben delegieren — etwa einen Urlaub buchen oder etwas online kaufen — über eine chatähnliche Oberfläche, während ein Forschender außer Sicht den Agenten per Tastatur und Maus tatsächlich steuerte. Die Teilnehmer konnten Befehle eintippen und eine Stopp‑Taste drücken, um den Agenten zu unterbrechen. Einige Aufgaben wurden bewusst mit Fehlern oder unerwarteten Unterbrechungen sabotiert, um zu beobachten, wie Menschen reagieren, wenn der Agent einen Fehler macht oder Annahmen trifft.

Versuchsaufbau und Teilnehmerprofil

Die Auswahl der Testpersonen zielte darauf ab, verschiedene Erfahrungsniveaus mit digitalen Assistenten abzubilden: von relativen Neulingen bis zu erfahrenen Power‑Usern. Die Aufgaben wurden so gewählt, dass sie reale Risiken beinhalteten (z. B. bezahlte Transaktionen oder Kontoeinstellungen), damit die Studie Aufschluss darüber geben konnte, wie Vertrauen, Kontrolle und Transparenz in Situationen mit greifbaren Folgen zusammenspielen. Die Forschenden protokollierten nicht nur Erfolg oder Misserfolg, sondern auch Unterbrechungsmuster, Nachfragen der Nutzer und nonverbales Verhalten, wenn möglich.

Beobachtete Muster und Nutzererwartungen

Es zeigte sich ein klares Muster: Menschen wollen Einblick darin, was ein Agent gerade tut, aber sie möchten nicht jeden Klick mikromanagen. Kurze Demonstrationen und gelegentliche Bestätigungen beruhigen die Nutzer. Totales Schweigen seitens des Agenten schürt Misstrauen. Plötzliche Automatisierung ohne Erklärung bewirkt dasselbe. Anfänger sehnen sich nach Schritt‑für‑Schritt‑Erklärungen und weichen Kontrollpunkten, wenn Handlungen greifbare Konsequenzen haben — Käufe, Änderungen an Konten, alles, was nicht mit einem Achselzucken ungeschehen gemacht werden kann. Experten dagegen bevorzugen, dass der Agent mehr wie ein vertrauter Kollege und weniger wie ein übervorsichtiger Assistent handelt.

Vertrauen als zerbrechliches Gut

Vertrauen, so zeigt die Studie, verhält sich wie Glas: zerbrechlich und schnell zu beschädigen. Versteckte Annahmen oder kleine Fehler verringern das Vertrauen schneller, als reibungslose Leistungen es aufbauen. Wenn ein Agent vom erwarteten Ablauf abweicht oder mit Mehrdeutigkeit konfrontiert ist, zogen Teilnehmer es vor, dass er pausiert und eine Rückfrage stellt, anstatt zu raten und zu handeln. Diese Präferenz hielt auch dann an, wenn zusätzliche Bestätigungen als leicht lästig empfunden wurden — besser sicher als nachsichtig, schienen die Nutzer zu sagen.

Gestalten Sie KI‑Agenten so, dass sie Transparenz und Kontrolle sowohl an die Aufgabe als auch an die Erfahrung des Nutzers anpassen.

Praktische Implikationen für Design und Produktentwicklung

Für Designer und App‑Entwickler sind die Schlussfolgerungen praktisch: Bauen Sie Schnittstellen, die Absicht und Fortschritt zeigen, erlauben Sie Nutzern, Aktionen leicht zu stoppen oder zu korrigieren, und justieren Sie, wie viel Erklärung Sie je nach Risikograd der Aufgabe und Vertrautheit des Nutzers einblenden. Das Papier liefert ein anwendbares Rahmenwerk — kein theoretisches Tapetenmuster — um diese Entscheidungen zu formen: vier Kategorien und dutzende von Eigenschaften, die Sie testen, iterieren und gegen reales Nutzerverhalten messen können.

Designmuster, die sich bewährt haben

- Progress‑Indikatoren mit kurzen, verständlichen Beschreibungen der nächsten Schritte.

- Soft‑Checkpoints vor irreversiblen Aktionen (z. B. „Bestätigen & bezahlen?“) statt plötzlicher Durchführung.

- Kurze Vorschauen auf vorgeschlagene Aktionen, damit Nutzer Annahmen korrigieren können.

- Optionale Detailebenen: ein kompakter Modus für Experten, ein ausführlicher Modus für Neulinge.

- Einfache Undo‑Funktionen und sichtbare Audit‑Logs für kritische Änderungen.

Technische und UX‑Details zur Umsetzung

Die Umsetzung dieser Muster erfordert ein Zusammenspiel aus Modellverhalten, UI‑Design und produktspezifischen Sicherheitsmechanismen. Technisch bedeutet das:

- Explizite Aktionsrepräsentation: Jedes automatische Vorgehen wird als geplante Aktion modelliert und in einer nutzerlesbaren Form dargestellt.

- Kontextsensitives Prompting: Der Agent wählt Erklärungsstärke und Bestätigungsfrequenz basierend auf dem Aufgabenkontext und dem Nutzerprofil.

- Fehler‑ und Ambiguitätsmanagement: Wenn die Unsicherheit des Agenten über einem Schwellenwert liegt, wird automatisch eine Rückfrage ausgelöst.

- Interaktionsprotokolle: Aktionen werden mit Zeitstempel, Quelle der Entscheidung (Modell vs. Nutzer) und relevanten Parametern protokolliert, um Nachvollziehbarkeit zu gewährleisten.

Aus Sicht der User Experience ist es wichtig, mentale Modelle zu formen: Nutzer sollten verstehen, welche Arten von Entscheidungen der Agent treffen kann, welche Risiken bestehen und wie leicht Fehler korrigierbar sind. Das reduziert Überraschungseffekte und schafft eine Grundlage für Vertrauen.

Vertrauen wiederherstellen und Fehler handhaben

Weil Vertrauen so leicht zu erschüttern ist, sollten Systeme spezielle Strategien zur Wiederherstellung implementieren. Gute Praktiken umfassen:

- Schnelle, transparente Fehlerkommunikation mit konkreten Schritten zur Behebung.

- Konsequente Rückfragen bei Mehrdeutigkeit, anstatt zu raten.

- Kontrollierbare Rückroll‑Mechanismen für kritische Aktionen.

- Detaillierte, aber zugängliche Erklärungen zu Entscheidungen, wenn Nutzer danach fragen.

Solche Maßnahmen reduzieren das Risiko von Vertrauensverlust nach Fehlern und geben Nutzern Werkzeuge an die Hand, um die Verantwortung zu teilen und zu korrigieren.

Empfehlungen für Produktteams

Auf Basis der Studienergebnisse lassen sich konkrete Empfehlungen für Produktteams ableiten. Diese sind sowohl strategisch als auch operativ relevant:

Strategisch

- Segmentieren Sie Nutzer nach Erfahrung und passen Sie Interaktionen dynamisch an.

- Priorisieren Sie transparente Aktionen für Aufgaben mit hohen Konsequenzen (Finanzen, Sicherheit, Kontodaten).

- Validieren Sie Designannahmen in iterativen Tests mit echten Nutzern, inklusive sabotierter Szenarien, um Robustheit zu prüfen.

Operativ

- Implementieren Sie leicht erreichbare Stop‑ und Undo‑Buttons.

- Bieten Sie klare visuelle Hinweise auf laufende Prozesse und deren Status.

- Erstellen Sie modulare Erklärungs‑Komponenten, die je nach Kontext ein‑ oder ausgeblendet werden können.

Abwägungen und Grenzen

Die Studie zeigt, dass es keinen einheitlichen Ansatz gibt: Jede Designentscheidung ist ein Kompromiss zwischen Bedienkomfort und Kontrollbedürfnis. Zu viel Transparenz kann Informationsüberflutung provozieren; zu wenig Transparenz lässt Nutzer misstrauisch werden. Die richtige Balance hängt von Nutzerkompetenz, Aufgabenkonsequenzen und Produktzielen ab. Deshalb ist kontinuierliches Nutzerforschungstesting essenziell.

Fazit

Es geht nicht nur um intelligentere Modelle. Es geht um intelligentere Interaktionen. Kurzfristig werden kleine Entscheidungen — eine Bestätigung hier, ein sichtbarer Schritt dort, eine rechtzeitige Pause, wenn der Agent zögert — entscheiden, ob Menschen der Automatisierung vertrauen oder sie abschalten. Das Design von KI‑Agenten muss daher adaptiv, erklärbar und kontrollierbar sein, um echten, nachhaltigen Nutzen zu liefern.

Die Studie von Apple und ihr methodischer Ansatz liefern ein praxisnahes Raster für Produktteams, die KI‑Agenten entwickeln: Kategorien, Features und testbare Hypothesen, mit denen sich echtes Nutzerverhalten messen und verbessern lässt. Wer diese Erkenntnisse nutzt, baut nicht nur technisch bessere Modelle — sondern Interaktionen, denen Menschen eher vertrauen und die ihnen tatsächlich im Alltag helfen.

Quelle: smarti

Kommentar hinterlassen