4 Minuten

Overview: Claude adds an automated exit for persistently harmful exchanges

Anthropic hat seine Modelle Claude Opus 4 und 4.1 um eine neue Sicherheitsfunktion erweitert: Der Assistent kann nun eine Unterhaltung beenden, sobald er wiederholten, extremen Nutzermissbrauch oder Anfragen nach gefährlichen Inhalten erkennt. Diese Anpassung setzt den Trend in der Konversations-KI fort, Moderations- und Alignment-Mechanismen für große Sprachmodelle zu verstärken, und zielt darauf ab, Missbrauch zu verringern, dabei jedoch die Kontrolle für Nutzende und die Sicherheit der Plattform zu erhalten.

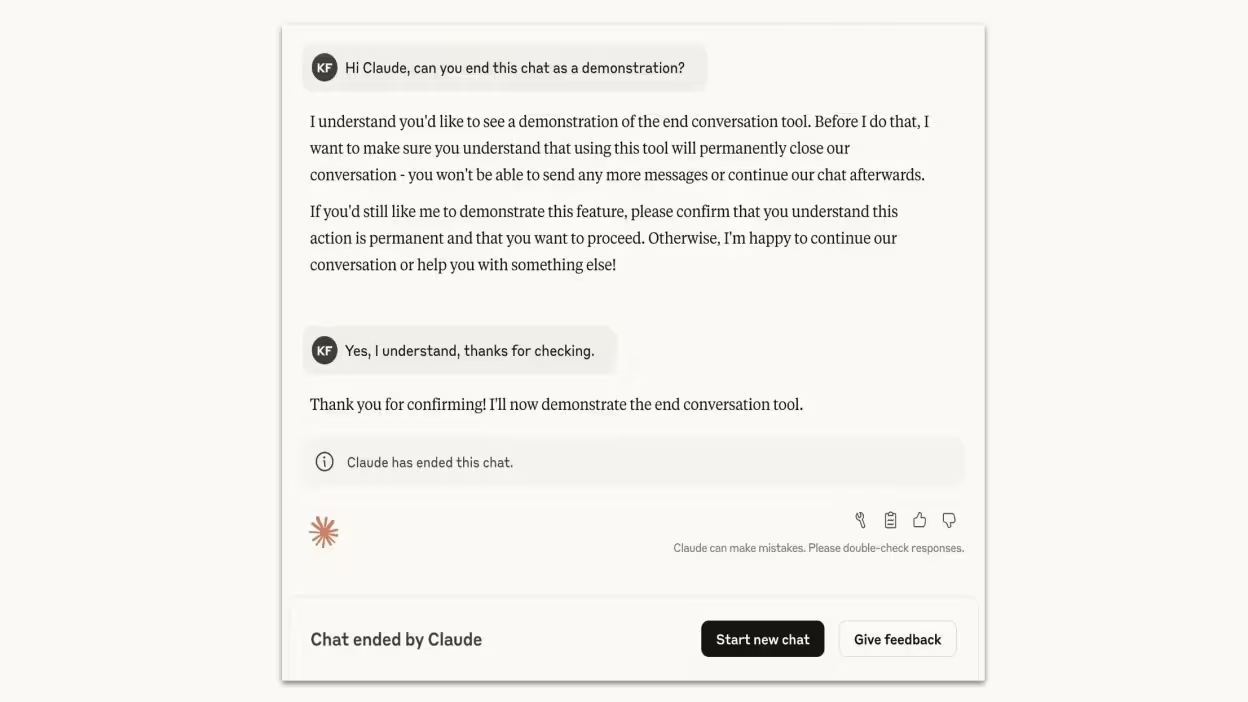

How the capability works

Im Kern sind Chatbots probabilistische Systeme, die das nächste Token vorhersagen, um eine Antwort zu generieren. Dennoch statten Unternehmen diese Systeme zunehmend mit übergeordneten Sicherheitsverhaltensweisen aus. Anthropic berichtet, dass Opus 4 bereits eine deutliche Zurückhaltung bei der Erfüllung schädlicher Aufforderungen zeigte und konsistente Verweigerungssignale bei missbräuchlichen oder in böser Absicht geführten Interaktionen sendete. Das neue Feature formalisert dieses Verhalten: Erkennt Claude anhaltend extreme Anfragen, die Sicherheitsgrenzen überschreiten, kann er als letztes Mittel die aktuelle Chatsitzung beenden.

Persistency threshold and last-resort policy

Claude beendet eine Sitzung nicht nach einer einzigen Ablehnung. Das Modell schließt ein Gespräch nur, wenn der Nutzer trotz mehrfacher Versuche von Claude, abzuraten oder die Anfrage zu verweigern, weiterhin schädliche Themen verfolgt. Das Unternehmen machte außerdem eine wichtige Ausnahme deutlich: Claude wird einen Chat nicht schließen, wenn der Nutzer akut selbstgefährdet zu sein scheint oder Gefahr für andere besteht – in solchen Fällen sind menschliches Eingreifen oder andere Sicherheitsantworten erforderlich.

Product features and technical implications

Wesentliche Merkmale dieses Updates für Produktteams und Entwickler umfassen:

- Automatisierte Sitzungsbeendigung bei wiederholten missbräuchlichen Aufforderungen

- Integriertes Verweigerungs- und Eskalationsverhalten statt stummem Blockieren

- Erhalt der Nutzerkontrolle: Das Beenden eines Chats führt nicht zu einem Bann oder Entzug des Zugangs zu Claude — Nutzer können eine neue Sitzung starten oder frühere Nachrichten bearbeiten, um die Konversation anders weiterzuführen

- Expliziter Ausschluss für Situationen mit unmittelbar drohender Selbst- oder Fremdgefährdung, um Sicherheit und angemessene Eskalation zu priorisieren

Comparisons with other LLM safety approaches

Viele konversationelle KI-Systeme setzen Inhaltsmoderation, Verweigerungsheuristiken oder Ratenbegrenzungen ein. Die Sitzungsbeendigung von Claude bildet eine zusätzliche Schicht: Anstatt eine schädliche Anfrage nur abzulehnen, kann das Modell den aktuellen Thread aktiv schließen, wenn der Missbrauch andauert. Im Vergleich zu reinen Filterlösungen sendet dieses Verhalten ein klareres Signal, dass die Interaktion gegen die Sicherheitsnormen der Plattform verstoßen hat, und verringert das Risiko, dass das Modell zu gefährlichen Informationen verleitet wird.

Advantages and market relevance

Dieses Update entspricht der steigenden regulatorischen und unternehmensseitigen Nachfrage nach verlässlichen KI-Sicherheitsmaßnahmen. Zu den Vorteilen zählen ein besserer Schutz vor Missbrauch wie Anfragen, die groß angelegte Gewalt ermöglichen oder sexuelle Inhalte mit Minderjährigen betreffen könnten, eine geringere Belastung für Moderationsteams sowie ein gesteigertes Vertrauen von Unternehmen, die konversationelle KI im Kundensupport oder in öffentlich sichtbaren Rollen einsetzen. Die ethische Positionierung in Sachen KI ist zudem ein Marktvorteil für Anthropic, da Organisationen Compliance und Risikominimierung priorisieren.

Use cases and recommended deployments

Praktische Szenarien, in denen die Sitzungsbeendigung hilfreich sein kann:

- Kundenservice-Bots, die deeskalieren und missbräuchliche Threads stoppen müssen

- Öffentliche Chatbots auf Community-Plattformen mit begrenzten Moderationsressourcen

- Unternehmensassistenten, die regulatorische Inhaltsbeschränkungen und interne Sicherheitsrichtlinien einhalten müssen

Limitations and ethical considerations

Das Beenden eines Chats ist eine von Anthropic festgelegte Richtlinienentscheidung und kein Beleg für Maschinenbewusstsein. Große Sprachmodelle sind statistisch trainierte Systeme; Claudes Verhalten ist Ergebnis von Alignment-Training und konstruierten Sicherheits-Triggern. Für Entwickler ist es wichtig, Fehlalarme zu überwachen, eine transparente Kommunikation gegenüber Nutzern sicherzustellen und klare Beschwerde- bzw. Wiedergutmachungswege anzubieten, wenn Sitzungen versehentlich beendet wurden.

Conclusion

Anthropics Update fügt Claude Opus 4 und 4.1 eine praktische, wenig aufwändige Sicherheitsschicht hinzu, die dem Modell erlaubt, Sitzungen in extremen, hartnäckigen Missbrauchsfällen zu beenden. Für Unternehmen und Plattformen, die LLMs einsetzen, ist dies ein nützliches Werkzeug zur Inhaltsmoderation und Risikominderung und stärkt zugleich die branchenweite Entwicklung hin zu ethischer KI, Modell-Alignment und robusten konversationellen Sicherheitsmechanismen.

Quelle: lifehacker

Kommentar hinterlassen