4 Minuten

Samsung positioniert sich als bedeutender Speicherlieferant für Nvidias nächste Generation von KI-Servern und hat angekündigt, etwa die Hälfte der neuen SOCAMM2-DRAM-Module zu liefern, die Nvidia 2026 benötigen wird. Dieser Schritt folgt auf ein Jahr intensiver Optimierung bei Samsungs High-End-DRAM- und HBM-Entwicklungen, in dem das Unternehmen an Ausbeuten, Performance und Integrationsqualität gearbeitet hat, um den Anforderungen von Hyperscale-Datenzentren und AI-Workloads gerecht zu werden.

Warum Samsungs SOCAMM2-Erfolg wichtig ist

Nachdem Samsung im Vorjahr bei einem großen Teil des KI-Speicherbooms nicht in vollen Umfang zum Zuge gekommen war, hat das Unternehmen seine Ausbeuten und die Leistungsfähigkeit seiner fortschrittlichen DRAM-Fertigungslinien deutlich verbessert. Diese Optimierungen betreffen sowohl die Waferproduktion als auch das Chip-Design, Testverfahren und Packaging-Qualität, wodurch die Produktion skalierbarer und wirtschaftlicher wird. Samsung hat bereits HBM4-Muster an Nvidia für die abschließende Validierung ausgeliefert und bestätigt nun gleichzeitig seine Pläne, rund 50 % der Small Outline Compression Attached Memory Module 2 (SOCAMM2) bereitzustellen, die Nvidia im kommenden Jahr voraussichtlich einsetzen wird. Diese Ankündigung signalisiert eine stärkere Marktposition und stärkt Samsungs Rolle im Ökosystem von KI-Infrastruktur und High-Bandwidth-Speicherlösungen.

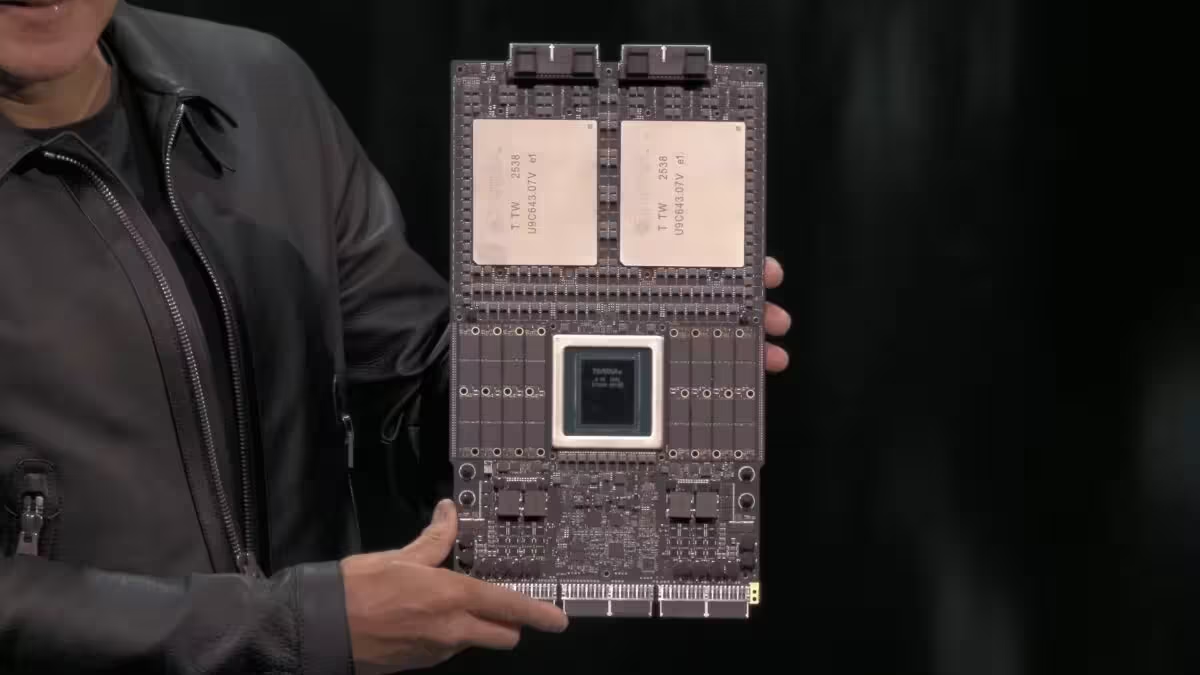

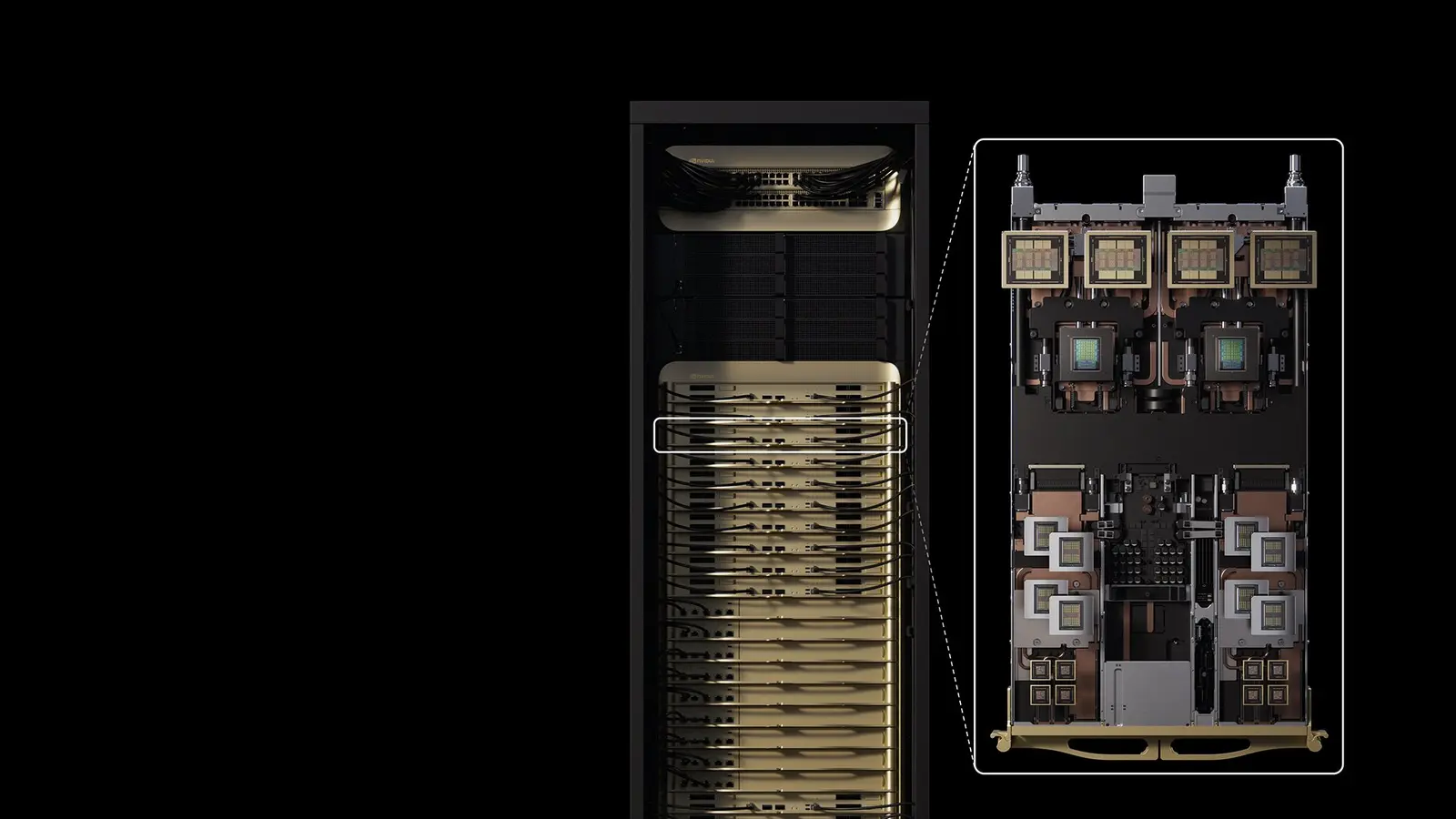

SOCAMM2 ist im Kern ein dichteres, für Server optimiertes Speichermodul, das mehrere LPDDR-Chips auf einem einzigen Substrat zusammenführt. Durch die Konsolidierung verschiedener Speicherbausteine auf einer gemeinsamen Trägerplatte vereinfacht SOCAMM2 Upgrades, reduziert die Integrationskomplexität am Server-Motherboard und verbessert die Speicherdichte pro Rack-Unit in AI-Rechenzentren. Für AI-Workloads ist eine Kombination aus hoher Bandbreite, geringer Latenz und kompakter Bauform entscheidend: SOCAMM2 adressiert diese Anforderungen, indem es mehrere LPDDR5X-Die effizient miteinander verbindet und so einen hohen Datendurchsatz bei vergleichsweise niedrigem Platzbedarf ermöglicht. Nvidias Vera-Plattformen platzieren beispielsweise mehrere SOCAMM2-Module neben der Vera-CPU, um die Rubin-GPUs kontinuierlich mit hoher Bandbreite zu versorgen und Engpässe beim Datentransfer zu vermeiden.

In diesem Jahr war Micron beim SOCAMM-Start führend, doch Samsung hat zusammen mit SK Hynix deutlich aufgeholt. Samsung berichtet, die Ausbeuten bei seinen fünften Generation 1c DRAM-Chips stabilisiert zu haben — jene 1c-DRAM-Generationen gelten als zentrale Bausteine für SOCAMM2-Module. Stabilere Ausbeuten bedeuten weniger Ausschuss, verlässlichere Lieferketten und eine bessere Planbarkeit bei Fertigungsvolumen. Technologisch beruht diese Verbesserung auf feinjustierten Lithografie-Schritten, optimierten Prozesskontrollen und einem robusteren Testing nach der Waferfertigung. Dank dieser Maßnahmen kann Samsung die Produktion hochskalieren, ohne die Qualitätsanforderungen moderner KI-Server zu gefährden, und sich so als strategischer Partner für große Abnehmer wie Nvidia positionieren.

Skalierung und Versorgung: die Zahlen

Laut Berichten hat Nvidia die Speicherindustrie gefragt, bis zu 20 Milliarden Gigabyte (GB) an SOCAMM-Modulen zu liefern — eine Größenordnung, die die Kapazitätsplanung der Hersteller über Jahre hinweg beeinflusst. Unter den aktuellen Vereinbarungen würde Samsung etwa die Hälfte dieser Kapazität bereitstellen, also rund 10 Milliarden GB. Um dieses Volumen zu erreichen, schätzt Samsung den Bedarf auf etwa 830 Millionen 24Gb LPDDR5X-DRAM-Chips. Diese Menge entspricht einem Waferbedarf von schätzungsweise 30.000 bis 40.000 Wafern pro Monat, je nachdem, wie viele funktionale Dies pro Wafer erzielt werden und welche Ausbeutegrade realistisch sind. In relativen Zahlen entspricht das etwa 5 % von Samsungs gesamter monatlicher DRAM-Waferproduktion, eine signifikante, aber bewältigbare Belastung für einen der größten Speicherhersteller der Welt.

Die Rechnung hinter den Zahlen lässt sich wie folgt grob nachvollziehen: Ein 24Gb-Die trägt zur Gesamtkapazität eines SOCAMM2-Moduls bei, und je nach Bestückungsdichte eines Moduls werden mehrere Dies kombiniert, um die gewünschte Kapazität und Bandbreite zu erzielen. Die Umrechnung von Chips in Gigabyte und von Dies in Wafer hängt von Faktoren wie Die-Größe, Yield, Packaging-Verlusten und Testing-Raten ab. Samsung hat öffentlich genannt, dass für die geplante Liefermenge von rund 10 Milliarden GB circa 830 Millionen 24Gb-DRAM-Chips nötig wären; dies ist eine konservative Schätzung, die schwankende Ausbeuten und mögliche Design-Varianten berücksichtigt.

Micron und SK Hynix werden voraussichtlich den verbleibenden Bedarf an SOCAMM2-Modulen decken. Für Samsung kann der Gewinn großer SOCAMM2-Aufträge neben möglichen HBM4-Bestellungen bedeuten, dass Umsatz und Ergebnissignifikant zulegen, wenn sich die Ausgaben für KI-Infrastruktur beschleunigen. Gleichzeitig wirkt sich diese erhöhte Nachfrage auf die gesamte Speicherlieferkette aus: Rohmaterialbeschaffung, Substratproduktion, Advanced-Packaging-Kapazitäten, Testinfrastruktur und Logistik müssen koordiniert werden. Marktpreise, Verfügbarkeit und Leadzeiten werden 2026 stark von der Balance zwischen Nachfrage (vor allem durch AI-Server-Deployments) und dem Ausbau der Produktionskapazitäten durch die großen Hersteller abhängen.

Was ist als Nächstes zu erwarten? Eine breitere Einführung von SOCAMM2 in KI-Servern ist wahrscheinlich, sobald die Lieferanten ihre Kapazitäten hochfahren und die Validierungszyklen abgeschlossen sind. Wesentlich ist auch Samsungs HBM4-Validierungsprozess mit Nvidia: Sollten HBM4-Produkte die Tests erfolgreich bestehen, könnten sie ergänzend oder alternativ zu SOCAMM2 eingesetzt werden, je nach den Anforderungen an Bandbreite, Energieeffizienz und Systemarchitektur. Beide Entwicklungen — die SOCAMM2-Skalierung und die HBM4-Validierung — werden 2026 die Speicherlieferketten, Preisgestaltung und Architekturentscheidungen in Rechenzentren spürbar beeinflussen.

Quelle: sammobile

Kommentar hinterlassen