8 Minuten

Neue Forschung deutet darauf hin, dass es beim Folgen eines Gesprächs in einem lauten Raum nicht nur auf die Ohren ankommt, sondern maßgeblich darauf, wie das Gehirn Schall verarbeitet. Eine aktuelle Studie unter Leitung der University of Washington verbindet geringere kognitive Fähigkeiten mit größeren Schwierigkeiten, Sprache vor Hintergrundlärm zu verstehen — selbst wenn konventionelle Hörtests unauffällig sind. Die Ergebnisse werfen Licht auf zentrale Aspekte der Sprachwahrnehmung, der zentralen Hörverarbeitung und des sogenannten Cocktail-Party-Problems und liefern Hinweise für Diagnostik, Therapie und Hörhilfetechnologien.

Stimmen entwirren: das Cocktailparty-Problem und die Kognition

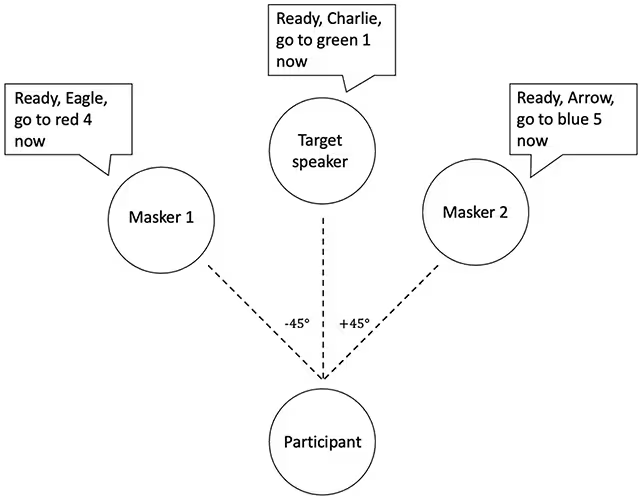

Die Forschenden prüften Freiwillige mit einem klassischen Hörtest, der häufig als "Cocktailparty-Problem" bezeichnet wird — die Fähigkeit, sich auf eine einzelne Stimme zu konzentrieren, während mehrere andere gleichzeitig sprechen. Statt reale Gespräche zu verwenden, nutzte das Team computergenerierte Sprachströme, um Überschneidungen und zeitliche Muster präzise zu steuern. Dadurch war es möglich, die akustische Szene systematisch zu manipulieren: Variationen in Lautstärke, Überlappung, zeitlicher Verschiebung und spektraler Ähnlichkeit der Stimmen konnten gezielt eingestellt werden. Die Teilnehmenden sollten Anweisungen folgen, die in den Zielgesprächen eingebettet waren, während ablenkende Stimmen zeitgleich abgespielt wurden. Dieses Design erlaubt eine differenzierte Analyse, wie selektive Aufmerksamkeit, auditive Szenenanalyse und Arbeitsgedächtnis beim Herausfiltern einer Zielstimme zusammenwirken.

Die verwendeten synthetischen Sprachsignale sind ein wichtiges methodisches Detail: sie eliminieren soziale und pragmatische Hinweise, die in natürlichen Gesprächen vorhanden sind, ermöglichen allerdings eine klare Kontrolle über akustische Parameter. So konnten die Forschenden beispielsweise gezielt manipulieren, wie ähnlich oder unterschiedlich Ziel- und Stimmmasker waren, welche räumlichen Hinweise (z. B. simulierte Positionen im Raum) zur Verfügung standen und wie stark zeitliche Überschneidungen auftraten. Diese experimentelle Kontrolle ist besonders nützlich, um die Rolle kognitiver Ressourcen bei der Sprachselektion zu untersuchen, ohne dass variable Inhalte oder nonverbale Signale die Messung stören.

Die Teilnehmergruppe umfasste 12 Personen mit Autismus und 10 Personen mit Fetalem Alkoholsyndrom — beides Diagnosen, die zuvor mit Schwierigkeiten beim Hören in lauten Umgebungen in Verbindung gebracht worden sind und die eine Bandbreite an Intelligenzquotienten (IQ) abdeckten. Ergänzt wurde die Stichprobe durch eine Kontrollgruppe von 27 neurotypischen Teilnehmenden, die nach Alter und Geschlecht abgeglichen waren und dieselben Aufgaben absolvierten. Ein entscheidender Punkt: Alle Versuchspersonen zeigten eine klinisch normale periphere Hörfunktion, das heißt, ihre Ohren erfassten Töne in den erwarteten Frequenz- und Pegelbereichen bei standardisierten Audiogrammen. Damit konnten die Forschenden zentrale, nicht-periphere Ursachen für Hörprobleme in Lärm gezielt untersuchen.

Was die Ergebnisse über Sprachwahrnehmung und IQ verraten

Innerhalb aller drei Gruppen korrelierte eine geringere kognitive Leistungsfähigkeit mit schlechteren Ergebnissen im Sprach-im-Lärm-Test. Anders ausgedrückt: Personen mit niedrigerer Punktzahl in kognitiven Tests hatten größere Probleme, die Zielstimme zuverlässig zu verfolgen und die richtigen Anweisungen herauszufiltern. Wie die Hörneuroforscherin Bonnie Lau von der University of Washington zusammenfasst: „Die Beziehung zwischen kognitiver Fähigkeit und Sprachwahrnehmungsleistung überschritt die diagnostischen Kategorien.“ Das heißt, Unterschiede bei der Verarbeitung — die sich in verschiedenen IQ-Werten widerspiegeln — scheinen eher dafür verantwortlich zu sein, dass Menschen Stimmen im Hintergrund nicht gut herausfiltern können, als ein messbarer peripherer Hörverlust.

Diese Befunde stützen die Auffassung, dass Sprachverstehen in Lärmsituationen ein komplexes Zusammenspiel aus peripherer und zentraler Verarbeitung ist. Die periphere Hörfunktion liefert die akustischen Signale, doch das zentrale Nervensystem entscheidet, welche Signale priorisiert, verknüpft oder verworfen werden. Kognitive Prozesse wie auditive Aufmerksamkeit, geteilte Aufmerksamkeit, Arbeitsgedächtnis, Reiz-Selektion und Entscheidungsfindung beeinflussen die Effizienz dieser zentralen Verarbeitung. In klinischer Terminologie spricht man in diesem Kontext auch von zentralen auditorischen Verarbeitungsstörungen (CAPD) oder von Defiziten in der auditiven Szenenanalyse, die durch klassische Hörtests nicht zwangsläufig erfasst werden.

Das Ergebnis erscheint plausibel: Eine einzelne Stimme zu isolieren erfordert schnelle Trennung von Audio-Streams (stream segregation), selektive Aufmerksamkeit, ein belastbares Arbeitsgedächtnis, um Satzteile zu halten, und häufig die Integration visueller Hinweise wie Lippenbewegungen. All diese Prozesse erhöhen die kognitive Belastung, besonders in komplexen akustischen Umgebungen mit mehreren konkurrierenden Quellen. Zudem spielt die Vorhersagefähigkeit des Gehirns (Predictive Coding) eine Rolle: das Gehirn nutzt kontextuelle Erwartungen, um Sprachanteile zu ergänzen und störende Inputs abzuschirmen. Wenn kognitive Ressourcen begrenzt sind — etwa durch niedrige Verarbeitungsgeschwindigkeit, reduzierte Exekutivfunktionen oder eingeschränkte Arbeitsgedächtniskapazität — werden diese Kompensationsmechanismen weniger effektiv.

Neurowissenschaftliche Modelle betonen, dass auditive Verarbeitung nicht passiv stattfindet: Top-down-Prozesse (Erwartungen, Erfahrungen, Aufmerksamkeitssteuerung) interagieren mit Bottom-up-Signalen aus dem Hörnerv. Die Studie legt nahe, dass individuelle Unterschiede in diesen top-down-Fähigkeiten, die auch in IQ-Messungen reflektiert werden, entscheidend sind, um Sprachinformationen aus einem lauten Hintergrund zu extrahieren. Kurz: Nicht nur die Sensitivität der Ohren, sondern auch die Kapazität des Gehirns zur Selektion, Priorisierung und Aufrechterhaltung relevanter Informationen bestimmt das erfolgreiche Hörverstehen im Lärm.

Praktische Folgen: mehr als ein Hörtest

Die Autorinnen und Autoren der Studie betonen, dass Standard-Audiogramme zentrale, kognitive Ursachen von Hörschwierigkeiten übersehen können. Jemand kann ein Hörtest-Resultat haben, das technisch als „normal“ gilt, und dennoch beim Zuhören in einem geschäftigen Café oder einem lauten Klassenzimmer erhebliche Probleme haben. Diese Erkenntnis hat direkte praktische Konsequenzen: Sie öffnet den Weg zu kostengünstigen, pragmatischen Anpassungen wie der Platzierung eines Schülers näher an der Lehrperson, verbesserten Raumakustik (Absorber, Reduktion von Nachhall, Lautsprecher-Arrangement), oder gezielten Trainingsprogrammen für auditive Aufmerksamkeit und Stream-Segregation.

Konkrete Interventionen können unterschiedlich ausfallen: pädagogische Maßnahmen umfassen klar strukturierte Sitzordnungen, reduzierte parallele Aktivitäten, Visualisierung von Informationen und den Einsatz von FM-Systemen oder individuellen drahtlosen Mikrofonen, die die Stimme des Sprechers direkt an das Hörgerät oder Kopfhörer übermitteln. Therapeutische Ansätze beinhalten auditory training, das sukzessive die Fähigkeit steigert, Zielstimmen in komplexen Klanglandschaften zu erkennen, sowie kognitive Trainingsprogramme, die Arbeitsgedächtnis und Aufmerksamkeitssteuerung verbessern. Für die Entwicklung von Hörhilfen und Algorithmen zur Geräuschunterdrückung bedeutet die Studie, dass nicht nur Verstärkung, sondern Modelle von Aufmerksamkeit und Szenenanalyse berücksichtigt werden müssen.

Die Forschenden nennen aber auch Einschränkungen: eine relativ kleine Stichprobe und die Verwendung synthetischer Sprache statt natürlicher Dialoge sind wichtige Limitationen. Dennoch fügt die Arbeit eine weitere Facette zu einer wachsenden Evidenzbasis hinzu, die zeigt, dass Sprachverstehen im Lärm multifaktoriell ist und mit breiteren kognitiven Veränderungen zusammenhängen kann. Frühere Studien haben zudem ähnliche Schwierigkeiten beim Hören in Verbindung mit einem erhöhten Risiko für kognitive Beeinträchtigungen und Demenz gebracht — wobei die kausalen Mechanismen noch Gegenstand intensiver Forschung sind. So bleibt offen, ob Hörprobleme im Lärm ein Frühindikator für neuronale Veränderungen sein können oder eher ein paralleles Symptom überlappender Risikofaktoren.

Warum Forscher aufmerksam sind

Das Verständnis der neuronalen und kognitiven Grundlagen der Sprachwahrnehmung hat weitreichende Bedeutung. Für Klinik und Diagnostik bedeutet es, Hörbeschwerden nicht allein mit peripheren Tests zu bewerten, sondern ergänzende Prüfungen der zentralen auditorischen Verarbeitung und kognitiven Funktionen in Betracht zu ziehen. Für Pädagogen legt dies nahe, wie wichtig Raumgestaltung, akustische Optimierung und didaktische Anpassungen sind, um Mitschülern mit zentralen Verarbeitungs- oder Aufmerksamkeitsdefiziten das Verstehen zu erleichtern. Für Entwickler von Hörgeräten, Cochlea-Implantat-Algorithmen und Softwarelösungen ist die Botschaft klar: Modelle sollten auditive Szeneanalyse und Aufmerksamkeitsmechanismen integrieren, statt sich ausschließlich auf Verstärkung und einfache Rauschunterdrückung zu stützen.

Technologisch bedeutet das, dass adaptive Algorithmen, die Zielstimmen erkennen und priorisieren, oder Systeme, die Blick- und Head-Tracking nutzen, um die wahrscheinliche Zielquelle zu identifizieren, an Bedeutung gewinnen. Ebenso relevant sind hybride Lösungen, die sowohl peripheren Hörverlust adressieren als auch kognitives Training und Verhaltensstrategien kombinieren. In der Forschung fördert diese Perspektive interdisziplinäre Kooperationen zwischen Audiologie, Neurowissenschaften, Kognitionspsychologie, Pädagogik und Ingenieurwissenschaften, um ganzheitliche Lösungen für reale Kommunikationsprobleme zu entwickeln.

Abschließend betonen die Autorinnen und Autoren, dass man keine messbare Hörschwäche im klassischen Sinne benötigt, um Alltagsgeräusche als ermüdend und verwirrend zu erleben. Zukünftige Schritte sollten größere, diversere Studien umfassen, die verschiedene Altersgruppen, Diagnosen und sozioökonomische Hintergründe berücksichtigen. Ebenso wichtig sind Interventionsstudien, die prüfen, welche Maßnahmen — von akustischer Raumoptimierung über pädagogische Anpassungen bis hin zu gezieltem kognitiven Training — die beste Verbesserung des Sprachverstehens in Lärm bewirken. Langfristig könnte ein besseres Verständnis der zentralen Hörverarbeitung nicht nur die Lebensqualität vieler Betroffener verbessern, sondern auch neue Wege in Prävention und Früherkennung kognitiver Erkrankungen eröffnen.

Quelle: sciencealert

Kommentar hinterlassen