8 Minuten

Ein japanisches Forscherteam hat mithilfe künstlicher Intelligenz die bislang detaillierteste Simulation der Milchstraße erstellt — eine Simulation, die über 100 Milliarden einzelne Sterne verfolgt und mehr als 100-mal schneller läuft als frühere Ansätze. Indem die Forschenden der KI beibrachten, wie sich Supernova-Explosionen entfalten und dieses Wissen mit großskaliger Gravitions- und Gasphysik kombinierten, entstand ein galaktisches Modell, das sonst Jahrzehnte dauernde Rechnungen auf wenige Monate reduziert. Diese Entwicklung ist relevant für die Forschung zur Galaxienbildung, zur chemischen Anreicherung und für Methoden des Hochleistungsrechnens (HPC).

KI hat die erste echte Stern-für-Stern-Simulation der Milchstraße so beschleunigt, dass sie in Monaten statt Jahrzehnten abgeschlossen werden kann.

Wie das Team die Simulationsbarriere überwunden hat

Die Modellierung einer Galaxie wie der Milchstraße auf Einzelstern-Auflösung ist notorisch anspruchsvoll. Typische Galaxiensimulationen müssen konkurrierende Anforderungen ausbalancieren: Gravitation, die sich über zehntausende Lichtjahre erstreckt; Gasdynamik und Turbulenz auf sehr kleinen Skalen; sowie hochenergetische, kurzlebige Ereignisse wie Supernova-Explosionen. Klassischerweise vereinfachten Forschende das Problem, indem sie viele Sterne zu einzelnen rechnerischen Partikeln zusammenfassten. Diese Abstraktion opfert jedoch die notwendige Mikrophysik, um zu verstehen, wie Sterne, Gas und neu erzeugte Elemente über kosmische Zeiten hinweg interagieren.

Die Arbeitsgruppe unter Leitung von Keiya Hirashima am RIKEN Center for Interdisciplinary Theoretical and Mathematical Sciences (iTHEMS), zusammen mit Kooperationspartnern der University of Tokyo und der Universitat de Barcelona, verfolgte einen anderen Weg. Anstatt ausschließlich auf rohe numerische Integration zu setzen, kombinierten sie hochpräzise physikalische Modelle mit einem Deep-Learning-Surrogatmodell. Dieses Surrogat wurde auf hochaufgelösten Simulationen von Supernovae trainiert und lernte die feinen Details, wie sich Gas in den rund 100.000 Jahren nach einer Explosion ausdehnt, abkühlt und mit der Umgebung wechselwirkt. Anschließend ersetzte es die rechenintensivsten Teile der Mikrophysik innerhalb der großskaligen galaktischen Simulation.

Technisch gesehen handelt es sich um eine hybride Methode: großskalige Gravitation und Gasdynamik bleiben physikalisch explizit modelliert, während komplexe, lokale Mikroprozesse, die zuvor eine enorme Rechenlast erzeugten, durch ein zuverlässiges, lernbasiertes Modell approximiert werden. Diese Kopplung aus Künstlicher Intelligenz, numerischer Astrophysik und Hochleistungsrechnen ermöglicht eine neue Balance zwischen Genauigkeit und Rechenaufwand.

Geschwindigkeit ohne Qualitätsverlust

Der Gewinn ist dramatisch. Während eine konventionelle, rein physikbasierte Simulation etwa 315 Stunden benötigen würde, um eine Million Jahre Entwicklung der Milchstraße in Einzelsternauflösung zu berechnen, reduzierte der KI-beschleunigte Ansatz dieses Intervall auf nur 2,78 Stunden. Hochgerechnet bedeutet dies, dass eine Simulation über eine Milliarde Jahre, die früher mehr als 36 Jahre Rechenzeit erfordert hätte, nun in etwa 115 Tagen abgeschlossen werden kann. Dieser Quantensprung — mehr als zwei Größenordnungen schneller — eröffnet neue Möglichkeiten zur Untersuchung von Galaxienaufbau, Sternendynamik und chemischer Anreicherung in nie zuvor erreichter Breite und Tiefe.

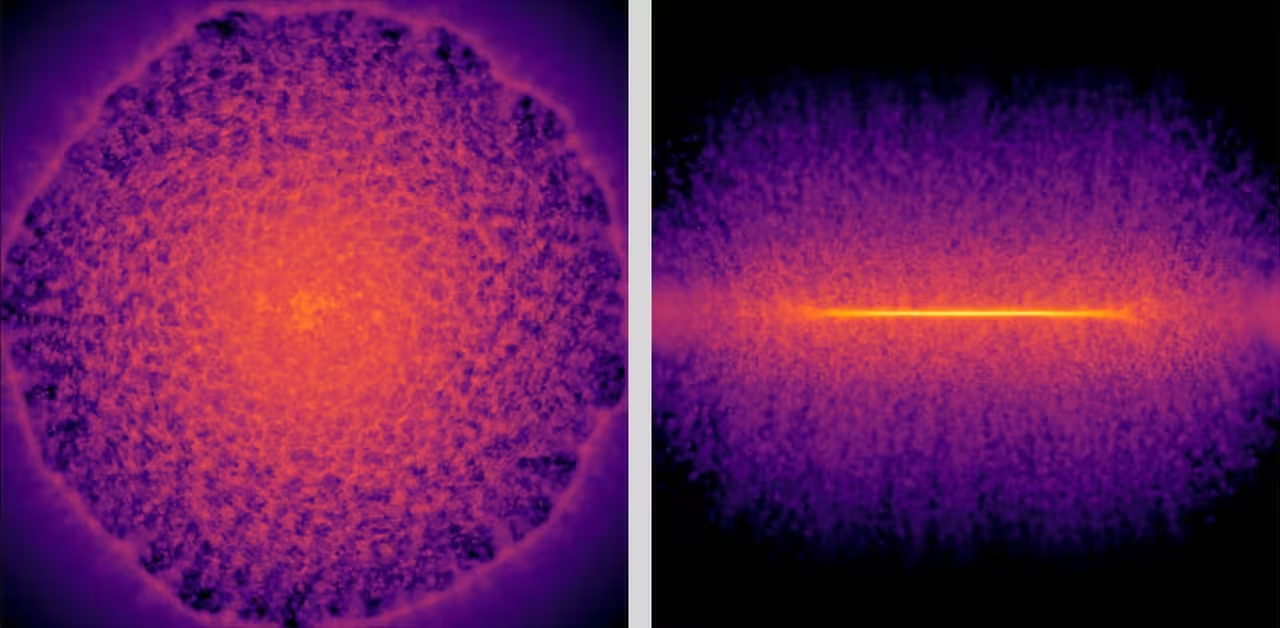

Frontale (links) und seitliche (rechts) Schnappschüsse einer galaktischen Gasscheibe. Diese Visualisierungen der Gasverteilung nach einer Supernova wurden vom Deep-Learning-Surrogatmodell erzeugt.

Warum das Tracking einzelner Sterne wichtig ist

Die Verfolgung einzelner Sterne — statt Sternhaufen durch einzelne Partikel zu repräsentieren — bewahrt die kleinskaliigen Prozesse, die die Galaxienentwicklung antreiben. Supernovae injizieren Energie und schwere Elemente in das umgebende Gas, was entweder Sternentstehung anregen oder sie dämpfen kann; gleichzeitig verändern diese Explosionen lokale Strömungen und die Turbulenzstruktur. Solche Vorgänge spielen sich über kurze Zeiten und auf kleinen Volumina ab; nur ein Modell mit feiner Auflösung kann erfassen, wie sich diese lokalen Effekte summieren und die großräumige Struktur einer Galaxie über Millionen bis Milliarden Jahre formen.

Mit Einzelstern-Auflösung können Astrophysiker simulierte Sternbahnen, Altersverteilungen und chemische Fingerabdrücke direkt mit Beobachtungsdaten vergleichen — beispielsweise mit Katalogen der ESA-Mission Gaia oder bevorstehenden spektroskopischen Kampagnen. Die neue Simulation ist damit nicht nur eine technische Errungenschaft, sondern ein praktisches Forschungstool, um Hypothesen über die Entstehung der Milchstraße, ihre Zusammensetzung und die Herkunft der für Leben wichtigen Elemente zu testen. Zusätzlich ermöglicht die erhöhte Auflösung die Untersuchung feinerer Fragen, etwa wie verschiedene Migrationsprozesse innerhalb der galaktischen Scheibe ablaufen oder wie sich einzelne Mergerspuren in der Sternpopulation niederschlagen.

Technische Validierung und breitere Auswirkungen

Das Team validierte seine hybride Methode durch großangelegte Tests auf RIKENs Supercomputer Fugaku und dem Miyabi Supercomputer System der University of Tokyo. Die Ergebnisse bestätigen, dass das Surrogatmodell zentrale physikalische Verhaltensweisen bewahrt, während es die Rechenkosten drastisch senkt. Solche Verifikationsschritte sind wichtig, um sicherzustellen, dass beschleunigende Approximationen die relevanten Observablen nicht verzerren — etwa Energieerhaltung, Impulserhaltung und die richtige Verteilung von Metallen (chemische Anreicherung) im Gas.

Über die Galaxienmodellierung hinaus könnte dieses hybride Paradigma — bei dem KI als verlässliches Surrogat für die rechenintensivste Mikrophysik dient — multi-skalen Simulationen in anderen Disziplinen transformieren. Bereiche wie Klimamodellierung, Ozeanographie oder Wettervorhersage leiden ebenfalls unter extrem unterschiedlichen Skalen und rechenintensiven Prozessen; auch hier könnten lernbasierte Surrogate Rechenzeit reduzieren und neue Experimente ermöglichen.

Hirashima betonte die weitreichende Bedeutung: „Ich glaube, dass die Integration von KI in Hochleistungsrechnen einen grundlegenden Wandel darin markiert, wie wir multi-skalen- und multi-physikalische Probleme in den computational sciences angehen. Dieser Fortschritt zeigt außerdem, dass KI-beschleunigte Simulationen über Mustererkennung hinauswachsen und zu echten Werkzeugen für wissenschaftliche Entdeckungen werden können — etwa um nachzuvollziehen, wie die Elemente, aus denen Leben entstand, innerhalb unserer Galaxie entstanden sind.“

Wichtige wissenschaftliche Implikationen

- Galaxienentwicklung: Schnelle, hochaufgelöste Simulationen ermöglichen umfangreichere Parameterstudien, mit denen konkurrierende Entstehungsszenarien für die Milchstraße getestet werden können.

- Sternarchäologie: Das Tracking einzelner Sterne verbessert den Vergleich mit Beobachtungskatalogen und unterstützt Bestrebungen, die Migrations- und Fusionsgeschichte der Galaxie zu rekonstruieren.

- Chemische Anreicherung: Detaillierte Supernova-Feedback-Modelle erlauben es, die Produktion und Verteilung schwerer Elemente (Metalle) im Laufe der Zeit präziser nachzuverfolgen.

- Disziplinübergreifendes Potenzial: Die KI-Surrogat-Strategie kann andere rechenintensive Probleme in Erdwissenschaften und computational sciences beschleunigen und so neue Experimente und Sensitivitätsanalysen ermöglichen.

Was diese Methode noch nicht leistet — vorerst

Trotz des Durchbruchs bleiben Herausforderungen. Die aktuelle Demonstration deckt 10.000 Jahre in Einzelstern-Granularität innerhalb eines galaktischen Rahmens ab und projiziert die erzielten Zeitgewinne auf Million- und Milliardenjahresskalen. Die Einbeziehung zusätzlicher Physik — etwa kosmischer Strahlung, fein aufgelöster Magnetfelder oder der vollständige Strahlungstransport — erfordert jedoch weitere Entwicklung sowohl der Trainingsdaten für das Surrogat als auch der Kopplungsstrategien zwischen Surrogat und großskaliger Simulation. Darüber hinaus sind Energieeffizienz und Skalierbarkeit auf unterschiedlichen Supercomputer-Architekturen aktive Herausforderungen, besonders wenn es um wiederholte Produktionsläufe in großem Maßstab geht.

Zudem müssen methodische Fragen sorgfältig adressiert werden: Wie robust sind die Surrogate außerhalb der Trainingsverteilung? Welche Unsicherheiten führen sie in die Simulation ein? Wie gut lassen sich konservative physikalische Prinzipien, etwa Energie- und Impulserhaltung, in den lernbasierten Komponenten erzwingen? Solche Validierungen sind Voraussetzung dafür, dass die Wissenschaftsgemeinde beschleunigte Simulationen als vertrauenswürdige Analysewerkzeuge akzeptiert.

Experteneinschätzung

Dr. Laura Méndez, Astrophysikerin und Computational Scientist (fiktiv), kommentierte: „Diese Arbeit ist ein Meilenstein, weil sie den rechnerischen Kompromiss neu denkt. Anstatt nur zu fragen, wie viel Hardware wir einsetzen können, fragen wir, wie clever wir die teuersten physikalischen Komponenten durch gelernte, verlässliche Approximationen ersetzen. Das hat weitreichende Folgen: mehr Experimente, umfangreichere Parameterstudien und letztlich schnellere wissenschaftliche Erkenntnisse.“

Ausblick und zukünftige Perspektiven

Mit Blick auf die Zukunft könnte der hybride KI-plus-HPC-Ansatz auf die Simulation anderer Galaxien erweitert werden, um Sternentstehungsgeschichten in unterschiedlichen Umgebungen zu untersuchen, und als Unterstützung für Beobachtungsmessungen dienen, indem realistische Mock-Surveys erzeugt werden. Wenn Trainingsdatensätze wachsen und Surrogatmodelle robuster und vielseitiger werden, dürfte sich das Verhältnis von Genauigkeit zu Geschwindigkeit weiter zugunsten der Forschenden verschieben. Das ermöglicht tiefere, häufigere und vergleichbarere Untersuchungen der kosmischen Geschichte, die in den Sternen geschrieben steht.

Schließlich eröffnet die Methode auch didaktische und kollaborative Chancen: Durch die Verringerung von Rechenkosten können mehr Forscherteams — auch solche mit begrenzten Ressourcen — an hochauflösenden Experimenten teilnehmen, reproduzierbare Szenarien testen und zur Validierung beitragender Modelle beitragen. Das stärkt die wissenschaftliche Überprüfbarkeit und beschleunigt kumulative Fortschritte in der Astrophysik und verwandten Feldern.

Quelle: scitechdaily

Kommentar hinterlassen