8 Minuten

Einführung

Wenn ein Modell aufhört zu raten und stattdessen zu schlussfolgern beginnt, merkt man den Unterschied sofort. Drei Monate nachdem Gemini 3 Pro am 19. November debütierte, hat Google stillschweigend Gemini 3.1 Pro ausgeliefert — eine Verfeinerung, die gezielt auf jene Problemklassen abzielt, die sorgfältiges Denken mehr belohnen als cleveres Tricksereien.

Was ist neu in Gemini 3.1 Pro?

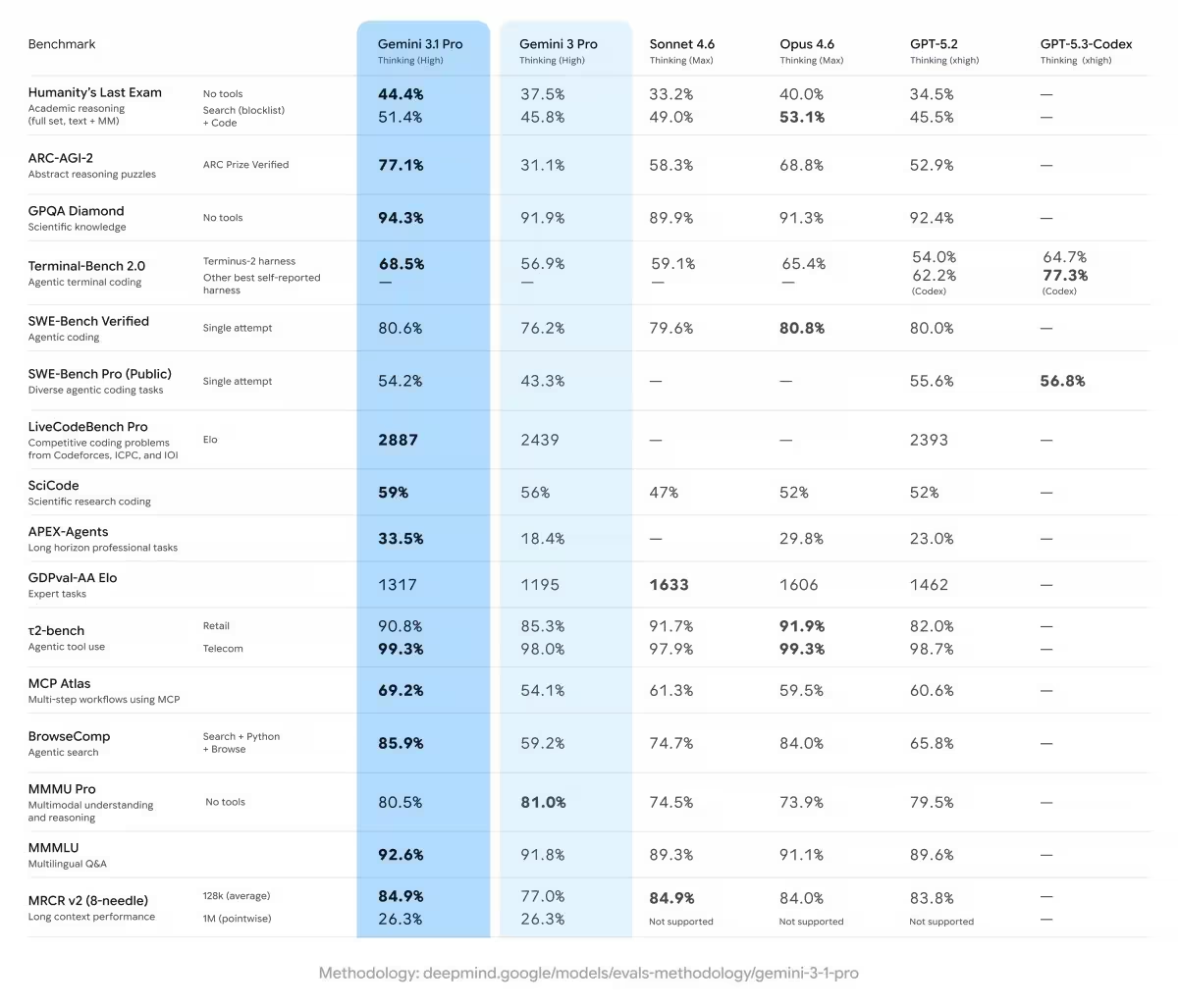

Google bezeichnet dieses Update als einen Fortschritt in der Kern-Argumentation (core reasoning). Das ist kein bloßes Marketinggeplänkel; die Verbesserung zeigt sich in Benchmark-Ergebnissen. Gemini 3.1 Pro führte die Rangliste beim ARC-AGI-2 an — einem Test, der entwickelt wurde, um zu messen, wie gut ein System brandneue logische Muster löst, die es zuvor nicht gesehen hat. In einfachen Worten: Das Modell ist besser darin, sich mit ungewohnten Rätseln auseinanderzusetzen, statt sich auf auswendig gelerntes Wissen zu verlassen.

Der Begriff "Kern-Argumentation" umfasst mehrere Fähigkeiten:

- Mehrstufiges logisches Schlussfolgern über unbekannte Kontexte

- Schlussfolgerungen aus mehreren, teils widersprüchlichen Informationen

- Flexibles Anwenden von Regeln auf neuartige Situationen

- Reduktion von oberflächlichen Heuristiken zugunsten strukturierter Analyse

Diese Verbesserungen resultieren aus Modell- und Trainingsanpassungen sowie aus gezielten Evaluationszyklen, die auf Robustheit gegenüber neuen, nicht im Training enthaltenen Aufgaben abzielen.

Anwendungsfälle: Was bedeutet das im Alltag?

Was heißt das konkret für die tägliche Nutzung? Denken Sie über kurze, einzeilige Antworten hinaus. Möchten Sie eine klare visuelle Schritt-für-Schritt-Anleitung für ein komplexes Thema? Müssen disparate Datensätze zu einer kohärenten Gesamtsicht synthetisiert werden? Oder versuchen Sie, eine halb ausgereifte kreative Idee in etwas Greifbares zu verwandeln? Gemini 3.1 Pro positioniert sich als Grundlage für jene schwereren, mehrstufigen Aufgaben, bei denen Nuancen eine Rolle spielen.

Typische Einsatzszenarien

- Technische Problemanalyse: Diagnosen und mehrschrittige Lösungspläne für komplexe Fehlerbilder in Software oder Infrastruktur.

- Forschung und Datenanalyse: Zusammenführen heterogener Datenquellen und Ableiten fundierter Hypothesen.

- Kreative Entwicklung: Ausformulieren, Verfeinern und Konkretisieren von Ideen über mehrere Iterationen hinweg.

- Bildungsunterstützung: Schrittweise Erklärungen bei mathematischen oder logischen Problemen statt nur einer finalen Antwort.

- Programmierung: Erklärungen von Algorithmen, präzise Code-Reviews und mehrstufige Refactorings.

Zugang, Abonnements und Nutzungslimits

Google signalisiert auch, wie das Unternehmen erwartet, dass Menschen das Modell verwenden. Gelegenheitsnutzer können ab sofort über die Gemini-App auf Gemini 3.1 Pro zugreifen. Intensivnutzer und Berufsanwender erhalten mehr Spielraum: Abonnenten von Google AI Pro und Ultra bekommen höhere Nutzungsgrenzen. NotebookLM‑Nutzer sehen das neue Modell ebenfalls, allerdings nur wenn sie ein Pro- oder Ultra‑Abo besitzen.

Was das für verschiedene Nutzer bedeutet

- Freie oder Gelegenheitsnutzer: Einfacher Zugriff über die App, geeignet für sporadische Fragen und kleine Projekte.

- Professionelle Anwender (Pro/Ultra): Höhere Anfrageraten, längere Kontexte und Priorität beim Zugriff — sinnvoll für Teams, Entwickler und Forschung.

- NotebookLM-Integration: Bessere Unterstützung für dokumentenbasierte Workflows, jedoch abhängig vom Abonnement.

Kurz gesagt: Erwarten Sie intelligentere, methodischere Antworten, wenn die Aufgabe Tiefe verlangt — und unterschiedliche Zugriffsmöglichkeiten je nach Abonnementstufe.

Leistungsbewertung und Grenzen

Es bleibt noch Arbeit. Benchmarks deuten auf Fortschritte hin, nicht auf Perfektion. ARC-AGI-2 ist ein spezialisierter Test, um die Fähigkeit zu messen, bisher unbekannte logische Muster zu lösen; ein gutes Abschneiden dort ist ein starker Hinweis auf verbesserte reasoning-Fähigkeiten, aber es garantiert nicht universelle Fehlerfreiheit.

Was Benchmarks aussagen — und was nicht

Benchmarks sind nützlich, weil sie standardisierte, vergleichbare Messgrößen bieten. Allerdings haben Benchmark-Ergebnisse Grenzen:

- Sie messen die Leistung in einem definierten Aufgabenraum, nicht in allen realen Situationen.

- Ein Spitzenplatz in einem Test wie ARC-AGI-2 zeigt Robustheit gegenüber bestimmten Logikaufgaben, aber sagt wenig über Domänenwissen oder moralische Urteilsfähigkeit aus.

- Modelle können in spezifischen Benchmarks überoptimiert wirken, wenn Trainings- oder Evaluationsdaten unbemerkt korrelieren.

Praktisch bedeutet das: Gemini 3.1 Pro wird wahrscheinlich weniger „plausibel klingende“ Fehler (Halluzinationen) bei mehrstufigen, logikintensiven Aufgaben machen, aber es bleibt wichtig, Ausgaben kritisch zu prüfen — besonders bei sicherheitskritischen oder geschäftskritischen Entscheidungen.

Bekannte Herausforderungen

- Unsichere Fakten bei sehr aktuellen Ereignissen (Abhängigkeit vom Trainingskorpus und Aktualität).

- Fehlende Domänenexpertise in sehr spezialisierten Nischen, in denen spezifische Daten oder kontextspezifisches Wissen nötig sind.

- Mögliche Verzerrungen oder unerwünschte Muster, die aus Trainingsdaten übernommen wurden.

Technische Einblicke und Evaluationsmethoden

Obwohl Google keine vollständigen Architekturdetails veröffentlicht hat, lassen sich aus den verfügbaren Informationen und aus der Art der Verbesserungen einige plausible technische Schlüsse ziehen. Fortschritte im "core reasoning" deuten oft auf:

- Optimierungen in der Trainings-Datenkuratierung, um vielfältigere logische Beispiele einzuschließen.

- Architektur- oder Feinabstimmungs‑Änderungen, die das Modell robuster gegenüber Kontexteinschränkungen machen.

- Erweiterte Evaluationsschleifen mit gezieltem adversarial testing, um systematische Schwachstellen zu finden und zu schließen.

Für Teams, die Modelle bewerten oder in Produktionssysteme integrieren, sind folgende Evaluationsmethoden empfehlenswert:

- Mehrstufige Prompt‑Tests: Aufgaben entwerfen, die mehrere Zwischenschritte erfordern, und die Korrektheit jedes Schritts prüfen.

- Adversarial-Probing: Eingaben, die das Modell leicht in die Irre führen können, verwenden, um Stabilität zu testen.

- Vergleich mit Vorgängerversionen: Leistung auf identischen Datensätzen mit Gemini 3 Pro vergleichen, um reale Verbesserungen zu quantifizieren.

- Domänenspezifische Benchmarks: Eigene Tests erstellen, die typische Aufgaben der Zielbranche abbilden (z. B. juristische Argumentation, medizinische Differentialdiagnosen, Finanzmodellierung).

Wie Sie Gemini 3.1 Pro sinnvoll testen

Wenn Sie das Modell selbst ausprobieren möchten, helfen strukturierte Tests, die Reasoning-Fähigkeiten gezielt herausfordern:

Beispiel-Methodik

- Definieren Sie eine komplexe Aufgabe, die mehrere Schritte benötigt (z. B. Daten bereinigen → Muster erkennen → Hypothese formulieren → Handlungsempfehlung).

- Lassen Sie das Modell jeden Zwischenschritt explizit ausgeben, nicht nur das Endergebnis.

- Prüfen Sie Zwischenergebnisse auf Konsistenz und Nachvollziehbarkeit.

- Varianz-Tests: Wiederholen Sie die Aufgabe mit leicht veränderten Formulierungen, um Robustheit gegen Prompthühner zu messen.

Ein konkretes Beispiel für einen Testprompt könnte sein: "Analysiere diese beiden Datensätze, identifiziere drei potenzielle Ursachen für die Diskrepanz, skizziere Tests zur Überprüfung jeder Ursache und nenne priorisierte Handlungsempfehlungen." Solche Aufgaben fordern logisches Denken, Synthese und praktische Umsetzbarkeit — genau die Bereiche, in denen Gemini 3.1 Pro Verbesserungen verspricht.

Sicherheit, Ethik und verantwortungsvolle Nutzung

Mit stärkerer Reasoning-Fähigkeit steigen die Erwartungen an verantwortungsvolle Nutzung. Schnellere, plausibelere Antworten können die illusionäre Autorität eines Modells verstärken; deshalb sollten Organisationen klare Prozesse für Validierung und menschliche Überprüfung etablieren.

Best Practices

- Implementieren Sie menschliche Review-Schritte für kritische Ausgaben.

- Dokumentieren Sie verwendete Prompts, Modellversion und Kontexte, um Reproduzierbarkeit zu gewährleisten.

- Begrenzen Sie automatische Ausführung in sicherheitsrelevanten Workflows ohne zusätzliche Validierung.

- Überwachen Sie langfristig Modellverhalten, um Drift oder unerwartete Muster zu erkennen.

Wettbewerbsvorteile und Differenzierung

Warum ist Gemini 3.1 Pro relevant gegenüber anderen Modellen? Zwei Faktoren sind entscheidend:

- Fokus auf Kern-Argumentation: Verbesserte Logik- und Reasoning-Fähigkeiten machen das Modell besonders nützlich für Anwendungen, die mehrstufige Analysen erfordern.

- Integration in Google‑Ökosystem: Der einfache Zugang über die Gemini-App, sowie höhere Limits für Pro- und Ultra-Abonnenten, erleichtern die Einbindung in bestehende Arbeitsabläufe und Kollaborationstools.

Organisationen, die auf präzise mehrstufige Antworten angewiesen sind — etwa in Forschung, Consulting oder komplexer Produktentwicklung — können hier einen Wettbewerbsvorteil sehen, wenn sie die verbesserten Reasoning-Fähigkeiten effektiv nutzen und verantwortungsvoll begleiten.

Fazit

Benchmarks deuten auf echten Fortschritt hin, aber kein Modell ist perfekt. Wenn Sie von KI-Antworten frustriert waren, die zwar plausibel klangen, aber bei genauer Prüfung auseinanderfielen, ist Gemini 3.1 Pro ein nächster Versuch, dieses Problem zu verringern. Es bietet eine bessere Basis für Aufgaben, die tieferes, mehrstufiges Denken erfordern — vorausgesetzt, Sie testen und integrieren es mit angemessenen Validierungsmechanismen.

Kurz gesagt: Erwarten Sie intelligentere, methodischere Antworten, wenn die Aufgabe Tiefe verlangt — und unterschiedliche Zugriffsrechte je nach Ihrem Abonnement.

Bereit, es selbst zu testen? Beginnen Sie mit strukturierten, mehrstufigen Aufgaben und validieren Sie die Zwischenschritte — so erkennen Sie am schnellsten, wie sich die verbesserte Kern-Argumentation in Ihrer Praxis auszahlt.

Quelle: gsmarena

Kommentar hinterlassen