7 Minuten

Chinesische Forscher haben einen optischen Quantenchip vorgestellt, der ihrer Darstellung zufolge KI-Workloads um mehrere Größenordnungen beschleunigen könnte. Entwickelt von CHIPX aus Wuxi und Turing Quantum aus Shanghai, gewann das Gerät einen Leading Technology Award auf der Wuzhen Global Internet Conference 2025 und hat bereits eine breite Diskussion über die Zukunft der KI-Hardware ausgelöst. Die Bekanntgabe des photonischen Quantenchips erfolgt in einem Kontext intensiver globaler Investitionen in Quantencomputer, optische Beschleuniger und spezialisierte KI-Beschleuniger. Neben der technischen Innovation betonen die Entwickler auch Aspekte der industriellen Skalierbarkeit sowie strategische Implikationen für nationale Technologiepläne. Die Meldung wurde sowohl in Fachkreisen als auch in Medienkommentaren aufgegriffen, wobei Experten einerseits das Potenzial für signifikante Leistungssteigerungen hervorheben und andere wiederum auf offene Fragen bei Verifikation, Anwendungsfällen und industrieller Produktion hinweisen. Diese erste Bekanntmachung dient als Auftakt für weitergehende technische Dokumentation und mögliche Kooperationen mit Rechenzentrumskunden, Cloud-Anbietern und Forschungslabors.

Ein photonenbasierter Sprung mit großen Geschwindigkeitssprüngen

Berichten zufolge kann der neue photonische Quantenchip bestimmte komplexe KI-Probleme mehr als 1.000-mal schneller lösen als aktuelle NVIDIA-GPUs — eine mutige Behauptung, die die beteiligten Teams ausdrücklich auf spezifische Benchmark-Szenarien einschränken. Solche Angaben sind in der Regel an die Art der Aufgabe, die Messmethodik und die verwendeten Datensätze gebunden; daher sind transparente Benchmarks und Reproduzierbarkeit entscheidend, um die Aussagekraft der Zahl zu bewerten. Der Chip wurde als eines von 17 herausragenden wissenschaftlichen Ergebnissen aus über 400 Nominierten aus 34 Ländern beim Wuzhen-Gipfel ausgewählt, was seinen Status als potenziellen Durchbruch unterstreicht. Entscheidend ist, welche Klassen von KI-Aufgaben konkret profitieren: sind es stochastische Sampling-Probleme, bestimmte Optimierungsprobleme, Monte-Carlo-Methoden, spezielle lineare Algebra-Operatoren oder gar bestimmte Teile von Transformer-Inferenz- und Trainingspipelines? Photonenbasierte Geräte können für einige dieser Problemklassen besonders geeignet sein, etwa wenn es um schnelle Sampling-Verfahren, parallele optische Übertragungen oder energieeffiziente Matrixoperationen geht. Gleichzeitig bleibt zu prüfen, ob die gemessenen Leistungsgewinne bei realen, großskaligen Produktionsworkloads — etwa in kommerziellen KI-Rechenzentren oder in der Forschung — replizierbar sind. Die Bewertung durch unabhängige Institutionen, standardisierte Benchmarks und Vergleichstests gegen aktuelle GPU- und TPU-Architekturen ist für die Akzeptanz in der Industrie zentral.

Wie der Chip funktioniert: Photonen, Co‑Packaging und Chip‑skalierte Integration

Was dieses Design besonders hervorhebt, ist der konsequente Einsatz von Licht anstelle traditioneller elektrischer Signale. Die Entwickler geben an, eine On‑Chip-Co‑Packaging-Lösung realisiert zu haben, bei der photonische Komponenten und elektronische Schaltungen eng integriert sind, was die Produktion photonischer Quantenprozessoren in Wafer‑Maßstab ermöglichen soll. Diese Kombination aus Photonentechnik und elektronischer Steuerung ist ein kritischer Schritt, um Latenzen, Kopplungsverluste und Verpackungskomplexität zu reduzieren und gleichzeitig die Testbarkeit zu verbessern. Zu den technischen Kernpunkten, die in der Projektbeschreibung genannt werden, gehören:

- Photonenbasierte Datenpfade, die den ohmschen Verlust und damit verbundenes resistives Heizen minimieren können, was zu geringerer Wärmeentwicklung und potenziell niedrigerem Energieverbrauch führt. Optische Signale propagieren mit sehr hohen Bandbreiten und können Information mit geringer Latenz über optische Wellenleiter oder freie Raumkanäle übertragen.

- Chip‑level Integration, die es erlaubt, mehrere photonische Chips koordiniert zusammenarbeiten zu lassen und damit eine skalierbare Multi‑Chip‑Architektur zu bilden. Die Entwickler sprechen von einer potenziellen Skalierung bis zu dem, was sie als bis zu einer Million Qubits in einer Multi‑Chip‑Anordnung beschreiben. In diesem Zusammenhang ist es wichtig zu unterscheiden, welche Art von Qubit‑Repräsentation eingesetzt wird (z. B. Einzelphotonen, optische Moden oder kontinuierliche Variable) und wie Fehlerkorrektur, Verlustmanagement und Kopplung zwischen Chips technisch gelöst werden.

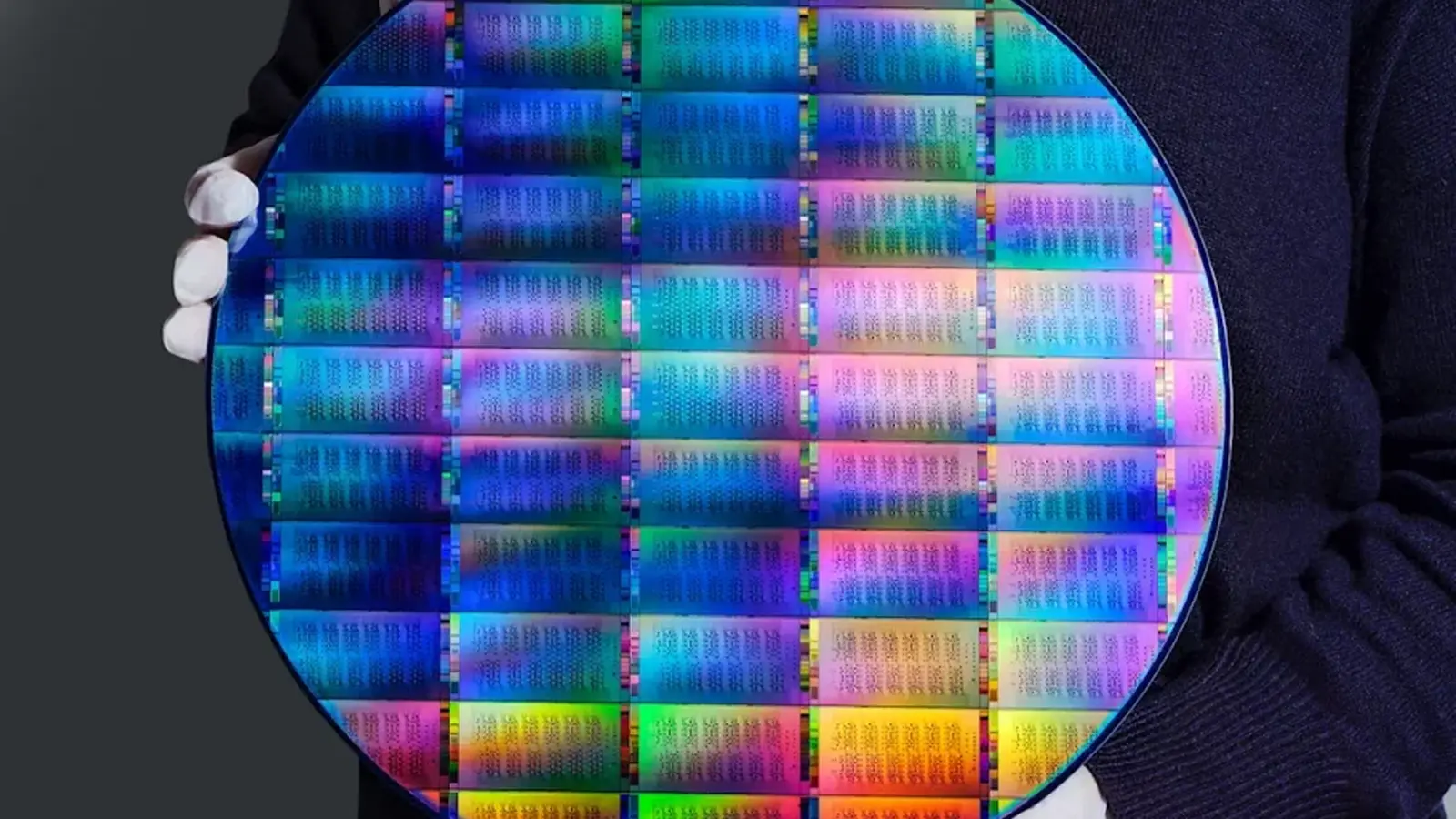

- Wafer‑skalige Fertigung, die die Hersteller als weltweite Premiere für photonische Quantenbauelemente bezeichnen. Die Fähigkeit, photonische Schaltungen auf Standardwafern in großen Stückzahlen zu produzieren, wäre ein bedeutender Fortschritt für die industrielle Reife von optischen Quantenprozessoren. Dabei spielen Prozessstabilität, optische Kopplungspräzision, Ausbeute (Yield) und Testverfahren auf Wafer‑Ebene eine große Rolle.

Wo das spricht: KI‑Rechenzentren und fortgeschrittene Industrien

Die Forscher nennen als Zielanwendungen vor allem KI‑Rechenzentren und Supercomputer, sehen aber auch Relevanz für Luft‑ und Raumfahrt, biomedizinische Forschung und finanzmathematische Modellierung. Photonische Quantenverarbeitung könnte durch höhere Durchsatzraten, parallele optische Kanäle und verbesserte Energieeffizienz entscheidende Vorteile für KI‑Infrastrukturen bieten, die heute immense Mengen an Energie verbrauchen. In Rechenzentren ist neben reiner Rechenleistung auch die Effizienz pro Watt, die Kühlleistung und die Dichte der Recheneinheiten von zentraler Bedeutung; photonische Systeme versprechen in einigen Szenarien eine bessere Energieeffizienz, insbesondere wenn sie elektrische I/O‑Flaschenhälse umgehen. In der biomedizinischen Forschung könnten schnelle Sampling‑Methoden und beschleunigte Optimierungsalgorithmen neue Möglichkeiten für Molekulardynamik, Genomanalysen oder Bildverarbeitung eröffnen. In der Finanzbranche ermöglichen performantere Sampling‑ und Optimierungsverfahren schnellere Risikomodelle und Szenarioanalysen.

Für Cloud‑Provider und Anbieter von KI‑Diensten ergeben sich mehrere Fragen: Wie lassen sich photonische Quantenbeschleuniger in bestehende Server‑Racks und Orchestrierungslösungen integrieren? Welche APIs, Framework‑Anpassungen und Hardware‑Abstraktionen sind nötig, damit Entwickler und Data‑Scientists photonische Beschleuniger nutzen können? Eine pragmatische Einführung würde vermutlich über hybride Systeme laufen, in denen photonische Quantenmodule bestimmte, gut definierte Teilaufgaben übernehmen, während herkömmliche GPUs, CPUs und spezialisierte Chips weiterhin die übrigen Workloads tragen.

Realitätscheck: Produktionsgrenzen und Kommerzialisierungshürden

Trotz der Aufregung bleibt die Produktion begrenzt. Berichte deuten auf eine jährliche Fertigung von grob 12.000 Wafern hin, von denen jeder rund 350 Chips liefert — Zahlen, die im Vergleich zu etablierten Halbleiterproduktionen noch relativ niedrig erscheinen. Solche Produktionsmengen werfen Fragen zur Ausbeute, zu Testzyklen und zu den Kosten pro funktionsfähigem Baustein auf. Viele praktische Fragen sind weiterhin offen: Welche KI‑Aufgaben profitieren tatsächlich, wie lässt sich die angebliche 1.000x‑Beschleunigung unabhängig verifizieren, und welche kommerziellen Vertriebs‑ und Supportwege stehen Unternehmen und Cloud‑Anbietern zur Verfügung? Darüber hinaus sind Zuverlässigkeit, MTBF (Mean Time Between Failures), Langzeitstabilität und die Wartbarkeit von photonischen Modulen für den Enterprise‑Einsatz kritische Faktoren.

Zu den kommerziellen Hürden zählen außerdem Zertifizierungsprozesse, Standardisierung von Schnittstellen, Entwickler‑Ökosysteme und die Notwendigkeit, Open‑Benchmarks sowie wissenschaftliche Publikationen vorzulegen. Ohne transparente Leistungsdaten und reproduzierbare Tests bleiben Aussagen über massive Geschwindigkeitsvorteile spekulativ. Unabhängige Benchmarks, Peer‑Reviewed‑Publikationen und Kooperationen mit etablierten Rechenzentrumsbetreibern würden die Glaubwürdigkeit deutlich erhöhen. Ebenso wichtig sind Robustheitsnachweise unter realen Betriebsbedingungen — etwa Temperaturschwankungen, Vibrationsanfälligkeiten, optische Kopplungsverluste, Fehlerraten und Fehlererkennung/-korrektur auf Systemebene.

China treibt offensichtlich an, westliche Wettbewerber im Bereich Quantencomputing zu überholen, und dieser photonische Chip signalisiert einen strategischen Vorstoß in Richtung optischer Quantenbeschleuniger. Ob er sich als weitverbreiteter Ersatz für elektronische KI‑Prozessoren durchsetzt, hängt von mehreren Faktoren ab: technischem Scale‑Up, reproduzierbaren Benchmarks, Kosten pro Leistungseinheit, Integration in bestehende KI‑Ökosysteme und letztlich der Akzeptanz durch Industrie und Forschung. Kurzfristig ist ein hybrider Einsatz am wahrscheinlichsten — photonische Module als spezialisierte Beschleuniger für bestimmte Klassen von Problemen, ergänzt durch klassische Elektronik für allgemeine KI‑Aufgaben.

Quelle: smarti

Kommentar hinterlassen