3 Minuten

Meta startet weltweiten Rollout der KI‑gestützten Sprachdubbing‑Funktion für Reels

Meta hat damit begonnen, seine KI‑basierte Voice‑Dubbing‑Funktion für Reels global auszurollen. Das Tool, das Mark Zuckerberg erstmals auf der Meta Connect 2024 vorstellte, nutzt generative KI, um die gesprochene Tonspur eines Creators in eine andere Sprache zu übersetzen und kann optional synchronisierte Lippenbewegungen hinzufügen, die zur übersetzten Audiospur passen.

Wesentliche Produktfunktionen

Übersetzung und Stimmklonung

Das Feature lernt aus deiner Originalstimme und erzeugt darauf basierend eine übersetzte Audiospur, die Tonfall und Sprechrhythmus erhält. Zum Start sind Übersetzungen nur zwischen Englisch und Spanisch in beide Richtungen verfügbar; Meta hat jedoch zusätzliche Sprachen für künftige Updates angekündigt.

Lippensynchronisation und Vorschau‑Kontrollen

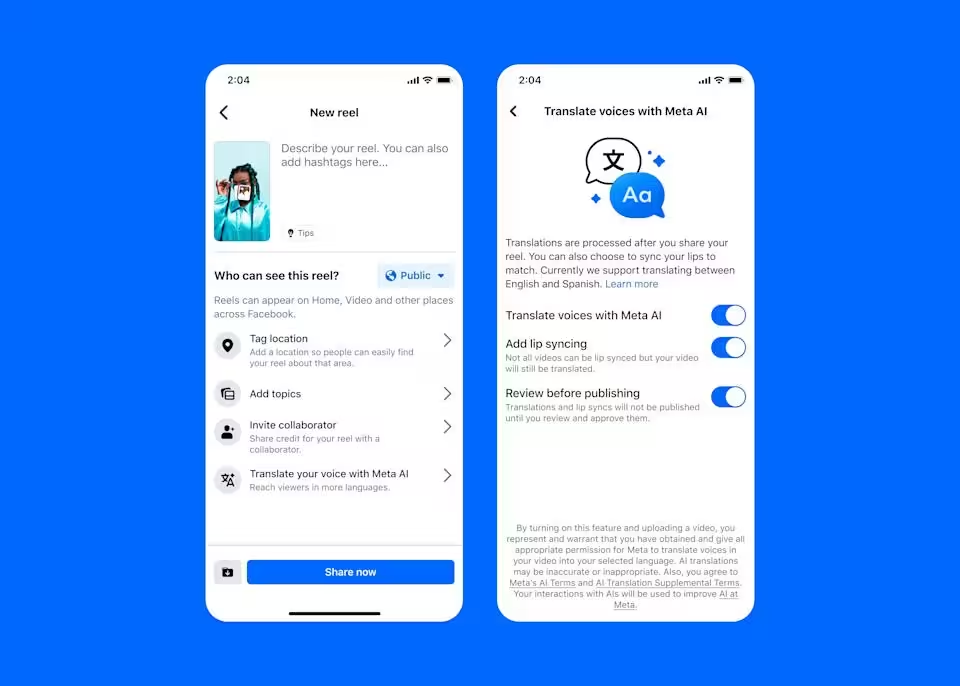

Creators können die Lippensynchronisation ein‑ oder ausschalten und die KI‑generierte Übersetzung vor der Veröffentlichung prüfen. Du kannst wählen, ob du Lip‑Sync hinzufügen möchtest, und vor dem Posten eine Vorschau ansehen. (Meta)

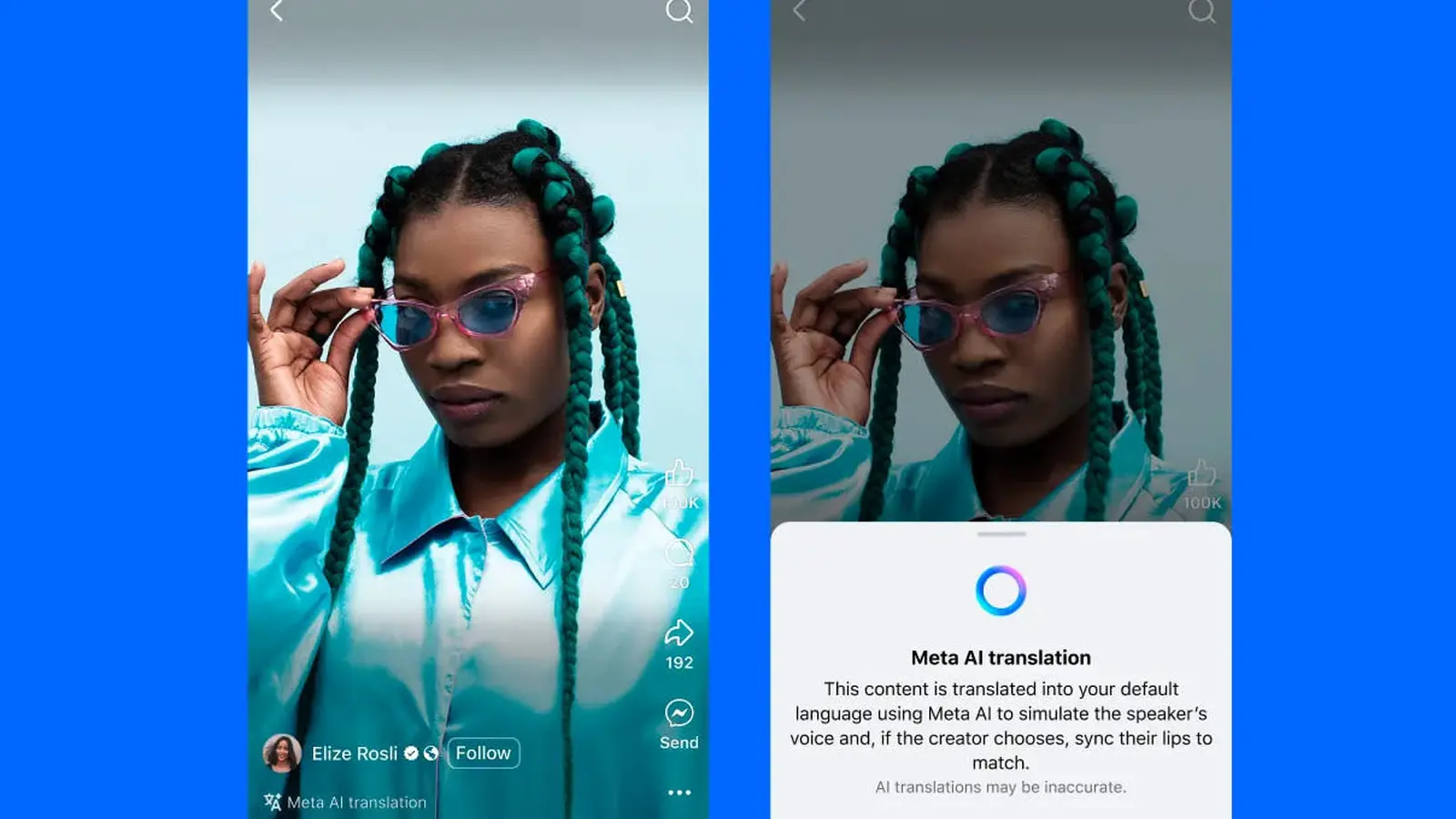

Zugriff und Berechtigung für Creator

Anfangs ist das Tool beim Posten nur für Facebook‑Creator mit mehr als 1.000 Followern freigeschaltet, während jede Person mit einem öffentlichen Instagram‑Account es nutzen kann. Um die Funktion anzuwenden, wähle beim Veröffentlichen eines Reels die Option "Translate your voice with Meta AI" — in diesem Menü findest du auch den Schalter für Lip‑Sync sowie die Vorschau‑/Überprüfungsoption. Zuschauer sehen ein deutliches Pop‑up, das den Clip als KI‑Übersetzung kennzeichnet.

Best Practices und technische Hinweise

Meta empfiehlt Videos mit direkter Kameraperspektive für beste Ergebnisse. Vermeide es, den Mund zu bedecken, und halte Hintergrundmusik möglichst dezent. Das System unterstützt bis zu zwei Sprecher, erzielt jedoch die besten Resultate bei nicht überlappender Rede. Diese Vorgaben helfen der generativen KI, die Genauigkeit und Natürlichkeit sowohl der übersetzten Audio‑ als auch der visuellen Synchronisation zu wahren.

Warum das wichtig ist — Vorteile und Marktbezug

Für Creator und Marken senkt die Echtzeit‑Stimmübersetzung mitsamt Lip‑Sync die Hürden, mehrsprachige Zielgruppen zu erreichen, verbessert die Lokalisierung von Inhalten und erhöht die Auffindbarkeit. Meta hat zudem einen leistungsbezogenen Tracker nach Sprache ergänzt, mit dem Creator Engagement und Conversion über verschiedene Übersetzungen hinweg beobachten können — ein wertvolles Analyseinstrument für globales Wachstum und Content‑Strategie.

Vergleich und Wettbewerbsumfeld

Metas Schritt folgt ähnlichen Angeboten großer Plattformen: YouTube brachte letztes Jahr Voice‑Translation‑Funktionen, und Apple integrierte Live‑Übersetzungen in Messages, Phone und FaceTime mit iOS 16/17/18 (die Erwähnung von iOS 26 zeigt die breitere Branchenentwicklung). Metas Alleinstellungsmerkmal ist die Kombination aus Stimmklonung, generativer KI‑Übersetzung und optionaler Lip‑Sync‑Funktion, die speziell auf Kurzform‑Reels abzielt.

Anwendungsfälle

- Influencer, die ihre Reichweite in spanisch‑ und englischsprachige Märkte ausdehnen.

- Marken, die Kampagnenvideos schnell lokalisieren, ohne neu drehen zu müssen.

- Pädagogen und Micro‑Publisher, die kurze Lektionen für neue Zielgruppen wiederverwenden.

Aussicht

Mit der Erweiterung um weitere Sprachen und der Verbesserung der Sprecherunterstützung könnte die Funktion zum Standardwerkzeug für globale Inhaltslokalisierung und Social‑Video‑SEO werden. Vorerst sollten Creator mit klarer Audioqualität und frontal ausgerichteten Aufnahmen testen, um die besten Ergebnisse zu erzielen.

Quelle: engadget

Kommentar hinterlassen