5 Minuten

Hintergrund: Von physikalischen Modellen zu riesigen Datensätzen

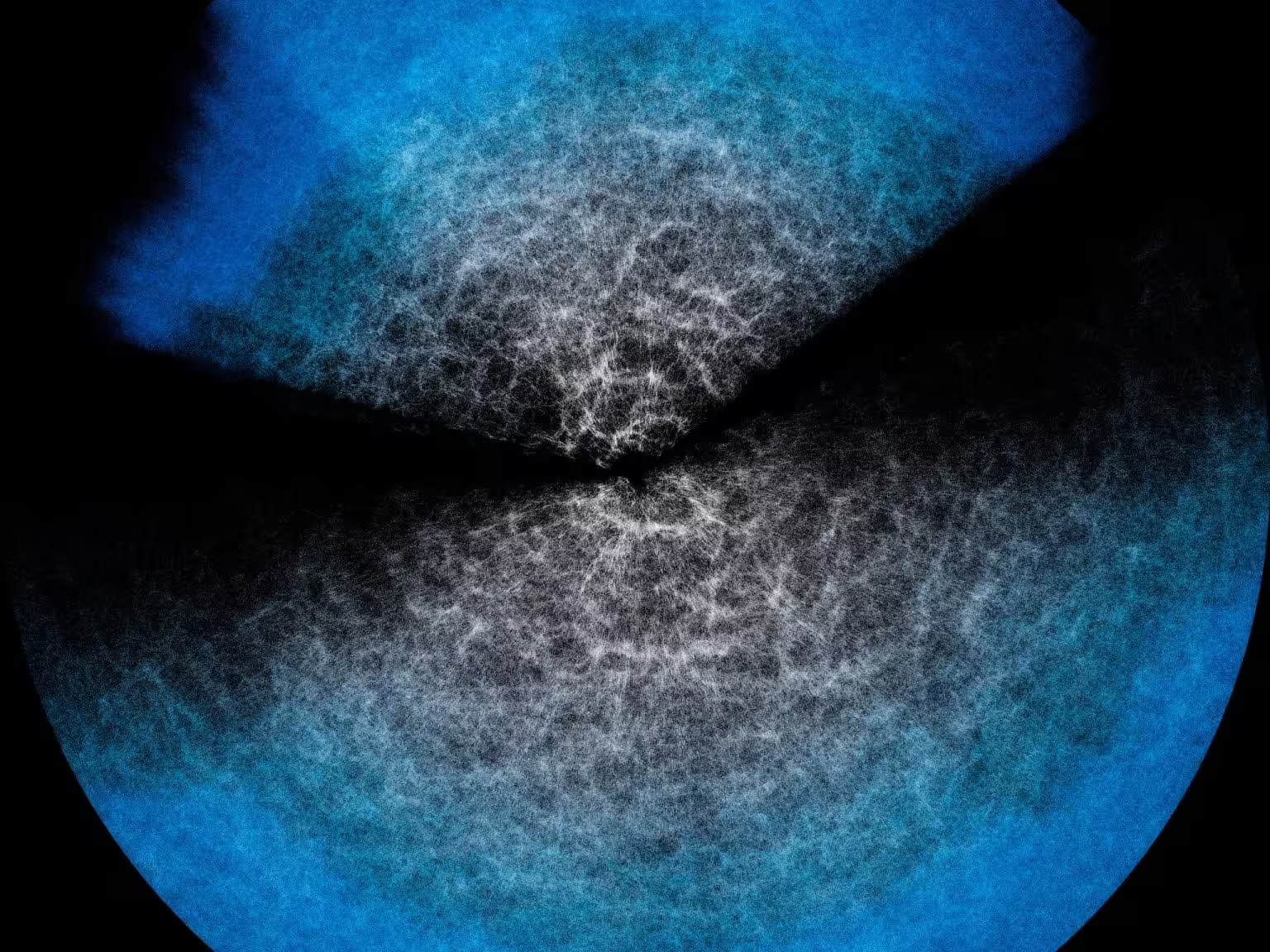

Die moderne Kosmologie verbindet Phänomene über enorme Skalen: die Large-Scale-Struktur des Universums ergibt sich aus mikroskopischen physikalischen Prozessen. Theoretische Modelle kodieren diese Verbindung und liefern statistische Vorhersagen für beobachtbare Muster von Galaxien, kosmischer Schwächung und anderen Messgrößen. In der Praxis speisen Astronominnen und Astronomen beobachtungsbezogene Eingaben in komplexe Codes, die die erwarteten Signale berechnen — ein Prozess, der rechenintensiv und zeitaufwändig sein kann.

Mit wachsenden Survey-Datensätzen wird eine vollständige Auswertung dieser theoretischen Modelle für jede Analyse unpraktisch. Laufende und bevorstehende Projekte wie das Dark Energy Spectroscopic Instrument (DESI), das bereits erste Daten veröffentlicht hat, und die Euclid-Mission der ESA werden Messdaten in deutlich größerem Umfang liefern. Volle Forward-Modell-Berechnungen wiederholt auszuführen, um Parameterbereiche zu erkunden oder Likelihood-Analysen durchzuführen, würde unverhältnismäßig große Rechenressourcen erfordern.

Wie Effort.jl Modellvorhersagen beschleunigt

Emulatoren sind eine praktische Lösung: Surrogatmodelle, die die Ausgaben teurer Codes deutlich schneller reproduzieren. Effort.jl ist ein Emulator-Framework mit einem neuronalen Netzwerkkern, der die Abbildung zwischen Eingabeparametern (etwa kosmologische Parameter, Bias- oder Störparameter) und den vorab berechneten Modellvorhersagen erlernt.

Erlernen der Modellantwort

Während des Trainings wird dem Netzwerk eine Reihe von Parameterkombinationen und die entsprechenden Modelloutputs gezeigt. Nach dieser Trainingsphase kann der Emulator generalisieren und sehr schnell präzise Vorhersagen für neue Parameterkombinationen liefern. Wichtigerweise ersetzt der Emulator nicht die zugrunde liegende Physik; er approximiert die numerische Reaktion des Modells, sodass Analystinnen und Analysten fast augenblicklich Vorhersagen für nachgelagerte Aufgaben wie Parameterschätzungen und Prognosestudien erhalten.

Integrierte Sensitivitäts- und Gradienteninformationen

Die Innovation von Effort.jl besteht darin, die benötigten Trainingsdaten zu reduzieren, indem Vorwissen darüber eingebracht wird, wie sich Vorhersagen bei Parameteränderungen verhalten. Der Code nutzt Gradienteninformationen — numerische Ableitungen, die Richtung und Betrag der Änderung beschreiben, wenn ein Parameter leicht gestört wird. Indem Effort.jl sowohl von Modelloutputs als auch von deren Gradienten lernt, wird vermieden, dass das Netzwerk bekannte Sensitivitäten neu erfinden muss. Das senkt die Anzahl notwendiger Trainingsbeispiele und den gesamten Rechenaufwand erheblich. Diese Effizienz macht es möglich, präzise Emulationen auf kleineren Rechnern durchzuführen und Analysen schneller zu iterieren.

Validierung, Genauigkeit und wissenschaftliche Bedeutung

Jeder Surrogatansatz muss sorgfältig validiert werden, bevor er für wissenschaftliche Inferenz vertrauenswürdig ist. Die jüngste Studie zur Validierung von Effort.jl zeigt eine starke Übereinstimmung zwischen den Emulator-Ausgaben und vollständigen Modellberechnungen sowohl in Simulationstests als auch mit realen Survey-Daten. Wo traditionelle Modellläufe Vereinfachungen oder Beschränkungen der Analyse erforderten, ermöglichte Effort.jl Forschenden, zuvor ausgelassene Komponenten aufzunehmen, ohne prohibitive Rechenkosten in Kauf zu nehmen.

Dieser praktische Vorteil ist relevant für Experimente wie DESI und Euclid. Beide Projekte zielen darauf ab, die großräumige Materieverteilung mit beispielloser Präzision zu messen, um Modelle für dunkle Energie, Gravitation und kosmische Inflation einzuschränken. Emulatoren wie Effort.jl ermöglichen eine tiefere, schnellere Erkundung des Parameterraums, robuste Unsicherheitsquantifizierung und die Einbeziehung vollständigerer physikalischer Bestandteile während der Inferenz.

Verwandte Technologien und Ausblick

Effort.jl ergänzt Fortschritte in Hochleistungsrechnen, differentiablem Programmieren und GPU-Beschleunigung. Die Kombination gradientinformierter Emulatoren mit automatischer Differentiation und moderner Hardware könnte Kosten weiter senken und die Genauigkeit erhöhen. Mit dem Wachstum von Survey-Volumina werden Emulator-Frameworks eine zentrale Rolle spielen, um zeitnahe wissenschaftliche Ergebnisse zu liefern.

Experteneinsicht

Dr. Alessia Rossi, eine Astrophysikerin, die mit Werkzeugen zur kosmologischen Inferenz vertraut ist, kommentiert: "Effort.jl stellt einen pragmatischen Fortschritt dar. Durch die Nutzung von Gradienten und domänenspezifischem Wissen reduziert es die Trainingslast und bewahrt gleichzeitig die Treue zum zugrunde liegenden Modell. Für große Surveys bedeutet das, dass vollständigere Analysen ausgeführt werden können, ohne wochenlange Rechenzeiten abzuwarten." Diese Art hybrider Ansätze — die physikbasierte Modelle mit maschinellen Lernsurrogaten kombinieren — dürfte bei kommenden Datenveröffentlichungen zur Standardpraxis gehören.

Fazit

Effort.jl veranschaulicht, wie Emulator-Techniken die Lücke zwischen rechenintensiven theoretischen Modellen und den von Next-Generation-Surveys erwarteten Datenmengen überbrücken können. Durch die Nutzung von Gradienteninformationen und Vorwissen über Modell-Sensitivitäten erzielt der Emulator präzise, ressourceneffiziente Vorhersagen, die in Validierungstests mit Vollmodell-Ausgaben übereinstimmen. Für Projekte wie DESI und Euclid werden Werkzeuge wie Effort.jl Analysezyklen beschleunigen, die Einbeziehung reichhaltigerer Modellkomponenten ermöglichen und dazu beitragen, den wissenschaftlichen Nutzen umfangreicher kosmologischer Datensätze zu maximieren.

Quelle: scitechdaily

Kommentare