6 Minuten

Eine überraschende Erkenntnis aus einer gemeinsamen Studie der University of Maryland und Microsoft: Polnisch übertraf 25 andere Sprachen und erwies sich als die effektivste Sprache für das Prompting großer KI-Modelle, während Englisch nur den sechsten Platz belegte. Diese Beobachtung stellt gängige Annahmen zur Dominanz des Englischen bei der Interaktion mit großen Sprachmodellen in Frage und eröffnet neue Perspektiven für mehrsprachige KI-Anwendungen, Prompt-Engineering und die Bewertung von Modelleigenschaften über verschiedene Sprachen hinweg.

Wie die Forschenden die Sprachleistung mit KI testeten

Das Forschungsteam fütterte mehrere große Sprachmodelle mit identischen Prompts, die in 26 Sprachen übersetzt wurden — darunter Modelle von OpenAI, Google Gemini, Qwen, Llama und DeepSeek — und maß die Aufgaben- sowie Antwortgenauigkeit systematisch. Die Methodik umfasste standardisierte Aufgaben aus Bereichen wie Textverständnis, Informationsabruf, Instruktionsbefolgung und längere Textgenerierung, wobei dieselben inhaltlichen Instruktionen sprachlich äquivalent übertragen wurden, um Verzerrungen durch semantische Unterschiede zu minimieren. Entgegen der Erwartungen lag Polnisch mit einer durchschnittlichen Aufgabengenauigkeit von 88 % an der Spitze.

Die Autorinnen und Autoren des Berichts bezeichneten die Ergebnisse als „unerwartet“ und betonten, dass Englisch nicht automatisch als universelle Referenzsprache fungiert. In Bewertungen mit längeren Texten erreichte Englisch nur den sechsten Rang, während Polnisch vorne lag. Solche Resultate unterstreichen, dass die Wahl der Sprache einen direkten Einfluss auf die Qualität und Zuverlässigkeit der Modellantworten haben kann, was sowohl für Forschung als auch für praktische Anwendungen wichtig ist.

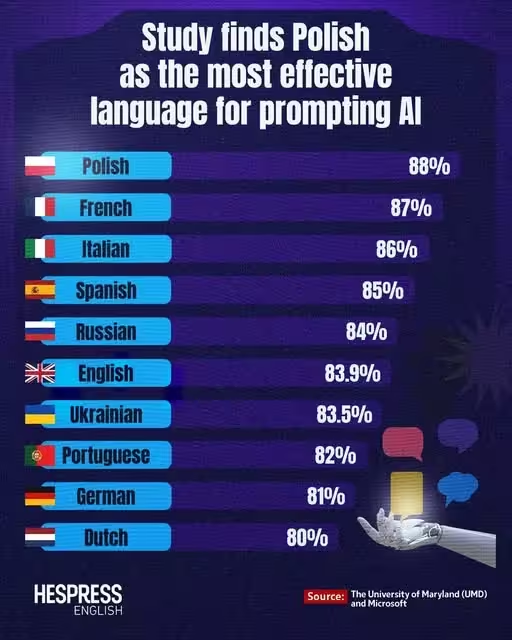

Top-Sprachen für KI-Prompting — das Leaderboard der Studie

Im Folgenden sind die zehn am besten abschneidenden Sprachen aus der Studie nach durchschnittlicher Genauigkeit aufgeführt. Die Rangfolge zeigt, dass mehrere europäische Sprachen sehr gut abschneiden, was Rückschlüsse auf Tokenisierungsstrategien, morphologische Eigenschaften und Trainingsdatenverteilung zulässt.

- Polnisch — 88%

- Französisch — 87%

- Italienisch — 86%

- Spanisch — 85%

- Russisch — 84%

- Englisch — 83.9%

- Ukrainisch — 83.5%

- Portugiesisch — 82%

- Deutsch — 81%

- Niederländisch — 80%

Warum könnte Polnisch für KI-Prompts besser sein?

Mehrere Theorien können dieses kontraintuitive Ergebnis erklären. Polnisch ist morphologisch reich und weist vergleichsweise konsistente Orthografieregeln auf, was dazu führen kann, dass Token — also die Einheiten, mit denen Transformer-Modelle arbeiten — klarer und stabiler gebildet werden. Bei Subword-Tokenisierungen wie Byte-Pair Encoding (BPE) oder Unigram-Tokenizern können häufige Morpheme und Wortstämme in polnischen Formen zu vorteilhaften Token-Verteilungen führen. Das bedeutet: Selbst bei einem geringeren Volumen an polnischen Trainingsbeispielen können die resultierenden Tokenrepräsentationen für bestimmte Instruktionen effizienter sein.

Ein weiterer Faktor ist Ambiguität und Formulierung: Manche Sprachen zwingen durch ihre Grammatik explizitere semantische oder syntaktische Signale auf, wodurch die Wahrscheinlichkeit sinkt, dass ein Modell die Intention des Prompts falsch interpretiert. Beispielsweise können Fälle, Flexionsmuster oder präzisere Wortordnungen dazu beitragen, Referenzen und Rollen im Satz eindeutiger zu markieren — ein Vorteil, wenn ein Modell pragmatische oder referentielle Entscheidungen treffen muss. Die Studie deutet außerdem an, dass eine Sprache, die für Menschen als „schwer zu lernen“ gilt, nicht zwangsläufig schwerer für KI ist: Modelle erkennen und nutzen strukturelle Muster unabhängig davon, wie intuitiv diese für menschliche Lernende erscheinen.

Im Gegensatz dazu belegte Chinesisch in dieser Bewertung einen der hinteren Plätze (vierte von hinten), was zeigt, dass ein großes Trainingsdatenvolumen allein die Prompt-Performance in einer Sprache nicht garantiert. Faktoren wie Segmentation, Schriftsystem (logographisch vs. alphabetisch), Tokenisierungsmethoden sowie die Qualität und Domänenabdeckung der Trainingskorpora spielen eine entscheidende Rolle. Hinzu kommen Unterschiede in Datensätzen, die für bestimmte Sprachen verfügbar sind, z. B. Presse, Web-Dumps, Bücher oder fachliche Texte, die die Generalisierungsfähigkeit eines Modells beeinflussen.

Implikationen für Prompt-Engineering und mehrsprachige KI

Welche Schlussfolgerungen sollten Entwicklerinnen, Forschende und Prompt-Ingenieurinnen daraus ziehen? Die Studie hat mehrere praktische und methodische Implikationen, die sowohl die Entwicklung als auch den Einsatz großer Sprachmodelle betreffen.

- Gehen Sie nicht automatisch davon aus, dass Englisch immer am besten ist: Testen Sie Prompts in mehreren Sprachen — Sie könnten überraschend präzisere, knappere oder robustere Antworten in einer unerwarteten Sprache erhalten.

- Berücksichtigen Sie Morphologie und Tokenisierungseffekte bei der Gestaltung multilingualer Benchmarks oder Feinabstimmungs-Datensätze: Unterschiedliche Tokenizer-Strategien können zu erheblichen Leistungsschwankungen führen, daher lohnt sich eine Analyse der Token-Verteilung und -Länge für jede Zielsprache.

- Für internationale Rollouts: Evaluieren Sie das Modellverhalten in den Zielsprachen direkt, anstatt von englischsprachigen Tests auf andere Sprachen zu extrapolieren. Cross-linguale Validierung, Domänenadaption und lokalisiertes Prompt-Tuning sind entscheidend, um verlässliche Ergebnisse zu erzielen.

Die Polnische Patentbehörde (Urząd Patentowy) veröffentlichte sogar in sozialen Medien, dass die Ergebnisse zeigen, Polnisch sei die präziseste Sprache, um KI-Anweisungen zu geben, und fügte mit einem Augenzwinkern hinzu: Menschen könnten Polnisch als schwierig empfinden, aber diese Schwierigkeit teilt die KI nicht. Solche öffentlichen Reaktionen unterstreichen das mediale Interesse an Sprachunterschieden bei KI-Systemen und betonen zudem die Notwendigkeit einer differenzierten Kommunikation über Forschungsergebnisse und ihre praktischen Konsequenzen.

Was kommt als Nächstes?

Die Forschenden betonen, dass dies nicht das letzte Wort ist — weitere Untersuchungen sind nötig, um besser zu verstehen, wie Tokenisierung, Verteilung der Trainingsdaten und linguistische Strukturen das Verhalten von Modellen beeinflussen. Zukünftige Studien sollten kontrollierte Experimente zur Token-Länge, Subword-Segmentierung, Domänenbalance und zu feingranularen morphosyntaktischen Merkmalen enthalten. Ebenfalls sinnvoll sind A/B-Tests, die unterschiedliche Tokenizer-Konfigurationen, verschiedene Präprozessingschritte und hybride Trainingsstrategien (z. B. multilingual pretraining gefolgt von language-specific fine-tuning) vergleichen.

Darüber hinaus regt die Studie an, die Community sollte:

- robustere, mehrsprachige Benchmarks entwickeln, die linguistische Vielfalt abbilden und nicht nur auf Englisch basieren;

- Tokenisierungs- und Embedding-Analysen durchführen, um zu verstehen, welche sprachlichen Eigenschaften predictive Features für Modellentscheidungen sind;

- Explorative Arbeiten zu Cross-lingual Transfer und Few-shot-Lernen betreiben, speziell für Sprachen mit weniger Ressourcen, um die Kosten-Nutzen-Relation von Datensammlung versus Tokenizer-Anpassung zu bewerten;

Technisch gesehen könnten Änderungen an Tokenizern, etwa die Verwendung adaptiver Subword-Modelle, die Integration von linguistischen Segmentierungsregeln oder die Ergänzung durch phonetische / morphologische Features, die Performance in bestimmten Sprachen weiter verbessern. Für Betreiber von Sprachmodell-APIs empfiehlt sich zudem, mehrsprachige Evaluationspipelines zu implementieren, die Metriken wie Genauigkeit, Konsistenz, Bias-Indikatoren und Robustheit gegenüber Formulierungsvarianten umfassen.

Insgesamt fordert die Studie die KI-Community dazu auf, Annahmen zu hinterfragen und breit zu experimentieren, wenn es darum geht, Prompts für mehrsprachige Modelle zu optimieren. Praktikerinnen und Forscher sollten die sprachspezifischen Eigenschaften als Teil der Modell- und Evaluationsstrategie betrachten, um bessere, gerechtfertigtere und verlässlichere Ergebnisse für unterschiedliche Nutzergruppen zu erzielen.

Quelle: smarti

Kommentar hinterlassen