3 Minuten

Huawei entwickelt laut Berichten eine für KI optimierte SSD, die HBM herausfordern soll

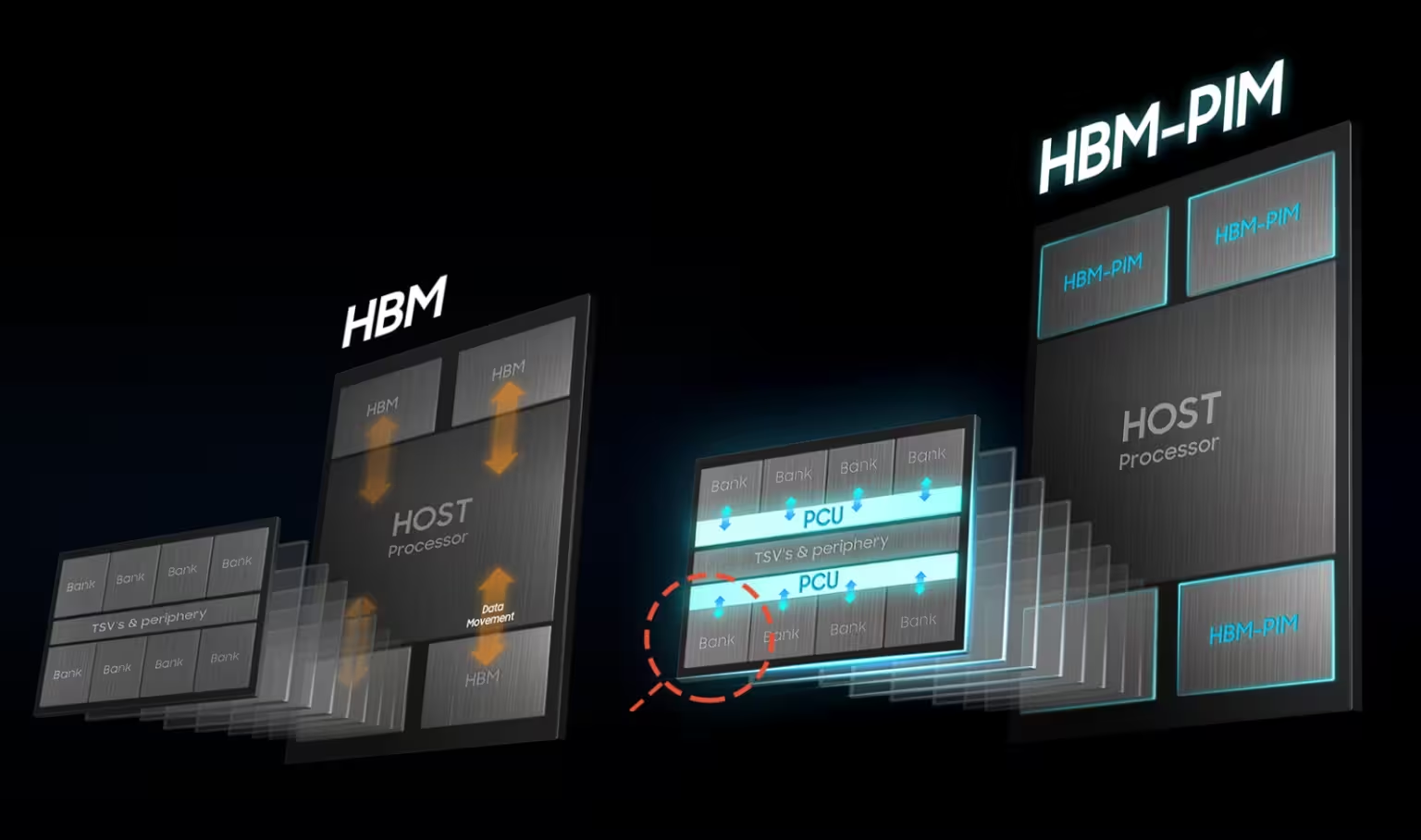

Chinesische Medienberichte behaupten, dass Huawei einen dedizierten "KI-Speicher" entwickelt — beschrieben als Solid-State-Drive (SSD), das speziell auf Datacenter-KI-Workloads abgestimmt ist. Die angebliche KI-SSD soll HBM-ähnlichen Durchsatz und Effizienz liefern und gleichzeitig traditionelle Kapazitätsgrenzen aufheben, wodurch sie eine praktikable Alternative zu High-Bandwidth Memory (HBM) bieten und Huaweis Abhängigkeit von westlichen Lieferketten verringern könnte.

Produktmerkmale: Was die KI-SSD voraussichtlich bieten wird

Skalierbare Kapazität ohne harte Grenzen

Den Berichten zufolge zielt die KI-SSD darauf ab, die engen Kapazitätsbeschränkungen von HBM-Stacks zu beseitigen und deutlich größere effektive Speichermengen für das Training und die Inferenz großer Sprachmodelle (LLMs) zu ermöglichen.

Datacenter-Optimierung und Effizienz

Das Laufwerk soll angeblich für KI-spezifische Zugriffsprofile optimiert sein und niedrige Latenz, hohen Durchsatz sowie Haltbarkeitsprofile priorisieren, die für intensive Trainingslasten geeignet sind — Eigenschaften, die es über eine standardmäßige NVMe-SSD hinausheben.

Software-Seite: UCM (Unified Cache Manager) und Speicherochestrierung

Parallel zur Hardwarearbeit hat Huawei eine Unified Cache Manager (UCM)-Software-Suite vorgestellt, die das Training von LLMs beschleunigen soll, indem HBM, DRAM und SSD-Ressourcen zusammengeführt werden. UCM kann Tensoren transparent über mehrere Speichertypen hierarchisch verwalten und cachen, wodurch nutzbarer Speicher für KI-Workloads erweitert wird, selbst wenn Hochbandbreitenmodule begrenzt sind.

Vergleich: KI-SSD vs. HBM, DRAM und Standard-SSDs

HBM bleibt in Sachen Rohbandbreite pro Watt und der engen Nähe zu GPUs/Acceleratoren unerreicht, ist jedoch teuer und geopolitisch sensibel. Standard-DRAM bietet niedrigere Latenzen als SSDs, ist aber in Kosten und Kapazitätsskalierung begrenzt. KI-SSDs versprechen einen Mittelweg: deutlich höhere Kapazität als HBM zu geringeren Kosten, verbesserte Bandbreite für KI-Zugriffsmuster gegenüber konventionellen SSDs und nahtlose Integration über Software wie UCM.

Vorteile, Anwendungsfälle und Markt-Relevanz

Vorteile umfassen Resilienz der Lieferkette, größere Kapazitäten für LLMs und potenzielle Kosteneinsparungen für Hyperscaler und Cloud-Anbieter. Anwendungsfälle reichen vom großskaligen Modelltraining über verteilte Inferenz-Cluster bis hin zu Rechenzentrums-Speicherpools. Strategisch könnte eine praktikable KI-SSD dem chinesischen KI-Hardware-Ökosystem helfen, den Abstand zu Marktführern wie NVIDIA zu verringern, indem alternative Speicherhierarchien unter Exportbeschränkungen angeboten werden.

Einschränkungen und Ausblick

Details zur Architektur, Latenzstatistiken und realen Benchmarks sind noch nicht offengelegt. Behauptungen über das Aufheben von Kapazitätsgrenzen und das Erreichen von HBM-Effizienz bedürfen unabhängiger Validierung. Dennoch deutet Huaweis kombinierter Hardware- und Softwareansatz — KI-SSD zusammen mit UCM — auf einen pragmatischen Weg hin, AI-Speicher angesichts geopolitischer Beschränkungen zu skalieren.

Quelle: wccftech

Kommentare