7 Minuten

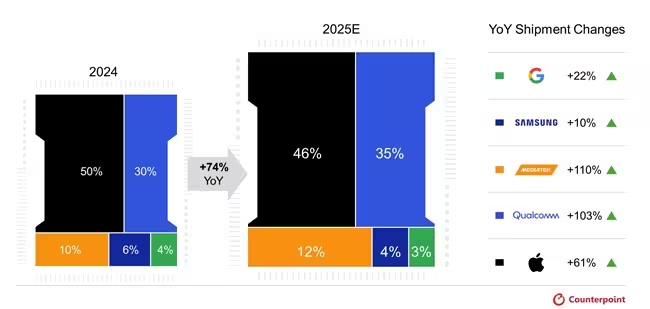

GenAI-fähige Smartphone-SoCs stehen 2025 vor einem kräftigen Schub: Counterpoint Research prognostiziert, dass diese Prozessoren 35% der gesamten Smartphone-SoC-Lieferungen ausmachen werden. Die breitere Verfügbarkeit von On-Device-AI-Funktionen sowohl in High-End- als auch in Mittelklassegeräten treibt die rasche Verbreitung voran und sorgt für starkes Wachstum gegenüber dem Vorjahr. Nutzer profitieren zunehmend von lokal laufenden Sprachmodellen und assistentenähnlichen Funktionen, die Latenzen senken und Privatsphäre verbessern, weil weniger Daten in die Cloud gesendet werden müssen.

Marktprognose und treibende Faktoren

Counterpoints Q2 2025 Global Smartphone AP-SoC Shipment & Forecast Tracker geht von einem Anstieg der GenAI-fähigen SoC-Lieferungen um 74% im Jahresvergleich aus. Diese Erwartung spiegelt die steigende Nachfrage nach On-Device-Sprachmodellen, multimodalen KI-Anwendungen (Bild-, Audio- und Textkombinationen) sowie nach funktionsreicheren Assistenzsystemen wider. Hersteller integrieren größere NPUs (Neural Processing Units) und fortschrittlichere CPU-/GPU-Kerne, sodass Smartphones immer komplexere KI-Modelle lokal ausführen können. Das verringert nicht nur die Reaktionszeit, sondern bietet auch bessere Datenschutzoptionen im Vergleich zu rein Cloud-basierten Lösungen.

Mehrere technische und marktbezogene Faktoren treiben dieses Wachstum. Erstens ermöglichen Fortschritte in der Chip-Architektur höhere TOPS-Werte (Tera Operations Per Second) pro Watt, was effizientere KI-Inferenz auf dem Gerät erlaubt. Zweitens schaffen verbesserte Software-Stacks und kompakte LLM-Optimierungen (Quantisierung, Pruning, Knowledge Distillation) die Voraussetzung, dass große Sprachmodelle auf mobilen NPUs praktikabel laufen. Drittens fördern OEM- und Plattform-Integrationen — etwa native API-Schichten und On-Device-Orchestratoren — die Bereitstellung konsistenter GenAI-Erlebnisse über verschiedene Geräteklassen hinweg.

Auch ökonomische und produktstrategische Aspekte spielen eine Rolle: Hersteller sehen in On-Device-GenAI ein starkes Differenzierungsmerkmal, das sich direkt auf Nutzerbindung, Service-Monetarisierung und Markenwahrnehmung auswirkt. Gleichzeitig treiben Fertigungsverbesserungen auf fortschrittlichen Nodes (etwa 4 nm und darunter) sowie steigende Investitionen in spezialisierte KI-IP die Verfügbarkeit leistungsfähigerer SoCs in höheren Stückzahlen voran. Zusammen bedeuten diese Trends, dass On-Device-AI nicht mehr ausschließlich ein Merkmal teurer Flaggschiffe bleibt, sondern in immer mehr Preissegmente Einzug hält.

Wer führt das GenAI-SoC-Segment an

Für 2025 wird erwartet, dass Apple etwa 46% des GenAI-SoC-Marktes kontrolliert, Qualcomm rund 35% und MediaTek etwa 12%. Jeder Anbieter verfolgt dazu eine eigene Strategie, die sowohl Hardware- als auch Software-Innovationen umfasst. Die Marktanteile spiegeln nicht nur die Produktionskapazitäten wider, sondern auch Unterschiede in Ökosystemen, Partnernetzwerken und Integrationsfähigkeiten.

- Apple kombiniert on-device-Modelle mit Cloud-Optionen und bietet beispielsweise ein lokal laufendes Sprachmodell mit rund 3 Milliarden Parametern sowie größere cloudbasierte Modelle über Private Cloud Compute auf Apple-Silicon-Servern an. Apple integrierte zudem ChatGPT in iOS, iPadOS und macOS durch eine Partnerschaft mit OpenAI, wodurch Anwender nahtlos zwischen lokalem und Cloud-basiertem Processing wechseln können. Apples Ansatz legt großen Wert auf enge Hardware-Software-Koordination, sichere Enklaven für Schlüsselverwaltung und Energiemanagement zur Gewährleistung langer Batterielaufzeiten bei intensiver AI-Nutzung.

- Qualcomm bietet ein AI Orchestrator-Framework, das Geräteherstellern ermöglicht, GenAI-Dienste zu liefern, ohne selbst die gesamte LLM-Infrastruktur oder eine tiefe Hardware-/Softwareintegration managen zu müssen. Die Plattform unterstützt heterogene Ausführung — also die Verteilung von Workloads auf CPU, GPU und NPU — und vereinfacht die Nutzung von Cloud-Fallbacks für rechenintensive Aufgaben. Qualcomms Strategie fokussiert auf breite Kompatibilität und Partner-Ökosysteme, sodass OEMs schneller mit differenzierten GenAI-Features auf den Markt kommen können.

- MediaTek setzt auf seine NeuroPilot-Software, die Arbeitslasten zwischen CPU, GPU und NPU automatisch zuteilt, und arbeitet eng mit chinesischen OEMs zusammen, um On-Device-GenAI optimal bereitzustellen. MediaTeks Ansatz ist stark praxisorientiert: durch enge Abstimmung mit App- und OS-Entwicklern sollen Modelle so skaliert werden, dass sie in der Mittelklasse effiziente Rechenleistung, akzeptable Wärmeentwicklung und gute Batterielebensdauer bieten. Darüber hinaus investiert MediaTek in Referenz-Stacks und Tools, damit Partner schneller angepasste GenAI-Funktionen implementieren können.

Premium-Chips treiben Leistung und Preisgestaltung

Die Auslieferungen von Premium-GenAI-SoCs sollen im Jahresvergleich um 53% steigen; 88% der Premium-SoCs werden voraussichtlich 2025 GenAI unterstützen. Zu den führenden Modellen, die diesen Wandel beschleunigen, gehören beispielsweise Apple A19/A19 Pro, Qualcomm Snapdragon 8 Elite Gen 5 und MediaTek Dimensity 9500. Diese Chips integrieren größere NPUs, schnellere Speicherkanäle und spezialisierte Beschleuniger für neuronale Netze, wodurch sie komplexe multimodale Modelle effizient verarbeiten können.

Research-Analystin Shivani Parashar weist darauf hin, dass die Spitzen-AI-Compute-Kapazität in Premium-SoCs 2025 Werte von bis zu etwa 100 TOPS erreichen könnte — fast viermal so hoch wie 2021. Solche Zuwächse schlagen sich in höheren durchschnittlichen Verkaufspreisen nieder, weil Marken auf fortschrittliche Fertigungstechnik umsteigen, mehr Halbleiter-Inhalt integrieren und zusätzliche Komponenten für Leistung und Kühlung benötigen. Unternehmen argumentieren jedoch, dass die höheren Kosten durch verbesserte Nutzererlebnisse, neue Services und potenzielle Einnahmequellen wie abonnementbasierte AI-Features gerechtfertigt werden.

Technisch betrachtet kombinieren Premium-SoCs mehrere Optimierungsansätze: bessere Quantisierungsverfahren für Modelle, hardware-nahe Laufzeitoptimierungen, effizientere Datentransfers zwischen Speicherhierarchien und adaptive Frequenzsteuerungen, die Spitzenleistung liefern, ohne die Thermik zu destabilisieren. Für Endnutzer bedeuten diese Fortschritte schnellere Antworten von Sprachassistenten, intelligentere Kamerafunktionen (z. B. Kontextverstehen in Echtzeit) und flüssigere Multimodal-Interaktionen, die Bild, Sprache und Text kombinieren.

Mittelklasse-Adoption gewinnt an Geschwindigkeit

Im Preisbereich von 300–499 US-Dollar dürften sich die Lieferungen von GenAI-fähigen SoCs 2025 im Jahresvergleich verdreifachen und etwa 38% dieses Segments ausmachen. Qualcomm führt in der Mittelklasse mit einem Anteil von rund 57%, gestützt durch die Snapdragon 700- und 6er-Serien, während MediaTeks Dimensity-8000-Familie den Einsatz von On-Device-GenAI in der Mittelklasse beschleunigte. Diese Entwicklung ist entscheidend, damit GenAI-Funktionen für einen breiteren Nutzerkreis verfügbar werden.

Analyst Parv Sharma betont, dass SoC-Anbieter LLMs und KI-Modelle speziell für Mittelklasse-Hardware optimieren, damit Hersteller reichhaltigere AI-Erlebnisse bieten können, ohne die Batterielaufzeit oder thermische Stabilität zu opfern. Solche Optimierungen umfassen reduzierte Präzision (bspw. INT8/INT4), effizientes Layer-Folding, dynamische Modell-Pfadanpassungen und Model-Slicing, sodass typische On-Device-Aufgaben mit deutlich weniger Rechenaufwand erreichbar sind.

Die Verlagerung von GenAI in die Mittelklasse hat auch wirtschaftliche Effekte: Komponentenhersteller und OEMs können von Skaleneffekten profitieren, Service-Ökosysteme wachsen schneller, und App-Entwickler sehen eine größere Basis an Geräten, die leistungsfähige KI-Funktionen unterstützen. Darüber hinaus werden lokale Datenschutzfunktionen in vielen Märkten zunehmend zu einem Differenzierungsfaktor — besonders in Regionen mit strengen Datenschutzvorgaben bleibt On-Device-Processing ein Vorteil.

Fazit

Insgesamt deutet vieles darauf hin, dass 2025 ein Wendepunkt für mobile GenAI wird: stärkere On-Device-Rechenleistung, breitere OEM-Unterstützung und tiefgreifende Plattform-Integrationen verwandeln GenAI von einem Premium-Unterscheidungsmerkmal zu einer mainstreamtauglichen Smartphone-Funktion. Während SoC-Anbieter weiterhin an der Balance zwischen Leistung und Energieeffizienz arbeiten, ist damit zu rechnen, dass GenAI-Fähigkeiten in den kommenden Jahren weiter in günstigere Preisstufen vordringen werden.

Für Verbraucher bedeutet dies konkreter Nutzen: schnellere, privatere und kontextsensible Assistenzfunktionen; für Entwickler und Hersteller entstehen neue Chancen für innovative Dienste, Personalisierung und Monetarisierung. Die nächsten Entwicklungsphasen werden zeigen, wie sich Software-Ökosysteme, regulatorische Rahmenbedingungen und Nutzererwartungen gegenseitig beeinflussen, doch die Richtung ist klar: On-Device-GenAI wird zu einem grundlegenden Bestandteil moderner Smartphone-Erlebnisse.

Quelle: fonearena

Kommentar hinterlassen