7 Minuten

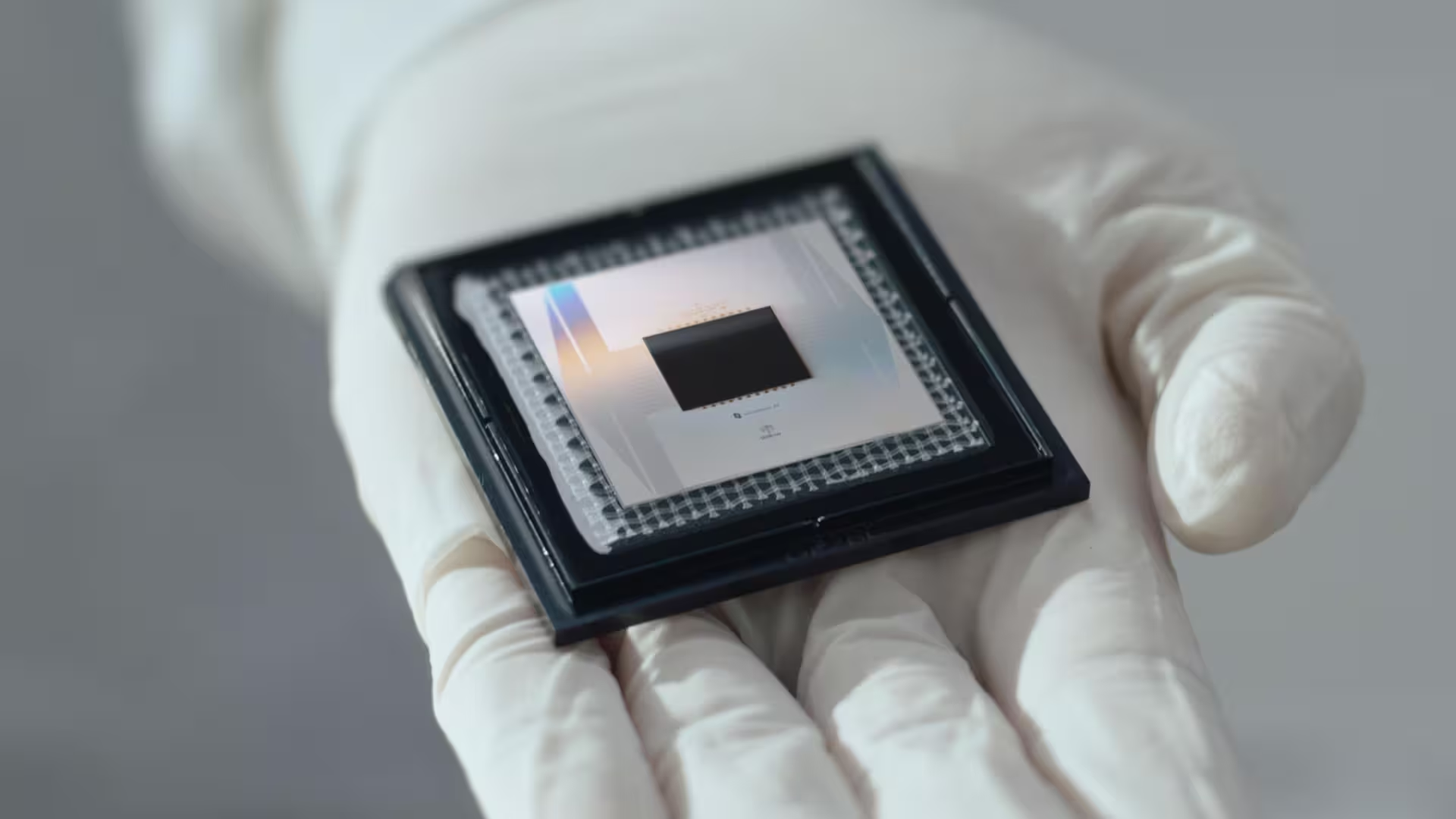

Das Quantum‑AI‑Team von Google hat Willow vorgestellt, einen supraleitenden Prozessor mit 105 Qubits, der nach Angaben des Unternehmens bestimmte Berechnungen schneller als heutige Supercomputer ausführt – und zwar um den Faktor von etwa 13.000. Die Ergebnisse wurden in Nature veröffentlicht und gelten als eine der klarsten Demonstrationen von Quantenüberlegenheit (Quantum Advantage) in einem praktisch durchgeführten Experiment.

Mehr als eine Schlagzeile: Was Willow tatsächlich gemacht hat

Willow führte den sogenannten Quantum Echoes‑Algorithmus aus, einen Test, der konzipiert wurde, um Quantenchaos und die komplexe Dynamik von Vielteilchen‑Quantensystemen zu untersuchen. Im Unterschied zu Googles Sycamore‑Demonstration von 2019 – die eine sehr spezialisierte Zufalls‑Sampling‑Aufgabe adressierte – lässt sich Willows Durchlauf direkter auf wissenschaftliche Anwendungsfälle abbilden, beispielsweise auf die hochauflösende Simulation molekularer Strukturen und elektronischer Wechselwirkungen.

Der Quantum Echoes‑Algorithmus ist so gestaltet, dass er empfindlich auf Wechselwirkungen, Verschränkung und Kohärenzzeiten reagiert. Durch das gezielte Erzeugen und Messen von Echos in einem verschränkten Vielteilchensystem können Forschende Rückschlüsse auf die chaotische Entwicklung des Systems und die Grenzen klassischer Simulationen ziehen. Die Messungen liefern Verteilungen und Korrelationen, die für klassische Computer exponentiell teuer zu berechnen sind, wenn die Systemgröße ansteigt.

Quantum Echoes‑Algorithmus: Zweck und Methodik

Technisch betrachtet kombiniert Quantum Echoes zufällig erzeugte Schaltkreise mit gezielten Rückspulen (Echo‑Sequenzen), um Fehlerkomponenten zu isolieren und gleichzeitig die inhärente Dynamik des Systems zu exponieren. Dadurch wird das Verhalten von Vielteilchensystemen in einem Modus analysiert, der näher an konkreten Quantenchemie‑ oder Materialsimulationen liegt als reine Zufallsprobennahme. Für die Bewertung des Ergebnisses nutzt das Team statistische Metriken, die klassische Rechenverfahren überfordern, sobald die Zahl der Qubits und die Tiefe der Schaltkreise wachsen.

Darüber hinaus hat die Willow‑Studie Validierungsverfahren implementiert, die sicherstellen, dass die beobachteten Ergebnisse reproduzierbar und nicht allein auf Messartefakte zurückzuführen sind. Peer‑Review und offene Methodik in der Veröffentlichung stärken die Glaubwürdigkeit und machen die Daten für die Community nutzbar.

Nach Angaben des Teams können sich alle 105 supraleitenden Qubits von Willow in Überlagerungszuständen befinden und miteinander verschränkt werden, sodass der Chip eine enorme Anzahl von Möglichkeiten parallel erkundet. Die Hardware erreicht extrem niedrige Fehlerquoten: Die Ein‑Qubit‑Gate‑Fidelity liegt bei etwa 99,97 % und Zwei‑Qubit‑Verschränkungsoperationen nahe 99,88 %. Diese Kennzahlen sind entscheidend, um akkumulierte Fehler zu begrenzen, während die Schaltkreistiefe zunimmt.

Solche hohen Gate‑Fidelities bedeuten längere effektive Kohärenzfenster für komplexe Berechnungen. In Verbindung mit optimierten Pulsformen, verbesserten Kalibrierungsalgorithmen und fortschrittlichem Crosstalk‑Management kann ein supraleitender Prozessor wie Willow stabilere und aussagekräftigere Messungen liefern, die sich auf reale wissenschaftliche Fragestellungen übertragen lassen.

Warum Forschende begeistert — und vorsichtig bleiben

Michel Devoret, einer der leitenden Physiker des Projekts, beschrieb den Prozessor als Beleg dafür, dass ingenieurmäßig gestaltete elektrische Schaltkreise wie "künstliche Atome" wirken können. Willow eröffne damit ein Labor für das Studium atomarer Wechselwirkungen, ohne auf manche üblichen Näherungen angewiesen zu sein. Das ist mehr als Produktmarketing: Höhere Fidelity und stärkere Verschränkung bedeuten, dass Quanten‑Hardware Simulationen angehen kann, die klassische Rechner nur mit großem Aufwand oder gar nicht effizient modellieren können.

Forschende erkennen mehrere Bereiche, in denen verbesserte Quantensimulationen praktische Auswirkungen haben könnten:

- Quantenchemie und Wirkstoffentwicklung: präzisere Modellierung chemischer Reaktionspfade und Übergangszustände, was die Lead‑Optimierung beschleunigen kann.

- Materialforschung: Simulationen für Festkörper, Batteriematerialien oder Hochtemperatur‑Supraleiter, die neue Einsichten in elektronische Korrelationsphänomene liefern.

- Optimierung und KI‑Beschleunigung: bestimmte kombinatorische Optimierungsaufgaben und Heuristiken in maschinellen Lernverfahren könnten energieeffizienter umgesetzt werden.

- Fundamentale Physik: Untersuchung von Quantenchaos, Thermalisierung in Vielteilchensystemen und dem Übergang zwischen klassischem und quantenmechanischem Verhalten.

Die praktische Bedeutung wird jedoch mit Zurückhaltung beurteilt. Der gezeigte Vorteil bezieht sich auf eine klar definierte Klasse von Aufgaben; das bedeutet nicht automatisch, dass Willow oder ähnliche Prozessoren bereits klassische Supercomputer in allen Bereichen ersetzen können. Vielmehr handelt es sich um einen Wendepunkt, der zeigt, welche Anwendungsfälle realistischerweise als Nächstes angegangen werden sollten.

Wissenschaftliche Validität und Reproduzierbarkeit

Die Veröffentlichung in einer begutachteten Fachzeitschrift stärkt die Aussagekraft des Experiments. Peer‑Review prüft Methodik, Fehlerabschätzung und Interpretationen, wodurch die Community besser einschätzen kann, wie belastbar die Resultate sind. Reproduzierbarkeit ist ein zentraler Faktor: unabhängige Gruppen müssen in der Lage sein, die Versuchsbedingungen nachzuvollziehen oder auf ähnlicher Hardware vergleichbare Resultate zu erzielen.

Praktische Einsatzszenarien und Übergangsstrategien

In der Praxis dürften frühe produktive Anwendungen hybride Workflows nutzen: klassische Hochleistungsrechner (HPC) übernehmen Pre‑ und Post‑Processing, während der Quantenprozessor spezifische Schwergewichtsaufgaben löst, die für klassische Systeme besonders teuer sind. Solche Ko‑Design‑Ansätze – Plattformen, Software und Algorithmen gemeinsam zu entwickeln – erhöhen die Chancen, dass Quantenhardware reale wissenschaftliche und industrielle Werkzeuge ergänzt.

Was noch im Weg steht

Trotz dieses Meilensteins bestehen erhebliche ingenieurtechnische Herausforderungen. Die Forschungsgemeinschaft ist sich einig, dass der Übergang von lauten physikalischen Qubits zu großskaligen, fehlerkorrigierten logischen Qubits die größte Hürde ist. Skalierung, Temperaturmanagement und fehlertolerante Architekturen benötigen weitere Durchbrüche, bevor Quantencomputer zu universellen Rechenmotoren werden.

Im Detail bestehen die wichtigsten technischen Hürden aus mehreren ineinandergreifenden Bereichen:

- Fehlerkorrektur und Overhead: Aktuelle Fehlerkorrekturcodes, wie zum Beispiel der Surface Code, benötigen tausende physikalische Qubits, um ein einziges robustes logisches Qubit zu realisieren. Diese Ressourcen‑Kosten bleiben hoch und verlangen bessere physische Qubits sowie effizientere Korrekturalgorithmen.

- Kühltechnik und Thermomanagement: Supraleitende Qubits arbeiten bei Millikelvin‑Temperaturen in Verdünnungs‑Kryostaten. Größere Systeme erfordern skalierbare Kühllösungen und verbesserte Wärmeabfuhr, ohne die Signalintegrität zu gefährden.

- Kontroll‑Elektronik und Verkabelung: Die Steuerung von Hunderten oder Tausenden Qubits stellt Anforderungen an platzsparende, rauscharme und latenzarme Elektronik, die idealerweise näher an den Kryostaten betrieben werden sollte.

- Materialwissenschaft und Störquellen: Verlustmechanismen in dielektrischen Schichten, Quasipartikel‑Erzeugung oder magnetische Verunreinigungen limitieren Kohärenzzeiten und müssen durch Materialinnovationen reduziert werden.

- Software‑Stack und Fehlermodellierung: Realistische Fehlermodelle, kompakte Kompilierungsstrategien und adaptive Fehlermitigationsverfahren sind nötig, damit Algorithmen effizient ausgeführt werden können.

Bevor Quantencomputer universell anwendbar werden, müssen diese Bereiche zusammenwachsen: Hardwareverbesserungen allein genügen nicht; effizienter Software‑Stack und Systemintegration sind gleichermaßen entscheidend. Deshalb betrachten Experten Willow als wichtigen Zwischenschritt — eine experimentell verifizierte Plattform, die hilft, Architekturentscheidungen für die nächste Generation zu treffen.

Für Forschende und Branchenbeobachter ist Willows Erfolg ein Beleg dafür, dass Quantenplattformen sich von wissenschaftlichen Kuriositäten zu praktikablen Forschungs‑ und Entwicklungswerkzeugen entwickeln. Die Demonstration von verifizierbaren, nützlichen Resultaten ist ein notwendiger Schritt auf dem Weg zu kommerziell relevanten Anwendungen.

Abschließend lässt sich sagen: Willow ist kein sofortiger Ersatz für klassische Supercomputer, aber es ist ein bedeutender Fortschritt auf dem Weg zu praxisrelevanten Quantenrechnern. Die Studie liefert sowohl technische Einsichten in die Leistungsgrenzen aktueller supraleitender Architekturen als auch Impulse für die Priorisierung zukünftiger Forschung: bessere Qubit‑Qualität, effizientere Fehlerkorrektur und integrierte Hardware‑Software‑Lösungen.

Quelle: gizmochina

Kommentar hinterlassen